从高分辨率遥感图像中提取有价值的信息,并自动将不同场景的遥感图像分类是最近关注的热点话题。遥感图像是利用卫星在空中拍摄,含有丰富的场景信息,在许多领域都得到了应用,如图像分割[1]、道路提取[2]、目标检测[3]等。但由于遥感图像具有空间范围大、场景复杂等特点,导致提取遥感图像的关键区域面临极大的挑战。

对于传统的分类方法,场景分类一般包括特征提取和分类两部分。在特征提取方面,基于传统卷积神经网络(CNN)模型的方法表现出极好的特征提取效果,如基于VGG16[4]、AlexNet[5]、ResNet[6]的网络。基于传统CNN的方法通过提取最后一层卷积层获得的特征进行分类,但最近一些研究表明,通过提取传统CNN不同卷积层特征可以补充遥感图像的轮廓信息,更有利于提高分类精度。如Wang等[7]提出了名为EFPN-DSE-TDFF网络,该网络基于增强特征金字塔网络(EFPN)提取多尺度特征信息,然后通过深层语义嵌入(DSE)对特征进行判别,最后融合特征进行分类,EFPN-DSE-TDFF将多尺度低层轮廓信息和高层语义信息视为同样重要,而忽略了提取低层信息时带来的干扰信息(如冗余和互斥)。为了改进文献[7]提出方法的弊端,Sun等[8]提出了一种门控双向网络GBNet,通过实验选择性提取不同层的卷积特征,之后通过自顶向下和自底向上的双向联通网络来消除提取多层特征产生的干扰信息,分类准确度得到了微弱提升。提取多层卷积特征有利也有弊,一方面提取低层的特征信息可以获取更多有利于分类的外观轮廓信息,另一方面,多层卷积特征尺度变化范围大,干扰信息不易过滤,反而容易造成提取无关特征过多,降低了分类的性能。如He等[9]基于预训练的VGG16模型提出了跳跃连接协方差(SCCov)网络,通过池化层直接聚合VGG16的三层卷积特征,虽然在小数据集上提高了分类性能,但复杂的数据集由于场景类数及复杂度提高,导致其网络对于复杂信息的过滤性能降低。事实上,利用CNN网络的最后一层特征输出进行场景分类是完全足够的。

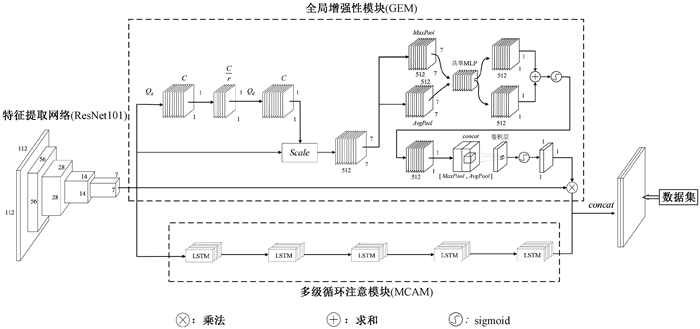

高分辨率遥感图像具有尺度变化大、涵盖信息复杂的特点,导致显著性特征提取困难。通常目标区域只占整幅图的小部分,而其他部分都是无关区域,为了定位图像中的关键区域,我们设计了全局增强性模块(GEM)。首先,将基准网络输出的全局特征信息输入帮助捕获特征之间空间相关性的挤压激励模块(SENet),通过该模块对特征重新校准,网络可以学习使用全局信息来选择性地强调信息性特征,并抑制不太有用的特征。其次,为了进一步提取特征,消除干扰信息,CNS-Net在SENet之后加入了注意力模块,一些方法[10-11]已经证明,组合不同的注意力可以提高网络的表示能力。

另外,由于在模型训练过程中信息不能被长期存储,利用GEM模块提取特征信息会丢失一部分关键信息,导致显著性信息提取不充分。而关键局部区域放大了最重要的对象,可以提供更细粒度的特征并减少背景噪声。因此,我们设计了一种补充显著信息的多级循环注意模块(MCAM),其结构采用的循环长短期记忆(LSTM)门控。LSTM能够进一步消除干扰[12-13],专注于提取关键信息,提高收敛速度。

我们将GEM模块和MCAM模块生成的注意力图通过concat函数聚合进行分类。本文的贡献主要有三个方面。

1) 为了获取遥感图像中的显著性特征,提高不同图像之间的区分度,提出了一种显著性目标检测方法—全局增强性模块(GEM)。实验结果表明,GEM可以有效提取显著性特征信息,降低不同特征之间的相互依赖性。

2) 为了获取更多更关键的特征信息,提出了多级循环注意模块(MCAM)。该模块利用LSTM实现对高层语义信息的选择性记忆,补充了GEM模块提取的特征信息。

3) 在4个数据集上的实验结果表明,我们设计的CNS-Net网络优于许多最新的网络。

1 方法设计的CNS-Net网络结构如图 1所示,下面将详细介绍各个模块的设计。

|

图 1 设计的CNS-Net网络架构 Fig. 1 The designed CNS-Net network architecture |

为了利用卷积提取的全局信息建立信道之间的动态、非线性依赖关系,在GEM中引入了SENet。设经过ResNet101特征提取的输出向量Pe∈RH×W×C,将Pe输入SENet中的全局平均池化层得到输出特征向量Pe∈R1×1×C,计算为

| $ \boldsymbol{F}=Q_{s}\left(\boldsymbol{P}^{e}\right)=\frac{1}{H \times W} \sum\limits_{i=1}^{H} \sum\limits_{j=1}^{W} \boldsymbol{P}^{e}(i, j), $ | (1) |

其中: Qs代表一种运算。

接着,捕获通道的依赖项,计算为

| $ \boldsymbol{K}=Q_{e}(\boldsymbol{F}, \boldsymbol{W})=\sigma\left(\boldsymbol{W}_{2} \delta\left(\boldsymbol{W}_{1} \boldsymbol{F}\right)\right), $ | (2) |

其中:δ代表ReLU激活函数;$\boldsymbol{W}_{1}, \boldsymbol{W}_{2} \in \mathbf{R}^{c \times \frac{C}{r}}$。

将得到的权重输出与特征提取模块的特征输出通过相乘操作,得到缩放后的输出Z∈RHo×Wo×Co,计算为

| $ \boldsymbol{Z}=Q_{\text {scale }}\left(\boldsymbol{K}_{\boldsymbol{e}}, \boldsymbol{P}^{e}\right)=\boldsymbol{K} \times \boldsymbol{P}^{e}, $ | (3) |

其中:输出特征向量Z=[z1, z2, …, ze]。

通过SENet之后已经得到高级语义信息,为了自适应调整得到的特征信息,进一步提高模型的泛化能力,我们引入了通道注意力和空间注意力。在GEM中的SENet后串联两个顺序连接的注意力模块。研究已经证明[14],通过顺序串联通道注意力和空间注意力可以达到最好的显著性特征提取效果。

我们将SENet得到的特征向量Z∈RHo×Wo×Co输入通道注意力中,首先在每个空间位置上应用MaxPooling、AvgPooling,得到两种不同空间描述的向量,然后为了更好地拟合通道间复杂的相关性,将这两种特征向量分别送入一个共享的包含两层FC(fully connected)的MLP,最后特征相加融合,经过一个激活函数,得到通道注意力图。输入通道注意力后特征图为Lc∈R1×1×C,计算公式为

| $ \begin{aligned} & \boldsymbol{L}_{c}(\boldsymbol{Z})=\sigma({MLP}({Avg} {Pool}(\boldsymbol{Z}))+ \\ & {MLP}({MaxPool}(\boldsymbol{Z})))=\sigma\left(\boldsymbol{W}_{Z_{1}}\left(\boldsymbol{W}_{Z_{o}}\left(\boldsymbol{Z}_{\mathrm{avg}}^{C}\right)\right)+\right. \\ & \left.\boldsymbol{W}_{Z_{1}}\left(\boldsymbol{W}_{Z_{o}}\left(\boldsymbol{Z}_{\max }^{C}\right)\right)\right) 。\end{aligned} $ | (4) |

再将通道注意力生成的注意力图Lc∈R1×1×C输入空间注意力中得到权值特征图Ls∈R1×1×1,最后得到加权后的特征向量X,公式为

| $ \boldsymbol{W}=\boldsymbol{L}_{s}\left(\boldsymbol{L}_{c}(\boldsymbol{Z})\right)=\sigma\left(\boldsymbol{f}^{7 \times 7}\left(\left[\boldsymbol{L}_{c}(\boldsymbol{Z})_{\mathrm{avg}}^{s} ; \boldsymbol{L}_{c}(\boldsymbol{Z})_{\max }^{s}\right]\right)\right), $ | (5) |

| $ \boldsymbol{X}=\boldsymbol{P}^{e} \times \boldsymbol{W}, $ | (6) |

其中:生成的加权特征向量X=[x1, x2, …, xr]。

1.2 多级循环注意模块由于GEM中先引入SENet模块,在通道中提取特征的赋予权重不同,压缩通道同时会有部分特征丢失。同样,经过两种注意力操作后会丢失信息,在特征提取网络ResNet101后加入一种循环注意力模块MCAM补充丢失的特征信息。MCAM模块可以建立特征信息的长期依赖关系,选择性记忆或遗忘信息。MCAM由五个LSTM模块组构成,每个LSTM横向有三层。LSTM模块内部执行过程主要分为三个阶段,即忘记阶段、选择记忆阶段和输出阶段。

首先,消除上一个节点的输入中的干扰并选择性遗忘其中不重要的信息,公式为

| $ \boldsymbol{M}^{f}=\sigma\left(\boldsymbol{W}_{o_{1}} \boldsymbol{x}_{t}+\boldsymbol{W}_{j_{1}} h^{t-1}+\boldsymbol{b}_{1}\right), $ | (7) |

其中:Mf为忘记门控,来控制上一个状态Ct-1的特征信息哪些需要记忆,哪些需要忘记;σ代表sigmoid激活函数。

其次,记忆关键的显著性特征,公式为

| $ \boldsymbol{M}^{i}=\boldsymbol{\sigma}\left(\boldsymbol{W}_{o_{2}} \boldsymbol{x}_{t}+\boldsymbol{W}_{j_{2}} h^{t-1}+\boldsymbol{b}_{2}\right), $ | (8) |

其中:Mi为选择门控,对输入xt的内容进行选择。

另外,为了决定哪些将会被当成当前状态输出,通过输出门控制,

| $ \boldsymbol{M}=\tanh \left(\boldsymbol{W}_{o_{3}} \boldsymbol{x}_{t}+\boldsymbol{W}_{j_{3}} h^{t-1}+\boldsymbol{b}_{3}\right), $ | (9) |

| $ \boldsymbol{M}^{o}=\sigma\left(\boldsymbol{W}_{o_{4}} \boldsymbol{x}_{t}+\boldsymbol{W}_{j_{4}} h^{t-1}+\boldsymbol{b}_{4}\right), $ | (10) |

其中:M代表当前输入内容;Mo控制当前状态的哪些内容应该被输出。为了对上一阶段得到的Mo进行放缩,通过tanh激活函数转换成-1~1之间的值。

最后,隐藏状态输出为

| $ \boldsymbol{C}^{t}=\boldsymbol{M}^{f} \odot \boldsymbol{C}^{t-1}+\boldsymbol{M}^{i} \odot \boldsymbol{M} , $ | (11) |

| $ \boldsymbol{h}_{(m, n)}=\boldsymbol{M}^{o} \odot \tanh \left(\boldsymbol{C}^{t}\right), $ | (12) |

| $ \boldsymbol{y}_{(m, n)}=\boldsymbol{\sigma}\left(\boldsymbol{W}_{5} \boldsymbol{h}_{(m, n)}\right), $ | (13) |

其中:h(m, n)代表的是第m个LSTM组在位置n的隐藏状态输出。前一个LSTM网络的最后一层输出和隐藏状态将被传输到下一个LSTM网络。将隐藏状态h(m, n)顺序通过所有LSTM层和空间位置生成最后一层隐藏状态h(num, L),同时生成输出特征向量y(num, L),

| $ \boldsymbol{h}_{(n u m, L)}=\left\{\boldsymbol{h}_{\left(R_{b o r}, 1\right)}, \boldsymbol{h}_{\left(R_{b o r}, 2\right)}, \cdots, \boldsymbol{h}_{\left(R_{b o r}, L\right)}\right\}, $ | (14) |

| $ \boldsymbol{y}_{(n u m, L)}=\left\{\boldsymbol{y}_{\left(R_{b o r}, 1\right)}, \boldsymbol{y}_{\left(R_{b o r}, 2\right)}, \cdots, \boldsymbol{y}_{\left(R_{b o r}, L\right)}\right\}。$ | (15) |

用Y=(y1, y2, …, yL)代替y(num, L),现在需要融合GEM和MACM输出的特征向量得到最终的预测向量,计算为

| $ \boldsymbol{V}=\left(v_{1}, v_{2}, \cdots, v_{g}\right), $ | (16) |

其中:g代表标签总数。

我们建议的三种融合方法如下。

a) 对预测向量加权求和,

| $ \boldsymbol{V}=q_{1} \times \boldsymbol{X}+q_{2} \times \boldsymbol{Y}, q_{1}, q_{2} \in(0, 1] ; $ | (17) |

b) 对一段时间内的预测向量求和,

| $ \boldsymbol{V}=\boldsymbol{X}+\boldsymbol{Y}, \boldsymbol{X}, \boldsymbol{Y} \in \mathbf{R}^{n}; $ | (18) |

c) 对预测向量进行拼接,

| $ \boldsymbol{V}=[\boldsymbol{X}, \boldsymbol{Y}] \in \mathbf{R}^{2 n} 。$ | (19) |

最后,由于第三个方法在最终预测向量V中具有最高概率的预测,将两部分特征预测向量通过concat连接起来,生成评分映射表

| $ \boldsymbol{V}^{a}={concat}(\boldsymbol{X}, \boldsymbol{Y}), $ | (20) |

其中:Va={v1, v2, …, va}。

2 实验 2.1 数据集数据集定义如下。

1) AID数据集[15]由30个遥感场景类别组成,每个类别至少有200幅图像。共有10 000张图片,分辨率为600×600。

2) UC-Merced数据集[16](UCM)由全国21个遥感城市场景类别组成,共有2 100幅图像。每个遥感场景类别有100幅图像,分辨率为256×256。

3) OPTIMAL-31数据集[12]由31个遥感场景类别组成,每个类别包含60幅遥感图像。数据集中有1 860幅图像,每幅图像的分辨率为256×256。

4) NWPU-RESISC数据集[17]是最大的遥感数据集。它包含45个场景类。每个类包含700幅图像,分辨率为256×256。

2.2 评估指标以下两个典型指标用于定量评估实验结果。

1) 总体精确度(OA):表示正确预测图像与整体图像的比率。使用K折交叉验证取平均值作为最终预测结果。

2) 混淆矩阵(CM):是评价分类性能的常用方法,可以用于可视化图像分类的结果,矩阵的每一行代表预测类的所有样本,每一列代表真实类的样本。

2.3 实验参数设置1) 参数设置:实验选取ResNet101作为主干网络提取特征,在ImageNet上将所有的图像调整为224×224,为了增强训练的泛化能力,将输入的图片进行随机裁剪、翻转。批量设置为32,学习率设置为1e-4。所有模型都使用Adam优化算法,交叉熵损失作为损失函数。10个周期的权重衰减设置为1e-4,动量值设为0.9,为了获取稳定的实验数据,在4个数据集上采集5次获取的平均值作为实验结果。

2) 硬件和软件平台:所有实验在配备有英特尔i7 7700H@2.8 GHz CPU和英伟达GeForce1080Ti GPU的计算机上实现。

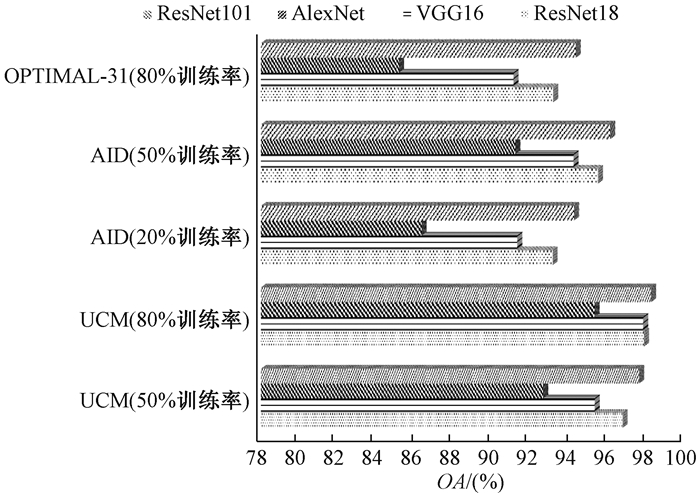

2.4 比较不同的特征提取网络如图 2,在3个公共的数据集上测试了ResNet101、AlexNet、VGG16和ResNet18对遥感图像分类的精度,ResNet101网络都达到了最好的分类效果,所以采用ResNet101作为特征提取主干网络。

|

图 2 测试不同主干网络的OA值 Fig. 2 The OA values of different backbone networks on three datasets |

利用CNS-Net网络在80%训练率的UCM数据集上测试LSTM的层数和循环次数对网络训练损失影响。结果显示,当层数和循环次数增加时,训练损失下降较快,当增加到一定值时,趋于稳定。最终选择LSTM迭代3层循环5次。

2.6 消融实验本节我们探究GEM和MCAM对CNS-Net网络在遥感图像分类上的潜在优势。

1) 实验一 为了探究GEM对OA的影响,将MCAM模块移除,保持网络的其他参数不变。如表 1,我们利用ResNet18和ResNet101特征提取网络分别在两个数据集上测试了OA,在AID数据集20%和50%的训练率下,CNS-Net-ResNet101的OA评分比CNS-Net-ResNet18提高了1.36%和0.61%;在OPTIMAL-31数据集80%的训练率下,CNS-Net-ResNet101的OA评分比CNS-Net-ResNet18提高了0.47%,与基准网络相比OA提高0.9%和0.99%。这表明,我们设计的GEM模块能够从复杂的遥感图像场景中提取关键特征,并且对主干网络有更好的改进。

|

|

表 1 CNS-Net采用不同主干网络和模块的OA值 Tab. 1 OA values of CNS-Net with different backbone networks and modules |

2) 实验二 为了证明所提出的MCAM模块对于显著性特征的提取能力,我们将GEM和MCAM模块同时加入到CNS-Net网络中,从表 1的实验结果可以看出,在AID数据集20%和50%的训练率下,CNS-Net-ResNet101的OA评分和CNS-Net-ResNet18的OA评分比只加上GEM模块的CNS-Net网络分别提高了0.50%、0.32%和0.63%、0.34%;在80%训练率的OPTIMAL-31数据集上,OA评分分别提高了0.45%和0.40%。这说明所提出的MCAM模块有利于获得显著性特征,添加了GEM和MCAM模块的CNS-Net达到了最好的分类效果,对主干网络有更好的改进。我们设计的基于主干网络ResNet101的CNS-Net的参数量为51.63 M,比单独ResNet101网络44 M的参数量只增加7.63 M,这说明我们提出的方法仅增加少量参数量就能带来分类性能的大幅增加,体现方法的优越性。

2.7 与其他方法的比较为了证明我们方法的优越性,把设计的CNS-Net网络在4个公共的遥感数据集上与目前较新的方法进行比较。从表 2可以看到,CNS-Net在4个数据集上达到了最优的分类精度(除了10%训练率的NWPU数据集),这证明我们的方法优于其他方法。

|

|

表 2 CNS-Net网络与其他方法在4个数据集上的OA值 Tab. 2 OA values of CNS-Net network and other methods on four datasets |

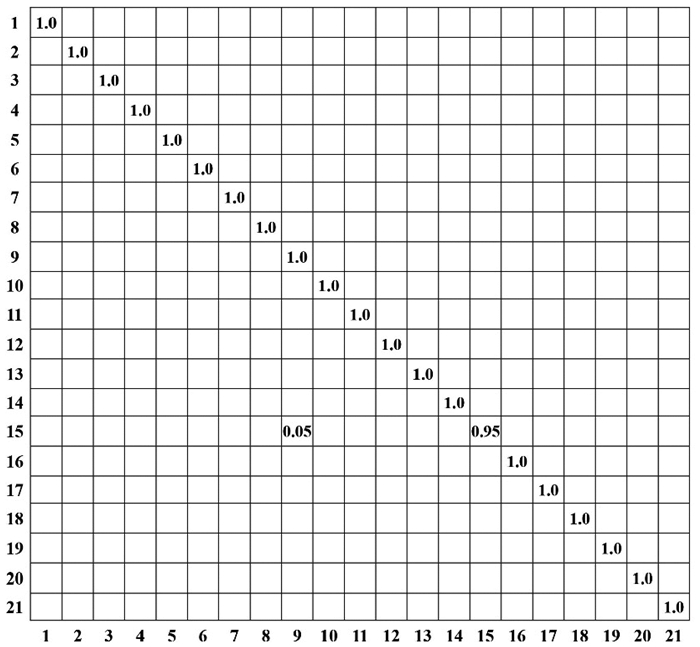

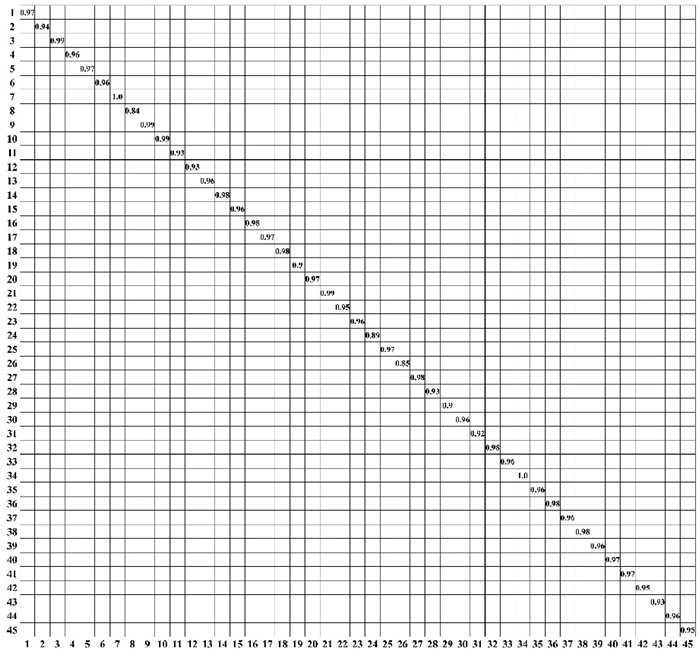

UCM数据集是比较经典的广泛用于测试网络性能的数据集。表 2中,CNS-Net-ResNet101网络在50%和80%的训练率时的测试精度为99.33%和99.83%,比其他算法最好的精度提高了0.04%和0.07%,比同样采用ResNet101作为主干网络的GRMA-Net-ResNet101[13]提高了0.04%和0.45%,比EAM-ResNet101[18]在80%训练率时提高了0.62%。如图 3所示,在80%训练率的UCM数据集上的CM表明,只将两个数据集划分错误(天桥误判为高速公路),这是由于数据集中拍摄的天桥和高速公路极为相似导致。

|

图 3 UCM数据集在80%训练率的CM Fig. 3 CM of the UCM dataset at 80% training rate |

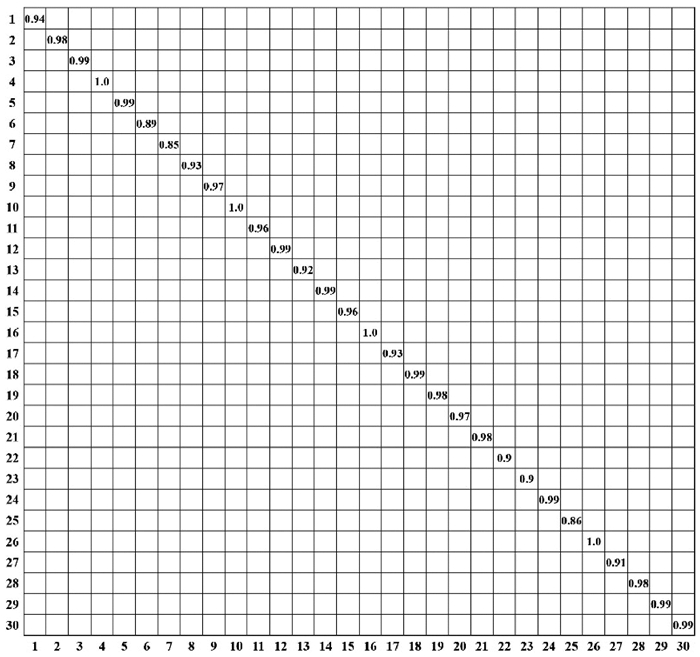

在目前遥感图像分类中所含场景较为复杂的AID数据集上,我们的方法在20%和50%训练率时,OA值达到了96.21%和98.35%,比文献[13]的方法提高了0.02%和0.51%,如图 4所示。在场景复杂、内容丰富的NWPU数据集上,20%训练率时OA值达到了95.33%。即使在10%的训练率时,也可以保持较高的OA值。NWPU数据集在20%训练率的CM如图 5。

|

图 4 AID数据集在20%训练率的CM Fig. 4 CM of the AID dataset at 20% training rate |

|

图 5 NWPU数据集在20%训练率的CM Fig. 5 CM of the NWPU dataset at 20% training rate |

最后在OPTIMAL-31数据集上,本文方法比文献[13]中方法的OA值提高了0.52%。如图 6, 在训练率为80%时,我们的CNS-Net只在棒球场、丛林和住房区三种类别上产生混淆,在其他类别上OA值达到了100%。

|

图 6 OPTIMAL-31数据集在80%训练率的CM Fig. 6 CM of the OPTIMAL-31 dataset at 80% training rate |

本文提出了一种端到端的CNS-Net网络用于遥感图像场景分类。设计CNS-Net网络的目的在于提取显著性的高层语义信息,实现更精确地定位关键区域,提高OA值。具体来说,为了增强网络的表示能力,我们设计了GEM模块建立信道之间的动态、非线性依赖关系,赋予关键信息区域有区别的权重,极大改进了现有网络对特征信息的提取难度和精确度。为了进一步提高分类性能,设计了MCAM模块高层语义信息选择性提取,实现了与GEM提取特征信息的互补。

| [1] |

白雪飞, 韩晓静, 王文剑. 一种视觉显著性引导的模糊聚类图像分割方法[J]. 郑州大学学报(理学版), 2022, 54(2): 1-7. BAI X F, HAN X J, WANG W J. Visual saliency-guided fuzzy clustering method for image segmentation[J]. Journal of Zhengzhou university (natural science edition), 2022, 54(2): 1-7. (  0) 0) |

| [2] |

YANG K, YI J Z, CHEN A B, et al. ConDinet: full-scale fusion network based on conditional dilated convolution to extract roads from remote sensing images[J]. IEEE geoscience and remote sensing letters, 2022, 19: 1-5. (  0) 0) |

| [3] |

王阳, 袁国武, 瞿睿, 等. 基于改进YOLOv3的机场停机坪目标检测方法[J]. 郑州大学学报(理学版), 2022, 54(5): 22-28. WANG Y, YUAN G W, QU R, et al. Target detection method of airport apron based on improved YOLOv3[J]. Journal of Zhengzhou university (natural science edition), 2022, 54(5): 22-28. (  0) 0) |

| [4] |

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. (2014-09-04)[2022-06-13]. https://arxiv.org/abs/1409.1556.

(  0) 0) |

| [5] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90. DOI:10.1145/3065386 (  0) 0) |

| [6] |

HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2016: 770-778.

(  0) 0) |

| [7] |

WANG X, WANG S Y, NING C, et al. Enhanced feature pyramid network with deep semantic embedding for remote sensing scene classification[J]. IEEE transactions on geoscience and remote sensing, 2021, 59(9): 7918-7932. DOI:10.1109/TGRS.2020.3044655 (  0) 0) |

| [8] |

SUN H, LI S Y, ZHENG X T, et al. Remote sensing scene classification by gated bidirectional network[J]. IEEE transactions on geoscience and remote sensing, 2020, 58(1): 82-96. DOI:10.1109/TGRS.2019.2931801 (  0) 0) |

| [9] |

HE N J, FANG L Y, LI S T, et al. Skip-connected covariance network for remote sensing scene classification[J]. IEEE transactions on neural networks and learning systems, 2020, 31(5): 1461-1474. DOI:10.1109/TNNLS.2019.2920374 (  0) 0) |

| [10] |

GUO D E, XIA Y, LUO X B. Scene classification of remote sensing images based on saliency dual attention residual network[J]. IEEE access, 2020, 8: 6344-6357. DOI:10.1109/ACCESS.2019.2963769 (  0) 0) |

| [11] |

GUO Y Y, JI J S, SHI D, et al. Multi-view feature learning for VHR remote sensing image classification[J]. Multimedia tools and applications, 2021, 80(15): 23009-23021. DOI:10.1007/s11042-020-08713-z (  0) 0) |

| [12] |

WANG Q, LIU S T, CHANUSSOT J, et al. Scene classification with recurrent attention of VHR remote sensing images[J]. IEEE transactions on geoscience and remote sensing, 2019, 57(2): 1155-1167. DOI:10.1109/TGRS.2018.2864987 (  0) 0) |

| [13] |

LI B Y, GUO Y L, YANG J G, et al. Gated recurrent multiattention network for VHR remote sensing image classification[J]. IEEE transactions on geoscience and remote sensing, 2021, 60: 1-13. (  0) 0) |

| [14] |

WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module[C]//European Conference on Computer Vision. Cham: Springer International Publishing, 2018: 3-19.

(  0) 0) |

| [15] |

XIA G S, HU J W, HU F, et al. AID: a benchmark data set for performance evaluation of aerial scene classification[J]. IEEE transactions on geoscience and remote sensing, 2017, 55(7): 3965-3981. DOI:10.1109/TGRS.2017.2685945 (  0) 0) |

| [16] |

YANG Y, NEWSAM S. Bag-of-visual-words and spatial extensions for land-use classification[C]//Proceedings of the 18th SIGSPATIAL International Conference on Advances in Geographic Information Systems. New York: ACM Press, 2010: 270-279.

(  0) 0) |

| [17] |

CHENG G, HAN J W, LU X Q. Remote sensing image scene classification: benchmark and state of the art[J]. Proceedings of the IEEE, 2017, 105(10): 1865-1883. (  0) 0) |

| [18] |

ZHAO Z C, LI J Q, LUO Z, et al. Remote sensing image scene classification based on an enhanced attention module[J]. IEEE geoscience and remote sensing letters, 2021, 18(11): 1926-1930. (  0) 0) |

| [19] |

SUN H, LI S, ZHENG X, et al. Remote sensing scene classification by gated bidirectional network[J]. IEEE transactions on geoscience and remote sensing, 2020, 58(1): 82-95. (  0) 0) |

| [20] |

TANG X, MA Q S, ZHANG X R, et al. Attention consistent network for remote sensing scene classification[J]. IEEE journal of selected topics in applied earth observations and remote sensing, 2021, 14: 2030-2045. (  0) 0) |

| [21] |

TIAN T, LI L L, CHEN W T, et al. SEMSDNet: a multiscale dense network with attention for remote sensing scene classification[J]. IEEE journal of selected topics in applied earth observations and remote sensing, 2021, 14: 5501-5514. (  0) 0) |

2024, Vol. 56

2024, Vol. 56