2. 中国民航大学 民航智慧机场理论与系统重点实验室 天津 300300;

3. 成都圭目机器人有限公司 四川 成都 610100

2. Key Laboratory of Smart Airport Theory and System, Civil Aviation University of China, Tianjin 300300, China;

3. Chengdu Guimu Robot Co.Ltd., Chengdu 610100, China

长期以来,机场跑道表观结构病害一直是影响机场飞行器安全起降的严重隐患。其中,道面裂缝是主要的机场道面结构病害之一。传统上,机场跑道裂缝的检查工作主要依赖人工目视巡检,检测效率低下,检测成本较高,且极易出现误检、漏检等情况。为此,设计一种准确度高、鲁棒性好的机场跑道裂缝分割算法对于机场的安全运营、跑道养护等工作均有着深远的意义。

早期的裂缝分割算法主要依赖传统图像处理方式,此类算法通常从形态学出发,首先对含有病害的图像通过滤波算法进行去噪处理,随后设计不同的阈值分割算法,通过提取裂缝的边缘特征,对裂缝进行分割。如Li等[1]提出了基于二次阈值分割的机场道面裂纹检测方法,使用改进的Otsu阈值分割算法去除道面上的标线,并用自适应迭代阈值分割算法对道面裂缝进行分割。Noh等[2]通过使用模糊C均值聚类的方式对混凝土表面的裂缝进行检测,使用了不同的滤波器对裂缝的杂波进行过滤。此类算法通常依赖人工设计特征,存在泛化性不高的问题[3],不能兼顾所有裂缝特征,难以在真正的工程应用中落地。

在后续研究中,分割任务通常借助卷积神经网络(convolutional neural network,CNN)来实现。经典的语义分割网络有FCN[4]、U-net[5]、SegNet[6]、DeepLab[7]等模型,这些模型通常使用编码器-解码器(encoder-decoder)结构,其中,encoder负责提取图像的语义信息,而decoder负责恢复特征图的原始尺寸,得到模型预测结果。这启发了研究人员在裂缝分割任务上探索基于CNN的分割模型,Zou等[8]提出了DeepCrack,这是一种基于CNN的裂缝检测模型,网络通过学习裂缝的高级特征表示来进行自动裂纹检测。König等[9]提出了一种结合残差网络和门控注意力的全卷积U-net网络,用于对路面裂缝进行分割。

尽管CNN方法对各类裂缝分割任务有一定的效果,但CNN方法有两个先天不足。首先,受限于卷积核大小,CNN仅能提取邻近像素空间内的特征,缺乏对全局信息的捕获能力;其次,CNN中使用的卷积核形状较为固定,难以适应不同类型的图像特征。由于机场跑道裂缝常常形态多样、长短不一,且在分布上呈稀疏特征,一般的CNN方法难以提取裂缝特征的全貌,需要依赖全局语义特征作为支撑。如何使网络充分提取并利用裂缝的全局语义信息,成为改善裂缝分割效果的关键因素。

近年来,transformer模型[10]在自然语言处理领域的许多任务上取得了非凡的成绩,Dosovitskiy等[11]将transformer应用到视觉领域,提出了vision transformer(ViT)方法,ViT是一种基于自注意力(self-attention)机制的特征提取器,该模型改用堆叠多头self-attention的方式来实现对图像特征的提取,在大规模数据集上展现出优于CNN的效果。Ho等[12]提出了用轴向注意力(axial-attention)计算特征图中各个位置与其所在同一方向上其他位置间的注意力关系,减少了自注意力机制的运算量。

本文提出了联合self-attention与axial-attention的机场跑道裂缝分割网络(CSA-net)。CSA-net采用了encoder-decoder模式,并在encoder的第一层使用基于可变形卷积[13]的残差模块提取有效的裂缝特征,设计self-attention[14]与axial-attention[12, 15]联合的特征编码模块用于增强网络对细小裂缝的表达能力。在decoder阶段,使用self-attention机制构建的transformer模块进行上采样操作,在恢复特征图大小的同时,减少特征信息的丢失。本文采用APD07机场跑道裂缝分割数据集,对比了5个不同的裂缝分割模型。CSA-net在APD07上的F1-score为78.91%,优于其他对比方法。本文的主要贡献为:1) 通过联合self-attention与axial-attention,提出了一种新的transformer模块;2) 使用该模块构建了裂缝分割网络,实现对裂缝的精细化分割;3) 通过不同损失函数加权,解决了由于机场跑道裂缝正、负样本不均衡导致的分割效果差的问题。

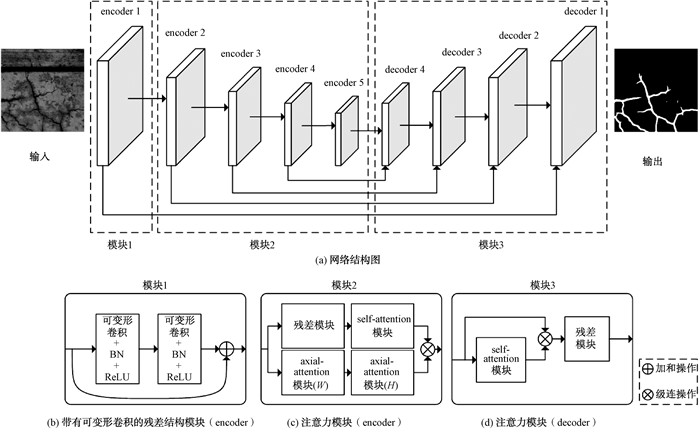

1 机场跑道裂缝分割网络本文提出的CSA-net主要由4部分组成:带有可变形卷积[13]的残差模块、self-attention模块[11]、axial-attention模块[12]与transformer decoder模块[14],并借鉴U-net模型堆叠而成,网络的详细结构如图 1(a)所示。其中包括5个encoder层与4个decoder层,第一个encoder层由两个带有可变形卷积的残差模块堆叠而成,使用可变形卷积,可以从形态各异的裂缝中提取病害的普遍特征,随后紧跟4个encoder层,用于在不同尺度的特征图上对裂缝的特征进行提取。每个encoder层包括一组self-attention模块与一组axial-attention模块。其中,self-attention模块可以提取裂缝的全局语义特征,而axial-attention则专注于提取横向或纵向裂缝的特征。网络通过4层Transformer decoder恢复特征图的原始尺寸,通过融合不同尺度下的特征信息,增强网络对裂缝细节的分割能力。下面针对每个模块进行详细说明。

|

图 1 网络模型结构图 Fig. 1 Network model structure diagram |

在CNN方法中通常使用固定形状与大小的卷积核来提取图像特征,对于常规形态的物体,该方法有着较好的特征提取能力,但机场跑道裂缝病害通常在形态和方向上有着不同的分布,固定形状的卷积核对几何形变的适应能力较差,不能很好地提取此类病害的特征。本文通过引入可变形卷积模块来解决这一问题。

可变形卷积模块在感受野中加入了对偏移量的学习,通过在普通卷积核中加入偏移量,可以使得卷积核不再是固定的方形。具体来说,一般的卷积操作对于输入特征图x中p0位置,其输出特征图中相同位置的计算方式为

| $ y\left(p_0\right)=\sum\limits_{p_n \in G} w\left(p_n\right) x\left(p_0+p_n\right), $ | (1) |

其中:G为固定大小和形状的卷积核;w(·)则为卷积核中某位置的权重参数。而可变形卷积是在标准卷积的常规网格采样操作的基础上增加了Δpn的偏移量,即公式(1)演化为

| $ y\left(p_0\right)=\sum\limits_{p_n \in G} w\left(p_n\right) x\left(p_0+p_n+\Delta p_n\right), $ | (2) |

其中:Δpn是可以学习的网络参数,通过训练这一模块,可变形卷积的卷积核可以变换为贴近裂缝的形状,使得感受野中的区域始终是需要重点关注的跑道裂缝病害区域。

如图 1(b)所示,算法在模型浅层使用带有可变形卷积的残差模块来提取裂缝的特征,由于网络较浅,此处提取的特征多为裂缝的初级语义信息,例如裂缝的纹理、边缘等信息。在此处使用可变形卷积,可以有效利用裂缝的形态差异信息提取裂缝的特征。

1.2 Self-attention模块由于机场跑道裂缝通常较为狭长,使用卷积操作难以提取裂缝特征的全貌,这也是语义分割算法在裂缝分割任务中效果不佳的原因之一,本文引入了self-attention模块,通过self-attention机制捕获裂缝的全局语义信息,来改善对裂缝的分割效果。

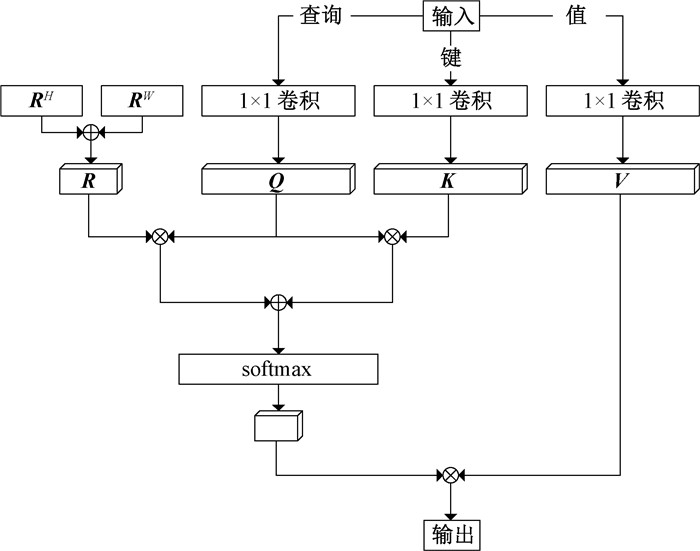

与CNN不同,self-attention通过计算特征图上某个点与所有点之间的相关关系来反映特征的相关性。这样,self-attention具有全局感受野且善于捕捉图像的长程依赖,能够从完整的图像上、下文信息中提取图像的语义信息。具体来说,对于一张特征图F ∈ RC×H×W,其中:H、W分别表示特征图的高度和宽度;C表示特征图的通道数。Self-attention通过一系列1×1卷积将F中的每个位置投影为3个长度为d的隐向量q, k, v∈R1×d,通过这3个向量,可以计算出某个位置与其他位置间的相关关系。特征图F中某点(i, j)的注意力值计算方式为

| $ attention\left(\boldsymbol{F}_{i, j}\right)=\sum\limits_{h=1}^H \sum\limits_{w=1}^W \operatorname{softmax}\left(\boldsymbol{q}_{i, j} \boldsymbol{k}_{h, w}^{\mathrm{T}}\right) \boldsymbol{v}_{h, w} 。$ | (3) |

故对于特征图F中的所有位置构成的self-attention矩阵的计算方式为

| $ attention(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V})_F=\operatorname{softmax}\left(\frac{\boldsymbol{Q} \boldsymbol{K}^{\mathrm{T}}}{\sqrt{d}}\right) \boldsymbol{V}, $ | (4) |

其中:Q、K、V表示特征图F上所有位置(i, j)的隐向量q、k、v所组成的隐向量矩阵;Q, K, V∈Rn×d, n=H×W。

为了使得self-attention机制能够利用特征图区域间的语义差异,通过学习位置偏差信息,加强self-attention机制对于特征图整体的建模能力,在self-attention机制中加入位置编码信息。位置编码信息是一组可以学习的参数,用以表征特征图区域间的相对位置关系。对于特征图中的任意两个点i(xi, yi), j(xj, yj),它们之间的相对位置编码信息li, j可以表示为

| $ l_{i, j}=\operatorname{softmax}\left(\boldsymbol{k}_j+\boldsymbol{r}_{x_j-x_i}^W+\boldsymbol{r}_{y_j-y_i}^H\right) \boldsymbol{q}_i^{\mathrm{T}}, $ | (5) |

其中:rW和rH是一组可以学习的隐向量,分别与xj-xi间的相对宽度和yj-yi间的相对高度有关。将上述所有的信息融合在整张特征图F上,其self-attention矩阵可以表示为

| $ attention(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V})_F=\operatorname{softmax}\left(\frac{\boldsymbol{Q K}^{\mathrm{T}}+\boldsymbol{S}_H+\boldsymbol{S}_W}{\sqrt{d}}\right) \boldsymbol{V}, $ | (6) |

其中:SH和SW为特征图F中所有点对i (xi, yi), j(xj, yj)构成的相对位置编码信息li, j所组成的相对位置编码矩阵。

关于self-attention模块的计算流程如图 2所示,其中RW、RH为特征图F上的所有位置(i, j)的隐向量rW、rH所构成的隐向量矩阵。

|

图 2 Self-attention模块计算流程 Fig. 2 The calculation process of the self-attention module |

这样,通过计算特征图中每个位置与全局的注意力关系,网络可以不断学习和优化同一特征图中不同区域间的相关关系和重要性差异,以此来捕捉长裂缝的全局语义特征,这种语义特征可以很好地帮助网络理解裂缝的形态。

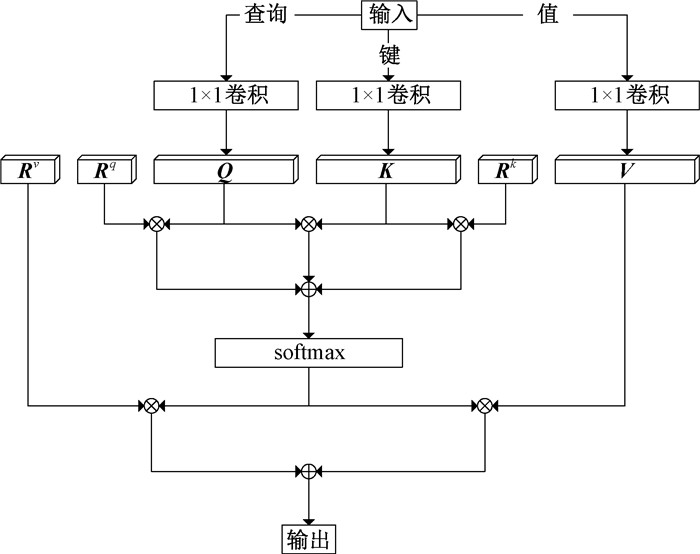

1.3 Axial-attention模块机场跑道裂缝除了具有形态和长度方面的特点外,也常常在方向上有着特殊的分布,一般来说,在机场跑道的水平和垂直方向往往更容易出现裂缝。基于这一发现,本文引入了axial-attention模块,通过axial-attention机制,重点关注机场跑道的水平方向和垂直方向裂缝的语义特征。

Axial-attention属于注意力的一种形式,但其特点是在计算特征图中某一点与其他区域的相关关系时,仅关注与该点处于同一水平或垂直方向区域的语义信息。对于特征图上某点(i, j)在宽度方向的注意力值可以表示为

| $ attention(i, j)=\sum\limits_{w=1}^W \operatorname{softmax}\left(\boldsymbol{q}_{i, j}^{\mathrm{T}} \boldsymbol{k}_{i, w}\right) \boldsymbol{v}_{i, w} \text { 。} $ | (7) |

同理,在高度方向上的axial-attention与之类似。

同样地,为了使得本模块可以利用不同区域间的相对位置偏差关系,更好地提取空间中的结构信息,本文在axial-attention模块中加入相对位置编码,用于强化特征图上不同区域之间的位置关系。具体来说,与q、k、v向量相似,用rq, rk, rv∈Rw×w表示该特征图中宽度方向的位置编码信息矩阵。于是,特征图中某个位置(i, j)在宽度方向的axial-attention最终表示为

| $ \begin{aligned} & attention(i, j)=\sum\limits_{w=1}^W \operatorname{softmax}\left(\boldsymbol{q}_{i, j}^{\mathrm{T}} \boldsymbol{k}_{i, w}+\right.\\ & \left.\boldsymbol{q}_{i, j}^{\mathrm{T}} \boldsymbol{r}_{i, w}^q+\boldsymbol{k}_{i, w}^{\mathrm{T}} \boldsymbol{r}_{i, w}^k\right)\left(\boldsymbol{v}_{i, w}+\boldsymbol{r}_{i, w}^v\right) 。\end{aligned} $ | (8) |

图 3展示了axial-attention模块的计算流程,不同方向的axial-attention分别可以对裂缝的横向或纵向特征进行提取,本文通过不同方向的axial-attention模块堆叠的方式提取裂缝在方向上的特征,其中Rq、Rk、Rv表示特征图F上的所有位置(i, j)的位置编码信息rq、rk、rv所构成的位置编码矩阵。

|

图 3 Axial-attention模块的计算流程 Fig. 3 The calculation process of the axial-attention module |

如图 1(c)所示,本文使用联合self-attention与axial-attention的方式构建transformer模块,用于裂缝全局语义信息的提取,其中self-attention用于提取裂缝的全局语义信息,而axial-attention则专注于裂缝在方向上的特征。本文通过多个transformer模块堆叠的方式,加强对裂缝特征提取的能力。

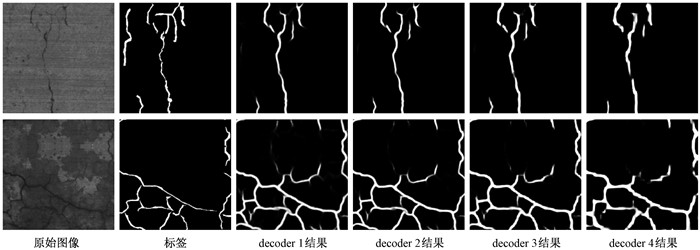

1.4 Transformer decoder与特征融合模块机场跑道裂缝普遍宽度较窄,网络经过多次encoder降采样操作后,容易丢失裂缝的细节信息,难以在decoder阶段还原裂缝的全貌[16]。考虑这一原因,在设计decoder网络时,本文采用级联不同特征尺度的方式[17-19]还原裂缝形态。如图 1(d)所示,在decoder的每一阶段,网络首先通过transformer decoder的方式将该阶段的特征图恢复成下一阶段期望的输出尺寸,随后,通过级联的方式融合两个阶段的特征图,并通过一个残差模块得到该层最终的输出结果。通过上述操作,网络融合了不同尺度间的分割效果,对于细小裂缝,这样的设计方式可以有效减少裂缝细节的丢失,获得更加精细的分割效果。图 4展示的是transformer decoder模块在不同阶段对机场跑道真实场景分割效果。可以看到,在decoder的初始阶段,由于经过多次特征提取,模型的预测结果保留了丰富的语义特征,并过滤了大部分的噪声,但也损失了较多的边缘细节信息。与之相反,深层decoder对于特征的边缘信息保留较多。通过融合不同特征尺度下的预测结果,模型可以同时学习边缘细节信息与深层语义信息,抑制特征噪声,达到精确的分割效果。

|

图 4 网络在不同解码层的预测结果 Fig. 4 The prediction results of the network in different decoder layers |

本文选用FCN[4]、U-net[5]、DeepLab-v3+[20]、Axial DeepLab[15]与DeepCrack[8]作为对比。其中,FCN是语义分割领域的经典模型,U-net则是当今语义分割网络的经典设计范式。DeepLab-v3+是DeepLab语义分割系列的最新模型,网络使用Xception模块[21]提取特征,并引入了空洞空间卷积池化金字塔模块。在Axial DeepLab中,网络通过使用axial-attention的方式,降低了transformer的模型复杂度,同时改进了语义分割的效果。DeepCrack是一种专门针对裂缝场景实现语义分割的模型。

2.1.2 数据集本文中所有实验所使用的数据集称为APD07,原始的图像由成都圭目机器人有限公司使用机场道面安全检测机器人在国内各大机场实际采集获得,该道面检测机器人搭载了可见光相机、光照系统与差分GPS等模块,其外观如图 5所示。机器人采集的图像原始像素尺寸为900×1 800,共2 000张。经过人工像素级标注后,将原始图像裁切成符合网络输入的像素尺寸(256×256),并将不含裂缝病害的图像剔除,最终共获得图像27 691张。将该数据集随机划分为训练集和测试集,训练集与测试集比例为9∶1。

|

图 5 机场道面安全检测机器人 Fig. 5 Airport road surface safety inspection robot |

本文采用三个评价指标来定量评估模型效果,分别是准确率(Precision)、召回率(Recall)与F1-score。由于对裂缝的精细化像素级标注是非常困难的,故在本文的评价标准中,允许对裂缝的实际分割效果与真实标签间存在两个像素的容差,最终本文所采用的Precision和Recall定义为

| $ \begin{array}{c} Precision=\frac{\sum\limits_i\left|\hat{Y}_i \cap D_t\left(Y_i\right)\right|}{\sum\limits_i\left|\hat{Y}_i\right|}, \\ Recall=\frac{\sum\limits_i\left|D_t\left(\hat{Y}_i\right) \cap Y_i\right|}{\sum\limits_i\left|\hat{Y}_i\right|}, \end{array} $ |

其中:i表示数据集中的第i张图像;

F1-score定义为

| $ F 1-score=2 \times \frac{Precision \times Recall }{Precision + Recall}, $ | (9) |

F1-score是Precision与Recall的调和平均,通常能够更加客观地定量反映模型推理结果的好坏。

2.1.4 实现细节本文模型及对比方法基于pytorch深度学习框架实现,使用Geforce RTX3090显卡进行训练与测试,其中对比方法采用默认参数。CSA-net采用Adam进行网络参数优化,学习率为0.001,权重衰减系数为0.000 01,动量系数为0.9;使用Dice loss[22]与交叉熵损失函数[23]加权的方式计算网络损失。具体来说,对网络decoder部分的1~4层与真实标签分别计算Dice loss和交叉熵损失函数,并各自赋予权重1.0、0.75、0.5和0.25,将所得的损失函数结果相加,作为最终的损失结果。此外,将交叉熵损失函数对背景分割权重设为0.2,裂缝分割权重设为1.0。

2.2 结果分析在同一实验环境下,使用上述参数初始化本文模型及对比方法,使用APD07训练集分别对所有模型进行训练。训练相同的轮数后,使用APD07的测试集对6种模型效果进行测试,得到如表 1所示的实验结果。本文的语义分割模型在机场跑道裂缝分割场景中的F1-score达到了78.91%,优于其他几种模型效果。此外,针对机场跑道裂缝分割任务的召回率达到了77.35%,同样优于其他所有对比模型。最后,虽然裂缝分割的准确率略低于部分对比模型,但在实际应用场景中,更关注机场跑道裂缝的漏检情况,对比模型FCN虽然拥有最高的准确率,但在裂缝分割任务的召回率上表现不佳,即该模型对裂缝的漏检率极高,难以在实际应用场景中落地。本文模型能够很好地平衡准确率与召回率,符合工程化应用的需求。

|

|

表 1 CSA-net与其他算法对比结果 Tab. 1 Comparison between CSA-net and other algorithms |

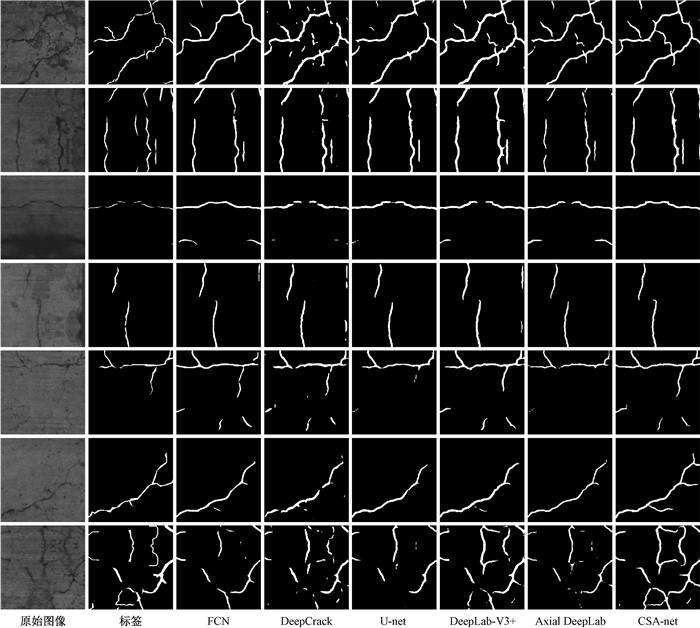

为直观体现模型的分割效果,本文选取APD07测试集中的部分图像进行效果可视化,结果如图 6所示。可见,本文设计的模型相较于其他5种对比模型在细小裂缝的分割上有着更好的效果。对于具有不同形态特征的裂缝,模型均能产生稳定的分割效果。模型抗干扰能力较强,不易将水渍、沥青、划痕等形似裂缝的目标错误分割。

|

图 6 不同算法结果对比 Fig. 6 Comparison of different algorithms |

为进一步证明本模型中各个模块的有效性,体现不同模块的相互作用关系,本文设计并开展了消融实验,表 2展示了不同模块对模型的影响。

|

|

表 2 消融实验的对比结果 Tab. 2 Comparison between ablation studies |

为提取不同裂缝的形态特征,本模型在残差模块中使用了可变形卷积。为证明其有效性,保持其余模块不变,将可变形卷积操作替换为普通卷积操作,在相同参数下对网络进行训练。结果如表 2中CSA-net w/Conv所示。可见可变形卷积对裂缝分割效果略有帮助但影响不大。

2.3.2 self-attention机制的有效性本文通过引入self-attention机制来提取裂缝的全局语义信息,为证明该模块的有效性,本实验将网络encoder部分的self-attention机制模块去除,单独保留axial-attention模块,其余模块和网络整体结构保持不变。在相同的实验条件下重新训练该网络,得到的分割效果如表 2中CSA-net w/o SA所示。可见self-attention机制对裂缝分割效果影响较大,证明全局语义信息对于裂缝分割有较大的帮助。

2.3.3 axial-attention机制的有效性针对裂缝在水平或垂直方向上分布的特点,本文采用axial-attention机制对机场跑道水平或垂直裂缝特征进行提取。为证明本模块的有效性,在网络中去除axial-attention模块,保持其他模块与参数不变,重新训练该网络,分割结果如表 2中CSA-net w/o ASA所示。结果表示裂缝在水平或垂直方向上的语义特征对于裂缝分割同样重要。

2.3.4 transformer decoder模块的有效性本文使用transformer decoder进行特征图上采样,通过融合不同特征层间的结果,减少特征细节的丢失。为验证该模块的有效性,本实验使用双线性插值来替换transformer decoder。保持其他模块及网络参数一致,重新训练整个网络,得到的分割结果如表 2中CSA-net w/Interp所示。由实验结果可以看出,对于裂缝分割任务,相较于双线性插值法,使用transformer decoder进行特征图上采样能够减少特征信息的丢失,获得更为精确的分割效果。

2.3.5 多种损失函数多个位置加权对网络加速收敛的有效性网络会在decoder的不同位置产生不同尺度的分割结果,为加速网络收敛,本文对网络不同位置输出结果计算交叉熵损失。并通过赋予不同权重的方式,强化监督信号。同时,考虑在实际场景中,裂缝占整张图像的比例较小,正、负样本严重不均衡,本文引入Dice loss解决这一问题。为验证上述两种策略的有效性,本文设计实验1)~3)。实验1)去除中间输出层的交叉熵损失函数与所有输出层的Dice loss,仅保留网络最终分割结果的交叉熵损失结果。实验2)去除中间输出层的交叉熵损失函数与Dice loss,为最后一层的输出结果计算交叉熵损失与Dice loss。实验3)去除所有输出层的Dice loss,保留所有输出层的交叉熵损失函数。在相同的实验环境下对网络模型重新训练,得到的分割结果如表 3所示。从表中实验结果可以看出,添加Dice loss之后,网络能够解决正、负样本不均衡的问题,对于不同类型的裂缝,网络均能产生稳定的分割效果。

|

|

表 3 损失函数策略的对比结果 Tab. 3 Comparison results of loss function strategies |

针对机场跑道表观裂缝的形态特点与分布方式,本文提出了联合self-attention与axial-attention的裂缝分割网络,通过引入两种不同方式的自注意力机制,使得网络可以提取裂缝的全局语义信息。同时,通过在残差模块中引入可变形卷积机制,在一定程度上弥补了CNN的不足,使得模型可以更好地提取病害的局部特征。通过堆叠几类模块,模型充分结合了CNN与transformer机制的优点,通过多种损失函数加权的形式,加速了网络收敛。实验结果表明,本文模型相较于CNN方法在机场跑道裂缝分割任务中有着更好的效果。但同时,本模型也存在网络推理速度较慢的问题,将在后续研究中关注该问题并加以改善。

| [1] |

LI P, WANG C, LI S M, et al. Research on crack detection method of airport runway based on twice-threshold segmentation[C]//The Fifth International Conference on Instrumentation and Measurement, Computer, Communication and Control. Piscataway: IEEE Press, 2015: 1716-1720.

(  0) 0) |

| [2] |

NOH Y, KOO D, KANG Y M, et al. Automatic crack detection on concrete images using segmentation via fuzzy C-means clustering[C]//International Conference on Applied System Innovation. Piscataway: IEEE Press, 2017: 877-880.

(  0) 0) |

| [3] |

白雪飞, 韩晓静, 王文剑. 一种视觉显著性引导的模糊聚类图像分割方法[J]. 郑州大学学报(理学版), 2022, 54(2): 1-7. BAI X F, HAN X J, WANG W J. Visual saliency-guided fuzzy clustering method for image segmentation[J]. Journal of Zhengzhou university (natural science edition), 2022, 54(2): 1-7. (  0) 0) |

| [4] |

LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2015: 3431-3440.

(  0) 0) |

| [5] |

RONNEBERGER O, FISCHER P, BROX T. U-net: convolutional networks for biomedical image segmentation[M]//Lecture notes in computer science. Cham: Springer International Publishing, 2015: 234-241.

(  0) 0) |

| [6] |

BADRINARAYANAN V, KENDALL A, CIPOLLA R. SegNet: a deep convolutional encoder-decoder architecture for image segmentation[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(12): 2481-2495. DOI:10.1109/TPAMI.2016.2644615 (  0) 0) |

| [7] |

CHEN L C, PAPANDREOU G, KOKKINOS I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE transactions on pattern analysis and machine intelligence, 2018, 40(4): 834-848. DOI:10.1109/TPAMI.2017.2699184 (  0) 0) |

| [8] |

ZOU Q, ZHANG Z, LI Q Q, et al. DeepCrack: learning hierarchical convolutional features for crack detection[J]. IEEE transactions on image processing, 2019, 28(3): 1498-1512. DOI:10.1109/TIP.2018.2878966 (  0) 0) |

| [9] |

KÖNIG J, DAVID JENKINS M, BARRIE P, et al. A convolutional neural network for pavement surface crack segmentation using residual connections and attention gating[C]//IEEE International Conference on Image Processing. Piscataway: IEEE Press, 2019: 1460-1464.

(  0) 0) |

| [10] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[EB/OL]. (2017-06-12)[2022-03-25]. https://arxiv.org/abs/1706.03762.

(  0) 0) |

| [11] |

DOSOVITSKIY A, BEYER L, KOLESNIKOV A, et al. An image is worth 16×16 words: transformers for image recognition at scale[EB/OL]. (2021-01-03)[2022-03-25]. https://arxiv.org/abs/2010.11929.

(  0) 0) |

| [12] |

HO J, KALCHBRENNER N, WEISSENBORN D, et al. Axial attention in multidimensional transformers[EB/OL]. (2019-12-20)[2022-03-25]. https://arxiv.org/abs/1912.12180.

(  0) 0) |

| [13] |

DAI J F, QI H Z, XIONG Y W, et al. Deformable convolutional networks[C]//IEEE International Conference on Computer Vision. Piscataway: IEEE Press, 2017: 764-773.

(  0) 0) |

| [14] |

GAO Y H, ZHOU M, METAXAS D N. UTNet: a hybrid transformer architecture for medical image segmentation[M]//Medical image computing and computer assisted intervention. Cham: Springer International Publishing, 2021: 61-71.

(  0) 0) |

| [15] |

WANG H Y, ZHU Y K, GREEN B, et al. Axial-DeepLab: stand-alone axial-attention for panoptic segmentation[C]//Proceedings of European Conference on Computer Vision. Cham: Springer International Publishing, 2020: 108-126.

(  0) 0) |

| [16] |

王知人, 谷昊晟, 任福全, 等. 基于深度卷积残差学习的图像超分辨[J]. 郑州大学学报(理学版), 2020, 52(3): 42-48. WANG Z R, GU H S, REN F Q, et al. Residual learning of deep CNN for image super-resolution[J]. Journal of Zhengzhou university (natural science edition), 2020, 52(3): 42-48. (  0) 0) |

| [17] |

VALANARASU J M J, OZA P, HACIHALILOGLU I, et al. Medical transformer: gated axial-attention for medical image segmentation[EB/OL]. (2021-02-20)[2022-03-23]. https://arxiv.org/abs/2102.10662.

(  0) 0) |

| [18] |

官申珂, 林晓, 郑晓妹, 等. 结合超像素分割的多尺度特征融合图像语义分割算法[J]. 图学学报, 2021, 42(3): 406-413. GUAN S K, LIN X, ZHENG X M, et al. A semantic segmentation algorithm using multi-scale feature fusion with combination of superpixel segmentation[J]. Journal of graphics, 2021, 42(3): 406-413. (  0) 0) |

| [19] |

田启川, 孟颖. 多尺度融合增强的图像语义分割算法[J]. 计算机工程与应用, 2021, 57(2): 177-185. TIAN Q C, MENG Y. Image semantic segmentation algorithm with multi-scale feature fusion and enhancement[J]. Computer engineering and applications, 2021, 57(2): 177-185. (  0) 0) |

| [20] |

CHEN L C, ZHU Y K, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]//Proceedings of the European Conference on Computer Vision. Cham: Springer International Publishing, 2018: 801-818.

(  0) 0) |

| [21] |

CHOLLET F. Xception: deep learning with depthwise separable convolutions[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2017: 1800-1807.

(  0) 0) |

| [22] |

MILLETARI F, NAVAB N, AHMADI S A. V-net: fully convolutional neural networks for volumetric medical image segmentation[C]//The Fourth International Conference on 3D Vision. Piscataway: IEEE Press, 2016: 565-571.

(  0) 0) |

| [23] |

DE BOER P T, KROESE D P, MANNOR S, et al. A tutorial on the cross-entropy method[J]. Annals of operations research, 2005, 134(1): 19-67. (  0) 0) |

2023, Vol. 55

2023, Vol. 55