2. 河南日报社 河南 郑州 450014

2. Henan Daily, Zhengzhou 450014, China

在人工智能领域的迅速发展中,模拟和理解世界的能力成为研究和开发的重要课题之一。在这个背景下,世界模型的概念应运而生,它旨在构建能够模拟和理解环境的大型神经网络系统。世界模型不仅是对环境的建模,更是对人类认知方式的模仿,其试图通过感知和经验构建内在模型,并以此进行推理、规划和决策。世界模型的核心思想是利用神经网络来构建环境的模型,使其能够模拟现实世界的各种特征,并为人工智能系统提供一个更丰富、更准确的认知基础。这种模型不仅可以处理多种类型的数据,如图像、文本等,还可以应用于各种任务,如规划、决策和控制等。尽管世界模型的概念还处于探索阶段,但已经引起了广泛的关注和研究。研究人员希望通过不断改进和扩展世界模型,使其能够更好地适应复杂多变的现实世界,并为人工智能技术的发展带来新的突破和机遇。本文将对世界模型的发展历程、核心思想、技术实现以及实际应用进行探讨,旨在为读者提供一个全面了解世界模型的视角,并展望了其在人工智能领域的潜在应用和影响。

1 研究背景世界模型的概念最早可以追溯到哲学家伊曼努尔·康德(Immanuel Kant)在18世纪提出的认识论理论。

1971年,系统动力学之父Forrester[1]提出了心智模型:人类会利用其有限的感官去感知周围的事物,以此来建立内心世界模型,人类做出的决策和行动都是基于这种内部模型。人的脑海中携带的周围世界的形象只是一个模型。人们只选择了概念,以及它们之间的关系,并用它们来表示真实的系统。也就是说,为了处理日常生活中流动的大量信息,人类大脑学习了这些信息的空间和时间方面的抽象表示,然后建立世界模型[2]。在任何时刻,人类的感知都受大脑内部世界模型对未来预测结果的支配[3]。

Keller等[4]认为,大脑内部的模型不仅仅是在预测未来,也同时在预测未来的感官数据,因为在人类运动的过程中,会下意识地对即将到来的危险做出反应,而不是通过预测未来得到结果后制订相应的计划[5]。

世界模型的目的是设计一个可以更新状态的神经网络模块,用来记忆和建模环境,实现输入当前观测(图像、状态等)和即将采取的动作,根据模型对世界的记忆和理解预测下一个可能的观测和动作,并通过采取动作将下一时刻的实际观测和预测的观测之间的差异作为损失(loss)来自监督训练模型[6]。在世界模型的训练中,loss是一个用于衡量模型预测与实际观测之间差异的指标,常见的loss包括均方误差、平均绝对误差等。

2 基础理论 2.1 基于递归神经网络的世界模型Schmidhuber[7]提出了基于递归神经网络(recursive neural network,RNN)的世界模型,该模型使用从实际游戏环境中收集的观察结果进行训练。在训练世界模型后,可以使用它们来模拟完整的环境,并以此来训练智能体。大型RNN是具有高度表现力的模型,可以学习数据的丰富空间和时间表示。然而,许多无模型强化学习方法通常只使用参数很少的小型神经网络。强化学习算法经常受到信用分配问题的影响,使得其很难学习大型模型的数百万个权重。因此,在实践中经常使用较小的网络,因为它们在训练期间迭代到良好策略的速度更快。

Schmidhuber[7]认为在理想情况下能够有效地训练基于RNN的大型世界模型。另外,反向传播算法[8-10]能够有效地训练大型神经网络。总的来说,该模型是通过训练一个大型神经网络来处理强化学习任务,方法是将代理划分为一个大的世界模型和一个小的控制器模型。首先训练一个大型神经网络,以无监督的方式学习智能体世界的模型,然后训练较小的控制器模型,以学习使用这个世界模型执行任务。一个小的控制器让训练算法专注于小搜索空间上的信用分配问题,同时不会通过更大的世界模型牺牲容量和表现力。

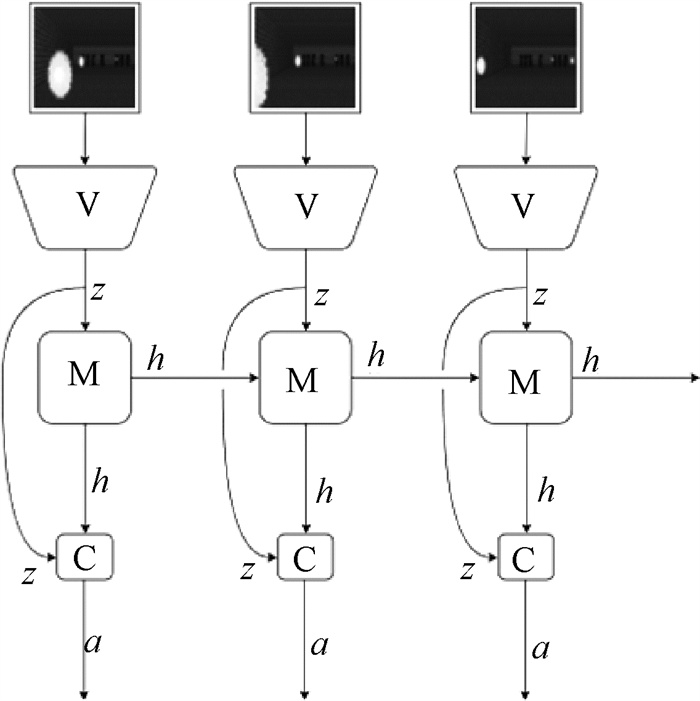

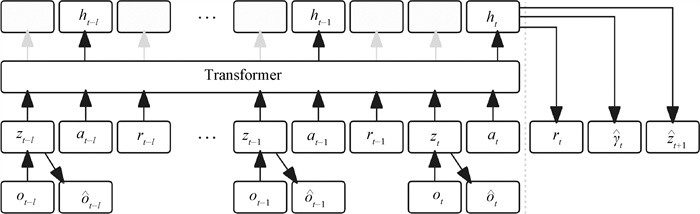

图 1是由视觉、内存和控制器组成的智能体,是一个类似人类认知系统的简单模型。在这个模型中,首先,智能体有一个视觉感官组件,它把所看到的压缩成一个小的代表性代码。其次,智能体还具有一个内存组件,可根据历史信息对未来代码进行预测。最后,智能体有一个决策组件,它仅根据其视觉和记忆组件创建的表示来决定要采取的行动。图 1中,视觉模型(V)将高维观测编码成低维潜在向量;记忆循环神经网络(M)整合历史编码,创建可预测未来状态的表示形式;一个小的控制器(C)利用来自V和M的表示来选择良好的动作。代理执行这些动作,这些动作会反过来影响环境。a表示代理采取的行动,例如移动、旋转等。h表示隐藏状态,它包含了过去的信息,对当前时间步的输出有影响。z表示模型从环境中接收到的观测或感知的信息,例如传感器数据、图像像素等。

|

图 1 由视觉、内存和控制器组成的智能体 Fig. 1 Intelligent agents composed of vision, memory, and controller |

由于RNN无法充分挖掘输入之间的关系导致训练效果较差,在大规模序列学习任务中容易出现性能瓶颈,难以应对真实应用的决策挑战[11]。早期的世界模型已有压缩神经表征的训练思想,但主要存在以下局限:一是模拟环境下训练缺乏真实世界适应性;二是模型存储编码能力有限导致灾难性遗忘;三是无法突破认知壁垒[12-13]。因此,文献[14]提出了全新的世界模型概念——联合嵌入预测架构(joint embedding predictive architecture,JEPA),并基于该模型设想了自主人工智能架构,其功能模块如表 1所示。

|

|

表 1 以世界模型为中心的自主人工智能架构功能模块 Tab. 1 Autonomous artificial intelligence architecture functional modules centered on the world model |

JEPA是一种神经网络架构,旨在实现联合嵌入和预测任务。这个架构结合了嵌入学习和预测模型,以便在一个统一的框架下进行多种任务,如推荐系统、搜索引擎、自然语言处理等。

JEPA架构的核心思想是将输入数据和目标数据映射到一个共同的嵌入空间,从而使得输入数据和目标数据能够在这个嵌入空间中进行有效表示和比较。通过这种方式,JEPA能够同时处理输入数据和目标数据,从而实现联合预测任务。

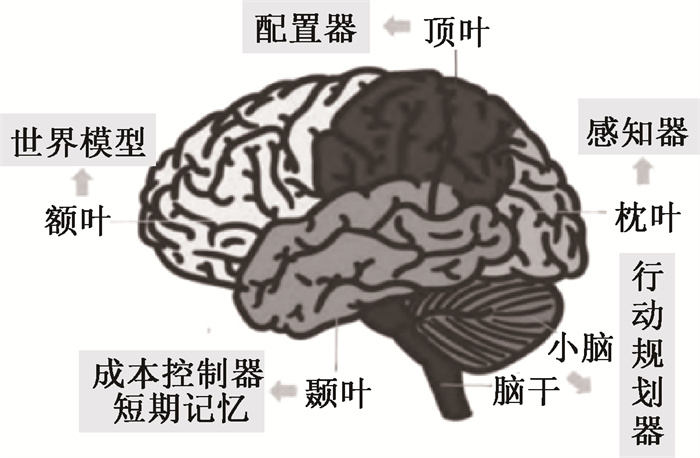

该架构的六大模块分别为:配置器、感知器、世界模型、成本控制器、行动规划器和短期记忆。这六大模块之间相互协调和适应,与人脑的四大脑区之间的分工具有一定的相似性。自主人工智能模块与人脑脑区的联系如图 2所示。人脑大体可分为大脑、脑干、小脑和边缘系统四部分,其中与人的高级认知相关的区域均位于大脑的额叶、枕叶、顶叶和颞叶区。

|

图 2 自主人工智能模块与人脑脑区的联系 Fig. 2 The connection between autonomous artificial intelligence modules and human brain regions |

首先,额叶作为大脑中发育最高级的部分,是人类大部分意识产生的区域,可直接访问感觉信息并控制专用于计划、判断和运动执行的区域[15],这与自主人工智能架构的世界模型模块相对应。其次,枕叶是大脑的视觉处理中心,是视觉空间处理、颜色辨别和运动感知区域[16],对应感知器。再次,颞叶主要负责记忆存储、语言理解和情绪联系方面的处理[17],对应成本控制器和短期记忆。最后,顶叶主要负责整合内外部感觉反馈,并将其整合为连贯的表征,以完成协调工作[18],相当于配置器的作用。此外,行动规划器计算智能体动作序列的先后顺序并选择最优动作,与小脑、脑干等对躯体的控制相关。

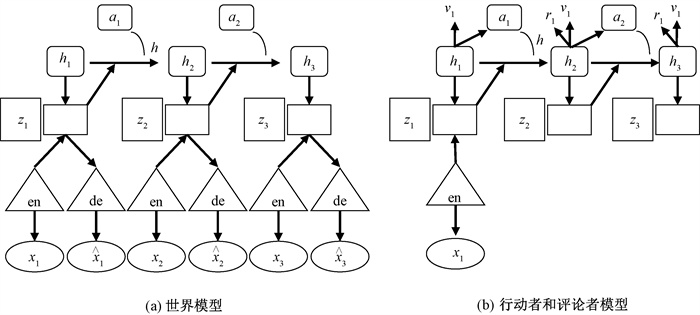

3 世界模型的主要算法 3.1 DreamerV3DreamerV3是一种通用且可扩展的算法,它在固定超参数情况下可应用于各种领域,且表现优于领域特定的算法[19-20]。DreamerV3从具有丰富感知和图像训练的经验中学习世界模型。该算法由3个神经网络组成:世界模型、评论者(critic)和行动者(actor)。世界模型预测了潜在动作的未来结果,评论者判断每个状态的价值,而行动者学会了达到有价值的状态。这3个网络从经验回放中共同训练而没有梯度共享,训练过程如图 3所示。世界模型接收感官输入,通过递归状态ht的序列模型生成表示,并使用zt表示来预测未来的动作。然后,模型通过重新构造输入来生成学习信号,以优化表示的性能。

|

图 3 DreamerV3的训练过程 Fig. 3 The training process of DreamerV3 |

世界模型通过自编码来学习感官输入的紧凑表示,并通过预测未来和潜在动作的奖励来实现计划。如图 3所示,将世界模型用一个循环状态空间模型——递归状态空间模型(recurrent state-space model,RSSM) [21]来实现。首先,编码器将感官输入xt映射到随机表示zt。然后,具有循环状态ht的序列模型基于给定的历史动作at-1预测该表示序列,ht和zt的拼接形成了模型状态,可以从中预测奖赏rt和episode联系标志ct∈{0, 1},并重建输入以确保信息表示[22],

| $ \operatorname{RSSM}\left\{\begin{array}{l} \text { Sequence model: } h_t=f_\phi\left(h_{t-1}, z_{t-1}, a_{t-1}\right), \\ \text { Encoder: } z_t \sim q_\phi\left(z_t \mid h_t, x_t\right), \\ \text { Dynamics predictor: } \hat{z}_t \sim p_\phi\left(\hat{z}_t \mid h_t\right), \end{array}\right. \\ \operatorname{Reward predictor}: \hat{r}_t \sim p_\phi\left(\hat{r}_t \mid h_t, z_t\right), \\ \operatorname{Continuation predictor}: \hat{c}_t \sim p_\phi\left(\hat{c}_t \mid h_t, z_t\right), \\ \operatorname{Decoder}: \hat{x}_t \sim p_\phi\left(\hat{x}_t \mid h_t, z_t\right) 。$ | (1) |

DreamerV3在多个领域表现优异,包括连续和离散动作、视觉和低维输入、2D和3D世界等,显示出其通用性和适应性。通过调整模型参数,它可以轻松应对不同任务的需求,并具有良好的扩展性,可提高数据效率和性能。DreamerV3是首个在没有人类数据训练的情况下,在Minecraft(一款沙盒游戏,提供了大量的数据和场景,可用于算法的训练和测试)中收集钻石的算法,这标志着人工智能领域在解决长期挑战方面取得了重要进展。其成功应用显示了DreamerV3在处理复杂环境和决策问题时的有效性,算法设计还允许在训练过程中充分利用经验数据,提高了学习效率和稳定性。

3.2 TransDreamerTransDreamer继承自Dreamer框架、基于Transformer的强化学习代理, 其重点是引入Transformer的优点[23]。TransDreamer的目标是实现以下需求。

1) 直接访问过去的状态。

2) 在训练期间并行更新每个时间步的状态。

3) 能够在测试时顺序推出轨迹想象。

4) 成为随机潜变量模型。

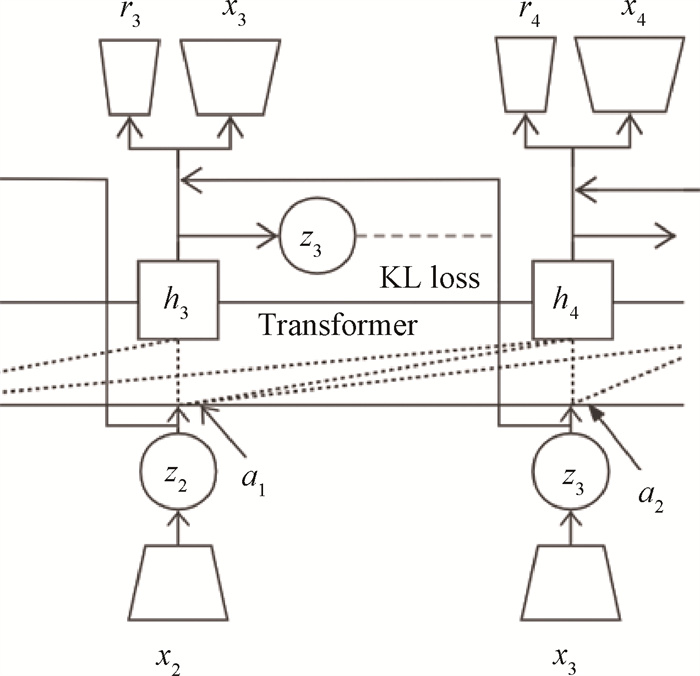

据调查,以往的世界模型还没有这样的模式,Dreamer中使用的世界模型的主干是RSSM,RSSM不满足上述需求1)和2)。因此,引入一种基于Transformer的状态空间模型(Transformer state-space model, TSSM)是必要的,图 4展示了其架构。

|

图 4 TSSM架构 Fig. 4 TSSM architecture |

在RSSM中,顺序相关计算的主要来源是基于RNN的状态更新,这说明RSSM的所有组件模型都是顺序计算的,因为它们都将隐藏状态作为输入。

为了消除这种顺序计算,能够直接访问并和复杂的历史状态相互作用,采用Transformer作为RNN的替代品,允许Transformer直接访问随机状态和动作的序列[23],可以使得预测更准确。

3.3 STORM基于随机Transformer的世界模型(stochastic Transformer-based world model, STORM)是一种高效的世界模型架构。STORM采用分类变分自编码器(variational auto-encoder,VAE)作为图像编码器,增强了代理的鲁棒性,减少了累积的自回归预测误差。STORM采用类似GPT的Transformer[24]作为序列模型,提高建模和生成质量,同时加快训练过程。

STORM基于模型的强化学习算法的既定框架,重点在于通过想象力增强代理的策略[25-28],反复执行以下步骤,直至达到规定的真实环境交互次数。

1) 通过执行当前策略来收集真实的环境数据,并将它们附加到重放缓冲区。

2) 使用从重放缓冲器采样的轨迹来更新世界模型。

3) 使用由世界模型生成的想象经验来改进策略,其中从重放缓冲器采样想象过程的起点。

如式(2)所示,利用VAE[29]将ot转换为潜在随机分类分布

| $ \begin{aligned} & \text { Image encoder: } z_t \sim q_\phi\left(z_t \mid o_t\right)=\mathscr{Z}_t, \\ & \text { Image decoder: } \hat{o}_t=p_\phi\left(z_t\right) 。\end{aligned} $ | (2) |

STORM的结构和想象过程如图 5所示。

|

图 5 STORM的结构和想象过程 Fig. 5 The structure and imagination process of STORM |

在进入序列模型之前,利用多层感知器和拼接操作,将潜在样本zt和动作at合并成一个单独的标记et,这个操作表示为mϕ,它为序列模型准备输入。序列模型fϕ将et的序列作为输入,并产生隐藏状态ht。

STORM采用类似GPT的Transformer结构作为序列模型,其中的自注意力块使用后续掩码进行屏蔽,以允许et关注到序列e1, e2, …, et。通过利用多层感知器gϕD、gϕR和gϕC,依赖ht来预测当前的奖励

| $ \text{Action mixer}: e_t=m_\phi\left(z_t, a_t\right), \\ \text{Sequence model}: h_{1: T}=f_\phi\left(e_{1: T}\right), \\ \text{Dynamics predictor}: \hat{\mathscr{Z}}_{t+1}=g_\phi^D\left(\hat{z}_{t+1} \mid h_t\right), \\ \text{Reward predictor}: \hat{r}_t=g_\phi^R\left(h_t\right), \\ \text{Continuation predictor}: \hat{c}_t=g_\phi^C\left(h_t\right) 。$ | (3) |

损失函数世界模型以自我监督的方式进行训练,并进行端到端优化。固定超参数β1=0.5和β2=0.1,B表示批次大小,T表示批次长度,总损失函数可表示为

| $ \begin{aligned} & \mathcal{L}(\phi)=\frac{1}{B T} \sum\limits_{n=1}^B \sum\limits_{t=1}^T\left[\mathcal{L}_t^{\text {rec }}(\phi)+\mathcal{L}_t^{\text {rew }}(\phi)+\mathcal{L}_t^{\text {con }}(\phi)+\right. \\ & \left.\beta_1 \mathcal{L}_t^{\text {dyn }}(\phi)+\beta_2 \mathcal{L}_t^{\text {rep }}(\phi)\right], \end{aligned} $ | (4) |

其中:

| $ \begin{aligned} \mathcal{L}_t^{\mathrm{rec}}(\phi) & =\left\|\hat{o}_t-o_t\right\|_2 \\ \mathcal{L}_t^{\mathrm{rew}}(\phi) & =\mathcal{L}^{\text {sym }}\left(\hat{r}_t, r_t\right) \\ \mathcal{L}_t^{\mathrm{con}}(\phi) & =c_t \log \hat{c}_t+\left(1-c_t\right) \log \left(1-\hat{c}_t\right) \end{aligned} $ | (5) |

其中:

式(4)中,损失

| $ \begin{aligned} & \mathcal{L}_t^{\text {dyn }}(\phi)=\max \left(1, K L\left[s g\left(q_\phi\left(z_{t+1} \mid o_{t+1}\right)\right) \| g_\phi^D\left(\hat{z}_{t+1} \mid h_t\right)\right]\right), \\ & \mathcal{L}_t^{\text {rep }}(\phi)=\max \left(1, K L\left[q_\phi\left(z_{t+1} \mid o_{t+1}\right) \| s g\left(g_\phi^D\left(\hat{z}_{t+1} \mid h_t\right)\right)\right]\right), \end{aligned} $ | (6) |

其中:sg()表示停止梯度的运算。

3.4 TWM基于Transformer的世界模型(Transformer-based world model,TWM),其概念是在想象中学习,不是直接从所收集的经验中学习行为,而是以(自)监督的方式学习环境动态的生成模型[32]。这种世界模型可以通过迭代预测下一个状态和奖励来创建新的轨迹,允许用于强化学习算法的潜在不确定的训练数据,而无须与真实的环境进一步交互。

由于深度神经网络的性质,世界模型可以推广到新的、不可见的情况,这有可能大大提高样本效率。一个训练成功的世界模型可能会预测到以前从未训练到的数据。

TWM由观测模型和动力学模型组成,它们不共享参数。图 6展示了TWM架构,其采用DreamerV2的神经网络架构[20]对观测模型进行了轻微修改。因此,潜在状态z是离散的。观测解码器重构观测并预测所有像素的独立标准正态分布的均值。

|

图 6 TWM架构 Fig. 6 TWM architecture |

自回归动力学模型根据其预测的历史来预测下一个时间步。骨干是一个确定性的聚合模型f,它根据“先前生成的潜在状态、动作和奖励”的预测历史来计算确定性的隐藏状态h,奖励、折扣和下一个潜在状态的预测器以隐藏状态为条件。动力学模型由以下组件组成,公式为

| $ \text{Aggregation model}: h_t=f_\psi\left(z_{t-\ell}, a_{t-\ell: t}, r_{t-\ell: t-1}\right),\\ \text{Reward predictor}: \hat{r}_t \sim p_\psi\left(\hat{r}_t \mid h_t\right), \\ \text{Discount predictor}: \hat{\gamma}_t \sim p_\psi\left(\hat{\gamma}_t \mid h_t\right), \\ \text{Latent state predictor}: \hat{z}_{t+1} \sim p_\psi\left(\hat{z}_{t+1} \mid h_t\right)。$ | (7) |

聚合模型被实现为因果掩蔽的Transformer-XL,显著增强了原始的Transformer模型(vanilla Transformer),引入了循环机制和相对位置编码。通过这些编码,TWM可以学习与时间步长无关的动态。潜在状态、动作和奖励被送入模态特定的线性嵌入,然后传递给Transformer模型。模型接收三种类型的输入,输入有三种模态(潜在状态、动作、奖励),最后一个奖励不作为输入的一部分(奖励的输入有一个特殊的规定,即最后一个奖励不被视为输入的一部分)。将动作模态的输出视为隐藏状态,而忽略其他两个模态的输出(图 6)。

训练包括:使用当前策略在真实的环境中收集经验;使用过去的经验改进世界模型;使用世界模型产生的新经验改进策略。

在训练期间,构建数据集D。在收集了当前策略的新经验之后,通过从D中采样N个序列,并使用随机梯度下降方法优化的损失函数来改进世界模型。在执行世界模型更新之后,从N个观测值中选择M个,并将它们编码为潜在状态,作为新轨迹的初始状态。动态模型基于策略提供的动作迭代地生成长度为H的M个轨迹。随后,使用标准的无模型目标改进策略。

由于数据集在训练过程中增长缓慢,轨迹的均匀采样过于关注早期经验,这可能导致过度拟合,特别是在低数据状态下。因此,保持访问计数,其在每次作为序列的开始对条目进行采样时递增,使用Softmax函数将这些计数转换为概率。

3.5 MWM掩蔽世界模型(masked world model,MWM)是一种基于视觉模型的强化学习算法[33],如图 7所示,它将视觉表示学习和动态学习结合起来,通过分别学习视觉表示和环境动态来学习准确的世界模型。MWM的关键思想是训练一个自动编码器,该自动编码器使用卷积特征掩蔽来重建视觉观察结果,并在自动编码器之上建立一个潜在的动态模型。通过引入早期卷积层并屏蔽卷积特征而不是像素补丁,MWM使世界模型能够从复杂的视觉观察中捕获细粒度的视觉细节。此外,为了学习那些可能无法仅通过重建目标来捕获的与任务相关的信息,MWM引入一个辅助奖励预测任务的自动编码器。具体来说,通过重复以下迭代过程分别更新视觉表示和动态:使用卷积特征掩蔽和奖励预测训练自动编码器;学习预测自动编码器视觉表示的潜在动态模型。

|

图 7 MWM方法说明 Fig. 7 MWM method description |

使用从环境交互中收集的在线样本不断更新视觉表示和动态,自动编码器参数在动态学习期间不会更新。

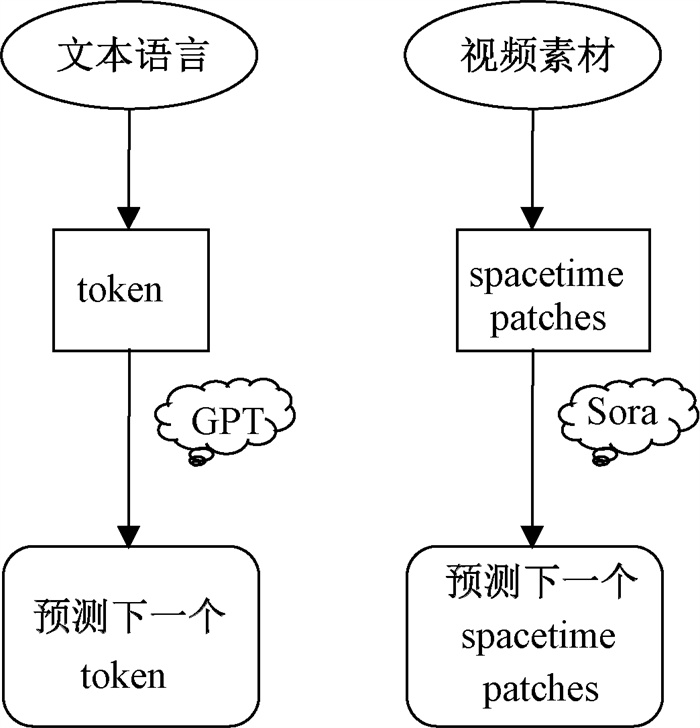

4 世界模型的应用 4.1 Sora2024年2月15日,OpenAI推出了一种新的基础模型,可以从用户的文本提示生成视频。这种名为Sora的模型,人们称之为ChatGPT的视频版本。OpenAI声称,由于在大规模的文本-视频数据集上进行训练,Sora具有令人印象深刻的接近真实世界的生成能力,包括创建生动的人物、模拟平滑的动作、描绘情感以及提供突出的物体和背景的细节。

目前,Sora模型官方只出了一个技术报告,并没有公布具体技术细节。但是,从ChatGPT的实现过程中不难得知,任何AI大型模型都需要“基本粒子”才能得以实现[34]。ChatGPT技术原理的起点是将“自然语言”token化,也就是给大语言模型提供了一个可计算、可理解的“基本粒子”,然后用这些“基本粒子”去组合文本语言新世界[35]。Sora的工作原理也应如此,其实现步骤如图 8所示。

|

图 8 Sora实现步骤 Fig. 8 Implementation steps of Sora |

与ChatGPT采用token embedding方法以实现文本数据相似,Sora模型将视频数据压缩至一个低维的潜空间,再将这些压缩后的数据细分为时空碎片,最后进行AI时空建模[36]。

目前,Sora作为世界模拟器表现出许多局限性。例如,它不能精确地模拟如玻璃破碎等复杂物理相互作用,同时,在类似吃食物这样的交互中,它也不是总能准确地反映对象状态的变化。并且,当视频过长时会出现不连贯性,或者有其他未提及的对象自发出现的问题。

4.2 Gemini为了与GPT-4抗衡,谷歌公司发布了新一代世界模型Gemini。传统的多模态模型通过分别训练处理各类信息类型的组件,然后将它们组合在一起的方式来构建。虽然这些模型在某些任务上表现不错,比如描述图像,但在处理更复杂的概念和推理时,效果并不理想。为了提升多模态模型的性能,谷歌采用了一种不同的策略,将Gemini设计成一个原生多模态模型。这意味着Gemini从一开始就在各种信息类型上进行了预训练,然后通过额外的多模态数据微调,使其更好地理解和推理各种输入。三种优化过后的能力如下[37]。

1) 复杂的推理能力

Gemini的多模态推理能力有助于理解复杂的书面和视觉信息,能在大规模的数据提取中识别微小的差异点。通过阅读、过滤和理解信息,从成千上万的文档中提取独到的信息和见解,有利于未来在众多领域中以数字化的速度实现新的突破。

2) 理解文本、图像、音频等内容的能力

经过训练,Gemini可以同时识别和理解文本、图像、音频及更多内容,因此它能更好地理解细微信息,回答与复杂主题相关的问题,且尤其擅长解释数学和物理等复杂学科的推理。

3) 高级编码能力

谷歌的第1版Gemini可以理解、解释和生成主流编程语言(如Python、Java、C++和Go)的高质量代码,能够跨语言工作并推理复杂的信息。

4.3 DynalangDynalang是一种代理程序,它从在线经验中学习语言和图像的世界模型,并利用该模型学习如何行动。Dynalang将学习建模世界和语言(通过预测目标进行监督学习)及根据该模型学习行动(通过任务奖励进行强化学习)分开。在这个应用中,世界模型接收视觉和文本输入作为观察模态,并将它们压缩到潜在空间中。训练世界模型使用在线收集的经验来预测未来的潜在表示。训练策略以最大化任务奖励的方式采取行动,将世界模型的潜在表示作为输入。由于世界建模与行动分离,Dynalang可以在单一模态(仅文本或仅视频数据)上进行预训练,而不涉及行动或任务奖励。

简单来说,Dynalang在接收视频、文本或多模态表示后,预测给定信息的未来表示。预测未来的表示不仅为视觉体验中的基础语言提供了丰富的学习信号,而且还允许从想象的序列中进行规划和策略优化。Dynalang结构如图 9所示。在每个时间步,它接收图像x、语言标记l和动作a。图像和语言观察被压缩成一个离散的表示z,并与动作一起输入序列模型,以预测下一个表示z。

|

图 9 Dynalang结构 Fig. 9 Dynalang structure |

Dynalang 将世界模型用一个循环状态空间模型来实现,该世界模型由以下组件组成,公式为

| $ \text{Sequence model} : \hat{z}_t, h_t=\operatorname{seq}\left(z_{t-1}, h_{t-1}, a_{t-1}\right), \\ \text{Multimodal encoder}: z_t \sim \operatorname{enc}\left(x_t, l_t, h_t\right), \\ \text{Multimodal decoder} : \hat{x}_t, \hat{l}_t, \hat{r}_t, \hat{c}_t=\operatorname{dec}\left(z_t, h_t\right) 。$ | (8) |

其中,序列模型以带有循环状态ht的GRU来实现。使用循环模型的好处在于策略不再需要随时间积累信息,但也可以使用其他序列模型,如Transformer。在每个时间步,编码器在观察模型状态ht的条件下进行建模,有效地学习将观察压缩为相对于历史的代码zt。然后,序列模型在编码观察zt的条件下,将新观察整合到下一个模型状态中。解码器经过训练以重构观察和其他信息,从而塑造模型的表示形式。

该模型的循环架构可能使在极长的视野环境中的优化具有挑战性。Dynalang的设计是将视觉和语言标记一对一地交错,允许智能体在通信时采取行动,但可能会导致序列长度成为某些任务中学习的瓶颈。

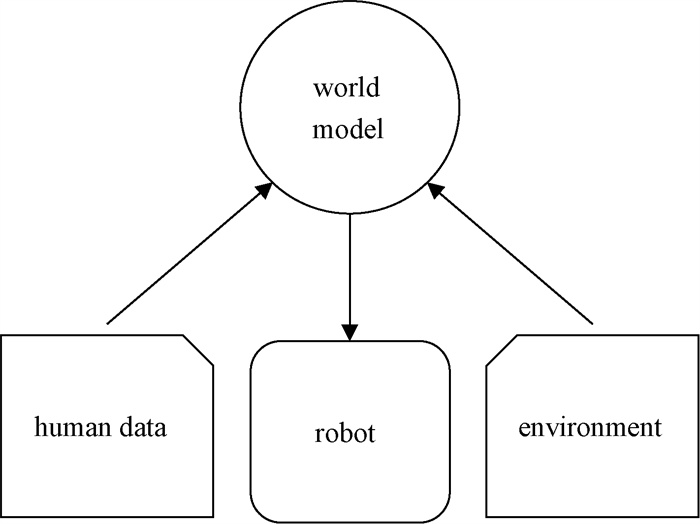

4.4 SWIM意向性的结构化世界模型(structured world model for intentionality,SWIM)[38]是一种在真实的世界中学习操作任务,利用这些丰富的数据来训练机器人世界模型,使机器人能够预测其在任何环境中的行为后果。

SWIM利用大规模的互联网数据,使用结构化的动作空间来训练机器人世界模型,其结构如图 10所示。在通用的高级结构化动作空间中训练世界模型,使其能够捕捉人手在试图抓住和操纵物体时如何与物体交互,可以仅使用少量真实世界的交互轨迹,对世界模型进行微调。此外,用于微调的这些交互轨迹不需要任何任务监督,并且可以通过执行视觉动作来获取。无论是在人类视频上进行预训练,还是在机器人数据上进行世界模型微调,都不会对奖励做出任何假设。这种无监督设置允许利用与不同任务相关的数据,从而使机器人能够在所有数据上训练单一的世界模型,培养机器人或人工智能系统具有多方面、多任务的能力。

|

图 10 SWIM结构 Fig. 10 SWIM structure |

在Mendonca R、Bahl S、Pathak D实验中展示了通过两个不同的机器人系统在真实世界环境中运行,来训练这种联合世界模型的方法。在应用方面,可以通过指定目标图像来部署微调后的世界模型,以执行特定的任务。世界模型在动作空间中进行规划,以找到一系列动作,根据任务要求操纵物体。

SWIM的训练过程包括三个阶段:利用人类交互的互联网视频来预训练模型;使用无奖励数据将模型微调到机器人设置;通过模型进行规划以实现目标。具体情况如下。

1) 预训练

利用人类视频数据集,需要初始化世界模型和可供性模型(经过预训练的学习模型),并对视频片段进行处理,提取像素信息。在动作创建阶段,随机采样深度和旋转角度,以增加模型对不同场景的适应能力。通过训练可供性模型,能够从视频帧中理解动作,并在决策和规划中提供支持。同时,通过轨迹序列训练世界模型,能够理解物体间的关系和环境的变化。最终获得了训练好的世界模型和可供性模型,为后续任务提供可靠的基础。

2) 对机器人数据进行无监督微调

在实际环境中,通过模仿学习和模型预测,让机器人完成特定的任务,从而实现从仿真到真实世界的迁移。

获取经过预训练得到的世界模型和可供性模型,通过对可供性模型进行多次查询,收集机器人数据集,用于训练世界模型。

给定目标图像,使用目标图像对机器人数据集中的轨迹进行排序,并使用高斯混合模型对轨迹进行拟合;对于每一个轨迹,从可供性模型中查询提案;通过世界模型使用交叉熵方法选择最佳提案,选择最佳的动作,以达到目标图像;最后执行所选择的最佳提案,让机器人达到目标图像。

3) 机器人部署以执行给定目标图像的任务

通过运行可供性模型来收集机器人数据集,需要收集一些域内机器人数据进行微调,这一步不需要以任务奖励进行任何监督。

基于专家设计的动作空间学习,能够学习人手如何与环境交互,利用在标记数据上训练的检测器从未标记的真实世界视频中获取动作。

虽然SWIM提供了一个可扩展的解决方案并显示出令人惊喜的结果,但可以执行的操作和任务类型存在一些限制,目前仅包括准静态设置。在未来的工作中,可以探索不同的动作参数化和其他类型的操作任务。如果可以扩展到更多的任务,通过从被动和主动数据中学习构建一个真正的多面手代理,该模型可以变得更好。

4.5 MUVO具有几何体素表示的多模态世界模型(multimodal world model with geometric voxel representations,MUVO)[39]是一个具有几何表示的自动驾驶多模态生成世界模型。该模型利用来自自动驾驶汽车的高分辨率图像和激光雷达传感器数据来预测原始相机和激光雷达数据以及未来多个步骤的3D占用表示。MUVO首先对原始相机图像和激光雷达点云进行处理、编码和融合,由此产生潜在表征,然后送入过渡模型,以动作为条件,预测未来的状态。最后,将这些未来状态解码为3D占用网格、原始点云和原始RGB图像。

MUVO工作流程如图 11所示。首先,处理编码和融合高分辨率RGB相机数据、激光雷达点云与基于Transformer的架构。其次,将传感器数据的潜在表示馈送到过渡模型,以导出当前状态的概率模型,然后进行采样,同时预测未来状态的概率模型并从中采样。最后,从概率模型中解码当前和未来状态,预测未来多帧的原始RGB图像、点云和3D占用网格。

|

图 11 MUVO工作流程 Fig. 11 MUVO workflow |

因此,先前的世界模型主要是学习数据中的模式,而不是对真实的世界进行建模。无监督学习传感器无关的几何占用表示的方法为模型提供了对物理世界的基本理解。

MUVO虽然创意性地提出模拟真实汽车行驶状况,从而预测驾驶员未来动作。但是,道路交通本身就具有不确定性,在很多情况下,未知事件的发生是人工智能无法做出判断的。此外,由于恶劣天气或者设备缺陷问题,图像的清晰度也无法得到保证,图像的代表性也较为单一。

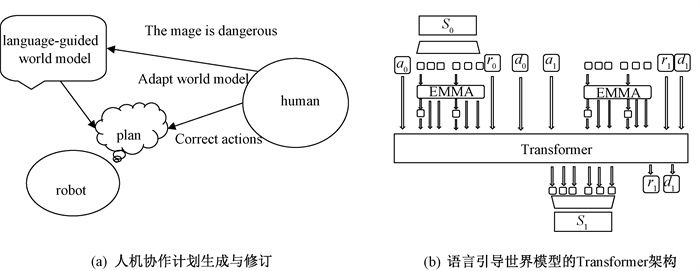

4.6 LWM基于语义的世界模型(language-guided world model,LWM)[40]可以通过阅读语言描述来捕获环境动态。该模型提高了智能体的通信效率,允许人类通过简洁的语言反馈同时改变其在多个任务中的行为。LWM还使智能体能够从最初为指导人类而编写的文本中进行自我学习。

图 12展示了智能引导的世界模型。如图 12(a)所示,这些模型使代理能够编写直观的计划,并邀请人类监督员来验证和修改这些计划。此外,它们还为管理者提供了各种修改计划的策略:提供行动纠正反馈来更新代理的策略,或者提供描述环境的语言反馈来修改其世界模型。图 12(b)给出了语言引导世界模型的Transformer架构,表现出很强的组合概括性,将轨迹转换成一个长序列的令牌,和训练Transformer自动回归生成这些令牌,实现了专门注意力机制,将文本信息纳入观察令牌中。

|

图 12 智能引导的世界模型 Fig. 12 Intelligent guided world model |

LWM在很大程度上提升了人工智能处理人类发布任务的效率。但现今,人工智能在某些方面并不能识别人类的感情,对待任务的处理方式也较为单一。此外,模型的精确度也会因为每次训练时人类发布不同任务的难易程度有所变化。

5 展望随着数据采集和处理技术的不断进步,世界模型的发展将更加依赖大数据和机器学习算法。通过分析海量数据,模型可以更准确地预测和解释现实世界的各种现象。未来,世界模型的发展会更加强调跨学科的融合,涉及物理学、生物学、社会学、经济学、环境科学等多个学科领域。这种融合将有助于构建多维度的模型,更好地反映现实世界的复杂性。此外,世界模型将越来越智能化和自主化,能够根据外部环境和输入自动调整和更新。这将使模型更具适应性和灵活性,能够更好地应对不断变化的情境,并且能够自主地进行推理和决策。

世界模型的广泛运用将对多个领域产生影响,具体而言包括但不限于以下四个领域。

一是电影创作。在影视制作行业,世界模型可以帮助电影制作者更好地创建场景和情节,以丰富电影的内容和表现力。此外,世界模型可以为电影制作提供更加真实和自然的角色表现以及更逼真的视觉效果。对影视行业而言,世界模型将带来革命性的改变。传统的影视制作流程通常需要大量人力、物力和财力,而世界模型可以帮助影视制作公司降低制作成本和提高效率,并快速生成高质量的视频内容。这将使更多的小型制作公司和独立制片人进入影视制作领域,推动影视产业的多元化发展。

二是广告创意。世界模型可以帮助广告制作者更好地表达广告创意,以提供更加生动和吸引人的视觉效果。它还可以帮助广告制作者更好地理解目标受众的需求和喜好,以提供更加个性化的广告体验。对创意产业而言,世界模型将带来革命性变革。创意产业包括广告、设计、文学、艺术等领域,上述领域需要不断创新并以新颖的内容吸引观众和客户。通过文字生成视频人工智能技术,创意人才和内容创作者将获得更多灵感和工具,可以更加轻松地创作出高品质的视频内容。这将推动创意产业的发展,激发创意人才的能动性和创造力,进一步丰富数字内容产业的多样性。

三是游戏开发。世界模型可以帮助游戏开发者创建更加真实和自然的游戏场景和角色表现,以提供更加沉浸式的游戏体验。此外,还可以帮助游戏开发者更好地理解游戏玩家的需求和反馈,优化游戏设计和体验。

四是教育和培训。在教育和培训领域,世界模型将推动教育方式的革新和提升学习体验。通过将文字描述转换为动态视频内容,教育者和培训机构可以为学生提供更加生动有效的教学内容和教学方式,增强学习者的兴趣和吸收能力。这将有助于提高教育质量和培训效果,实现个性化、交互性和深度学习的目标。

值得注意的是,上述影响是否具有颠覆性变革能力或能否给现实行业带来降维打击,取决于诸多因素,包括技术本身的成熟度、应用场景的限制、人类的创造力和想象力等。尽管现有的世界模型可以生成极其逼真的视频,但仍无法完全取代人类的创造力和想象力。因此,我们应以开放和理性的态度看待这项技术的发展,在抓住发展机遇的同时,平衡其中隐藏的风险和利益。

| [1] |

FORRESTER J W. Counterintuitive behavior of social systems[J]. Theory and decision, 1971, 2(2): 109-140. DOI:10.1007/BF00148991 (  0) 0) |

| [2] |

CHANG L, TSAO D Y. The code for facial identity in the primate brain[J]. Cell, 2017, 169(6): 1013-1028. DOI:10.1016/j.cell.2017.05.011 (  0) 0) |

| [3] |

NORTMANN N, REKAUZKE S, ONAT S, et al. Primary visual cortex represents the difference between past and present[J]. Cerebral cortex, 2015, 25(6): 1427-1440. DOI:10.1093/cercor/bht318 (  0) 0) |

| [4] |

KELLER G B, BONHOEFFER T, HÜBENER M. Sensorimotor mismatch signals in primary visual cortex of the behaving mouse[J]. Neuron, 2012, 74(5): 809-815. DOI:10.1016/j.neuron.2012.03.040 (  0) 0) |

| [5] |

MOBBS D, HAGAN C C, DALGLEISH T, et al. The ecology of human fear: survival optimization and the nervous system[J]. Frontiers in neuroscience, 2015, 9: 1-22. (  0) 0) |

| [6] |

HA D, SCHMIDHUBER J. Recurrent world models facilitate policy evolution[EB/OL]. (2018-09-04)[2024-03-27]. http://arxiv.org/abs/1809.01999v1.

(  0) 0) |

| [7] |

SCHMIDHUBER J. On learning to think: algorithmic information theory for novel combinations of reinforcement learning controllers and recurrent neural world models[EB/OL]. (2015-11-30)[2024-03-27]. http://arxiv.org/abs/1511.09249v1.

(  0) 0) |

| [8] |

LINNAINMAA S. The representation of the cumulative rounding error of an algorithm as a Taylor expansion of the local rounding errors[D]. Helsinki: University of Helsinki, 1970.

(  0) 0) |

| [9] |

KELLEY H J. Gradient theory of optimal flight paths[J]. ARS journal, 1960, 30(10): 947-954. DOI:10.2514/8.5282 (  0) 0) |

| [10] |

WERBOS P J. Applications of advances in nonlinear sensitivity analysis[M]//System Modeling and Optimization. Berlin: Springer Press, 2005: 762-770.

(  0) 0) |

| [11] |

LIPTON Z C, BERKOWITZ J, ELKAN C, et al. A critical review of recurrent neural networks for sequence learning[EB/OL]. (2015-10-17)[2024-03-28]. http://arxiv.org/abs/1506.00019v4.

(  0) 0) |

| [12] |

HA D, SCHMIDHUBER J. World models[EB/OL]. (2018-03-27)[2024-03-28]. https://arxiv.org/abs/1803.10122.

(  0) 0) |

| [13] |

VEN G M, SIEGELMANN H T, TOLIAS A S. Brain-inspired replay for continual learning with artificial neural networks[J]. Nature communications, 2020, 11(1): 4069. DOI:10.1038/s41467-020-17866-2 (  0) 0) |

| [14] |

LECUN Y. A path towards autonomous machine intelligence version 0.9.2[EB/OL]. (2022-06-27)[2024-03-27]. https://openreview.net/pdf?id=BZ5a1r-kVsf.

(  0) 0) |

| [15] |

CATANI M. The anatomy of the human frontal lobe[J]. Handbook of clinical neurology, 2019, 163: 95-122. (  0) 0) |

| [16] |

MUNDINANO I C, CHEN J, SOUZA M, et al. More than blindsight: case report of a child with extraordinary visual capacity following perinatal bilateral occipital lobe injury[J]. Neuropsychologia, 2019, 128: 178-186. DOI:10.1016/j.neuropsychologia.2017.11.017 (  0) 0) |

| [17] |

PATEL A, BISO G M N R, FOWLER J B. Neuroanatomy, temporal lobe[M]. Treasure Island: StatPearls Publishing, 2023.

(  0) 0) |

| [18] |

ANDERSEN R A. The neurobiological basis of spatial cognition: role of the parietal lobe[M]//Spatial Cognition. New York: Psychology Press, 2022: 57-80.

(  0) 0) |

| [19] |

SUTTON R S. Dyna, an integrated architecture for learning, planning, and reacting[J]. ACM SIGART bulletin, 1991, 2(4): 160-163. (  0) 0) |

| [20] |

HAFNER D, LILLICRAP T, FISCHER I, et al. Learning latent dynamics for planning from pixels[EB/OL]. (2018-11-12)[2024-03-28]. http://arxiv.org/pdf/1811.04551v1.

(  0) 0) |

| [21] |

KE N R, GOYAL A, BILANIUK O, et al. Sparse attentive backtracking: temporal credit assignment through reminding[EB/OL]. (2018-09-11)[2024-03-28]. http://arxiv.org/abs/1809.03702.

(  0) 0) |

| [22] |

HAFNER D, PASUKONIS J, BA J, et al. Mastering diverse domains through world models[EB/OL]. (2023-01-10)[2024-03-28]. http://arxiv.org/abs/2301.04104v2.

(  0) 0) |

| [23] |

CHEN C, WU Y F, YOON J, et al. TransDreamer: reinforcement learning with transformer world models[EB/OL]. (2022-02-19)[2024-03-29]. http://arxiv.org/abs/2202.09481v1.

(  0) 0) |

| [24] |

RADFORD A, NARASIMHAN K, SALIMANS T, et al. Improving language understanding by generative pre- training[EB/OL]. (2018-06-11)[2024-03-29]. https://www.cs.ubc.ca/~amuham01/LING530/papers/radford2018improving.pdf.

(  0) 0) |

| [25] |

TSCHANTZ A, MILLIDGE B, SETH A K, et al. Reinforcement learning through active inference[EB/OL]. (2020-02-28)[2024-04-01]. http://arxiv.org/abs/2002.12636v1.

(  0) 0) |

| [26] |

HAFNER D, LILLICRAP T, NOROUZI M, et al. Mastering atari with discrete world models[EB/OL]. (2022- 02-12)[2024-04-01]. http://arxiv.org/abs/2010.02193v4.

(  0) 0) |

| [27] |

KAISER L, BABAEIZADEH M, MILOS P, et al. Model-based reinforcement learning for atari[EB/OL]. (2019-03-01)[2024-04-01]. http://arxiv.org/abs/1903.00374v5.

(  0) 0) |

| [28] |

MICHELI V, ALONSO E, FLEURET F. Transformers are sample-efficient world models[EB/OL]. (2022-09-01)[2024-04-03]. http://arxiv.org/abs/2209.00588v2.

(  0) 0) |

| [29] |

KINGMA D P, WELLING M. Auto-encoding variational Bayes[EB/OL]. (2013-12-20)[2024-04-03]. http://arxiv.org/abs/1312.6114v11.

(  0) 0) |

| [30] |

LECUN Y, BOSER B, DENKER J S, et al. Backpropagation applied to handwritten zip code recognition[J]. Neural computation, 1989, 1(4): 541-551. DOI:10.1162/neco.1989.1.4.541 (  0) 0) |

| [31] |

BENGIO Y, LÉONARD N, COURVILLE A. Estimating or propagating gradients through stochastic neurons for conditional computation[EB/OL]. (2013-08-15)[2024-04-04]. http://arxiv.org/abs/1308.3432v1.

(  0) 0) |

| [32] |

ROBINE J, HÖFTMANN M, UELWER T, et al. Transformer-based world models are happy with 100k interactions[EB/OL]. (2023-03-13)[2024-04-04]. http://arxiv.org/abs/2303.07109v1.

(  0) 0) |

| [33] |

SEO Y, HAFNER D, LIU H, et al. Masked world models for visual control[EB/OL]. (2023-05-27)[2024-04-04]. http://arxiv.org/abs/2206.14244.

(  0) 0) |

| [34] |

ASKELL A, BAI Y T, CHEN A N, et al. A general language assistant as a laboratory for alignment[EB/OL]. (2021-12-09)[2024-04-04]. http://arxiv.org/abs/2112.00861v3.

(  0) 0) |

| [35] |

BAI Y T, JONES A, NDOUSSE K, et al. Training a helpful and harmless assistant with reinforcement learning from human feedback[EB/OL]. (2022-04-12)[2024-04-04]. http://arxiv.org/abs/2204.05862v1.

(  0) 0) |

| [36] |

BROOKS T, PEEBLES B, HOMES C, et al. Video generation models as world simulators, 2024[EB/OL]. (2024-02-15)[2024-04-05]. https://openai.com/research/video-generation-models-as-world-simulators.

(  0) 0) |

| [37] |

Google Gemini Team. Gemini: a family of highly capable multimodal models[R/OL]. (2023-12-19)[2024-04-05]. https://arxiv.org/abs/2312.11805.

(  0) 0) |

| [38] |

MENDONCA R, BAHL S, PATHAK D. Structured world models from human videos[EB/OL]. (2023-08-21)[2024-04-05]. http://arxiv.org/abs/2308.10901v1.

(  0) 0) |

| [39] |

BOGDOLL D, YANG Y T, ZÖLLNER J M. MUVO: a multimodal generative world model for autonomous driving with geometric representations[EB/OL]. (2023-11-20)[2024-04-10]. http://arxiv.org/abs/2311.11762v2.

(  0) 0) |

| [40] |

ZHANG A, NGUYEN K, TUYLS J, et al. Language-guided world models: a model-based approach to AI control[EB/OL]. (2024-01-24)[2024-04-10]. http://arxiv.org/abs/2402.01695v1.

(  0) 0) |

2024, Vol. 56

2024, Vol. 56