2. 中国矿业大学(北京) 机电与信息工程学院 北京 100083

2. School of Mechanical and Electrical Engineering, China University of Mining and Technology (Beijing), Beijing 100083, China

图像的分辨率指的是一幅图像每英寸所包含的像素点的个数,即图像存储的信息量。图像的分辨率越高,图像所呈现出的细节就越丰富。而在现实场景中,由于设备、空间环境等各种因素的影响,呈现出来的图像往往是低分辨率(low-resolution, LR)图像,而不是高分辨率(high-resolution, HR)图像。为解决图像分辨率过低的问题,研究如何从LR图像重建出带有丰富细节信息的HR图像的超分辨率(super-resolution, SR)技术长期以来是计算机视觉领域热门的研究方向。

传统的超分辨率重建算法主要是通过对LR图像进行基本的图像处理操作重建为HR图像。虽然传统的SR算法实现简单,计算量小,但图像重建后存在模糊锯齿等问题。与传统的基于插值[1]、基于重构[2]和基于学习[3]的SR算法相比,基于深度学习的SR算法能较好恢复图像的高频细节信息。随着SR技术的不断发展,超分辨率在实际场景的应用中也越来越成熟。例如在图像压缩、医学、遥感成像、视频感知等领域都展现了较高的应用价值。

本文主要以基于深度学习的方法为核心,将近五年来图像的超分辨率算法分为基于卷积神经网络、基于生成对抗网络(generative adversarial networks, GAN)、基于Transformer的SR算法。首先对各类算法的网络结构、算法优缺点、算法特点及适用场景进行详细评述。其次介绍图像超分辨率算法的常用数据集及各种评价指标,比较SR算法在不同数据集上的性能。最后,提出目前图像超分辨率存在的问题并对超分辨率的未来进行展望。

1 基于CNN的SR算法在Dong等[4]提出SRCNN之前,图像的超分辨率重建算法将重点放在对图像块编码和高分辨率字典的优化上。而SRCNN直接学习网络中低分辨率到高分辨率之间的端到端映射,在训练过程中可以对网络上的所有参数进行优化。SRCNN的核心是三层卷积神经网络,分别代表图像块的提取、非线性映射和图像的重建操作。同时SRCNN是基于深度学习的算法,可以采用ImageNet数据集进行训练,重建的HR图像比传统SR算法的细节更加清晰。

SRCNN的提出证明了深度学习是可以应用在图像超分辨率上的,并且重建HR图像的速度相对较快、质量高。尽管如此,作为最早在SR上运用CNN的算法,SRCNN仍然有着计算复杂度高、重建图像细节丢失等问题。因此研究者们提出了一系列改进算法。

1.1 基于SRCNN的改进算法1) ESPCN为使SRCNN在较高分辨率图像上进行卷积操作,降低SR算法的效率,Sin等[5]提出了ESPCN (efficient sub-pixel convolutional neural)网络,它可以在LR图像上直接卷积计算HR图像,大大提升算法的效率。ESPCN提出了在模型的末端采用亚像素卷积的方式来进行上采样,不仅降低了计算的复杂度,还能以可学习的滤波器代替SRCNN中的单一固定的插值滤波器,更好地从LR图像中学习,提取的特征更加丰富,并且ESPCN在视频超分辨率中可以达到实时性的要求。

2) FSRCNN Dong等[6]提出了以SRCNN为基础的FSRCNN(fast super-resolution convolutional neural networks)算法,提高了SRCNN在处理大图像上的速度。与SRCNN先进行双三次插值再输入网络不同,FSRCNN使用参数可学习的卷积层代替了插值,大大减少了参数量。FSRCNN整个网络被分为五个部分:特征提取、压缩、映射、扩展和反卷积。其中FSRCNN用压缩、映射和扩展操作代替了SRCNN中的非线性映射,增加了映射阶段的深度,以牺牲实时性为代价,提高了图像重建的精度。最后实验结果表明,FSRCNN重建图像的速度是SRCNN-Ex的40倍。

3) VDSR VDSR[7](very deep super resolution)是一个使用了非常深的卷积网络的单图像超分辨率[8](single image super-resolution, SISR)算法,它首次将残差结构用于图像SR领域。为了能够让网络利用更多的上、下文信息,VDSR加深了网络的深度来获得更大的感受野。同时,VDSR采用残差结构来减少学习成本,高学习率来加速网络的收敛,梯度裁剪来避免梯度爆炸等问题,保证了训练的稳定性。由于SRCNN训练只针对单一尺度,不能进行多尺度放大,VDSR设计了单个网络来解决多尺度的SR问题[9],混合不同倍数的数据集来共同训练模型,实现了不同尺度下的参数共享。

尽管VDSR相比于特定尺度的SR模型,能够学习不同尺度之间的信息来提高性能,但VDSR并没有在LR空间直接进行计算,损失了LR的图像细节,增加了计算的复杂度。

4) EDSR Lim等[10]提出了用于SR的加强深度残差网络EDSR(enhanced deep super-resolution),认为在SR任务中,图像的输入与输出在色彩、亮度和对比度上应保持一致,在分辨率和图像细节等地方才有不同。图像在经过BN层时,图像本身的色彩、对比度的分布被归一化,破坏了原本的信息,且BN层消耗的存储空间大,因此EDSR网络删除了传统残差网络的BN层,使得模型更加轻量,输出的图像质量更好。

EDSR是一个单尺度的SR网络,而为了利用不同尺度之间的相互关系,文献[10]同时提出了基于EDSR结构的多尺度模型MDSR(multi-scale deep super-resolution),减少了训练参数量。

1.2 基于注意力机制的改进算法近年来,注意力机制在自然语言处理领域取得良好的成果。由于输入图像尺寸过大,使神经网络不断加深,导致模型性能下降,计算机视觉领域引入了注意力机制。在深度学习中注意力的核心就是让网络能注意更加重要的地方,使CNN实现自适应注意的一个方式。

通常情况下,注意力机制分为通道注意力(channel attention, CA)、空间注意力(spatial attention, SA)或者二者的结合。Hu等[11]提出的SENet(squeeze-and-excitation network)重点在于获得输入特征层每一个通道的权值,增强有用的特征,忽视相对不重要的特征,通过SENet让网络关注它最需要关注的通道。ECANet也是CA机制的一种实现方式,它通过去除SENet的全连接层,同时在全局平均池化后的特征上采用了1维卷积进行学习的方式,解决了SENet中降维会影响通道注意力机制预测的问题。Woo等[12]提出CBAM(convolutional block attention module),将CA和SA机制进行了整合,它比只关注通道的注意力机制能取得更好的效果。

1) RCAN LR图像中包含了大部分的低频信息,而图像的SR则是为了能够尽量恢复高频信息。然而现有的大多数基于CNN的SR网络,对从LR图像中提取的所有特征在不同通道中采用相同的方式进行处理,在获取低频特征上浪费大量不必要的计算,影响CNN的性能。RCAN[13](residual channel attention networks)如图 1所示,主要由浅层特征提取的单层卷积模块、深层特征提取的RIR模块、上采样模块和重建模块组成。RCAN采用了RIR(residual in residual)构建深度网络,RIR结构通过使用长跳跃连接,使得低频信息通过跳跃连接传输到后面,同时使用短跳跃连接将网络不需要的低频信息过滤。RCAN还加入了CA机制来自适应调整不同通道的权重,使得网络将重点放在获得高频信息上。与VSDR相比,基于RCAN提出的深度残差通道注意力网络,使得RCAN在深层网络上具有更加优越的收敛性。但RCAN的缺点和大部分CNN网络一样,致力于设计更深的卷积网络,对中间层的特征相关性利用较少。

|

图 1 RCAN网络结构 Fig. 1 Structure of RCAN |

2) SAN SAN[14](second-order attention network)是一个深度二阶注意力网络,它由浅特征提取层、深度特征提取层、上采样模块和重建模块组成。其中深度特征提取层是基于非局部增强残差组(non-locally enhanced residual group, NLRG),主要用来获得长距离的空间上、下文信息。SAN还设计了一个二阶通道注意力(second-order channel attention, SOCA)机制来研究特征的二阶统计量,通过全局协方差池化来学习特征之间的相关性,弥补了SENet只考虑一阶统计量的缺点,能够获取更加丰富的高频信息。

3) CSNLN 现有的大多数SISR算法仅研究了相同尺度下的特征相关性,却忽视了大量跨尺度的样本。CSNLN[15](cross-scale non-local network)则考虑了不同尺度之间特征信息的相关性,提出了跨尺度非局部注意力(cross-scale non-local attention, CS-NL)模块。CS-NL模块能够在LR图像中获得更多的跨尺度特征相关性,并在SEM(self-exemplar mining)模块中与尺度内局部、非局部特征信息融合,从而学习大量的外部信息,提高了SISR的性能。

4) Cross-MPI 基于参考的超分辨率(reference-based super resolution, RefSR)旨在通过额外的HR参考图像对LR图像进行超分辨率。由于RefSR有了HR参考,重建的质量相比于SISR更好。目前混合多尺度成像系统因其能获得更高的带宽能力受到广泛关注,然而现有的RefSR算法未考虑跨尺度视图的场景,在类似于8倍及以上大的分辨率差距下难以完成高保真的超分辨率,因此提出了Cross-MPI[16]网络,它主要由基于平面感知注意力的MPI机制,多尺度的上采样模块和SR合成融合模块组成。通过在数据集上实验证明了Cross-MPI网络性能比现有的RefSR算法更好,适用于实际多尺度成像系统的SR。

1.3 视频超分辨率算法视频超分辨率(video super-resolution, VSR)旨在将低质量的视频输入,输出高质量的视频。VSR算法同时考虑空间冗余和时间冗余,利用相邻帧之间的时间信息来实现视频的超分辨率。

常见的视频超分辨率算法有VESPCN[17]、FRVSR[18]、EDVR[19]、RRN[20]等。VESPCN是基于ESPCN改进的VSR算法,结合了运动补偿网络、时序空间网络和亚像素卷积网络实现了实时的视频超分,最终在速度和重建效果上超过了ESPCN。FRVSR则提出了一个视频超分辨率帧循环网络框架,可以使用前一帧生成的HR结果来预测下一帧的输出。EDVR设计了时空注意力模型将视频前、后帧和同一帧内部的信息相融合,RRN则以EDSR为基础,利用了残差学习来提高超分辨率的性能。

而BasicVSR以及基于其改进的BasicVSR++网络将常见的VSR算法进行归纳,总结出对网络性能产生影响的四大组件,并提出新的扩展网络结构来进一步提高VSR性能。

1) BasicVSR 与图像超分辨率不同,对视频的超分辨率算法多样但互不相容,阻碍了后续算法的扩展。因此Chan等[21]将常见的VSR算法分解,认为现有的大部分VSR算法都由传播、对齐、聚合和上采样四个部分组成,最终提出了BasicVSR算法,将其作为未来VSR算法的基线。

BasicVSR采用双向传播充分利用了视频序列中的信息,以及基于光流的方法来估计相邻帧之间的关系进行特征对齐,最后加上常见的聚合和上采样生成HR图像。这四个简单的通用模块使得BasicVSR更加容易扩展。以BasicVSR为基础,文献[21]还提出了IconVSR作为其扩展,用来减少传播中的误差累积,促进信息聚合。

经过测试,BasicVSR性能超过现有的VSR算法,而在IconVSR组件的作用下,能进一步提升性能。尽管BasicVSR能够取得如此优秀的成绩,但是其在传播和对齐上的设计存在缺陷。在传播上,BasicVSR前、后向传播之间没有信息的交互,限制了信息聚合的效率。而在对齐上,由于BasicVSR采用的是基于光流的方法来进行特征对齐,该方法使BasicVSR在处理具有遮挡的复杂区域时,对细节恢复的效果较差。

2) BasicVSR++ 针对BasicVSR网络的缺点,Chan等[22]提出了BasicVSR++,以此来改进并优化传播和对齐组件。BasicVSR++在传播模块采用的是二阶网格传播,与BasicVSR的双向传播不同,二阶网格传播,使得不同帧的信息被重新访问,实现特征重复细化,充分利用了不同位置的时空信息进行聚合。在对齐模块,BasicVSR++设计了光流引导可变形对齐,改善了可变形对齐训练不稳定的缺陷,解决了BasicVSR在遮挡环境下光流对齐效果一般的问题。

2 基于GAN的SR算法GAN网络旨在一个数据集上以无监督的方式训练,最终生成与原数据集中样本相似的新样本。它主要由生成器和判别器组成,生成器所生成的分布需要使其尽可能接近真实数据,而判别器则需要判断生成器生成的样本是不是真实数据,直到判别器无法再判断真实数据和生成数据的真伪。

2.1 基于感知损失1) SRGAN Ledig等[23]首次将GAN网络引入SR任务中,以此提出了SRGAN(super resolution generative adversarial network)网络。尽管传统的MSE损失函数下重建的图像PSNR(peak signal to noise ratio)指标高,但通过人的肉眼并不能感知重建图像具有高分辨率,SRGAN首次使用感知损失在人类感知视觉上进行SR,同时提出了MOS(mean opinion score)图像评价指标来判断重建图像的感知质量。

生成网络SRResNet可以作为一个单独的SR网络,它是由多个ResNet块组成的深度网络,采用感知损失进行训练。而判别网络则是一个删去池化层的VGG网络。生成网络和判别网络共同组成了SRGAN网络。SRGAN的感知损失函数如式(1)所示,由内容损失lxSR和对抗损失lGenSR组成,

| $ l^{\mathrm{SR}}=l_x^{\mathrm{SR}}+10^{-3} l_{G e n}^{\mathrm{SR}}。$ | (1) |

内容损失是选取MSE损失或者VGG损失,对抗损失则是GAN网络中的常见损失函数,旨在让生成网络的结果产生较高的判别值来骗过判别网络。

经过实验研究,SRGAN通过感知损失和MOS评价,证明能够重建人眼感知最舒适的高分辨率图像。

2) ESRGAN ESRGAN(enhanced super-resolution generative adversarial networks)是由Wang等[24]基于SRGAN提出的改进算法。ESRGAN引入了密集型残差块(residual-in-residual dense block, RRDB),移除了BN层来使得网络有更大的容量,更加容易训练。ESRGAN采用了相对平均GAN作为判别器来判断生成器生成的图像相比于另一个是否更加真实,而不是判断该图像是真还是假,因而此生成器能够恢复更加真实的细节。ESRGAN调整了感知损失,使用VGG激活层前的特征值来计算重构损失。ESRGAN生成器的损失函数如式(2)所示,由改进的感知损失Lpercep、内容损失L1和对抗损失LGRa三部分组成,

| $ L_G=L_{\text {percep }}+\lambda L_G^{\mathrm{Ra}}+\eta L_1。$ | (2) |

实验表明,ESRGAN比SRGAN重建的图像纹理更加真实而自然。

3) SROBB 在不同层的特征图上使用感知损失进行计算时,浅层的特征注重对边缘、斑点等低级空间信息的处理,中、高层特征注重纹理等高级的语义信息。

然而,感知损失是作用在整张图像上的,忽略了图像内部的语义信息,因此Rad等[25]设计了SROBB网络,如图 2所示。它在SRGAN感知损失函数的基础上,提出了新的定向感知损失(targeted perceptual loss),如式(3)所示,并引入了OBB标签,

|

图 2 SROBB解码器结构 Fig. 2 Structure of the SROBB decoder |

| $ \left\{\begin{array}{l} T=I^{\mathrm{SR}} \cdot M_{\mathrm{OBB}}^{\text {boundary }}, I^{\mathrm{HR}} \cdot M_{\mathrm{OBB}}^{\text {boundary }}, \\ L_{\mathrm{perc}}=\alpha \cdot G_{\mathrm{e}} T+\beta \cdot G_{\mathrm{b}} T+\gamma \cdot G_{\mathrm{o}}。\end{array}\right. $ | (3) |

OBB分别代表着背景Gb(background)、边界Ge(boundaries)和目标Go (objects)标签,用于估计图像中对象的边缘和对象与背景之间的边缘,来获得更好的空间语义信息图像。

SROBB采用了COCO-stuff数据集进行训练,得出的实验结果显示SROBB的评估指标并不高。经过真实的用户调研后,最终结果证明了定向感知损失在人肉眼感知上能得到不错的重建效果。

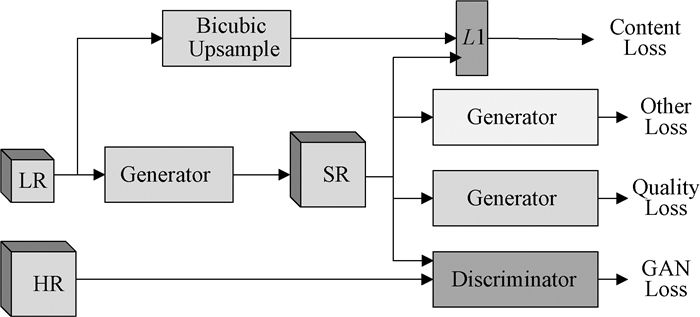

4) RankSRGAN 目前评价图像重建的感知质量很少有像PSNR/SSIM的客观指标,而以人类主观评价方式也并不准确,并且现有的基于人类评价相关的无参考图像质量评价(no-reference image quality assessment, NR-IQA)指标无法用作损失函数来对网络进行优化。因此Zhang等[26]提出了带有Ranker模型的SR网络RankSRGAN(super-resolution generative adversarial networks with ranker)来模拟常见的NR-IQA指标,用感知指标来优化生成器。

RankSRGAN网络主要分为三个部分。第一部分,在数据集上以不同的SR方法生成超分辨率图像,通过选择的感知指标计算内容相同图像的评分并进行排序,得到rank数据集。第二部分训练Ranker模型,Ranker采用了孪生神经网络结构,各网络分支共享权值,使得Ranker学习感知指标的行为。最后一部分引入排序损失函数LR(式(4))、感知损失、对抗损失共同作为RankSRGAN生成器的损失函数,

| $ L_{\mathrm{R}}=\operatorname{sigmoid}\left(R\left(G\left(x_i\right)\right)\right)。$ | (4) |

实验表明,RankSRGAN结合了不同SR方法的优点,可以在视觉上得到更好的效果,但感知质量的提升是牺牲PSNR换来的。

2.2 其他基于GAN的SR算法Shaham等[27]提出的SinGAN是第一个能无条件从单个自然图像训练中学习的图像生成模型,它可以接收一个随机的噪声,生成新的自然图像。SinGAN网络内部使用了多个GAN结构学习不同尺度下分辨率11×11的图像块的分布,从模糊的图像逐步添加细节,从LR到HR,最终生成真实图像。在一张LR图像上训练SinGAN,不断对图像上采样,同时输入最精细的生成器中,就可以完成图像的超分辨率。在实际应用中,SinGAN不仅在超分辨率上能达到不错的效果,在绘画图像转换、图像编辑和图像和谐化上与传统方法相比,也有巨大的优势。而SinGAN的缺点在于当图像块之间的差异较大时,无法学习有效分布,导致图像不真实。

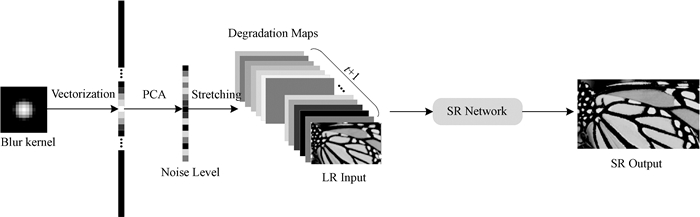

Real-ESRGAN[28]则是对ESRGAN的改进,它的提出是为了解决真实场景下盲图像超分模型对图像进行重建所面临的问题。由于使用经典的退化模型来合成训练数据时,合成的数据与真实退化图像存在较大差异,因此Real-ESRGAN采用高阶退化模型来处理现实场景下的退化问题。由于Real-ESRGAN的退化空间远大于ESRGAN,Real-ESRGAN将ESRGAN中VGG式的判别器改为U-Net结构来精确增强局部细节,同时采用谱归一化(spectral normalization)来弥补U-Net结构导致训练的不稳定。

3 基于Transformer的SR算法Transformer模型完全基于自注意力机制(self-attention),舍弃了传统的RNN[29]串行处理数据的方式,采用并行化来处理,解决了长距离依赖问题。最初,Transformer大多是用在NLP任务中。近年来,越来越多的研究将Transformer应用到目标检测、图像分类、图像生成等计算机视觉领域[30-31],获得了巨大的成功。本文将基于Transformer的SR算法主要分为两大类,一是将注意力机制和CNN网络结合的Transformer,二是仅有注意力机制,不采用传统CNN网络架构的Transformer。

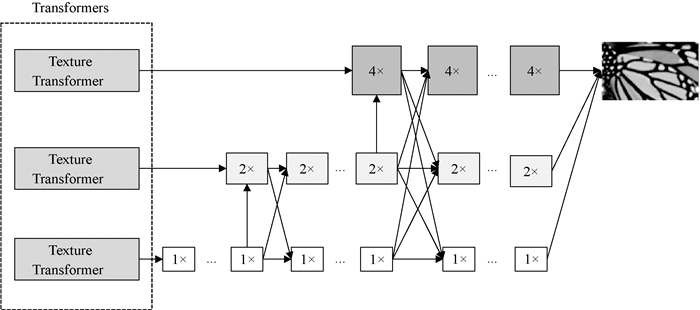

Yang等[32]首次将Transformer应用于图像生成领域,提出了TTSR(texture transformer network for image super-resolution)网络。TTSR是典型的仅由注意力机制组成的Transformer模型,它结合了RefSR技术,采用注意力机制来转移HR纹理特征,缓解SISR重建图片模糊的问题。TTSR的纹理Transformer模块主要由四部分组成:可学习的纹理提取器、相关性嵌入模块、进行纹理转换的硬注意力模块和进行纹理合成软注意力模块。通过这四个模块,可以将HR纹理特征从参考图像转换为LR特征,生成更加精确的纹理。文献[32]还设计了跨尺度特征整合模块结合纹理Transformer进行堆叠,可以交换不同尺度的特征信息。最终,TTSR采用CUFED5数据集进行训练,以YCbCr空间Y通道上的PSNR/SSIM来评价SR重建的结果,与RefSR模型相比,TTSR可以取得优秀的成绩。

ESRT(efficient super-resolution transformer)则是由注意力机制和传统CNN网络结合而成的Transformer,由Lu等[33]提出,来解决Transformer中计算复杂度高、GPU占用高导致网络无法设计过深的问题。如图 3所示,ESRT网络主要由轻型CNN主干网(lightweight CNN backbone, LCB)以及轻型Transformer主干网(lightweight Transformer backbone, LTB)组成。由这两部分组成的ESRT网络增强了图像特征表达能力以及长期依赖性,使得ESRT能以较低的成本提高网络的性能。LCB主要用于提取深层图像特征,它主要由三个高保留块(high preserving blocks, HPB)构成,以此来尽可能减少参数,降低计算成本。而LTB则采用了一种高效的Transformer(efficient Transformer, ET),在高效的多头注意力(efficient multi-head attention, EMHA)机制下,在增强特征表示能力的同时减少了GPU的占用。经实验可知,ESRT的性能比原始Transformer要更加优秀。

|

图 3 ESRT网络结构 Fig. 3 Network structure of ESRT |

Hu等[34]提出的Fusformer是一种针对高光谱图像的超分辨率方法。它通过Transformer中自注意力机制全局探索特征直接的内在关系,解决了传统基于CNN的高光谱超分辨率方法中,只考虑局部信息忽视全局信息的问题。除此之外,Fusformer主要关注LR多光谱与HR多光谱图像之间的空间残差,减少了映射空间,减轻了训练数据的负担。

Liang等[35]提出的SwinIR主要由浅层特征提取、深度特征提取和图像重建三个模块组成。SwinIR中,每个Transformer块利用多个swin Transformer进行局部注意和跨窗口交互,解决了训练视觉Transformer模型中出现的数据饥饿等问题。

4 常用数据集及图像质量评价 4.1 超分辨率常用数据集在深度学习中,数据集是一个非常重要的概念。大部分数据集会被划分为三大类:训练集、验证集和测试集。在训练集中的数据被用在模型的训练过程中对模型参数进行调整,进一步优化模型。验证集中的数据则是对模型精度进行验证,对模型的超参数进行调整。最后通过测试集的数据来对模型进行评估。

DIV2K[36]是目前SR领域最常用于训练的数据集,它主要包含了1 000张分辨率为2 K的图片,其中800张用于训练数据,100张用于验证,100张用于测试。而Urban100[37]、Set5[38]、Set14[39]、Manga109[40]、BSD100[41]等都是SR里经典的测试集。在应用中,根据重建图像所属的领域不同,数据集也需要根据实际问题来进行选取。

4.2 图像质量评价图像质量评价是从图像的颜色、形状、纹理、深度和亮度等方面来衡量各类图像处理算法性能的指标,主要可分为主观质量评价和客观质量评价。

4.2.1 主观质量评价主观质量评价即观测者通过人的视觉感知对测试图像进行主观评分,它能够直观反映图像的综合质量,然而主观评价的结果受观测者个体本身、观测环境等因素的影响,有较大的局限性。平均主观得分(mean opinion score, MOS)和平均主观得分差异(differential mean opinion score, DMOS)是常用的两个主观评价方法。MOS的值越大,图像的质量越高。DMOS则是指观测者的人眼对失真图像和无失真图像评分的差异,因此DMOS的值越小,图像的质量越高。

4.2.2 客观质量评价客观质量评价法即通过设计数学模型感知待测图像的质量来评价图像处理算法的优劣。客观评价法主要分为三大类:把相同内容的自然图像与失真图像进行比较的全参考方法[42](full-reference, FR)、只采用参考图像的部分信息的半参考方法[43](reduced-reference, RR)和无参考图像仅采用失真图像的无参考方法[44](no-reference, NR)。

均方误差(mean square error, MSE)是待测图像和参考图像之间像素值的均方差。通常情况,MSE的值越小,图像质量越好。与MSE相同,峰值信噪比[45](peak signal to noise ratio, PSNR)也是通过待测图像与参考图像之间像素的误差来评价图像的质量。PSNR表示的是待测图像与参考图像之间失真的程度,PSNR越大,失真越小,图像质量越好。结构相似性[46](structural similarity, SSIM)从亮度、对比度和结构三方面来比较待测图像和原始图像之间的相似性,采用均值来衡量亮度,方差来衡量对比度以及协方差来衡量结构的相似程度。SSIM值为0~1,数值越大表示图像越相似。

在图像超分辨率领域,目前主流的图像质量评价方法是PSNR/SSIM。随着基于感知损失的SR方法的出现,研究者们意识到并不是评价指标越高,人主观感知到的图像越清晰。以SROBB为例,尽管PSNR评价指标与其他SR网络相比并不高,但在真实的用户调研中,它却能更吸引用户。同理,在相同的数据集下,RankSRGAN的PSNR指标不如ESRGAN,但它可以显著提高重建图像的感知质量。

随着技术的进步,图像质量评价指标逐渐采取了主、客观相结合的评价方法,图像处理算法不仅需要追求越来越高的PSNR/SSIM等客观的评价指标,还需考虑人肉眼能够感知到的高质量图像。另一方面,在3D视觉的发展下,对3D图像进行质量评估也将是未来研究的方向。

5 总结和展望本文主要研究了基于深度学习的图像超分辨率算法,将近几年主流的SR算法分成了传统的基于CNN的SR算法、基于GAN网络的SR算法和基于Transformer的SR算法这三大类。对这三类算法的经典网络进行了详细的阐述、分析并对各算法的性能进行了对比。尽管在图像超分辨率领域已取得巨大的进展,但仍然存在着潜在问题。本文总结了几点超分辨率领域未来可能发展的方向。

1) 基于无监督的超分辨率方法

目前绝大多数的超分辨率方法都是属于有监督,有监督的SR则需要大量成对的LR-HR图像作为数据集进行训练。而有监督方法无法很好复现现实生活中的情况,限制了超分辨率的性能。而且目前盲图像SR在针对未知退化模型的问题上仍存在需要改进的地方,因此对无监督的超分辨率的探索,将会是未来研究的热门之一。

2) 轻量化的超分辨率模型

近年来,越来越多的超分辨率模型从开始的增加深度向现在更加轻量化转变。一方面,直接增加模型的深度,庞大的网络结构对计算量和存储资源的要求较高;另一方面,随着移动设备的普及,将算法模型部署在移动端也将成为未来的趋势。

3) 特定领域下的超分辨率研究

不同的应用场景,其退化方式也不相同,例如恶劣的天气条件、摄像机的运动和光学退化等等。针对不同的应用场景,尤其是在特殊领域下,如医学研究、煤矿开采、卫星遥感等,需要超分辨率模型尽可能适配该专业领域,尽可能满足该领域的实际需求,这也是当前比较热门的研究方向。

4) 合理的图像质量评估方法

常用的图像质量评价指标包括PSNR、SSIM、MSE、MSSIM等等。目前大多数评价指标仅是客观反映图像的重建质量,但在视觉上无法达到符合视觉感知的标准。因此,改进并完善现有的图像质量评价指标对SR未来的发展也极其重要。

| [1] |

JING G M, CHOI Y K, WANG J Y, et al. Gradient guided image interpolation[C]//IEEE International Conference on Image Processing. Piscataway: IEEE Press, 2015: 1822-1826.

(  0) 0) |

| [2] |

NASONOV A V, KRYLOV A S. Fast super-resolution using weighted median filtering[C]//The 20th International Conference on Pattern Recognition. Piscataway: IEEE Press, 2010: 2230-2233.

(  0) 0) |

| [3] |

TIMOFTE R, DE SMET V, VAN GOOL L. A+: adjusted anchored neighborhood regression for fast super-resolution[C]//Asian Conference on Computer Vision. Cham: Springer International Publishing, 2015: 111-126.

(  0) 0) |

| [4] |

DONG C, LOY C C, HE K M, et al. Image super-resolution using deep convolutional networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2016, 38(2): 295-307. DOI:10.1109/TPAMI.2015.2439281 (  0) 0) |

| [5] |

SHI W Z, CABALLERO J, HUSZÁR F, et al. Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2016: 1874-1883.

(  0) 0) |

| [6] |

DONG C, LOY C C, TANG X O. Accelerating the super-resolution convolutional neural network[C]//European Conference on Computer Vision. Cham: Springer International Publishing, 2016: 391-407.

(  0) 0) |

| [7] |

KIM J, LEE J K, LEE K M. Accurate image super-resolution using very deep convolutional networks[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2016: 1646-1654.

(  0) 0) |

| [8] |

LI Z, YANG J L, LIU Z, et al. Feedback network for image super-resolution[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 3862-3871.

(  0) 0) |

| [9] |

NAH S, KIM T H, LEE K M. Deep multi-scale convolutional neural network for dynamic scene deblurring[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2017: 257-265.

(  0) 0) |

| [10] |

LIM B, SON S, KIM H, et al. Enhanced deep residual networks for single image super-resolution[C]//IEEE Conference on Computer Vision and Pattern Recognition Workshops. Piscataway: IEEE Press, 2017: 1132-1140.

(  0) 0) |

| [11] |

HU J, SHEN L, SUN G. Squeeze-and-excitation networks[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2018: 7132-7141.

(  0) 0) |

| [12] |

WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module[C]//Proceedings of the European Conference on Computer Vision. Cham: Springer International Publishing, 2018: 3-19.

(  0) 0) |

| [13] |

ZHANG Y L, LI K P, LI K, et al. Image super-resolution using very deep residual channel attention networks[C]//Proceedings of the European Conference on Computer Vision. Cham: Springer International Publishing, 2018: 294-310.

(  0) 0) |

| [14] |

DAI T, CAI J R, ZHANG Y B, et al. Second-order attention network for single image super-resolution[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 11057-11066.

(  0) 0) |

| [15] |

MEI Y Q, FAN Y C, ZHOU Y Q, et al. Image super-resolution with cross-scale non-local attention and exhaustive self-exemplars mining[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 5689-5698.

(  0) 0) |

| [16] |

ZHOU Y M, WU G C, FU Y, et al. Cross-MPI: cross-scale stereo for image super-resolution using multiplane images[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2021: 14837-14846.

(  0) 0) |

| [17] |

CABALLERO J, LEDIG C, AITKEN A, et al. Real-time video super-resolution with spatio-temporal networks and motion compensation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2017: 2848-2857.

(  0) 0) |

| [18] |

SAJJADI M S M, VEMULAPALLI R, BROWN M. Frame-recurrent video super-resolution[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2018: 6626-6634.

(  0) 0) |

| [19] |

WANG X T, CHAN K C K, YU K, et al. EDVR: video restoration with enhanced deformable convolutional networks[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Piscataway: IEEE Press, 2020: 1954-1963.

(  0) 0) |

| [20] |

ISOBE T, ZHU F, WANG S J. Revisiting temporal modeling for video super-resolution[EB/OL]. (2020-08-13)[2022-03-25]. https://arxiv.org/abs/2008.05765.

(  0) 0) |

| [21] |

CHAN K C K, WANG X T, YU K, et al. BasicVSR: the search for essential components in video super-resolution and beyond[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2021: 4945-4954.

(  0) 0) |

| [22] |

CHAN K C K, ZHOU S C, XU X Y, et al. BasicVSR: improving video super-resolution with enhanced propagation and alignment[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2022: 5962-5971.

(  0) 0) |

| [23] |

LEDIG C, THEIS L, HUSZÁR F, et al. Photo-realistic single image super-resolution using a generative adversarial network[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2017: 105-114.

(  0) 0) |

| [24] |

WANG X T, YU K, WU S X, et al. ESRGAN: enhanced super-resolution generative adversarial networks[M]//Lecture Notes in Computer Science. Cham: Springer International Publishing, 2019: 63-79.

(  0) 0) |

| [25] |

RAD M S, BOZORGTABAR B, MARTI U V, et al. SROBB: targeted perceptual loss for single image super-resolution[C]//IEEE/CVF International Conference on Computer Vision. Piscataway: IEEE Press, 2020: 2710-2719.

(  0) 0) |

| [26] |

ZHANG W L, LIU Y H, DONG C, et al. RankSRGAN: generative adversarial networks with ranker for image super-resolution[C]//IEEE/CVF International Conference on Computer Vision. Piscataway: IEEE Press, 2020: 3096-3105.

(  0) 0) |

| [27] |

SHAHAM T R, DEKEL T, MICHAELI T. SinGAN: learning a generative model from a single natural image[C]//IEEE/CVF International Conference on Computer Vision. Piscataway: IEEE Press, 2020: 4569-4579.

(  0) 0) |

| [28] |

WANG X T, XIE L B, DONG C, et al. Real-ESRGAN: training real-world blind super-resolution with pure synthetic data[C]//IEEE/CVF International Conference on Computer Vision Workshops. Piscataway: IEEE Press, 2021: 1905-1914.

(  0) 0) |

| [29] |

ZAREMBA W, SUTSKEVER I, VINYALS O. Recurrent neural network regularization[EB/OL]. (2014-09-08)[2022-03-25]. https://arxiv.org/abs/1409.2329.

(  0) 0) |

| [30] |

CARON M, TOUVRON H, MISRA I, et al. Emerging properties in self-supervised vision transformers[C]//IEEE/CVF International Conference on Computer Vision. Piscataway: IEEE Press, 2022: 9630-9640.

(  0) 0) |

| [31] |

TOUVRON H, CORD M, SABLAYROLLES A, et al. Going deeper with image transformers[C]//IEEE/CVF International Conference on Computer Vision. Piscataway: IEEE Press, 2022: 32-42.

(  0) 0) |

| [32] |

YANG F Z, YANG H, FU J L, et al. Learning texture transformer network for image super-resolution[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 5790-5799.

(  0) 0) |

| [33] |

LU Z S, LI J C, LIU H, et al. Transformer for single image super-resolution[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Piscataway: IEEE Press, 2022: 456-465.

(  0) 0) |

| [34] |

HU J F, HUANG T Z, DENG L J, et al. Fusformer: a transformer-based fusion network for hyperspectral image super-resolution[J]. IEEE geoscience and remote sensing letters, 2022, 19: 1-5. (  0) 0) |

| [35] |

LIANG J Y, CAO J Z, SUN G L, et al. SwinIR: image restoration using swin transformer[C]//IEEE/CVF International Conference on Computer Vision Workshops. Piscataway: IEEE Press, 2021: 1833-1844.

(  0) 0) |

| [36] |

TIMOFTE R, GU S H, WU J Q, et al. NTIRE 2018 challenge on single image super-resolution: methods and results[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Piscataway: IEEE Press, 2018: 965-96511.

(  0) 0) |

| [37] |

HUANG J B, SINGH A, AHUJA N. Single image super-resolution from transformed self-exemplars[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2015: 5197-5206.

(  0) 0) |

| [38] |

BEVILACQUA M, ROUMY A, GUILLEMOT C, et al. Low-complexity single-image super-resolution based on nonnegative neighbor embedding[C]//Proceedings of the British Machine Vision Conference. Surrey: British Machine Vision Association, 2012: 1-10.

(  0) 0) |

| [39] |

ZEYDE R, ELAD M, PROTTER M. On single image scale-up using sparse-representations[M]//Curves and Surfaces. Berlin: Springer Press, 2012: 711-730.

(  0) 0) |

| [40] |

AIZAWA K, FUJIMOTO A, OTSUBO A, et al. Building a manga dataset "manga109" with annotations for multimedia applications[J]. IEEE multimedia, 2020, 27(2): 8-18. DOI:10.1109/MMUL.2020.2987895 (  0) 0) |

| [41] |

MARTIN D, FOWLKES C, TAL D, et al. A database of human segmented natural images and its application to evaluating segmentation algorithms and measuring ecological statistics[C]//Proceedings of the Eighth IEEE International Conference on Computer Vision. Piscataway: IEEE Press, 2002: 416-423.

(  0) 0) |

| [42] |

WANG Z H, CHEN J A, HOI S C H. Deep learning for image super-resolution: a survey[J]. IEEE transactions on pattern analysis and machine intelligence, 2021, 43(10): 3365-3387. DOI:10.1109/TPAMI.2020.2982166 (  0) 0) |

| [43] |

SOUNDARARAJAN R, BOVIK A C. RRED indices: reduced reference entropic differencing for image quality assessment[J]. IEEE transactions on image processing, 2012, 21(2): 517-526. DOI:10.1109/TIP.2011.2166082 (  0) 0) |

| [44] |

KIM J, NGUYEN A D, LEE S. Deep CNN-based blind image quality predictor[J]. IEEE transactions on neural networks and learning systems, 2019, 30(1): 11-24. DOI:10.1109/TNNLS.2018.2829819 (  0) 0) |

| [45] |

SHEIKH H R, SABIR M F, BOVIK A C. A statistical evaluation of recent full reference image quality assessment algorithms[J]. IEEE transactions on image processing, 2006, 15(11): 3440-3451. DOI:10.1109/TIP.2006.881959 (  0) 0) |

| [46] |

WANG Z, BOVIK A C, SHEIKH H R, et al. Image quality assessment: from error visibility to structural similarity[J]. IEEE transactions on image processing, 2004, 13(4): 600-612. DOI:10.1109/TIP.2003.819861 (  0) 0) |

2024, Vol. 56

2024, Vol. 56