传感器在工业生产领域应用广泛,但不同类型的传感器有各自的优势与弊端。因此,研究基于多种传感器的数据融合已经成为一个新的研究方向。利用具有互补特性的传感器数据进行融合和分析,可以增强感知能力,完成更为精准的决策和评估。在自动驾驶中,如何为自动驾驶系统提供准确、可靠的环境感知,是实现自动驾驶和确保其安全性的首要前提[1]。目前,在自动驾驶中普通摄像头、双目相机和激光雷达[2]等均可用于车辆环境的感知。其中,普通摄像头可以提供高清影像信息,但由于摄像头缺少车辆周边环境准确的三维信息,在复杂场景中不能很好地感知周围环境;双目相机可以提供车辆周围目标物体的三维信息,但其成本较高;激光雷达可以通过激光扫描获取车辆周围目标物体的三维信息,且不存在遮挡问题,但由于行程的点云数据较为稀疏,其分辨率、刷新率以及语义信息均不如图像。基于上述情况,一些研究将摄像头和激光雷达两种传感器组合使用,融合图像与点云数据,表现出了显著的性能优势。

近年来,深度学习的发展提高了图像与点云融合算法的性能。在数据结构方面,图像是规则、有序和离散的,而点云是不规则、无序和连续的。图像的特征提取一般利用卷积神经网络,该网络具有层次结构,可以不断增加抽象级别和接受域的图像特征,从而能够学习高级语义。而点云以三维结构和每点特征对信息进行编码,使得点云上的特征提取更具挑战性。点云直接学习的开创性工作之一是PointNet系列,通过采用独立的T-Net模块对齐点云和共享MLP来处理单个点,以进行每点特征提取。但是,PointNet[3]无法在不同级别提取局部点间几何。为了解决这个问题,Qi等[4]提出PointNet++,通过将点分组为多个集合并在本地应用PointNet,以从不同级别提取特征。

通过将图像与点云不同的数据类型进行特征提取,得到可以进行融合的数据类型,进而结合两者的优点提升融合模型性能。Gansbeke等[5]将结果级融合和特征级融合相结合,用于图像的深度补全网络中;Tang等[6]将编码器不同阶段的图像特征与稀疏特征融合,以此完成稀疏深度的上采样。此外,良好的数据集对于提升模型性能也非常重要。目前使用较多的有KITTI[7]、Waymo[8]、nuScenes[9]等与自动驾驶相关的数据集,还有一些数据集在室内场景下采集,比如ScanNet[10]也可以用来训练图像与点云融合的模型。本文首先对图像与点云融合的传统方法进行介绍,之后总结了图像与点云融合方法的相关研究,包括目标检测、多目标跟踪和语义分割等与感知相关的主题;依据不同的融合方式对各种方法进行了梳理和分类,并对各个模型的特点及性能进行了评述;最后结合自动驾驶领域中图像与点云融合方法的应用现状和存在的问题给出了研究建议。

1 图像与点云融合的传统方法多模态融合的传统方法一般包括代数法、卡尔曼滤波、贝叶斯理论以及证据理论,其中卡尔曼滤波是使用最多的方法。2011年,Aycard等[11]提出一种利用双目相机与激光雷达融合的算法,融合过程的输入有两个对象列表:立体视觉处理检测到的动态对象列表以及分类信息;点云经过检测后以质心点表示的动态对象列表。这两个列表之间的目标检测级融合可以相互补充,从而提供关于环境中对象状态更完整的信息。除了可以通过弱化目标形状进行融合,传统方法与深度学习的方法都是先将不同模态的目标进行检测,再将结果进行融合。2014年,Xu等[12]提出一种基于图像与点云数据融合增强的目标检测方法,在二维图像中获得候选目标区域的初始估计,同时以无监督的方式从相应的输入点云中提取包含潜在对象的三维点,只保留与预定义目标模型匹配的点。该方法对单个数据模态的检测是并行进行的,并且使用不同的融合方案进行组合。由于自动驾驶对模型的检测速度与精度要求较高,在提高检测精度的同时也要注重计算效率的最优化。2016年,Wang等[13]提出一种协同融合的方法来实现车辆检测精度和计算效率之间的最优平衡,在其所提出的车辆跟踪方法中,目标区域被描述为一个边界框,分别采用局部敏感直方图方法和均匀运动模型进行外观表示和运动表示,通过选择候选直方图的最佳匹配位置进行模型更新。

传统方法已经可以实现图像与点云的融合,并可以利用融合来进行目标检测、目标跟踪等任务,但是这些方法在融合中未能充分利用多模态信息,并且在目标检测等任务中精确度与速度不高。

2 基于图像与点云融合的目标检测目前,三维目标检测[14]方法可以分为两阶段目标检测和一阶段目标检测[15]。两阶段目标检测模型包括提取候选框阶段和三维包围盒回归阶段, 因此两阶段目标检测模型的性能受到多个阶段的限制。一阶段目标检测模型只由一个阶段组成,其中二维和三维数据以并行方式处理。对于图像与点云融合的三维目标检测而言,可以将模型按照结果级融合、特征级融合和多级融合的方式进行分类。

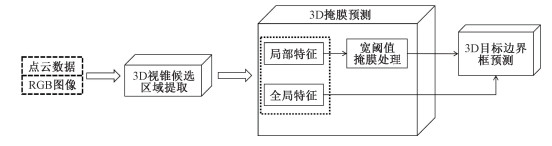

2.1 结果级融合结果级融合本质上是使用目前已经成熟的二维检测模型的结果来缩小三维目标检测的搜索空间,即减少点云多余的背景点,这种方法可以有效减少计算量并提高运行效率。但整个模型过于依赖二维目标检测模型的结果,因此受到二维图像目标检测模型性能的限制。结果级融合的典型模型架构如图 1所示。

|

图 1 结果级融合模型架构 Fig. 1 The framework of result-level fusion model |

2018年,Qi等[16]提出F-PointNet模型,利用二维目标检测器检测出二维边界框,从图像生成并投影到三维空间,将产生的视锥候选区域输入基于PointNet[3]的三维点云处理网络中进行目标检测。Wang等[17]提出的F-ConvNet模型与F-PointNet模型相似,也是利用图像投影缩小目标范围,但该方法生成了视锥体序列,避免了大范围遍历点云。Du等[18]将候选框生成阶段从二维扩展到三维,增加了候选框细化阶段,减少了对背景点不必要的计算。Shin等[19]提出的RoarNet使用了类似的想法,但在候选框细化阶段使用了二维卷积神经网络,利用几何一致性搜索[20],在每个二维包围框上生成多个三维柱体提案,以便生成相较于F-PointNet模型更小但更精确的视锥候选区域,然后利用PointNet++[4]网络处理初始的柱体候选区域,对模型进行最终的改进。这些方法均假设每个候选区域只包含一个感兴趣的对象,因此对于目标车辆较多的复杂场景无法精确定位目标物体。针对上述问题,可以利用二维语义分割代替二维目标检测器,用逐点提议代替逐区域提议。Yang等[21]提出基于密集型点的目标检测模型IPOD,通过将点投影到图像平面以及使用二维语义关联的点来实现对背景点的过滤,生成的前景点保留了上下文信息和细粒度的位置信息,在之后的逐点提案生成和包围框回归阶段,使用两个基于PointNet++ 的网络进行特征提取和包围框预测,在遮挡较多或者目标物体较多的场景中,这种方法具有显著的性能优势。

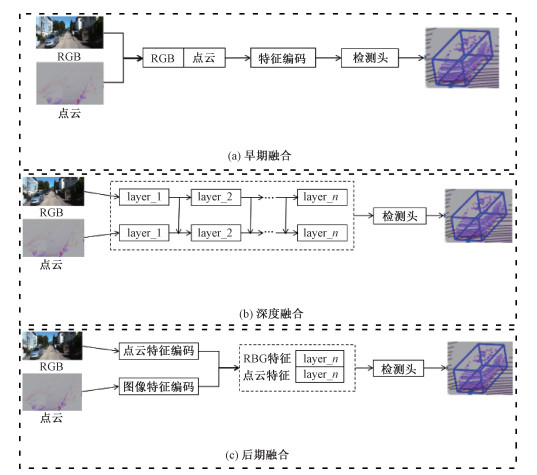

2.2 特征级融合与结果级融合类似,一些多模态融合是在图像层面上进行的,其中三维几何体被转换为图像格式或作为图像的附加通道,即将三维几何体投影到图像平面上,并利用成熟的图像处理方法进行特征提取,结果输出也在图像上,但这些方法在三维空间中定位目标的结果并不理想。2014年,Gupta等[22]提出一种基于RCNN[23]的二维对象检测、实例和语义分割架构,在图像的RGB通道中对相机的三维几何体进行编码。2015年,Gupta等[24]又提出可扩展深度的RCNN模型,通过对齐三维CAD模型进行三维目标检测,从而显著提升了性能。随着深度学习的不断发展,根据特征级融合的网络分层以及融合时机,可以将特征级融合分为早期融合、深度融合和后期融合,其模型架构如图 2所示。

|

图 2 特征级融合模型架构 Fig. 2 The framework of feature-level fusion model |

传统的数据级融合是一种在每个数据层融合数据的方法,在原始数据级别进行空间对齐和投影,而早期融合是将激光雷达的原始数据与相机的原始数据相融合。尽管不同模态的数据具有不同的内在特征,但是大部分数据都是通过某种规则的方法处理生成的,因此早期融合比传统的数据级融合效果更好。PointPainting模型[25]和PI-RCNN模型[26]将图像分支和原始激光雷达点云中的语义特征融合在一起,从而在目标检测任务中获得更好的性能。Simon等[27]和Dou等[28]提出的方法还利用了语义特征,对原始激光雷达点云进行预处理,生成了体素化张量,使其可以进一步利用效果更好的特征提取网络。Wen等[29]将原始RGB像素与体素化张量融合,而Wang等[30]将图像分支生成的伪点云和激光雷达分支生成的原始点云直接组合在一起,以完成目标检测任务。

2.2.2 深度融合深度融合方法一般用于点云特征与图像特征的数据融合中。该方法使用特征提取器分别获取点云和相机图像的特征向量表示,并通过一系列模块将特征融合到两种模型中[31-32]。Xu等[33]提出带有全局融合的点云特征和来自图像的全局特征,为了克服目标尺寸差异的影响,把点云每个点的特征和图像特征拼接起来进行处理。Sindagi等[34]提出了体素融合等方法,将ROI特征向量附加到点云中每个体素的特征向量上,但是体素融合不能融合所有点的特征。Song等[35]通过滑动三维检测窗口来实现三维目标检测,将图像的颜色信息通过投影附加到体素上,并且利用三维离散卷积神经网络[36]进一步拓展了这一想法。Huang等[31]提出一种深度激光雷达图像融合的方法,通过估计相应图像特征的权重以减少噪声影响,但是该模型在极端天气中性能一般。Bijelic等[37]提出一种极端天气下的多模态数据集,并对图像和点云进行深度融合,提高了模型的鲁棒性。

2.2.3 后期融合后期融合是融合每个模态中通道输出结果的方法。一些后期融合方法利用点云通道和图像通道输出结果,并基于两种模式的结果进行最终预测。在这种融合方式中,两种模态候选区的数据格式应与最终结果相同,但在精度上可以有所不同。Pang等[38]利用图像中的二维候选区和点云中的三维候选区对每个三维候选区域的权重进行二次细化。此外,对于每个重叠区域,利用了置信度、距离和IoU等统计特征对其权重进行再分配。2018年,Asvadi等[39]提出一种专注于二维目标检测的模型,结合了来自两个分支的建议以及置信度评分等功能,但是基于二维目标检测的模型存在遮挡问题,造成目标物体检测准确度不高。2019年,Gu等[40]提出了将分割结果组合在一起解决道路检测问题的方法,与Melotti等[41]提出的后期融合一样,将三维检测方案不同分支的权重汇总为一个最终权重,进行候选框的选取。MV3D[42]开创性地提出从鸟瞰图中生成三维提案,该方法在自上而下的激光雷达特征图上生成三维建议,然后将这些候选三维图像投影到激光雷达前视图和图像平面上,提取并融合区域特征,进行包围框回归。

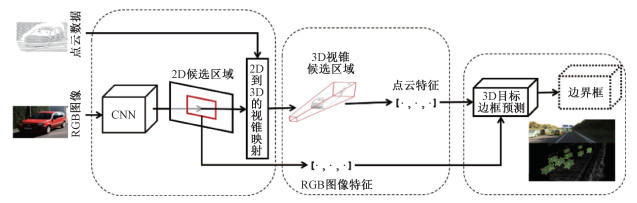

2.3 多级融合多级融合是将结果级融合与特征级融合都加入模型中,更多地保留了图像的语义特征和点云的三维特征。多级融合模型架构如图 3所示。

|

图 3 多级融合模型架构 Fig. 3 The framework of multi-level fusion model |

多级融合中典型的模型是PointFusion[33],该方法利用现有的二维目标检测生成二维包围框,将包围框投影到图像平面来选择相应的点,并定位通过包围框的点,再利用基于ResNet[43]和PointNet[3]的网络与图像结合起来,用于估计三维对象的点云特征,但是它的候选框提取阶段仍然不够成熟。在SIFRNet模型[44]中,首先从图像生成平截头体候选区域,然后将点云特征与其相应的图像特征结合起来,进行最终的三维包围框的回归。在MMF模型[45]中,通过结合多种融合方法进一步扩展逐点融合,例如信号级融合、特征级融合、多视图和深度补全等,缓解了稀疏逐点融合问题,有助于跨模态表示的学习。

目前,对于基于图像与点云融合的目标检测方法,大部分研究人员使用KITTI数据集进行讨论,本文列出部分模型进行对比分析,结果如表 1所示。根据融合方式对模型进行分类,表中给出不同类型模型的主要特点,使用平均精度(average precision,AP)作为准确度的判断标准,并列出不同模型在KITTI数据集中,对简单、中等、困难三种不同难度数据的测试结果。可以看出,对于简单难度的数据,三种融合策略的结果相差不大;而对于困难难度的数据,结果级融合和特征级融合比多级融合的效果更好。

|

|

表 1 基于图像与点云融合的目标检测模型的总结与比较 Tab. 1 Summary and comparison of target detection models based on image and point cloud fusion |

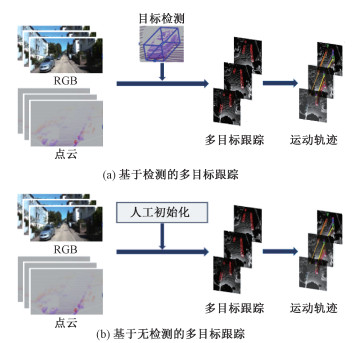

多目标跟踪是给定一段连续帧的图像序列,从这些图像中识别目标物体,并将不同帧中的物体一一对应,最终生成该物体的运动轨迹。目前,多目标跟踪模型可分为基于检测的跟踪(detection-based tracking,DBT)和基于无检测的跟踪(detection-free tracking,DFT)。其模型架构如图 4所示。

|

图 4 基于图像与点云融合的多目标跟踪模型架构 Fig. 4 The framework of multi-target tracking model based on image and point cloud fusion |

DBT是指在目标跟踪之前图像的目标物体都已经被检测出,再通过已检测的物体运动轨迹的假设来跟踪目标。DFT则是利用标注过的第一帧图像中的目标,在之后的过程中逐帧利用多目标多伯努利滤波和概率假设密度滤波等方法,边检测目标边对目标进行状态估计,进而达到跟踪目标的目的。

3.1 基于检测的多目标跟踪基于检测的跟踪模型一般包括两个阶段:在第一阶段逐帧检测目标物体;在第二阶段将这些物体按照图像序列的顺序一一对应,并生成该目标物体的运动轨迹。2018年,Frossard等[46]提出一种端到端的基于检测的多目标跟踪模型,将多目标跟踪的问题简化为线性规划,并且通过神经网络对目标进行检测与匹配。为了实现端到端的学习,检测和匹配模块利用了深度结构模型。Zhang等[47]提出一个通用的传感器不可知的多模态多目标跟踪模型,模型中的每个模态都可以独立地表现其特征,并且可以确保可靠性以及通过多模态融合模块进一步提高检测精度,包括目标检测、邻接估计和线性优化三个阶段。在第一阶段,该模型通过VGG16和PointNet[3]并行提取图像和点云特征,并通过融合模块进行融合;在第二阶段,该模型通过邻接矩阵学习将最小代价流扩展到多模态;在第三阶段,计算出一条最优路径,完成对目标物体的跟踪。

在自动驾驶的应用场景下,多目标跟踪也可以利用图像与点云三维重建目标物体来进行。Luiten等[48]利用三维重建改进目标跟踪模型,由于在图像或视频中目标物体会存在遮挡问题,使得检测算法无法精确识别,而通过三维重建还原物体本身的三维属性,可以很好地解决这个问题。

3.2 基于无检测的多目标跟踪基于无检测的跟踪模型一般通过基于过滤的方法对目标进行手动初始化和跟踪。Simon等[27]提出一种用于图像和点云三维目标跟踪和检测的实时框架,在三维目标检测阶段,利用特征级融合提取二维语义并逐点融合到点云中,将附加过图像语义信息的点云体素化,输入YOLO3D[49]框架中。在多目标跟踪过程中,通过标记多伯努利随机有限集滤波器来实现对目标物体轨迹的判断。

基于图像与点云融合的多目标跟踪模型的对比结果如表 2所示。根据模型的跟踪方式进行分类,表中给出了不同类型模型的主要特点,并使用多目标跟踪准确度(multiple object tracking accuracy,MOTA)、多目标跟踪精度(multiple object tracking precision,MOTP)、匹配成功在追踪目标中的比例(mostly tracked,MT)作为准确度的判断标准。可以看出,基于检测的多目标跟踪模型由于提前在图像上进行目标检测,判断出目标物体的位置,更易于进一步的跟踪。因此,大部分基于检测的多目标跟踪模型的性能优于基于无检测的多目标跟踪模型。

|

|

表 2 基于图像与点云融合的多目标跟踪模型的总结与比较 Tab. 2 Summary and comparison of multi-target tracking models based on image and point cloud fusion |

由于点云数据比较稀疏,难以提供精确的语义信息,在进行三维语义分割时,融合图像的语义信息可以使分割结果更加准确。按照模型的分割方式,可以将模型分为基于多视图的语义分割、基于候选框的语义分割和基于无候选框的语义分割。基于多视图的语义分割是利用不同视图的图像语义分割结果对点云数据进行语义分割[50],基于候选框的语义分割和基于无候选框的语义分割的区别在于输入网络时图像是否已检测出候选框。

4.1 基于多视图的语义分割基于多视图的语义分割模型利用鸟瞰图、前视图等不同视角的RGB图像或经过处理的点云图像对目标物体进行语义分割。2019年,Chiang等[51]提出一种基于点的语义分割模型,该模型通过将二维图像特征反投影到三维坐标中,并在一个统一的框架中学习二维纹理外观和三维结构特征,有效地优化了整个场景的像素级特征、几何结构和全局上下文先验。该模型由两个基于PointNet++[4]的编码器进行处理,以提取局部和全局特征,然后送入解码器进行逐点语义标签预测。Jaritz等[52]提出的基于点云处理网络的多视图三维场景中,运用了类似的想法融合了多视图图像语义和三维几何信息,以预测逐点的语义标签。Valada等[53]采用了不同深度的多级融合,先利用图像语义分割的结果减少点云的无用背景点,再融合图像的特征进行语义分割。Caltagirone等[54]利用由点云数据得到的深度图像和二维图像进行语义分割。Dai等[55]提出一种用于三维语义分割的多视图网络3DMV,融合了体素化点云中的图像语义和点云中点的特征,利用二维卷积神经网络从多幅对齐的图像中提取图像特征,并将其投影回三维空间。这些多视图图像特征在输入三维卷积神经网络进行逐体素语义预测之前,最大限度地混合体素信息,最后与三维几何体融合。此外,3DMV模型在ScanNet[10]基准上还运行了其他基于体素的方法。

4.2 基于候选框的语义分割基于候选框的语义分割首先通过二维目标检测模型提取二维候选框,再对三维场景中的物体进行分割。2019年,Hou等[56]提出了3D-SIS模型,结合三维场景的体素表示和对应的二维图像作为输入,对三维场景进行物体检测与实例分割。该模型利用了高分辨率的RGB输入,通过将二维图像与体积网格关联起来,基于三维重建进行姿态对齐。对于每幅图像,首先用一系列的二维卷积来提取每个像素的二维特征,然后将得到的特征向量反向投影到三维网格的相关体素中。但基于体素的方法,其性能取决于体素分辨率,容易受到体素边界伪影的干扰。

4.3 基于无候选框的语义分割基于无候选框的语义分割是直接在三维数据上进行分割任务,并在语义分割过程中加入图像的二维数据特征。Elich等[57]提出一个用于三维点云上联合语义和实例分割的深度学习框架,遵循无候选框实例分割方法的思想,该模型学习了一个特征嵌入,并将获得的特征空间分组为语义实例。

此外,三维语义分割还可以利用晶格进行数据融合。Su等[58]提出一种稀疏晶格网络,采用稀疏双边卷积来实现空间感知表示学习和多模态融合。在这种方法中,点云特征被插值到一个二维的准正六面体晶格上,在该晶格中利用双边卷积将结果插值回点云数据,使用二维卷积从多视图图像中提取图像特征,并将其投影到三维晶格空间与三维特征结合,最后利用卷积对融合后的特征图进行进一步的处理,预测每个点的标签。

基于图像与点云融合的语义分割模型的对比结果如表 3所示。表中给出不同类型模型的主要特点,并使用均交并比(mean intersection over union,mIoU)作为准确度的判断标准。可以看出,基于多视图的语义分割可以提供较多的图像信息,其效果优于基于候选框和无候选框的语义分割。基于候选框的语义分割可用在目标检测之后,但其提供的信息不足,因此可以用于单视图情况下的语义分割。

|

|

表 3 基于图像与点云融合的语义分割模型的总结与比较 Tab. 3 Summary and comparison of semantic segmentation models based on image and point cloud fusion |

随着自动驾驶感知任务的多模态融合方法取得了快速的发展,摄像头和激光雷达组合被用于提高感知系统的性能和可靠性,使自动驾驶车辆能够更好地理解复杂场景。因此,图像与点云融合的方法也有了从特征表示到深度学习模型的快速发展。但是目前融合方法的发展仍面临以下挑战:①图像与点云的数据表达形式不同,这两种数据需要在一个新的坐标系统下重新组织才能有效融合,但是由于噪声的存在,这种逐像素的对齐还不够准确。②自动驾驶汽车搭载的摄像头与激光雷达都会受到极端天气的干扰,在实际应用中这种情况是不可避免的。因此,如何在极端天气中提升模型的鲁棒性是亟待解决的问题。③大多数方法都集中在前视图的多模态数据上,其他有意义的信息没有被充分利用,如语义、空间和场景上下文信息等。④现有的大多数方法无法达到实时性,在自动驾驶领域需要在保证高精度的前提下提升模型速度。

针对上述挑战,首先,对于图像与点云逐像素对齐的问题,可以将图像和点云特征转换为中间数据表示,例如体素化点云进行解决。其次,对于极端天气而言,可以加入去雾、去雨等模型,对原始数据进行处理后再将图像与点云融合。再次,目前自动驾驶车辆中已经实现车辆四周均搭载摄像头,且激光雷达可以360°扫描环境,因此未来可以通过融合车道、交通灯和标志等其他目标的图像与点云信息,构建一个完整语义理解框架。最后,通过减少送入模型的多余信息来提升运行速度,以达到自动驾驶实时性的要求。

| [1] |

叶阳阳. 面向道路交通的环境感知关键技术研究[D]. 北京: 北京交通大学, 2020. YE Y Y. Study on key technology of environmental perception oriented to road traffic[D]. Beijing: Beijing Jiaotong University, 2020. (  0) 0) |

| [2] |

冯冬青, 崔盈慧, 张西雅. 基于雷达散射截面的汽车前方障碍物分类识别[J]. 郑州大学学报(理学版), 2011, 43(1): 114-117. FENG D Q, CUI Y H, ZHANG X Y. Vehicle obstacle classification recognition based on RCS[J]. Journal of Zhengzhou university (natural science edition), 2011, 43(1): 114-117. (  0) 0) |

| [3] |

CHARLES R Q, HAO S, MO K C, et al. PointNet: deep learning on point sets for 3D classification and segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2017: 77-85.

(  0) 0) |

| [4] |

QI C R, YI L, SU H, et al. PointNet++: deep hierarchical feature learning on point sets in a metric space[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. Berlin: Springer Press, 2017: 5105-5114.

(  0) 0) |

| [5] |

GANSBEKE W, NEVEN D, BRABANDERE B, et al. Sparse and noisy LiDAR completion with RGB guidance and uncertainty[C]//Proceedings of the 16th International Conference on Machine Vision Applications. Piscataway: IEEE Press, 2019: 1-6.

(  0) 0) |

| [6] |

TANG J, TIAN F P, FENG W, et al. Learning guided convolutional network for depth completion[J]. IEEE transactions on image processing, 2021, 30: 1116-1129. DOI:10.1109/TIP.2020.3040528 (  0) 0) |

| [7] |

GEIGER A, LENZ P, URTASUN R. Are we ready for autonomous driving? The KITTI vision benchmark suite[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2012: 3354-3361.

(  0) 0) |

| [8] |

SUN P, KRETZSCHMAR H, DOTIWALLA X, et al. Scalability in perception for autonomous driving: Waymo open dataset[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 2443-2451.

(  0) 0) |

| [9] |

CAESAR H, BANKITI V, LANG A H, et al. nuScenes: a multimodal dataset for autonomous driving[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 11618-11628.

(  0) 0) |

| [10] |

DAI A, CHANG A X, SAVVA M, et al. ScanNet: richly-annotated 3D reconstructions of indoor scenes[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2017: 2432-2443.

(  0) 0) |

| [11] |

AYCARD O, BAIG Q, BOTA S, et al. Intersection safety using lidar and stereo vision sensors[C]//Proceedings of the IEEE Intelligent Vehicles Symposium. Piscataway: IEEE Press, 2011: 863-869.

(  0) 0) |

| [12] |

XU J J, KIM K, ZHANG Z Q, et al. 2D/3D sensor exploitation and fusion for enhanced object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2014: 778-784.

(  0) 0) |

| [13] |

WANG X, XU L H, SUN H B, et al. On-road vehicle detection and tracking using MMW radar and monovision fusion[J]. IEEE transactions on intelligent transportation systems, 2016, 17(7): 2075-2084. DOI:10.1109/TITS.2016.2533542 (  0) 0) |

| [14] |

卜瑞. 基于图像和点云融合的无人驾驶场景下的目标检测与定位系统[D]. 济南: 山东大学, 2019. BU R. Object detection and localization system based on image and point cloud fusion in unmanned scenario[D]. Jinan: Shandong University, 2019. (  0) 0) |

| [15] |

卢佩, 刘效勇, 邵建新. 基于视觉显著性及多特征分析的目标检测[J]. 信阳师范学院学报(自然科学版), 2015, 28(4): 587-591. LU P, LIU X Y, SHAO J X. Target detection based on visual saliency and multi-feature analysis[J]. Journal of Xinyang normal university (natural science edition), 2015, 28(4): 587-591. DOI:10.3969/j.issn.1003-0972.2015.04.030 (  0) 0) |

| [16] |

QI C R, LIU W, WU C X, et al. Frustum PointNets for 3D object detection from RGB-D data[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2018: 918-927.

(  0) 0) |

| [17] |

WANG Z X, JIA K. Frustum ConvNet: sliding frustums to aggregate local point-wise features for amodal 3D object detection[C]//Proceedings of the IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway: IEEE Press, 2019: 1742-1749.

(  0) 0) |

| [18] |

DU X X, ANG M H, KARAMAN S, et al. A general pipeline for 3D detection of vehicles[C]//Proceedings of the IEEE International Conference on Robotics and Automation. Piscataway: IEEE Press, 2018: 3194-3200.

(  0) 0) |

| [19] |

SHIN K, KWON Y P, TOMIZUKA M. RoarNet: a robust 3D object detection based on RegiOn approximation refinement[C]//Proceedings of the IEEE Intelligent Vehicles Symposium. Piscataway: IEEE Press, 2019: 2510-2515.

(  0) 0) |

| [20] |

MOUSAVIAN A, ANGUELOV D, FLYNN J, et al. 3D bounding box estimation using deep learning and geometry[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2017: 5632-5640.

(  0) 0) |

| [21] |

YANG Z, SUN Y, LIU S, et al. IPOD: intensive point-based object detector for point cloud[EB/OL]. [2022-02-12]. https://doi.org/10.48550/arXiv.1812.05276.

(  0) 0) |

| [22] |

GUPTA S, GIRSHICK R, ARBELÁEZ P, et al. Learning rich features from RGB-D images for object detection and segmentation[C]//Proceedings of the European Conference on Computer Vision. Cham: Springer International Publishing, 2014: 345-360.

(  0) 0) |

| [23] |

GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2014: 580-587.

(  0) 0) |

| [24] |

GUPTA S, ARBELÁEZ P, GIRSHICK R, et al. Aligning 3D models to RGB-D images of cluttered scenes[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2015: 4731-4740.

(  0) 0) |

| [25] |

VORA S, LANG A H, HELOU B, et al. PointPainting: sequential fusion for 3D object detection[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 4603-4611.

(  0) 0) |

| [26] |

XIE L, XIANG C, YU Z X, et al. PI-RCNN: an efficient multi-sensor 3D object detector with point-based attentive cont-conv fusion module[C]//Proceedings of the AAAI Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2020: 12460-12467.

(  0) 0) |

| [27] |

SIMON M, AMENDE K, KRAUS A, et al. Complexer-YOLO: real-time 3D object detection and tracking on semantic point clouds[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2019: 1190-1199.

(  0) 0) |

| [28] |

DOU J, XUE J R, FANG J W. SEG-VoxelNet for 3D vehicle detection from RGB and LiDAR data[C]//Proceedings of the International Conference on Robotics and Automation. Piscataway: IEEE Press, 2019: 4362-4368.

(  0) 0) |

| [29] |

WEN L H, JO K H. Fast and accurate 3D object detection for lidar-camera-based autonomous vehicles using one shared voxel-based backbone[J]. IEEE access, 2021, 9: 22080-22089. DOI:10.1109/ACCESS.2021.3055491 (  0) 0) |

| [30] |

WANG J R, ZHU M, WANG B, et al. KDA3D: key-point densification and multi-attention guidance for 3D object detection[J]. Remote sensing, 2020, 12(11): 1895. DOI:10.3390/rs12111895 (  0) 0) |

| [31] |

HUANG T T, LIU Z, CHEN X W, et al. EPNet: enhancing point features with image semantics for 3D object detection[C]//Proceedings of the European Conference on Computer Vision. Cham: Springer International Publishing, 2020: 35-52.

(  0) 0) |

| [32] |

YOO J H, KIM Y, KIM J, et al. 3D-CVF: generating joint camera and LiDAR features using cross-view spatial feature fusion for 3D object detection[C]//Proceedings of the European Conference on Computer Vision. Cham: Springer International Publishing, 2020: 720-736.

(  0) 0) |

| [33] |

XU D F, ANGUELOV D, JAIN A. PointFusion: deep sensor fusion for 3D bounding box estimation[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2018: 244-253.

(  0) 0) |

| [34] |

SINDAGI V A, ZHOU Y, TUZEL O. MVX-Net: multimodal VoxelNet for 3D object detection[C]//Proceedings of the International Conference on Robotics and Automation. Piscataway: IEEE Press, 2019: 7276-7282.

(  0) 0) |

| [35] |

SONG S R, XIAO J X. Sliding shapes for 3D object detection in depth images[C]//Proceedings of the European Conference on Computer Vision. Cham: Springer International Publishing, 2014: 634-651.

(  0) 0) |

| [36] |

SONG S R, XIAO J X. Deep sliding shapes for amodal 3D object detection in RGB-D images[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2016: 808-816.

(  0) 0) |

| [37] |

BIJELIC M, GRUBER T, MANNAN F, et al. Seeing through fog without seeing fog: deep multimodal sensor fusion in unseen adverse weather[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 11679-11689.

(  0) 0) |

| [38] |

PANG S, MORRIS D, RADHA H. CLOCs: camera-LiDAR object candidates fusion for 3D object detection[C]//Proceedings of the IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway: IEEE Press, 2021: 10386-10393.

(  0) 0) |

| [39] |

ASVADI A, GARROTE L, PREMEBIDA C, et al. Multimodal vehicle detection: fusing 3D-LIDAR and color camera data[J]. Pattern recognition letters, 2018, 115: 20-29. DOI:10.1016/j.patrec.2017.09.038 (  0) 0) |

| [40] |

GU S, ZHANG Y G, TANG J H, et al. Integrating dense LiDAR-camera Road detection maps by a multi-modal CRF model[J]. IEEE transactions on vehicular technology, 2019, 68(12): 11635-11645. DOI:10.1109/TVT.2019.2946100 (  0) 0) |

| [41] |

MELOTTI G, PREMEBIDA C, GONCALVES N M M, et al. Multimodal CNN pedestrian classification: a study on combining LIDAR and camera data[C]//Proceedings of the 21st International Conference on Intelligent Transportation Systems. Piscataway: IEEE Press, 2018: 3138-3143.

(  0) 0) |

| [42] |

CHEN X Z, MA H M, WAN J, et al. Multi-view 3D object detection network for autonomous driving[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2017: 6526-6534.

(  0) 0) |

| [43] |

HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2016: 770-778.

(  0) 0) |

| [44] |

ZHAO X, LIU Z, HU R L, et al. 3D object detection using scale invariant and feature reweighting networks[C]// Proceedings of the AAAI Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2019, 33: 9267-9274.

(  0) 0) |

| [45] |

LIANG M, YANG B, CHEN Y, et al. Multi-task multi-sensor fusion for 3D object detection[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2019: 7337-7345.

(  0) 0) |

| [46] |

FROSSARD D, URTASUN R. End-to-end learning of multi-sensor 3D tracking by detection[C]//Proceedings of the IEEE International Conference on Robotics and Automation. Piscataway: IEEE Press, 2018: 635-642.

(  0) 0) |

| [47] |

ZHANG W W, ZHOU H, SUN S Y, et al. Robust multi-modality multi-object tracking[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2019: 2365-2374.

(  0) 0) |

| [48] |

LUITEN J, FISCHER T, LEIBE B. Track to reconstruct and reconstruct to track[J]. IEEE robotics and automation letters, 2020, 5(2): 1803-1810. DOI:10.1109/LRA.2020.2969183 (  0) 0) |

| [49] |

ALI W, ABDELKARIM S, ZIDAN M, et al. YOLO3D: end-to-end real-time 3D oriented object bounding box detection from LiDAR point cloud[C]//Proceedings of the European Conference on Computer Vision. Cham: Springer International Publishing, 2018: 716-728.

(  0) 0) |

| [50] |

张佳颖, 赵晓丽, 陈正. 基于深度学习的点云语义分割综述[J]. 激光与光电子学进展, 2020, 57(4): 28-46. ZHANG J Y, ZHAO X L, CHEN Z. Review of semantic segmentation of point cloud based on deep learning[J]. Laser & optoelectronics progress, 2020, 57(4): 28-46. (  0) 0) |

| [51] |

CHIANG H Y, LIN Y L, LIU Y C, et al. A unified point-based framework for 3D segmentation[C]//Proceedings of the International Conference on 3D Vision. Piscataway: IEEE Press, 2019: 155-163.

(  0) 0) |

| [52] |

JARITZ M, GU J Y, SU H. Multi-view PointNet for 3D scene understanding[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2019: 3995-4003.

(  0) 0) |

| [53] |

VALADA A, MOHAN R, BURGARD W. Self-supervised model adaptation for multimodal semantic segmentation[J]. International journal of computer vision, 2020, 128(5): 1239-1285. DOI:10.1007/s11263-019-01188-y (  0) 0) |

| [54] |

CALTAGIRONE L, BELLONE M, SVENSSON L, et al. LIDAR-camera fusion for road detection using fully convolutional neural networks[J]. Robotics and autonomous systems, 2019, 111: 125-131. DOI:10.1016/j.robot.2018.11.002 (  0) 0) |

| [55] |

DAI A, NIESSNER M. 3DMV: joint 3D-multi-view prediction for 3D semantic scene segmentation[C]//Proceedings of the European Conference on Computer Vision. Cham: Springer International Publishing, 2018: 452-468.

(  0) 0) |

| [56] |

HOU J, DAI A, NIESSNER M. 3D-SIS: 3D semantic instance segmentation of RGB-D scans[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2019: 4416-4425.

(  0) 0) |

| [57] |

ELICH C, ENGELMANN F, KONTOGIANNI T, et al. 3D-BEVIS: bird's-eye-view instance segmentation[C]//Proceedings of German Conference on Pattern Recognition. Cham: Springer International Publishing, 2019: 48-61.

(  0) 0) |

| [58] |

SU H, JAMPANI V, SUN D Q, et al. SPLATNet: sparse lattice networks for point cloud processing[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2018: 2530-2539.

(  0) 0) |

| [59] |

NARITA G, SENO T, ISHIKAWA T, et al. Panoptic-Fusion: online volumetric semantic mapping at the level of stuff and things[C]//Proceedings of the IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway: IEEE Press, 2019: 4205-4212.

(  0) 0) |

2022, Vol. 54

2022, Vol. 54