普通相机拍摄图像时,无法兼顾相机视场与视场中单个物体的分辨率问题,而全景相机普遍价格昂贵,不适用于低成本的一般性场景.为了使用普通相机获取宽视角,甚至是360°全景图像,人们提出了图像拼接技术.图像拼接技术是指将含有重叠部分的两幅或多幅图像,通过图像预处理、图像配准和图像融合技术,拼接成一幅包含各图像信息的高分辨率、宽视角图像的技术.该技术广泛地应用在医学成像[1]、遥感技术[2]、虚拟现实[3]、视频编辑[4]等方面,随着计算机视觉等技术的发展,其重要性日益凸显.此外,图像拼接技术还用于视频压缩[5],将视频逐帧拼接为高分辨率图像,去除重复部分,降低存储空间,提高传输速度,采用相位相关法搜索给定目标,实现图像索引[6].

图像拼接技术最先应用在遥感技术领域,其核心是图像配准,产生了两个分支,一个分支是基于区域的图像配准.早期主要采用全局搜索法进行图像配准,计算量极大.模板匹配法[7]相对于全局搜索法操作简单,容易实现,但都只能解决平移问题.Reddy于1996年提出扩展相位相关法[8],将相位相关法[9-10]和对数极坐标变换相结合,解决旋转和尺度缩放问题,但该方法计算较为复杂.另一个分支是基于特征的图像配准,包括角点、边缘、斑点等.1988年,Harris提出了经典的Harris角点检测算法[11],将图像中具有旋转、平移不变性的角点作为特征点进行图像配准.Lowe于1999年[12]提出,并在2004年[13]完善尺度不变特征变换(scale-invariant feature transform,SIFT)算法,该算法对平移、旋转、尺度缩放和光照不均都有很好的适应性,是目前的研究热点.

1 图像拼接流程图像拼接包括3部分:图像预处理、图像配准和图像融合.

图像预处理的目的是提高配准精度、降低配准难度,包括调整灰度差异、去噪、几何修正以及将两幅图像投影到同一坐标系等基本操作.

图像配准是计算出两幅图像间的空间变换模型并进行空间变换,使两幅图像的重叠部分在空间上对准,是图像拼接的关键.图像之间的空间变换关系包括:平移、旋转、尺度缩放、仿射变换、投影变换,其中投影变换更具有普遍性.

假设图像f1(x, y)、f2(x, y)存在投影变换关系,则用齐次方程(1)表示:

| $ \left[ {\begin{array}{*{20}{l}} {{x_2}}\\ {{y_2}}\\ 1 \end{array}} \right] = \left[ {\begin{array}{*{20}{l}} {{m_0}}&{{m_1}}&{{m_2}}\\ {{m_3}}&{{m_4}}&{{m_5}}\\ {{m_6}}&{{m_7}}&1 \end{array}} \right]\left[ {\begin{array}{*{20}{c}} {{x_1}}\\ {{y_1}}\\ 1 \end{array}} \right] = \mathit{\boldsymbol{M}}\left[ {\begin{array}{*{20}{c}} {{x_1}}\\ {{y_1}}\\ 1 \end{array}} \right], $ | (1) |

其中:m0、m1、m3和m4共同表示旋转角度和缩放尺度;m2和m5分别表示x方向与y方向上的平移量;m6和m7分别表示x方向和y方向上的变形量.图像配准的关键是用式(1)确定空间变换模型M的参数.

图像融合的目的是得到无缝的高质量图像.在不损失原始图像信息的前提下,消除接缝与亮度差异,实现拼接边界的平滑过渡.

2 图像配准技术 2.1 基于区域的图像配准基于区域的图像配准分为基于空间域的图像配准和基于变换域的图像配准.

2.1.1 基于空间域的图像配准基于空间域的图像配准法有全局搜索法和模板匹配法[7].直接利用图像像素的灰度信息,采用某种搜索方法,如以单个像素为单位平移的方法,确定当两图像重叠部分之间的相似性测度达到最大时的变换模型,常见的相似性测度有平均绝对差(mean absolute deviation,MAD)、误差平方和(sum of squared difference,SSD)、归一化互相关(normalized cross correlation,NCC)等.

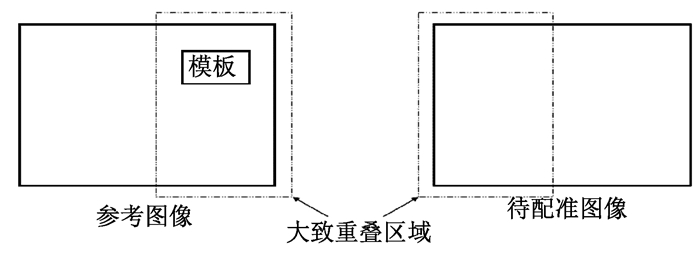

全局搜索法是使待配准图像在参考图像上平移,比较平移过程中两幅图像的配准程度,在进行所有平移之后选择相似性测度最优的平移量,这种方法的缺点是计算量极大.模板匹配法以两幅图像的重叠部分为基准,选取待配准图像的一块矩形区域为模板,在参考图像中搜索相似区域,相似性测度最优的位置即为最佳配准位置,如图 1所示.

|

图 1 模板匹配法 Fig. 1 Template matching method |

模板匹配法操作简单、匹配精度高,在图像拼接[14-15]、目标识别[16-17]等方面得到广泛应用.但全局搜索法和模板匹配法都要求图像不能包含较大噪声,不能有旋转、尺度缩放等问题,计算量仍然较大,并且要求参考图像中有完整的模板匹配目标.

2.1.2 基于变换域的图像配准1) 相位相关法

根据傅立叶变换的平移不变性,相位相关法[9-10]将空间域上像素的平移转换为频率域上相位的平移.

设f1(x, y)和f2(x, y)是具有平移关系的两幅图像,其空间变换关系为

| $ {f_2}(x,y) = {f_1}\left( {x - {x_0},y - {y_0}} \right), $ | (2) |

其中:(x0, y0)为两幅图像间的平移量.则图像f1与f2对应的傅立叶变换F1和F2之间关系为

| $ {F_2}(\mu ,\nu ) = {{\rm{e}}^{ - {\rm{j}}\left( {\mu {x_0} - \nu {y_0}} \right)}}{F_1}(\mu ,\nu ). $ | (3) |

由式(3)得出,图像f1(x, y)和f2(x, y)在频率域中幅值相同,相位不同.两幅图像间的互功率谱定义为

| $ \frac{{F_1^*(\mu ,\nu ){F_2}(\mu ,\nu )}}{{\left| {F_1^*(\mu ,\nu ){F_2}(\mu ,\nu )} \right|}} = {{\rm{e}}^{ - {\rm{j}}\left( {\mu {x_0} - \nu {y_0}} \right)}}, $ | (4) |

其中:*是复共轭运算符.

对式(4)右侧进行傅里叶逆变换得冲击响应函数δ(x-x0, y-y0),搜索使冲击响应函数δ最大的点(x0, y0),则(x0, y0)即为图像f1(x, y)和f2(x, y)之间的最佳平移量.

快速傅里叶变换(fast fourier transform,FFT) [18]提升了基于变换域的相位相关法的算法性能,效率高、计算简单,相对于基于空间域的图像配准,该方法对光照变化不敏感、抗噪能力强、稳定性好.该方法只对有平移关系的两幅图像有良好的效果,不适用于有旋转和尺度缩放关系的图像.二维快速傅里叶变换的时间复杂度可以用O(M·N·log(M·N))表示,其中M、N为图像尺寸,所以其时间复杂度随图像尺寸增大呈指数增长.

2) 扩展相位相关法

Castro等[19]解决了相位相关法不适用于平移和旋转的问题.Reddy[8]又在相位相关法的基础上提出了将相位相关法和对数极坐标变换相结合的扩展相位相关法,通过对数极坐标变换将两幅图像间的旋转和尺度缩放关系转换为该坐标系下的平移关系.

设图像f1(x, y)和f2(x, y)间存在平移、旋转和尺度缩放关系,则其空间变换关系为

| $ {f_2}(x,y) = {f_1}\left[ {s\left( {x\cos {\theta _0} + y\sin {\theta _0}} \right) - {x_0},s\left( { - x\sin {\theta _0} + y\cos {\theta _0}} \right) - {y_0}} \right], $ | (5) |

其中:θ0为旋转角度;s为尺度因子;(x0, y0)为平移量.

则图像f1与f2对应的傅立叶变换F1和F2之间关系如式(6),

| $ {F_2}(u,v) = {{\rm{e}}^{ - {\rm{j}}2 \pi\left( {u{x_0} + v{y_0}} \right)}}{s^{ - 2}}{F_1}\left[ {{s^{ - 1}}\left( {u\cos {\theta _0} + v\sin {\theta _0}} \right),{s^{ - 1}}\left( { - u\sin {\theta _0} + v\cos {\theta _0}} \right)} \right]. $ | (6) |

取F1、F2的幅度谱M1、M2,则M1与M2关系如式(7),

| $ {M_2}(u,v) = {s^{ - 2}}{M_1}\left[ {{s^{ - 1}}\left( {u\cos {\theta _0} + v\sin {\theta _0}} \right),{s^{ - 1}}\left( { - u\sin {\theta _0} + v\cos {\theta _0}} \right)} \right]. $ | (7) |

忽略比例因子s-2的影响,对M1与M2进行极坐标变换得

| $ {M_2}(r,\theta ) = {s^{ - 2}}{M_1}\left( {{s^{ - 1}}r,\theta - {\theta _0}} \right). $ | (8) |

沿极坐标半径r方向取对数可得

| $ {M_2}(\log r,\theta ) = {s^{ - 2}}{M_1}\left( {\log r - \log s,\theta - {\theta _0}} \right). $ | (9) |

设ξ=log r,d=log s可得

| $ {M_2}(\xi ,\theta ) = {s^{ - 2}}{M_1}\left( {\xi - d,\theta - {\theta _0}} \right). $ | (10) |

对式(10)用相位相关法可以计算出旋转角度θ0和尺度因子s,对待配准图像进行旋转和尺度缩放后,两幅图像间只剩平移关系,再次使用相位相关法可以确定两幅图像之间的平移量(x0, y0).

扩展相位相关法具有相位相关法的效率高、对光照变化不敏感、抗噪能力强、稳定性好等优点,同时又解决了旋转和尺度缩放问题,较相位相关法适用范围更广.该方法还可以与边缘检测相结合[20-22],进一步提高鲁棒性和计算效率.但是算法复杂,并且要求两幅图像之间有较高的重合度.

2.2 基于特征的图像配准与基于区域的图像配准相比,基于特征的图像配准只使用图像的部分信息,如轮廓、角点等特征,主要有角点检测法、基于轮廓特征的图像配准、基于SIFT的图像配准等.

2.2.1 角点检测法角点是指灰度图像中局部灰度梯度变化较大的点,或轮廓线上局部范围内的曲率极大值点.角点检测法基本思想是提取特征点,匹配两幅图像中的特征点作为特征点对,再通过随机抽样一致性(random sample consensus, RANSAC)算法[23],根据式(1)使用特征点对估计空间变换模型的参数.

1) 角点提取常用Harris角点检测法[11]、加速分割测试特征(features from accelerated segment test, FAST)算法[24-25]、最小核值相似区(smallest univalue segment assimilating nucleus, SUSAN)算法[26-27]等提取图像中的角点.

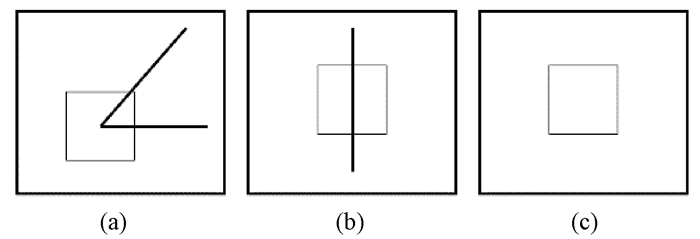

a) Harris角点检测法基本思想是计算某像素邻域内各像素的x和y方向上的梯度Ix、Iy,用角点响应函数(corner response function, CRF)表示梯度Ix、Iy的特征,如果某像素邻域内Ix、Iy的幅值都较大,CRF取局部区域极大值,则为特征点,如图 2(a)所示;如果只有一个方向的梯度幅值较大,另一方向的梯度几乎为0,则为边缘点,不是特征点,如图 2(b)所示;如果Ix、Iy的幅值几乎都为0,则位于平坦区域,不是特征点,如图 2(c)所示.

|

图 2 不同类型的点 Fig. 2 Types of different points |

Harris算法使用图像的梯度特征检测角点, 具有光照不变性, 还可以解决平移、旋转问题,但是像素邻域的窗函数对尺度变换敏感,不具备尺度不变性;Harris需要人工指定阈值,适应性较差,但可以与自适应阈值算法相结合[28]提高算法效率.

b) FAST算法基本思想是如果某像素的灰度值与足够多的邻域像素灰度值的差值较大时,认为该点为特征点.

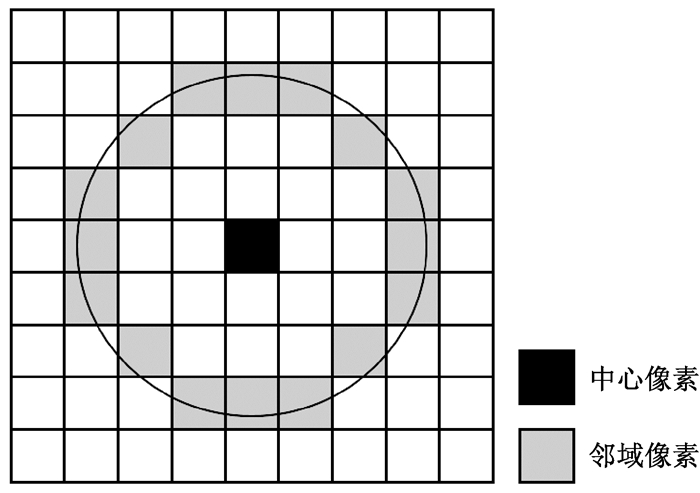

以点P(x, y)为圆心,以3为半径作圆,如图 3所示,则有16个像素p1, p2, …, p16分布在圆上,计算p1, p2, …, p16与中心点P的灰度值差值,如果有超过8个像素灰度值的差值的绝对值大于给定阈值s,则点P为潜在特征点.

|

图 3 FAST算法中点的邻域 Fig. 3 Neighborhood of a feature point in FAST |

为了去除干扰点,需要剔除潜在特征点中的非极大值点.若潜在特征点P的邻域N内,如5×5邻域,有多个潜在特征点,则用式(11)计算邻域N内每个潜在特征点的score值,若点P是邻域N内score值最大的潜在特征点,则保留点P,否则,剔除点P.

| $ score = \max \left\{ {\begin{array}{*{20}{l}} {\sum {\left| {f(i,j) - {f_p}(x,y)} \right|} f(i,j) - {f_p}(x,y) > t}\\ {\sum {\left| {{f_p}(x,y) - f(i,j)} \right|} {f_p}(x,y) - f(i,j) > t} \end{array}} \right., $ | (11) |

其中:f(i, j)是潜在特征点的邻域像素灰度值;fp(x, y)是潜在特征点的灰度值;t为给定阈值.

FAST算法操作简单,实时性好,但对包含噪声的图像鲁棒性不好,检测结果受给定阈值s和t的影响较大,不具备尺度不变性和旋转不变性.研究表明,适当增加图像对比度并滤波去噪能显著提升FAST的稳定性[29].

c) SUSAN算法与FAST算法基本思想类似,如果某像素灰度值与足够多的邻域像素的差值较大,认为该点为特征点,并可以根据邻域特征剔除干扰点.

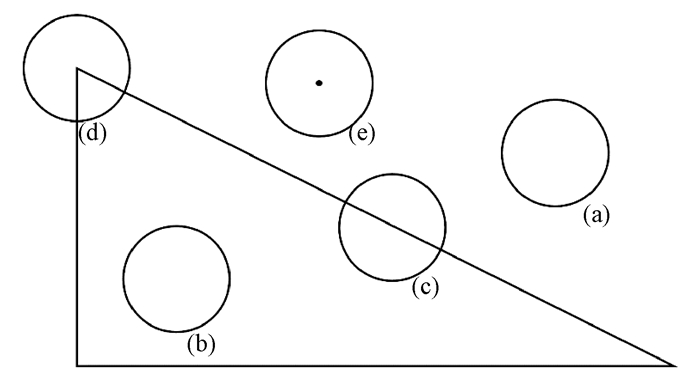

以点P(x, y)为圆心,以r为半径的圆形区域作为点P的邻域,邻域内共有R个像素.若邻域内有n个像素的灰度值与中心像素P灰度值之差小于给定阈值,则认为这n个像素与中心像素P灰度值相同,n个像素共同构成核值相似区(univalue segment assimilating nucleus, USAN).

当中心像素P位于目标或背景中时,如图 4(a)、(b)所示,n与R大致相等;当中心像素P位于边缘上时,如图 4(c)所示,n约为R的1/2;当中心像素P位于角点上时,如图 4(d)所示,n远小于R;当中心像素P位于孤立点上时,如图 4(e)所示,n约为0.

|

图 4 SUSAN算法中点的邻域 Fig. 4 Neighborhood of a feature point in SUSAN |

然后根据USAN区域的特征去除干扰点.若USAN区域的质心与模板中心P的距离小于给定阈值,则剔除;若存在USAN区域的质心与模板中心P的连线上的像素不在USAN区域内,则剔除.

SUSAN算法与FAST算法类似,操作简单,实时性好.该算法还根据USAN区域中像素数量n与邻域内像素总数量R的相对大小实现特征点检测[30]或边缘检测[31],功能性强,可以解决旋转和一定程度的尺度缩放问题,不涉及微分等操作,不易受单个噪声点的影响,鲁棒性好.但是该算法需要调节多个阈值,算法灵活但自适应性较差,对图像亮度敏感,不具备光照不变性.文献[32]提出,SUSAN与高斯-拉普拉斯算子(Laplace of Gaussian,LoG)相结合可以显著改善SUSAN算法对噪声和光照的敏感性.

2) 角点配对

设图像f1(x, y)和f2(x, y)中角点的集合分别为P和Q:P={p1, p2, …, pA};Q={q1, q2, …, qB}.

a) 邻域特征法

用角点的邻域特征构成的特征向量描述角点,如邻域灰度平均值f、邻域灰度值标准差σ、熵e等.

| $ {\mathit{\boldsymbol{p}}_a} = \left[ {{{\bar f}_{pa}},{\sigma _{pa}},{e_{pa}}, \cdots } \right],a = 1,2, \cdots ,A;{\mathit{\boldsymbol{q}}_b} = \left[ {{{\bar f}_{qb}},{\sigma _{qb}},{e_{qb}}, \cdots } \right],b = 1,2, \cdots ,B. $ |

计算角点p1的特征向量pa与qb间的欧式距离,距离最近且小于给定阈值的角点与p1组成特征点对,否则p1无配对特征点.在Q中依次为P中的其余角点配对.

b) 相关系数法

取各角点的(2K+1)×(2K+1)邻域,其中:K=1, 2, …;Rb为角点p1与Q中各角点之间的相关系数,则有

| $ {R_b} = \frac{{\sum\limits_{i = - N}^K {\sum\limits_{j = - N}^K {\left( {{f_1}\left( {{x_1} - i,{y_1} - j} \right) - {{\bar f}_1}} \right)} } \left( {{f_2}\left( {{x_b} - i,{y_b} - j} \right) - {{\bar f}_2}} \right)}}{{\sqrt {\sum\limits_{i = - N}^K {\sum\limits_{j = - K}^K {{{\left( {{f_1}\left( {{x_1} - i,{y_1} - j} \right) - {{\bar f}_1}} \right)}^2}} } \sum\limits_{i = - N}^K {\sum\limits_{j = - K}^K {{{\left( {{f_2}\left( {{x_b} - i,{y_b} - j} \right) - {{\bar f}_2}} \right)}^2}} } } }}, $ | (12) |

其中:b=1, 2, …, B;f1和f2是两幅图像的灰度值;f1和f2是两幅图像中各像素点的灰度均值.Rm最大且大于给定阈值的角点与p1组成特征点对,否则角点p1无配对特征点.在Q中依次为P中的其余角点配对.

角点检测法在提取图像特征时,有效降低了信息量,明显降低了时间复杂度,其准确性和实时性较好,还可以解决部分目标物被遮挡、几何变形等问题.但该类算法在特征提取过程中会损失大量的图像信息,对特征不明显、噪声较多的图像适应性较差.研究表明,与去噪算法、图像增强算法相结合可以提升该类算法性能[33-34].

2.2.2 基于轮廓特征的图像配准基于轮廓特征的图像配准的基本思想是根据轮廓特征对所提取的轮廓进行匹配,再将轮廓匹配对中的某些点作为特征点对,并根据式(1)用特征点对估计空间变换模型.

Li等[35]提出的轮廓匹配算法,能够处理包含有较大噪声但具有清晰边缘的图像,且两图像中相同目标之间有形变的情况,具有很好的鲁棒性和可靠性,可以处理图像间平移、旋转和尺度缩放的问题,对目标形变也有较好的适应性.

1) 轮廓提取

通常采用二值化、卷积或形态学处理等方法提取图像中的目标轮廓,Li用高斯-拉普拉斯(LoG)算子对图像进行卷积运算来提取图像轮廓.拉普拉斯算子是二阶微分算子,卷积后图像中连续过零点即为轮廓线;为了克服拉普拉斯算子对噪声与离散点的增强作用,在处理前使用高斯函数对原图像进行降噪处理.提取的轮廓使用链码[36]编码描述,并对链码进行归一化处理,对归一化链码进行平滑滤波,使链码表示的轮廓更加平滑.

2) 轮廓匹配

通过轮廓的形状特征,包括周长c、轮廓到质心的最大与最小距离dmax和dmin、Hu不变矩[37]中的一阶不变矩h1和二阶不变矩h2,构成的特征向量间的欧氏距离对两幅图像上的轮廓配对,构成轮廓匹配对.

3) 将轮廓匹配对的质心作为特征点对,根据式(1)估计空间变换模型.

基于轮廓特征的图像配准的关键是准确地提取轮廓特征,由于轮廓特征包含信息量较少,所以计算简单、效率高,相对于角点检测法,不易受单个噪声点的影响,鲁棒性较好,但是该类算法的配准精度依赖于轮廓提取精度,所以要求图像具有明显的轮廓特征.

2.2.3 基于SIFT的配准算法SIFT算法[12]能提取具有尺度不变、旋转不变、光照不变的局部极值点作为特征点.其基本思想是使用降采样和高斯函数构建图像尺度空间,提取极值点作为潜在特征点并剔除干扰点,将特征点邻域像素的梯度作为特征向量来描述特征点,计算特征向量间的欧氏距离进行特征点配对,根据公式(1)估计空间变换模型的参数.

1) 构建尺度空间

如图 5所示,用高斯函数G(x, y, σ)对原图像进行平滑处理,构建图像尺度空间L(x, y, σ),

| $ L(x,y,\sigma ) = I(x,y)G(x,y,\sigma ), $ | (13) |

|

图 5 构建DoG图像金字塔的过程 Fig. 5 The process of producing the DoG images |

其中:

T级金字塔的第t(t>0)级第1张图像由第t-1级中第s-2层的图像降采样得到.最后构建出级数为T,每级包含s层图像的高斯图像金字塔.

在T级高斯图像金字塔的每一级中,相邻尺度图像两两相减得到高斯差分(difference of Gaussian,DoG)图像金字塔,即D(x, y, σ)={f1-f0, f2-f1, …, fs-fs-1},其中fi,i∈[0, s]是尺度空间图像.最后构建出级数为T、每级包含s-1层图像的DoG图像金字塔.

2) 特征点提取

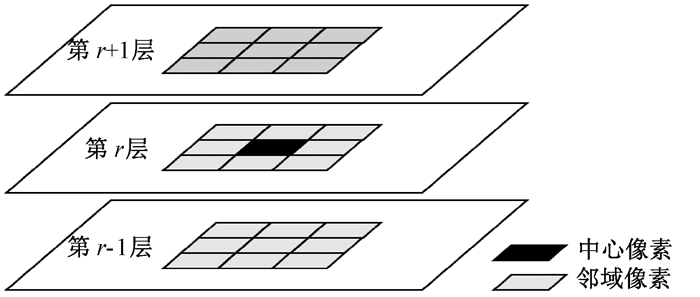

在DoG图像金字塔中,任意像素都可以用(t, r, x, y)表示,其中t为该像素所在DoG图像金字塔的级数,r为该像素所在第t级DoG图像金字塔的尺度空间层数,x和y为像素的坐标.当某像素d(t, r, x, y)的灰度值为其尺度空间r内8邻域内的极值,且为第r-1和r+1层尺度空间图像相同坐标的18个像素的灰度值极值时,该点为其尺度空间中3×3×3邻域内的潜在特征点, 如图 6所示.

|

图 6 SIFT特征点检测 Fig. 6 The detection of feature points in SIFT |

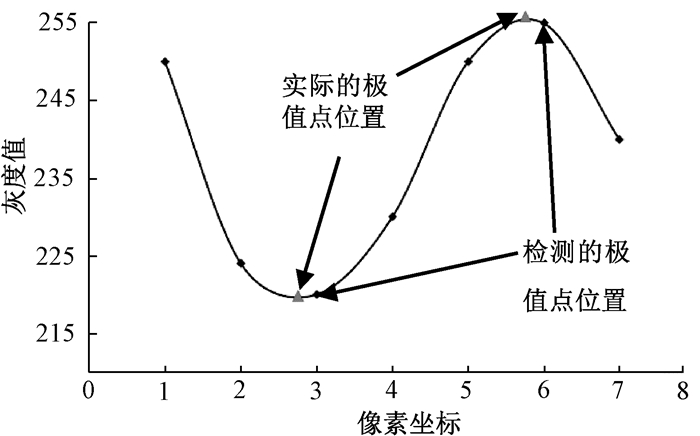

将位于曲率较低的边缘上的潜在特征点剔除, 如图 2(b)所示,并通过拟合特征点所在行和列的像素灰度值曲线,确定特征点的实际位置,最终得到特征点,如图 7所示.

|

图 7 SIFT特征点检测 Fig. 7 The accurate location of feature points in SIFT |

3) 特征点描述

利用邻域像素的梯度特征为特征点指定主方向,具体如下.

确定以特征点p(t, r, x, y)为圆心、3×1.5σ为半径的邻域,计算各邻域像素梯度的幅值Mf和角度δ,

| $ {M_f}(x,y) = \sqrt {{{(L(x + 1,y) - L(x - 1,y))}^2} + {{(L(x,y + 1) - L(x,y - 1))}^2}} , $ | (14) |

| $ \delta (x,y) = \text{arc tan} \left( {\frac{{L(x,y + 1) - L(x,y - 1)}}{{L(x + 1,y) - L(x - 1,y)}}} \right). $ | (15) |

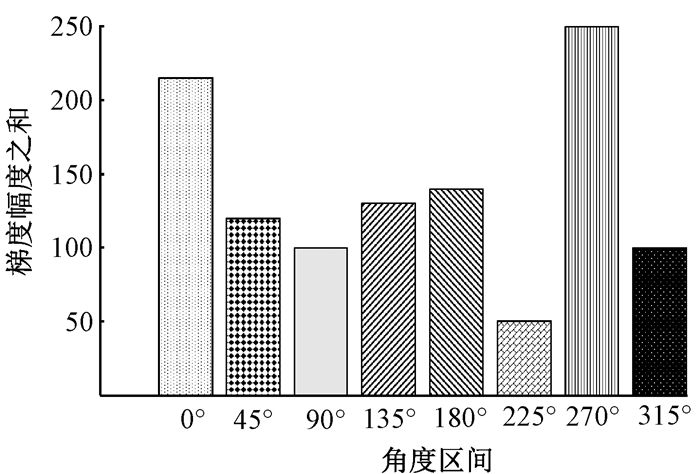

以45°的间隔将360°分为8个角度区间:

| $ {D_\theta } = \left( {\theta - {{22.5}^\circ },\theta + {{22.5}^\circ }} \right],\theta = k \cdot {45^\circ },k = 0,1,2, \cdots ,7. $ | (16) |

计算特征点p(t, r, x, y)邻域内各像素梯度角度在8个角度区间内的分布情况,将各角度区间包含的像素的梯度幅值相加,幅值之和最高的角度区间Dθ即为特征点的主方向θ,如图 8中的270°.

|

图 8 8个45°的角度区间与梯度幅度直方图 Fig. 8 Orientation intervals and the gradient magnitude histogram |

为了确保特征点的旋转不变性,将特征点的邻域旋转θ;取特征点的16×16邻域,如图 9,计算该邻域内各点梯度的幅值与角度,并使用高斯窗口对各梯度的幅值与角度高斯加权,再将16×16邻域划分为16个4×4子邻域,在各4×4子邻域内统计8个角度区间内的梯度幅值之和作为子邻域的种子点;16个种子点各有8个方向,共构成128维的特征向量,最后对128维特征向量归一化,去除光照影响,保证光照不变性.

|

图 9 SIFT特征点描述 Fig. 9 The feature description in SIFT |

4) 根据两幅图像特征点的特征向量之间的欧氏距离对特征点配对,并根据式(1)用特征点对估计空间变换模型的参数.

SIFT算法适用于平移、旋转、尺度缩放、光照不一等情况,适应性强,并且对视角变化、仿射变换也保持一定程度的稳定性;少量目标就可产生大量特征点,特征点的特征向量信息丰富,匹配精度高.该算法可以与其他形式的特征向量相结合,具有一定程度的可扩展性,是图像配准领域中的研究热点,其衍生算法加速稳健特征[38-39]基本满足了实时性要求.但SIFT算法复杂,构建图像金字塔、确定特征点的准确位置、估计主方向等操作可能会带来累积误差,造成特征点稳定性较差;对纹理较少、较为平滑的图像,128维特征向量可能没有显著差异,造成特征点匹配精度低.

3 图像融合技术由于图像亮度差异等因素,配准后图像可能存在明显接缝,需要使用图像融合技术来消除拼接缝隙.根据图像的表征层可将图像融合分为:像素级融合、特征级融合和决策级融合[40-41].像素级融合是目前常用的融合方法,指对像素灰度值进行直接平均、加权平均等操作,计算量较大.特征级融合是首先对图像提取轮廓、纹理、角等特征,再对这些特征分析、处理与整合,得到融合后的特征,速度较快.决策级融合是在特征级融合的基础上,对特征信息进行识别和分类,再基于认知模型和判别系统对决策的可信度量进行判断,融合效果较好,速度快.但是特征级融合和决策级融合的算法复杂,融合过程中丢失较多的原始图像信息,并且可能造成融合后图像的失真,应用较少.

像素级融合中最简单的方法是直接平均法,直接对配准后图像重叠区域的灰度值取平均值,避免了灰度值直接相加造成的溢出.设f(x, y)是f1(x, y)、f2(x, y)融合后图像,则直接平均法可以表示为

| $ f(x,y) = \left\{ {\begin{array}{*{20}{l}} {{f_1}(x,y),}&{(x,y) \in {f_1}}\\ {\left[ {{f_1}(x,y) + {f_2}(x,y)} \right]/2,}&{(x,y) \in \left( {{f_1} \cap {f_2}} \right)}\\ {{f_2}(x,y),}&{(x,y) \in {f_2}} \end{array}} \right.. $ | (17) |

该算法简单易行,但融合质量较差,融合后图像仍然可能存在明显拼接缝隙.

加权平均法是对配准后两幅图像重叠区域的灰度值按一定规则加权后再计算平均值.设f(x, y)是f1(x, y)、f2(x, y)融合后图像,则加权平均法表示为

| $ f(x,y) = \left\{ {\begin{array}{*{20}{l}} {{f_1}(x,y),}&{(x,y) \in {f_1}}\\ {{w_1}{f_1}(x,y) + {w_2}{f_2}(x,y),}&{(x,y) \in \left( {{f_1} \cap {f_2}} \right)}\\ {{f_2}(x,y),}&{(x,y) \in {f_2}} \end{array}} \right.. $ | (18) |

w1、w2分别为图像f1、f2对应像素灰度值相加时的权值,且w1+w2=1,0≤w1, w2≤1,常使用渐入渐出法对权值w1、w2进行动态选取,w1=x2-xi/x2-x1,w2=1-w1=xi-x1/x2-x1,其中:x1为待融合部分的左边界;x2为待融合部分的右边界;xi为待融合像素的横坐标,且x1≤xi≤x2.加权平均法计算简单、效率高,融合效果好,因此应用更为广泛.另外,还可以使用拉普拉斯图像金字塔[42]、小波变换[43]等方法实现图像融合,但操作复杂、耗时较长.

4 图像拼接面临的问题与发展在各个领域,图像拼接都面临通用性、鲁棒性与实时性的问题.由于图像种类繁多,尺寸、亮度、图像特征多变,尚没有一种算法可以适用所有情况的图像拼接,找到通用性强的图像拼接方法是目前重要的研究方向.在大尺度缩放、旋转、平移的情况下,几何畸变、重叠区域面积等问题会对图像拼接的效率与精度产生很大影响,多数算法在上述条件差别较小时可以取得良好效果,但当上述条件差别较大时,可能存在拼接效果差、甚至拼接失败的情况,提高算法的适应性和鲁棒性仍是一个重要课题.另外,诸多实际场景,如军事卫星的成像、无人汽车对路况和行人的成像与识别等,对图像拼接的实时性提出了更高的要求.

目前,研究人员通常从算法和硬件两方面解决这些问题.在算法方面,常使用不同算法相结合的方式提升整体效率,如文献[44]用相位相关法对图像粗配准后,再用角点检测法进行精配准,在不影响实时性的前提下提高了对红外图像的配准精度;文献[45]将Harris的高效率与SIFT描述子的稳定性相结合,先用Harris算法提取特征点,再用改进的SIFT特征向量对特征点配对实现图像拼接;文献[46]先根据图像的梯度和不变矩确定两幅图像的大致重叠区域,再用SIFT对重叠区域实现配准,极大提高了图像配准的鲁棒性和实时性;文献[47]使用Harris算法对SIFT提取的特征点进一步筛选,提高了特征点的准确性;文献[48]根据噪声点、边缘点、平滑点位于不同子空间的性质,用谱聚类的思想将像素进行分类并检测边缘,特别适用于包含有噪声的图像.在硬件方面,文献[49]用图形处理器(graphics processing unit,GPU)实现硬件加速,将配准速度提高了约10倍;文献[50]用基于现场可编程门阵列(field-programmable gate array,FPGA)并行处理的Harris算法,实现了视频的实时拼接.当前的图像处理理论和硬件发展水平都影响着图像拼接技术的发展与应用.

未来几年,深度学习可能会对图像拼接技术产生巨大推动作用.深度学习理论诞生于20世纪60年代,但由于硬件技术的限制,该技术在21世纪初才得到广泛应用,尤其是在计算机视觉和自动语音识别领域.文献[51]在仿真条件下,用全连接神经网络实现了医学上计算机断层扫描(computed tomography,CT)与超声成像(ultrasound scan,US)图像平移关系上的配准,但还不能应用在实际中.文献[52]用同一卷积神经网络结构分别实现了对手写数字、心脏核磁共振图像两种数据集的高效配准, 但单个卷积神经网络对多种场景图像配准的适应性还有待进一步研究.文献[53]首次用卷积神经网络实现了无人汽车上多模态动态视频的实时配准, 但对更多平台上、更多模态的图像配准是另一个待解决的问题.目前,深度学习极大促进了图像拼接领域的发展,对图像拼接的通用性、鲁棒性与实时性都产生了积极影响,但是深度学习在图像拼接领域的应用还处在起步阶段.更多方面,如软硬件结合的方法、对多个场景的适应性、与传统图像拼接方法相结合的理论框架等,还有待进一步研究.

5 结语本文研究了图像拼接技术中的核心算法,首先介绍了图像拼接的技术背景、发展历史和应用领域,指出了图像拼接技术的目的与意义;然后概括了图像拼接的主要流程,包括图像预处理、图像配准和图像融合,并分析了图像之间的变换关系;着重分析对比了图像配准中的核心方法及各方法的特点,尤其对SIFT技术做了重点剖析, 简述了图像融合的分类与常用技术, 最后,分析了图像拼接当前面临的主要问题与未来的可能发展趋势.

目前,图像拼接技术是图像处理技术的重要研究领域,已经在卫星遥感、医学图像分析、虚拟现实、增强现实等方面得到了广泛应用,也是机器人技术、自动驾驶、太空探索等前沿技术领域的重要组成部分.随着计算机性能的发展和数字图像处理理论的完善,以及近年来各技术领域对图像处理技术需求的提高,图像拼接技术无疑将会更进一步发展.

| [1] |

GUPTA V, BUSTAMANTE M, FREDRIKSSON A, et al. Improving left ventricular segmentation in four-dimensional flow MRI using intramodality image registration for cardiac blood flow analysis[J]. Magnetic resonance in medicine, 2018, 79(1): 554-560. DOI:10.1002/mrm.26674 (  0) 0) |

| [2] |

詹斌. 遥感图像拼接系统[J]. 计算机系统应用, 2014, 23(5): 31-36. DOI:10.3969/j.issn.1003-3254.2014.05.005 (  0) 0) |

| [3] |

杨迪航.基于多全景相机拼接的虚拟现实和实景交互系统[D].杭州: 浙江大学, 2017. http://cdmd.cnki.com.cn/Article/CDMD-10335-1018003494.htm

(  0) 0) |

| [4] |

朱云芳.基于图像拼接的视频编辑[D].杭州: 浙江大学, 2006. http://www.cnki.com.cn/Article/CJFDTotal-KJFT201709006.htm

(  0) 0) |

| [5] |

VIGUIER R, LIN C C. Automatic video content summarization using geospatial mosaics of aerial imagery[C]//IEEE International Symposium on Multimedia. Miami, 2015: 249-253.

(  0) 0) |

| [6] |

SAUR G, KRUEGER W. Change detection in UAV video mosaics combining a feature based approach and extended image differencing[J]. The international archives of the photogrammetry, remote sensing and spatial information sciences, 2016, 41(B7): 557-562. (  0) 0) |

| [7] |

TOYAMA F, SHOJI K. Image mosaicing from a set of images without configuration information[C]//The 17th International Conference on Pattern Recognition. Cambridge, 2004: 899-902.

(  0) 0) |

| [8] |

REDDY B S. An FFT-based technique for translation, rotation, and scale-invariant image registration[J]. IEEE transaction on image processing, 1996, 5(8): 1266-1271. DOI:10.1109/83.506761 (  0) 0) |

| [9] |

邹进贵, 杨义辉, 李琴, 等. 局部相位相关法在密集匹配中的应用及精度分析[J]. 测绘通报, 2018, 1(5): 25-28. (  0) 0) |

| [10] |

RENUKA DEVI S M. Image mosaicing using phase correlation and feature based approach: a review[J]. International journal of engineering research, 2016, 4(1): 270-275. (  0) 0) |

| [11] |

HARRIS C. A combined corner and edge detector[C]//The Fourth Alvey Vision Conference. Manchester, 1988: 147-151.

(  0) 0) |

| [12] |

LOWE D G. Object recognition from local scale-invariant features[C]//The Seventh IEEE International Conference on Computer Vision. Kerkyra, 1999: 1150-1157.

(  0) 0) |

| [13] |

LOWE D G. Distinctive image features from scale-invariant key-points[J]. International journal of computer vision, 2004, 60(2): 91-110. (  0) 0) |

| [14] |

ASCHENBRENNER K P, GUTHIER C V. Feasibility of using single photon counting X-ray for lung tumor position estimation based on 4D-CT[J]. Zeitschrift für medizinische physik, 2017, 27(3): 243-254. (  0) 0) |

| [15] |

贾迪, 杨宁华, 孙劲光. 像对匹配的模板选择与匹配[J]. 中国图像图形学报, 2017, 22(11): 1512-1520. (  0) 0) |

| [16] |

MOSTAFAVI H, SLOUTSKY A, JEUNG A. Detection and localization of radiotherapy targets by template matching[C]//The 34th Annual International Conference of the IEEE Engineering in Medicine and Biology Society. San Diego, 2012: 6023-6027.

(  0) 0) |

| [17] |

ZHAO T S. Small target detection and recognition based on template matching[C]//The 4th International Conference on Machinery, Materials and Information Technology Applications. Xi'an, 2016: 964-968.

(  0) 0) |

| [18] |

COOLEY J W, TUKEY J W. An algorithm for the machine calculation of complex fourier series[J]. Mathematics of computation, 1965, 19(90): 297-301. DOI:10.1090/S0025-5718-1965-0178586-1 (  0) 0) |

| [19] |

CASTRO E D, MORANDI C. Registration of translated and rotated images using finite fourier transforms[J]. IEEE transactions on pattern analysis and machine intelligence, 1987, 9(5): 700-703. (  0) 0) |

| [20] |

邵向鑫.数字图像拼接核心算法研究[D].长春: 吉林大学, 2010.

(  0) 0) |

| [21] |

XU J, HONG Y X, XIN S X, et al. Medical image mosaic technology based on image phase correlation[C]//The 4th International Conference on Digital Home. Guangzhou, 2012: 274-277.

(  0) 0) |

| [22] |

WANG W, CHEN H J, LI J P, et al. A registration method of fundus images based on edge detection and phase-correlation[C]//The 1st International Conference on Innovative Computing, Information and Control. Beijing, 2006: 572-576.

(  0) 0) |

| [23] |

FISCHLER M A, BOLLES R C. Random sample consensus: a paradigm for model fitting with applications to image analysis and automated cartography[J]. Graphics and image processing, 1981, 24(6): 381-395. (  0) 0) |

| [24] |

ROSTEN E, DRUMMOND T. Machine learning for high-speed corner detection[J]. European conference on computer vision, 2006, 3951(1): 430-443. (  0) 0) |

| [25] |

ROSTEN E, PORTER R, DRUMMOND T. Faster and better: a machine learning approach to corner detection[J]. Computer science, 2008, 32(1): 105-119. (  0) 0) |

| [26] |

CHEN X, LIU L, SONG J X, et al. Corner detection and matching for infrared image based on double ring mask and adaptive SUSAN algorithm[J]. Optical and quantum electronics, 2018, 50(4): 193-202. DOI:10.1007/s11082-018-1456-6 (  0) 0) |

| [27] |

SMITH S M, BRADY J M. SUSAN—a new approach to low level image processing[J]. International journal of computer vision, 1997, 23(2): 45-78. (  0) 0) |

| [28] |

WANG Z C, LI R, SHAO Z H, et al. Adaptive Harris corner detection algorithm based on iterative threshold[J]. Modern physics letters B, 2017, 31(15): 1750181. DOI:10.1142/S0217984917501810 (  0) 0) |

| [29] |

WU T, ZHANG Z L, ZHAO J Y, et al. An adaptive FAST corner detector based on high contrast grid image[C]//The 2nd International Conference on Mechatronics Engineering and Information Technology. Dalian, 2017: 591-597.

(  0) 0) |

| [30] |

LI H L, GUO L H, CHEN T, et al. The corner detector of the teeth image based on the improved SUSAN algorithm[C]//The 3rd International Conference on Biomedical Engineering and Informatics. Yantai, 2010: 609-612.

(  0) 0) |

| [31] |

曾俊, 李德华. 彩色图像SUSAN边缘检测方法[J]. 计算机工程与应用, 2011, 47(15): 194-196. DOI:10.3778/j.issn.1002-8331.2011.15.052 (  0) 0) |

| [32] |

吕冀, 汪渤, 高洪民. 快速SUSAN-Laplace角点算法[J]. 光学技术, 2008, 34(6): 873-876. DOI:10.3321/j.issn:1002-1582.2008.06.022 (  0) 0) |

| [33] |

MANORANJITHAM R, DEEPA P. Efficient invariant interest point detector using Bilateral-Harris corner detector for object recognition application[J]. Multimedia tools and applications, 2018, 77(8): 9365-9378. DOI:10.1007/s11042-017-4982-5 (  0) 0) |

| [34] |

高华. Log-Gabor梯度方向下的角点检测[J]. 中国图像图形学报, 2017, 22(6): 797-806. (  0) 0) |

| [35] |

LI H, MITRA S K. A contour-based approach to multi-sensor image registration[J]. IEEE transactions on image processing, 1995, 4(3): 320-334. DOI:10.1109/83.366480 (  0) 0) |

| [36] |

靳秋霞. 基于Freeman链码的二维曲线匹配[J]. 计算机应用, 2015, 35(S1): 247-251. (  0) 0) |

| [37] |

HU M K. Visual pattern recognition by moment invariants[J]. Information theory, 1962, 8(2): 179-187. DOI:10.1109/TIT.1962.1057692 (  0) 0) |

| [38] |

BAY H, ESS A, TUYTELAARS T, et al. Speeded-up robust features (SURF)[J]. Computer vision and image understanding, 2008, 110(3): 346-359. DOI:10.1016/j.cviu.2007.09.014 (  0) 0) |

| [39] |

巨刚, 袁亮, 刘小月, 等. 基于改进SURF算法的移动目标实时图像配准方法研究[J]. 通信学报, 2017, 38(1): 177-186. (  0) 0) |

| [40] |

朱炼, 孙凤, 夏芳莉, 等. 图像融合研究综述[J]. 传感器与微系统, 2014, 33(2): 14-18. DOI:10.3969/j.issn.1000-9787.2014.02.004 (  0) 0) |

| [41] |

徐书欣, 葛洪央. 形态人波和对比敏感度函数结合的图像融合算法[J]. 信阳师范学院学报(自然科学版), 2017, 30(3): 449-453. DOI:10.3969/j.issn.1003-0972.2017.03.022 (  0) 0) |

| [42] |

DOGRA A, GOYAL B, AGRAWAL S. Osseous and digital subtraction angiography image fusion via various enhancement schemes and Laplacian pyramid transformations[J]. Future generation computer systems, 2018, 82(1): 149-157. (  0) 0) |

| [43] |

LI H, MANJUNATH B S, MITRA S K. Multi-sensor image fusion using the wavelet transform[J]. Graphical models and image processing, 1995, 57(3): 235-245. DOI:10.1006/gmip.1995.1022 (  0) 0) |

| [44] |

袁梦笛, 顾国华, 钱惟贤, 等. 红外搜索跟踪系统中实时图像配准的研究和实现[J]. 红外技术, 2012, 34(9): 497-502. (  0) 0) |

| [45] |

ZHANG N, HOU J, WANG R W. Harris-SIFT algorithm optimization and its applications on nonwovens[C]//Advances in Materials, Machinery, Electronics. Wuhan, 2017: 123-135.

(  0) 0) |

| [46] |

AGRAWAL V, BHEDA D. Optimized image mosaicing with moment invariants and SIFT features[J]. Oriental journal of computer science and technology, 2017, 10(1): 66-75. DOI:10.13005/ojcst/10.01.09 (  0) 0) |

| [47] |

张震, 邵星星. 一种SIFT虹膜匹配算法[J]. 郑州大学学报(理学版), 2017, 49(3): 14-19. (  0) 0) |

| [48] |

郭新, 徐明, 张众. 基于谱聚类的边缘检测算法[J]. 郑州大学学报(理学版), 2018, 50(3): 83-87. (  0) 0) |

| [49] |

CHEN S F, QIN J, XIE Y M, et al. CUDA-based acceleration and algorithm refinement for volume image[C]//International Conference on Future Bio-medical Information Engineering. Sanya, 2009: 544-547.

(  0) 0) |

| [50] |

OKUMURA K, RAUT S, GU Q Y, et al. Real-time feature-based video mosaicing at 500 fps[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems. Tokyo, 2013: 2665-2670.

(  0) 0) |

| [51] |

SUN Y Y, MOELKER A, NIESSEN W J, et al. Towards robust CT-ultrasound registration using deep learning methods[C]//Understanding and Interpreting Machine Learning in Medical Image Computing Applications. Granada, 2018: 43-51.

(  0) 0) |

| [52] |

VOS B D, BERENDSEN F F, VIERGEVER M A, et al. End-to-end unsupervised deformable image registration with a convolutional neural network[C]//Deep Learning in Medical Image Analysis and Multimodal Learning for Clinical Decision Support. Quebec, 2017: 204-212.

(  0) 0) |

| [53] |

GIERING M, VENUGOPALAN V, REDDY K. Multi-modal sensor registration for vehicle perception via deep neural networks[C]//IEEE High-performance Extreme Computing Conference. Waltham, 2015: 1-6.

(  0) 0) |

2019, Vol. 51

2019, Vol. 51