伴随着人工智能技术在各个领域的广泛应用,数据呈现形式越来越多样化。文本、图像、视频等多模态数据急剧增长,带来了跨模态检索的迫切需求。尽管已有的一些跨模态检索方法提供了一定的理论依据,但在实际应用场景中的检索仍然是针对单一媒介,即查询和检索结果属于同一模态类型。因此,如何挖掘与利用具有语义相关性的多模态数据,实现文本、图像等数据的互检索成为研究热点。

目前,较为普遍的跨模态检索方法是构建不同模态数据的公共语义空间,将图像和文本异构数据映射为相同维度的语义特征,进而度量不同模态数据的语义相似性[1]。文献[2]提出深度对抗学习方法,将不同模态数据非线性映射到共享子空间,引入对抗学习机制和正则化约束,最大化促进模态数据的关联。文献[3]提出标签一致性局部线性嵌入方法,通过局部线性嵌入保留不同模态数据的非线性流形结构,将异构数据转换到公共语义空间以减少语义差距。然而,这些方法主要从图像和文本全局特征建立关联,忽略图像细粒度区域和文本词之间的对应语义关系,且图像特征高度依赖于检测精度。

针对上述方法存在的缺陷,通过挖掘多模态特征的多层关联关系构建有效的语义约束,是提升跨模态检索精度的关键。文献[4]提出结合全局特征和协同注意力表征学习的方法,设计双向排序损失函数,并对图像文本对进行修正,产生更准确的文本排序。文献[5]利用图像区域和句子词之间的全局语义作为局部对齐的补充,直接从可用句子语料库中提取语义标签,执行多标签预测以实现全局语义一致性。本文采用多层语义融合的思想,提出一种多层语义对齐的跨模态检索方法,将生成的多模态特征进行语义对齐,通过文本加权向量进行全局语义约束,以改善图像区域检测不精准的问题,实现跨模态数据的高度关联。

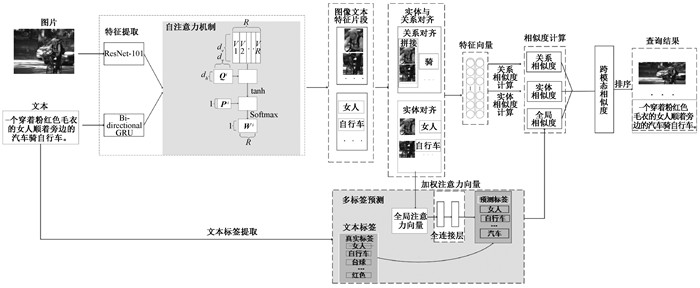

1 多层语义对齐的跨模态检索方法本文通过跨模态表示学习抽取数据特征,将多模态特征映射到公共空间,调用自注意力机制计算图像和文本片段间的关联度,剔除关联度低的区域后对图像区域和文本词实体、关系进行对齐;从文本模态数据直接提取标签信息作为全局语义约束,增强跨模态数据的关联性,并将多层次语义相似度融合,得到图像文本对的整体相似度。

多层语义对齐的跨模态检索模型如图 1所示,处理流程主要包括跨模态表示学习、跨模态注意力机制和全局语义表示三个核心部分。

|

图 1 多层语义对齐的跨模态检索模型 Fig. 1 Cross-modal retrieval model of multi-layer semantic alignment |

由图像、文本组成的数据集合为多模态数据集,可形式化地表示为D={I, T}n=1N,其中:I为图像;T为文本;N为图像-文本数。多模态数据处理的首要任务是特征提取与表示。

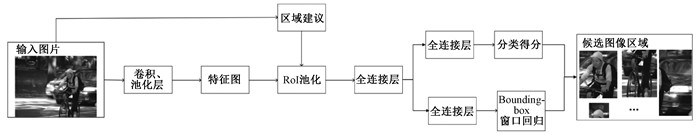

1.1.1 图像特征提取与表示采用Faster R-CNN[6]提取图像特征,图像候选区域选取流程如图 2所示。将原始图像I输入CNN网络,经过若干卷积与池化得到特征图,原图采用selective search算法提取2k个建议框,根据原图建议框到特征图映射关系,找到对应的特征框,并在RoI池化层中将每个特征框池化到7×7。特征框经过全连接层得到固定大小的特征向量,分别得到Softmax分类得分和Bounding-box窗口回归,利用窗口得分剔除重叠建议框,得到每个类别得分最高的窗口。

|

图 2 图像候选区域选取流程 Fig. 2 Selection flowchart of image candidate region |

Faster R-CNN通过ResNet-101网络提取候选框区域特征向量,{f1, f2, …,fn}表示图像I的n个候选区域。为使多模态数据映射到统一空间,添加全连接层对向量降维,计算公式为

| $ \boldsymbol{l}_{i}=\boldsymbol{W}_{v} \cdot \boldsymbol{f}_{i}+b_{v}, i \in[1,2, \cdots, n], $ | (1) |

其中:Wv是转换矩阵;bv是偏置系数;fi表示通过ResNet-101池化后的特征向量,最终投影为1 024维向量。

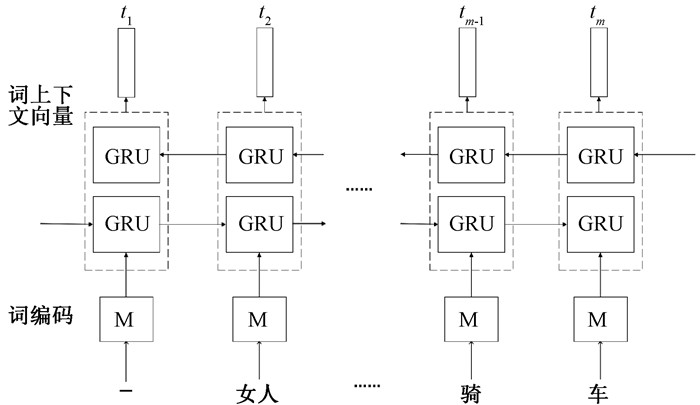

1.1.2 文本特征提取与表示对于文本模态采用Bi-GRU网络充分学习上下文特征,Bi-GRU词向量处理流程如图 3所示。将输入文本T通过one-hot编码得到长度为m的词向量{e1, e2, …,em},再通过Xt=M*et将词嵌入向量空间,其中M是一个嵌入矩阵。输入到Bi-GRU,分别从X1到Xm双向读取词向量,并用式(2)~(5)递归更新GRU,

| $ z_{t}=\sigma\left(W_{z} \cdot x_{t}+U_{z} \cdot h_{t-1}\right), $ | (2) |

| $ r_{t}=\sigma\left(W_{t} \cdot x_{t}+U_{z} \cdot h_{t-1}\right), $ | (3) |

| $ \hat{h}_{t}=\tanh \left(W \cdot x_{t}+U\left(r_{t} \otimes h_{t-1}\right)\right), $ | (4) |

| $ h_{t}=\left(1-z_{t}\right) \otimes h_{t-1}+z_{t} \otimes \hat{h}_{t}, $ | (5) |

|

图 3 Bi-GRU词向量处理流程 Fig. 3 Processing flowchart of Bi-GRU word vector |

其中:zt为更新门;ri为复位门。两个门均采用Sigmoid激活函数决定哪些信息能作为GRU的输出,并长期保存序列中的信息。ht为隐性激活单元,其隐含状态通过更新门对上一时刻隐含状态和候选隐含状态进行更新,控制过去的隐含状态在当前时刻的重要性,当更新门一直趋近于1,t时刻之前的隐含状态将一直保存下来并全传递到t时刻。文本T的最终向量表示为t={t1, t2, …, tm}。

1.2 跨模态注意力机制跨模态多层网络提取的图像和文本特征表示,通过跨模态注意力机制挖掘图像和文本的关联关系,为异构数据关联学习提供补充线索。因此,通过自注意力机制计算特征向量权重α,权重越大,表示区域关联度越高。以图像模态为例,自注意力机制是由多层感知器计算图像细粒度区域与其他区域的关联程度,多层感知器结构见图 1的自注意力机制部分。其中,Q和P为注意力参数矩阵,W是图像片段权值矩阵。将图像特征向量作为输入,通过两层感知器计算权值矩阵W,自适应过滤掉权值小于1/n的区域(n为图像区域数),计算公式为

| $ \boldsymbol{l}=\left\{\boldsymbol{l}_{1}^{\mathrm{T}}, \boldsymbol{l}_{2}^{\mathrm{T}}, \cdots, \boldsymbol{l}_{n}^{\mathrm{T}}\right\}, $ | (6) |

| $ \boldsymbol{W}=\operatorname{Softmax}\left(\boldsymbol{P} \tanh \left(\boldsymbol{Q} \cdot \boldsymbol{l}^{\mathrm{T}}+b_{1}^{i}\right)+b_{2}^{i}\right)。$ | (7) |

此外,采用跨模态联合注意力机制突出描述相应图像区域的关键词。具体来说,对于图像区域lpi,根据词向量与图像区域的语义相似度,计算每个词向量的注意力权重向量apqi,计算公式为

| $ \boldsymbol{a}_{p q}^{i}=\frac{\exp \left(\boldsymbol{l}_{p}^{i^{\mathrm{T}}} \cdot \boldsymbol{t}_{q}\right)}{\sum\limits_{j=1}^{m} \exp \left(\boldsymbol{l}_{p}^{i} \cdot \boldsymbol{t}_{j}\right)}, $ | (8) |

其中:lpi·tq为图像区域lpi和词向量tq的语义相似度。权重越大,表示文本描述图像实体越准确。通过加权词向量计算图像和文本实体相似度,计算公式为

| $ {sim}_{l}\left(\boldsymbol{t}, \boldsymbol{l}_{p}^{i}\right)=\sum\limits_{j=1}^{m} \boldsymbol{l}_{p}^{i} \cdot\left(\boldsymbol{a}_{p j}^{i^{\mathrm{T}}} \cdot \boldsymbol{t}_{j}\right), $ | (9) |

其中:apji表示图像区域lpi和文本词tj的注意力权重向量。其不仅可以有效保留模态内上下文信息,而且利用显著性细粒度增强语义对齐。根据计算的细粒度相似度,将相似度较小的图像文本对视为未匹配,并在多个图像实体中选择K个最近邻,使K个实体的平均相似度最大化,损失函数可以表示为

| $ L_{\text {local }}=\max \left(0, \alpha-\frac{1}{K} \sum\limits_{k=1}^{K} {sim}_{l}\left(\boldsymbol{t}, \boldsymbol{l}_{k}^{i+}\right)+\frac{1}{K} \sum\limits_{k=1}^{K} {sim}_{l}\left(\boldsymbol{t}, \boldsymbol{l}_{k}^{i-}\right)\right), $ | (10) |

其中:(t,li+)为匹配的图像文本对;(t,li-)为不匹配的图像文本对;siml(·)是实体语义相似度;α是边界参数。从匹配和不匹配的图像文本中充分挖掘图像和文本间的实体对齐,除了实体对齐外,利用图像区域关系和文本描述,进一步挖掘图像和文本的关系对齐。图像关系通过构造成对组合来实现,图像组合为ri={lpi:lqi},表示图像第p和q个区域拼接。

将拼接的图像通过全连接层降维到与文本相同维度向量,并采用关系注意力机制突出描述图像关系的文本词。具体来说,对每个图像关系ri,计算词向量与该图像区域的语义相似度,获得注意力权重向量apqr,计算公式为

| $ \boldsymbol{a}_{p q}^{r}=\frac{\exp \left(\boldsymbol{r}_{p}^{i^{\mathrm{T}}} \cdot \boldsymbol{t}_{q}\right)}{\sum\limits_{j=1}^{m} \exp \left(\boldsymbol{r}_{p}^{i^{\mathrm{T}}} \cdot \boldsymbol{t}_{j}\right)}, $ | (11) |

其中:rpi·tq表示图像区域rpi和词向量tq的语义相似度。权重越大,表示文本词描述图像组合的准确度越高。通过加权词向量计算图像组合和文本词关系相似度,计算公式为

| $ {sim}_{r}\left(\boldsymbol{t}, \boldsymbol{r}_{p}^{i}\right)=\sum\limits_{j=1}^{m} \boldsymbol{r}_{p}^{i} \cdot\left(\boldsymbol{a}_{p j}^{r} \cdot \boldsymbol{t}_{j}\right), $ | (12) |

其中:apjr为图像区域rpi和文本词tj的注意力权重向量。类似于实体对齐,采用K近邻算法度量关系相似度,忽略未对齐情况,实现图像和文本关系对齐,损失函数可以表示为

| $ L_{\text {relation }}=\max \left(0, \alpha-\frac{1}{K} \sum\limits_{k=1}^{K} {sim}_{r}\left(\boldsymbol{t}, \boldsymbol{r}_{k}^{i+}\right)+\frac{1}{K} \sum\limits_{k=1}^{K} {sim}_{r}\left(\boldsymbol{t}, \boldsymbol{r}_{k}^{i-}\right)\right)。$ | (13) |

通过对特征向量的实体和关系对齐,充分挖掘了图像、文本和视频特征间的依赖关系,提高了跨模态数据的关联度。为了加强语义约束,将文本的全局表示转换为多标签分类问题,避免因图像区域检测不精准造成实体特征难以对齐。

1.3 全局语义表示现有数据集(例如Flickr30k[7]和MSCOCO[8])未明确提供图像和文本的标签信息,有效的解决方法是根据图像的附加句子构建语义标签。由于Flickr30k和MSCOCO数据集的每张图像都与五个文本相关联,因此选择文本中的名词、形容词和动词等有意义的单词来构建标签词典。为满足每个图像文本对至少包含一个标签,将图像对应的五个文本聚合为一个文本,为图像文本对分配语义标签,并选择文本中出现频率最高的500个词构建标签字典,为每个图像-文本对分配一个或多个语义标签,以表示高级语义。全局特征匹配与直接计算全局特征相似度不同,通过对每个词向量的注意力权重αpqi均值化,得到文本的全局加权向量AT,生成文本全局特征表示,计算公式为

| $ \boldsymbol{\alpha}_{q}=\sum\limits_{p=1}^{n} \boldsymbol{\alpha}_{p q}^{i}, $ | (14) |

| $ \boldsymbol{A}^{\mathrm{T}}=\frac{1}{m} \sum\limits_{q=1}^{m} \boldsymbol{\alpha}_{q} \cdot \boldsymbol{e}_{q} 。$ | (15) |

为了使全局加权向量AT在语义上与(I, T)的语义标签保持一致,将加权向量转换为多标签分类问题,使用两个全连接层和激活函数实现向量语义标签非线性映射(1 024→500→512)。对于图像-文本对(I, T),其文本真实语义标签为Y={y1, y2, …, yC},其中:yi=1表示图像文本存在标签i;C表示标签数量。利用加权向量进行语义标签预测Ŷ,由于标签在字典中分布不均衡,每个标签采用正加权方案。通过标签的负样本和正样本之比计算正权重值PC,提高标签字典中低频标签的召回率。

计算真实标签和预测标签的余弦相似度,计算公式为

| $ {sim}_{g}(I, T)=\frac{\boldsymbol{Y}^{\mathrm{T}} \cdot \hat{\boldsymbol{Y}}}{\left\|\boldsymbol{Y}^{\mathrm{T}}\right\| \cdot\|\hat{\boldsymbol{Y}}\|}。$ | (16) |

将多模态数据相似度进行多层融合,计算公式为

| $ {sim}(I, T)={sim}_{g}(I, T)+\frac{1}{K} \sum\limits_{k=1}^{K} {sim}_{l}\left(\boldsymbol{t}, \boldsymbol{l}_{k}^{i}\right)+\frac{1}{K} \sum\limits_{k=1}^{K} {sim}_{r}\left(\boldsymbol{t}, \boldsymbol{r}_{k}^{i}\right)。$ | (17) |

因此,充分利用多模态数据的全局以及实体和关系互补信息,对图像和文本进行建模,可以提高跨模态检索的精度。

2 实验及结果分析 2.1 数据集和方法验证本实验在NVIDIA 1080 Ti GPU工作站上运行,在Flickr30k和MSCOCO数据集上进行实验,数据集中的每张图片对应五条关联句子,均为图像和文本两种模态数据。Flickr30k数据集包含31 783张图像和与之相关的158 915条文本信息;MSCOCO数据集包含123 287张图像和与之相关的616 435条文本信息。因数据集中只包含了图像和文本两种模态数据,故本方法验证了文本与图像的互检索。

实验中对每一张图像提取36个区域、2 048维度特征,通过全连接层将数据降维至1 024维公共空间。针对每个句子,单词嵌入大小设置为300,长度不足的句子用零填充,使用Bi-GRU对句子单词进行编码,隐藏单元维数为1 024。另外,将损失函数中的参数α设为0.5,K近邻相似度值设为1/3,批处理大小为200,并将学习率每10个周期降低10。

在Flickr30k数据集中,将1 000张图像划分为测试集,其余用来训练模型,并将初始学习率设为2×10-4,迭代30个周期;在MSCOCO数据集中,将5 000张图像划分为测试集,其余用来训练模型,并将初始学习率设为5×10-4,迭代20个周期。

2.2 方法评价与结果分析采用R@K对实验方法进行评估,R@K表示K个检索结果中查询正确的百分比,其值越高,表明检索性能越好,计算公式为

| $ R @ K=\frac{1}{N} \sum\limits_{K=1}^{N} R e l_{K} \text {, } $ | (18) |

其中:N为实例个数。RelK=1表示第K个返回结果与查询实例相关;RelK=0表示第K个返回结果与查询实例无关。实验中K设置为1、5、10。

本文方法与DCCA[9]、SCAN[10]、DVSA[11]、RRF-Net[12]、SCO[13]、JGCAR[4]、、CASC[5]方法在相同环境下的实验结果对比如表 1所示。可以看出,本文方法在Flickr30k数据集上比其他方法的R@K都有所提升,在MSCOCO数据集上部分R@K也有显著提升。

|

|

表 1 不同方法在Flickr30k和MSCOCO数据集上的实验结果对比 Tab. 1 Comparison of experimental results on Flickr30k and MSCOCO data sets by different methods |

现有的跨模态检索方法主要存在以下两个问题:1) 基于全局特征匹配方法由于网络结构较浅,提取模态特征粗糙,造成图像和文本对齐精度不高且损耗函数设计较差;2) 混合匹配方法只关注图像和文本的全局和实体对齐,并没有挖掘文本和图像区域间关系,且实体对齐高度依赖图像检测精准度,造成跨模态数据难以对齐。本文提出一种多层语义对齐的跨模态检索方法,利用文本加权向量的多标签预测实现全局语义约束;通过图像和文本注意力机制,突出图像和文本显著性特征,实现精准对齐。在Flickr30k和MSCOCO两个公开数据集上的实验结果表明了本文方法的有效性。下一步工作将聚焦算法复杂度问题,通过融合知识图谱实现多模态数据的语义表达,研究基于多模态知识表示的跨模态检索。

| [1] |

卓昀侃, 綦金玮, 彭宇新. 跨媒体深层细粒度关联学习方法[J]. 软件学报, 2019, 30(4): 884-895. ZHUO Y K, QI J W, PENG Y X. Cross-media deep fine-grained correlation learning[J]. Journal of software, 2019, 30(4): 884-895. (  0) 0) |

| [2] |

XU X, HE L, LU H M, et al. Deep adversarial metric learning for cross-modal retrieval[J]. World wide web, 2019, 22(2): 657-672. DOI:10.1007/s11280-018-0541-x (  0) 0) |

| [3] |

ZENG H, ZHANG H X, ZHU L. Label consistent locally linear embedding based cross-modal hashing[J]. Information processing and management, 2020, 57(6): 102136. DOI:10.1016/j.ipm.2019.102136 (  0) 0) |

| [4] |

WANG S H, CHEN Y Y, ZHUO J B, et al. Joint global and co-attentive representation learning for image-sentence retrieval[C]//Proceedings of the 26th ACM International Conference on Multimedia. New York: ACM Press, 2018: 1398-1406.

(  0) 0) |

| [5] |

XU X, WANG T, YANG Y, et al. Cross-modal attention with semantic consistence for image-text matching[J]. IEEE transactions on neural networks and learning systems, 2020, 31(12): 5412-5425. DOI:10.1109/TNNLS.2020.2967597 (  0) 0) |

| [6] |

熊昌镇, 蒋杰. 多尺度区域特征的细粒度分类算法研究[J]. 郑州大学学报(理学版), 2019, 51(3): 55-60. XIONG C Z, JIANG J. Multi-scale region features algorithm for fine-grained classification[J]. Journal of Zhengzhou university (natural science edition), 2019, 51(3): 55-60. (  0) 0) |

| [7] |

YOUNG P, LAI A, HODOSH M, et al. From image descriptions to visual denotations: new similarity metrics for semantic inference over event descriptions[J]. Transactions of the association for computational linguistics, 2014, 2: 67-78. DOI:10.1162/tacl_a_00166 (  0) 0) |

| [8] |

VINYALS O, TOSHEV A, BENGIO S, et al. Show and tell: lessons learned from the 2015 MSCOCO image captioning challenge[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(4): 652-663. DOI:10.1109/TPAMI.2016.2587640 (  0) 0) |

| [9] |

ANDREW G, ARORA R, BILMES J, et al. Deep canonical correlation analysis[C]//Proceedings of the 30th International Conference on Machine Learning. New York: ACM Press, 2013: 1247-1255.

(  0) 0) |

| [10] |

LEE K H, CHEN X, HUA G, et al. Stacked cross attention for image-text matching[M]//Computer Vision-ECCV 2018. Cham: Springer International Publishing, 2018: 212-228.

(  0) 0) |

| [11] |

KARPATHY A, LI F F. Deep visual-semantic alignments for generating image descriptions[C]//Proceedings of the IEEE Transactions on Pattern Analysis and Machine Intelligence. Piscataway: IEEE Press, 2016: 664-676.

(  0) 0) |

| [12] |

LIU Y, GUO Y M, BAKKER E M, et al. Learning a recurrent residual fusion network for multimodal matching[C]//Proceedings of the IEEE International Conference on Computer Vision. Piscataway: IEEE Press, 2017: 4127-4136.

(  0) 0) |

| [13] |

HUANG Y, WU Q, SONG C F, et al. Learning semantic concepts and order for image and sentence matching[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2018: 6163-6171.

(  0) 0) |

2021, Vol. 53

2021, Vol. 53