2. 苏州大学 计算机科学与技术学院 江苏 苏州 215006

2. School of Computer Science & Technology, Soochow University, Suzhou 215006, China

情感分类是对带有感情色彩的主观性文本进行分析、推理的过程。例如:产品评论“配件贵、夜间拍摄外景效果不太好!”被认为是负面的情感。在电子商务平台中存在大量此类评论文本, 正确识别这些评论文本的情感对了解产品质量以及促进电子商务平台的发展等都具有重要意义。

以往的研究中, 基于监督学习的情感分类方法已经取得了很好的分类效果[1], 但是监督学习方法需要大量的标注样本, 标注样本往往费时费力, 而无须任何标注样本的无监督学习方法的聚类效果又达不到实际需求[2-3], 因此情感分类研究的关注点逐渐从监督学习转向半监督学习, 以此减少情感分类任务对标注样本的依赖。例如, 协同训练[4]、标签传播[5]和深度学习[6]都被广泛应用于半监督的情感分类任务。

然而, 已有的半监督情感分类方法仍然需要获取未标注样本的标签。通常获取未标注样本标签的方法有两种, 一种是先从初始训练集训练出一个学习器, 再根据学习器的表现对未标注样本进行分类, 如此反复进行, 获取未标注样本的标签[4-5]; 另一种是通过规则学习, 即从训练数据中学习出一组能用于对未见示例进行判别的规则获取未标注样本的标签[7]。显然, 这两种方法都无法保证获取的未标注样本标签的正确率, 而错误的标注样本也会影响情感分类的性能。

另外, 中文情感分类中很多词语在不同语境中的情感也不同。词有多义、歧义的现象, 同一观点词在不同领域、不同的语境中甚至会有相反的情感倾向[8]。词语“高”在例1中的中文句子中表现为褒义, 而在例2中的中文句子中表现为贬义。相对而言, 英文句子不需要分词, 且中文句子无法确定的情感翻译成英文后更容易确定。例1的“性价比高”在中文中被分为“性价比”和“高”两个词语而无法确定其情感, 而翻译成英文为“cost-effective”便很容易识别出正面情感。

例1 中文:模样讨喜, 功能齐全, 性价比高; 英文:Look favorable, a full-featured, cost-effective。

例2 中文:价位高, 自动聚焦不好, 取景器不清楚!英文:Price high, auto-focus poor, the viewfinder is not clear!

因此, 为了缓解传统半监督方法的缺陷以及充分利用双语的辅助信息, 本文提出了基于双语对抗学习的半监督情感分类方法。首先, 中文的标注样本和未标注样本经过不同的编码器之后分别通过分类器和判别器进行对抗学习, 其中, 分类器的作用是识别样本的情感倾向并且使标注样本和未标注样本处于同一分布, 而判别器用来区分输入样本是标注样本还是未标注样本。然后构建一个英文语料的对抗神经网络, 其输入的标注样本和未标注样本为中文样本经过谷歌翻译的英文样本。最后, 通过联合学习中英文对抗神经网络提升半监督情感分类的实验结果。

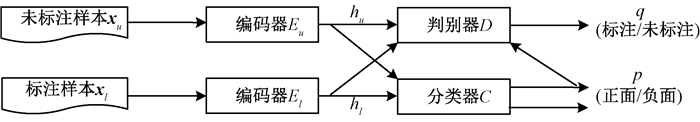

1 基于双语对抗学习的半监督情感分类 1.1 中文对抗学习的半监督情感分类中文对抗神经网络的半监督情感分类方法包括两个编码器、一个分类器和一个判别器, 图 1介绍了中文对抗神经网络的半监督情感分类方法的模型图。

|

图 1 中文对抗神经网络的半监督情感分类模型图 Fig. 1 Semi-supervised sentiment classification with Chinese adversarial learning |

图中的El和Eu表示两个编码器, 分别将标注样本和未标注样本映射到代码空间中,

| $ {h_l} = {E_l}\left( {{\mathit{\boldsymbol{x}}_l}} \right), \;{h_u} = {E_u}\left( {{\mathit{\boldsymbol{x}}_u}} \right), $ |

其中:xl表示标注样本输入的词向量形式; xu表示未标注样本输入的词向量形式。编码器El和Eu使用标准的长短期记忆(long short-term memory, LSTM)神经网络将文本序列编码为固定长度的向量。hl和hu分别为标注样本和未标注样本经过不同的编码器的输出结果。

接着, 使用分类器C预测文本的情感倾向,

| $ {p_l} = C\left( {{h_l}} \right), \;{p_u} = C\left( {{h_u}} \right), $ |

其中:pl和pu表示输入文本xl和xu的分类概率。分类器C使用激活函数是softmax的全连接神经网络,

| $ {p_l} = \mathit{softmax}\left( {{\mathit{\boldsymbol{W}}_c}{h_l} + {\mathit{\boldsymbol{b}}_c}} \right), \;{p_u} = \mathit{softmax}\left( {{\mathit{\boldsymbol{W}}_c}{h_u} + {\mathit{\boldsymbol{b}}_c}} \right), $ |

其中:Wc和bc分别表示该层的权值矩阵和偏置向量。

图中的判别器D用来判断输入文本是属于标注样本还是未标注样本, 标注样本的真实标签和未标注样本的预测概率分别作为判别器D的辅助输入,

| $ {q_l} = D\left( {{h_l} \oplus {y_l}} \right), \;{q_u} = D\left( {{h_u} \oplus {p_u}} \right), $ |

其中:ql和qu表示输入文本xl和xu的判别概率; yl表示输入文本xl的真实情感标签;

为了更好地训练对抗神经网络, 首先使用最小化二元交叉熵作为分类器C的损失函数, 损失函数lossC定义为

| $ \mathit{los}{\mathit{s}_C} = \min \left( { - \frac{1}{m}\sum\limits_{i = 1}^m {\sum\limits_{j = 1}^k {{y_{ij}}} } \log {p_{ij}}} \right), $ |

其中:m是样本总量; k是情感类别的数量; yij表示第i个样本是否属于第j个情感类别; pij表示第i个样本预测为第j个情感类别的概率。

接着, 通过公式(1)训练判别器的损失

| $ \mathit{los}{\mathit{s}_D} = \mathop {\min }\limits_{{\theta _E}} \left( {\lambda \mathop {\max }\limits_{{\theta _D}} \left( {\sum\limits_{i = 1}^m {{d_i}} \log {q_i}} \right)} \right), $ | (1) |

其中:lossD是判别器D的损失函数; di表示第i个样本属于标注样本还是未标注样本; qi表示第i个样本的判别概率; λ是对抗网络超参数。

最后, 本小节提出的中文对抗神经网络的模型损失函数为

| $ {J_{{\rm{cn}}}} = \mathit{los}{\mathit{s}_C} + \mathit{los}{\mathit{s}_D}。$ |

另外, 实验使用Adam[9]作为优化函数, 在整个神经网络中所有的矩阵和向量被初始化为统一的格式, 即

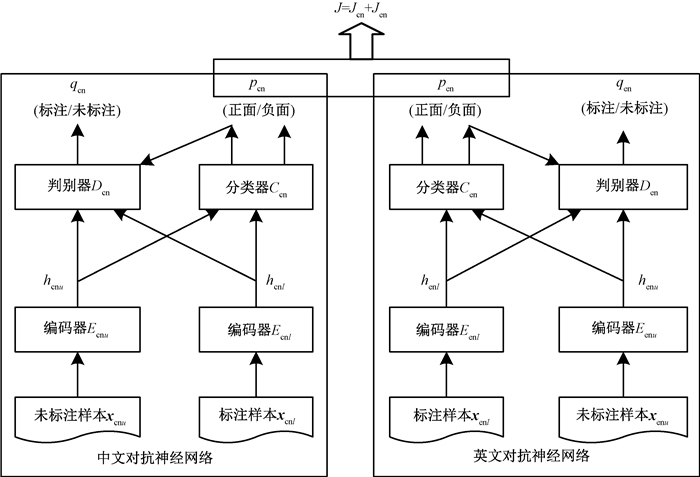

双语对抗神经网络的半监督情感分类方法包括中文对抗神经网络和英文对抗神经网络两部分。图 2显示了双语对抗神经网络的半监督情感分类方法的模型图。在本文提出的模型中, 通过中文对抗神经网络和英文对抗神经网络的联合学习有效提高了中文样本的情感分类结果。

|

图 2 基于双语对抗学习的半监督情感分类模型图 Fig. 2 Semi-supervised sentiment classification with bilingual adversarial learning |

具体联合学习的损失函数为

| $ J = {J_{{\rm{cn}}}} + {J_{{\rm{en}}}}, $ |

其中:Jen是同Jcn训练方法相同的英文对抗神经网络的损失函数。

在基于双语对抗学习的半监督情感分类方法中, 实验通过融合每条文本的中英文标签概率决定测试样本的标签类别。

2 实验结果与分析 2.1 实验设置本文采用了Wan[10]提供的中国IT产品网站IT168的中文评论语料, 其中包括886条标注样本(451条正面评论样本和435条负面评论样本)和2 000条未标注样本, 评论内容主要集中在mp3播放器、手机、数码相机和笔记本电脑等产品上。对于2.2节使用的英文语料, 实验使用中文评论语料对应的谷歌翻译结果。具体实验中分别使用3组不同的训练样本数量对相同的测试样本进行测试, 其中训练样本数量分别为正负各10条标注样本、正负各20条标注样本、正负各50条标注样本, 测试样本数量为正负各300条标注样本, 实验中采用所有未标注样本2 000条。

本文采用jieba工具进行分词, 并且采用word2vec训练词向量。实验结果采用准确率作为衡量情感分类性能的评价指标。

2.2 实验结果为了验证本文提出方法的有效性, 本文实现了以下几种半监督情感分类方法。

baseline(LSTM):本实验使用了标准的LSTM模型进行全监督情感分类方法。

LP(CN):Zhu[5]等提出了一种基于图形的半监督学习方法, 即标签传播(label propagation, LP), 实验中仅使用中文语料进行标签传播。

self-training(CN):本实验采用传统的自训练算法, 仅使用中文语料进行自训练算法。

VAE(CN):本实验采用变分自编码器实现半监督情感分类[11], 仅使用中文语料进行变分自编码器(variational autoencoder, VAE)实验。

AL(CN):该方法为2.1小节介绍的中文对抗学习的半监督分类方法。

LP(CN+EN):将中文语料和英文语料分别进行标签传播, 然后通过融合每条文本的中英文标签概率决定测试样本的标签。

self-training(CN+EN):将中文语料和英文语料分别进行自训练, 然后通过融合每条文本的中英文标签概率决定测试样本的标签。

VAE(CN+EN):将中文语料和英文语料分别进行变分自编码器的实验, 然后联合学习中英文模型的损失函数, 最后通过融合每条文本的中英文标签概率决定测试样本的标签。

AL(CN+EN):该方法为2.2小节介绍的基于双语对抗学习的半监督分类方法。

表 1展示了上述几种方法在不同训练集数量上的半监督情感分类任务的性能。

|

|

表 1 各方法在不同训练集数量上情感分类任务上的准确率 Tab. 1 The accurate rate of semi-supervised sentiment classification task on different training sets |

通过比较, 从表 1中可以得出以下结论。

1) 对抗学习的方法比其他基准半监督的方法好(如表 1中粗体所示)。对抗学习的方法在不同训练集规模上的实验结果比传统的半监督方法(LP和self-training)的结果都高, 并且对比VAE的实验结果也有明显提升。实验结果说明通过分类器和判别器的对抗学习可以有效学习到未标注样本的文本信息, 增强模型的数据特征, 从而帮助分类器更好地进行分类。

2) 使用双语对抗学习的半监督情感分类方法比使用单语对抗学习的半监督情感分类方法的实验结果更好。具体而言, 与单语实验相比, 加入英文语料的融合结果之后, LP(CN+EN)方法在3种不同的训练集规模中的实验结果如下:LP(CN+EN)方法平均提高了1.99%;self-training(CN+EN)方法的实验结果平均提高了2.78%;VAE(CN+EN)方法的实验结果平均提高了3.56%;本文提出的AL(CN+EN)方法的实验结果平均提高了3.71%。实验结果表明, 利用双语信息能够有效提升半监督情感分类的实验性能。

3) 本文提出的基于双语对抗学习的半监督情感分类方法AL(CN+EN)在所有的实验中都表现最好。当训练集数量为100条时, 使用AL(CN+EN)方法进行情感分类任务的准确率比未使用未标注样本的LSTM方法提高6.34%。实验结果表明利用双语信息及对抗学习能有效提高半监督情感分类的实验性能, 本文提出的对抗网络能够捕捉未标注样本中的有效信息。

3 结语本文提出了基于双语对抗学习的半监督情感分类方法, 主要通过分类器和判别器之间的对抗学习充分利用未标注样本的样本信息, 这种对抗学习的方法可以有效避免对未标注样本分类或者自动标注带来的错误标签的问题。同时本文使用了中文语料对应的英文语料的对抗学习, 通过中英文对抗神经网络的联合学习有效提高了半监督情感分类任务的性能。

| [1] |

PANG B, LEE L, VAITHYANATHAN S. Sentiment classification using machine learning techniques[C]// Proceedings of the Empirical Methods in Natural Language Processing. Philadelphia, 2002: 79-86.

(  0) 0) |

| [2] |

ZAGIBALOV T, CARROLL J. Automatic seed word selection for unsupervised sentiment classification of Chinese text[C]//Proceedings of the International Conference on Computational Linguistics. Manchester, 2008: 1073-1080.

(  0) 0) |

| [3] |

LIN C H, HE Y L. Joint sentiment/topic model for sentiment analysis[C]// Proceeding of the 18th ACM Conference on Information & Knowledge Management. Hong Kong, 2009: 375-384.

(  0) 0) |

| [4] |

WAN X J. Co-training for cross-lingual sentiment classification[C]// Proceedings of Joint Conference of the Meeting of the ACL and the International Joint Conference on Natural Language. Singapore, 2009: 235-243.

(  0) 0) |

| [5] |

ZHU X J, GHAHRAMANI Z. Learning from labeled and unlabeled data with label propagation[J]. Tech Report, 2002, 3175(2004): 237-244. (  0) 0) |

| [6] |

ZHOU S S, CHEN Q C, WANG X L. Active deep networks for semi-supervised sentiment classification[C]// Proceedings of the International Conference on Computational Linguistics. Beijing, 2010: 1515-1523.

(  0) 0) |

| [7] |

王志昊.情感分类特征选择方法[D].苏州: 苏州大学, 2014. WANG Z H. Research on feature selection for sentiment classification[D]. Suzhou: Soochow University, 2014. (  0) 0) |

| [8] |

苏艳.双语情感分类方法研究[D].苏州: 苏州大学, 2013. SU Y. Sentiment classification with bilingual text[D]. Suzhou: Soochow University, 2013. (  0) 0) |

| [9] |

KINGMA D P, BA J. Adam: a method for stochastic optimization[C]//International Conference on Learning Representions. San Diego, 2015: 1-13.

(  0) 0) |

| [10] |

WAN X J. Bilingual co-training for sentiment classification of Chinese product reviews[J]. Computational linguistics, 2011, 37(3): 587-616. (  0) 0) |

| [11] |

XU W D, SUN H Z, DENG C, et al. Variational autoencoders for semi-supervised text classification[C]// Proceedings of the 31st AAAI Conference on Artificial Intelligence. San Francisco, 2017: 3358-3364.

(  0) 0) |

2020, Vol. 52

2020, Vol. 52