2. 湖北省服装信息化工程技术研究中心 湖北 武汉 430200;

3. 武汉纺织大学 计算机与人工智能学院 湖北 武汉 430200

2. Engineering Research Center of Hubei Province for Clothing Information, Wuhan 430200, China;

3. School of Computer Science and Artificial Intelligence, Wuhan Textile University, Wuhan 430200, China

目前漫反射物体光学测量技术已经比较成熟。高光泽皮革、玻璃、塑料、金属部件等具有镜面反射特性的物体图像表面的高光,使得部分应用于漫反射的计算机视觉任务难以直接应用,如对象检测[1]、内在图像的分解[2]和跟踪[3]。如何合理消除物体表面的高光具有科研价值和实用价值。

在早期的去高光算法中,研究者们通过将图像中最亮的像素视为高光来检测[4],但是不能将场景中亮度比较高的材质和高光区分开来。传统算法去除图像中的高光,通常将高光视为噪声或分析图片中的镜面反射与漫反射的组成成分,如优化[5]、聚类[6]和过滤[7],但由于缺乏图像语义, 可能无法处理大规模的高光去除。

近年来,神经网络作为一种通用函数拟合器,在很多图像处理领域中显示出了令人惊叹的效果,如图像去噪、去雨滴任务。针对图像的高光去除任务,可以使用大量的配对数据训练网络,有监督去除图像中的高光[8]。

在实际中,大量成对图片难以获取,对偶学习能够充分利用未标注的数据,针对图像的高光去除任务,可以基于镜面反射域与漫反射域训练数据集,无监督去除图像中的高光[9]。然而上述过程没有考虑转换过程中背景对去高光结果的影响。为使风格迁移算法仅作用于前景物体,基于实验室标定的序列图像,提出了一种改进的无监督学习CycleGAN[10]框架,该模型采用分层的端到端网络。改进的模型主要有以下贡献:1) 生成大量视角、光照可控的图片,并整理为一个视角信息可知的合成数据集;2) 改进了CycleGAN网络,在网络中采用了可微分渲染器,仅使用少量的背景图片,即可将输入图片分解为前景与背景,使CycleGAN网络仅作用于前景以提高精度。

1 相关工作 1.1 本征图分解通过本征图分解可以得到给定图像对应的本色图和高光图。本征图的分解过程可以看作是图像到图像的转换问题。图像到图像转换旨在学习两个视觉域之间的映射关系,通过在CNN上训练以获取材质[11]、反射图[12]、照明[13]等渲染参数。而该模型关注的重点是使用条件GAN结构从多视图图像中去除光泽效果。

1.2 输入为单目图像的无监督算法无监督学习充分利用未标记数据,将漫反射域到镜面反射域之间的对应关系看作是一个闭环的对偶学习任务,利用对偶学习来实现镜面反射材质到漫反射材质的互相转换,从而达到去高光的效果。Wu等[9]率先采用基于CycleGAN算法的S2D-NET(specular-to-diffuse NET)网络将镜面反射物体的多个视图转换为漫反射物体对应的视图,从而完成了透明物体的三维重建。

1.3 基于可微分渲染器的图像合成算法近年来,可微分渲染技术在图像合成方面取得了令人印象深刻的成果。通过与计算机视觉领域知识相结合,在一定约束下可以揭示二维图像具有物理意义的三维特性[14-15],证明可以通过可微分渲染技术建立二维与三维之间的转换。将三维物体渲染成二维图像时,其本质是使用矩阵变换投影三维物体到二维平面。如果将渲染过程看作神经网络的前向传播,那么反向传播的损失函数可以定义为渲染图像和输入图像之间的不同,进而去优化三维物体的形状与纹理。Kato等[16]提供了一个可微分渲染器。Liao等[17]使用该渲染器生成大量视角、光照信息可控的图片。Miyato等[18]将可微分渲染器与GAN网络相结合,分离目标场景潜在的三维因素,该模型能够单独操纵场景中的多个物体。对渲染过程添加特定约束,就可实现二维图像前景与背景的分离。

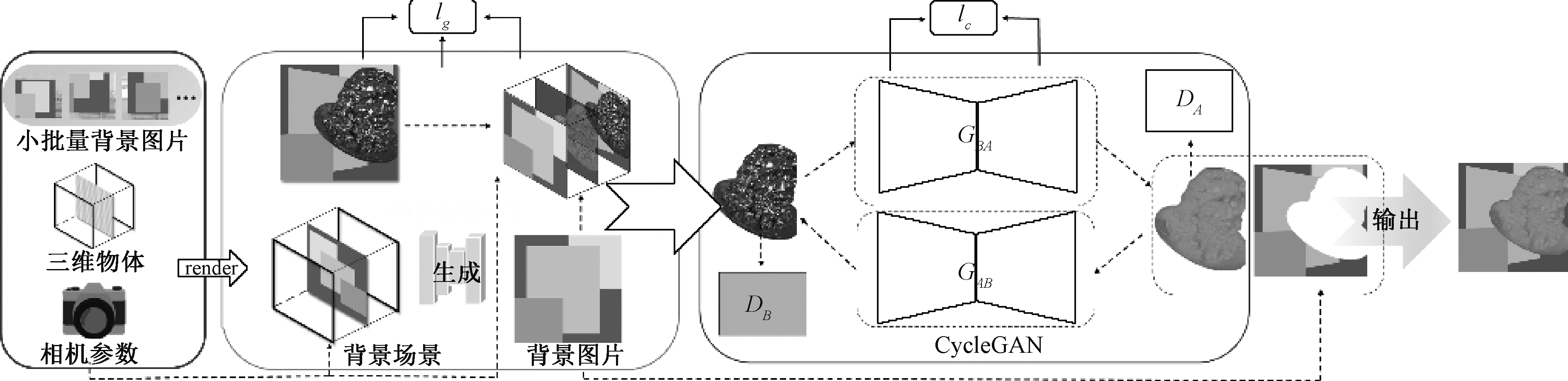

2 方法网络结构如图 1所示,首先基于可微分渲染器利用多视角背景图片生成背景场景,将背景场景投影到2D平面合成背景图片,随后将合成的背景图片与待分离图片输入比较器中,生成蒙版以实现物体的前景与背景分离。由于使用的是合成数据集,输入图片的相机参数是已知的,所以可以保证背景场景的投影图片与待分离图片视角信息一致。上述网络可实现任意视角、任意输入图片的前景与背景分离,然后基于CycleGAN,去除前景图片中的高光。该模型从多视角图片中学习一个可去除物体前景高光的模型,从3D角度考虑了图像形成过程,而不是直接解析2D图像的构成。

|

图 1 基于多视角序列图像的高光去除CycleGAN网络结构图 Fig. 1 Highlight removal CycleGAN network structure diagram based on multi-view sequence images |

使用可微分渲染器的目标是生成高质量背景场景,同时能够控制生成的背景场景的几何特征。为达成目的,使用数据集S={G, A}建模,G代表一组背景图片数据集G={G1, G2, …, Gn},A={R, t}用来表示物体的姿态参数,R是旋转矩阵,t是平移矩阵。为保证相机视点的变化不影响背景场景生成,相机参数为固定值。

多视角背景图片的合成。由于原始级别的物体姿态参数很难获得,使用CINEMA 4D合成数据集,将X、Y平面作为地面,对地面进行贴图生成不同前景的分离。由于是合成图像,所以背景图片G与待分离图片O中的物体位置是已知的,使用R与t描述拍摄图片的物体位置,R是物体的X、Y、Z旋转矩阵,t是物体的平移矩阵。在生成背景场景时,为解决不同视角下3D对象姿势一致性问题,参考文献[14]方法将相机固定,通过改变物体的外参数(R, t)得到相同视角下3D对象的不同姿态。

2.2 基于可微分渲染器的前景、背景分离为了模拟相机视点的变化,使用Kato等[17]提供的可微分渲染器,该渲染器通过双线性插值法,近似地计算光栅化过程的梯度,从而将其应用于神经网络的反向传播过程中,以训练整个网络的参数。通过该渲染器训练3D网格的贴图,进而生成背景场景。投影背景场景,得到3D网格的投影图片P={p1, p2, …, pn},由于背景图片G与投影图片物体位置参数相同,所以理论上在同一视角下背景图片G与投影得到的图片P是相同的,即

| $ \sum\limits_{i=1}^n\left(P_i-G_i\right)=0 \text { 。} $ | (1) |

在3D网格中,单幅背景图片可以生成部分贴图,通过多幅背景图片,可以补全3D网格中的贴图。

分离图像的前景与背景是在理解图像的基础上进行的,使用3D图像投影得到2D图像,可以从更高的维度理解图像。对于每幅待分离图片O而言,需要在同一物体姿态下投影背景场景得到投影P′={P1′, P2′, …, Pn′}, 将待分离图片O与投影P′输入分离器,完成图片的前景分离。

分离器实际上是通过蒙版M遮挡待分离图片O,使遮挡后的图片与投影P′误差最小实现的,通过蒙版Mi遮掩原始数据集中的物体,得到图像Z={Z1, Z2, …, Zn},那么理论上可以得到

| $ \sum\limits_{i=1}^n\left(P_i^{\prime} \cdot M_i-Z_i\right)=0 \text { 。} $ | (2) |

当待分离图片O与投影P′两幅图像之间的像素误差大于一定值时,将此处的像素设为透明。则前景f={f1, f2, …, fn} 可用公式(3)表示,

| $ f_i=O_i-O_i M_i \text { 。} $ | (3) |

使用可微分渲染器生成背景场景的损失函数定义为

| $ l_g=\sum\limits_{i=1}^n\left[\left(\boldsymbol{R}_i \cdot X_i+\boldsymbol{t}_i\right)-D_i^{\prime}+\left(\boldsymbol{R}_i \cdot X_i^{\prime}+\boldsymbol{t}_i^{\prime}\right)-D_i\right], $ | (4) |

其中:Xi为固定视角下3D对象的像素点,改变其外参数(Ri, ti) 得到相同视角下3D对象的另一姿势Di。使用可微分渲染器模拟原世界坐标系,在相机内参数和位置不变的情况下,观测3D对象得到像素点Xi′,同理改变物体外参数(Ri, ti)可得到Di′。由于生成的像素点仅改变了物体的姿势参数,根据相机成像原理可以实现两个视图之间的相对变换,即R·X+t=D。几何一致性损失鼓励具有相同外观但从不同角度观察的对象在外观和深度方面保持一致。

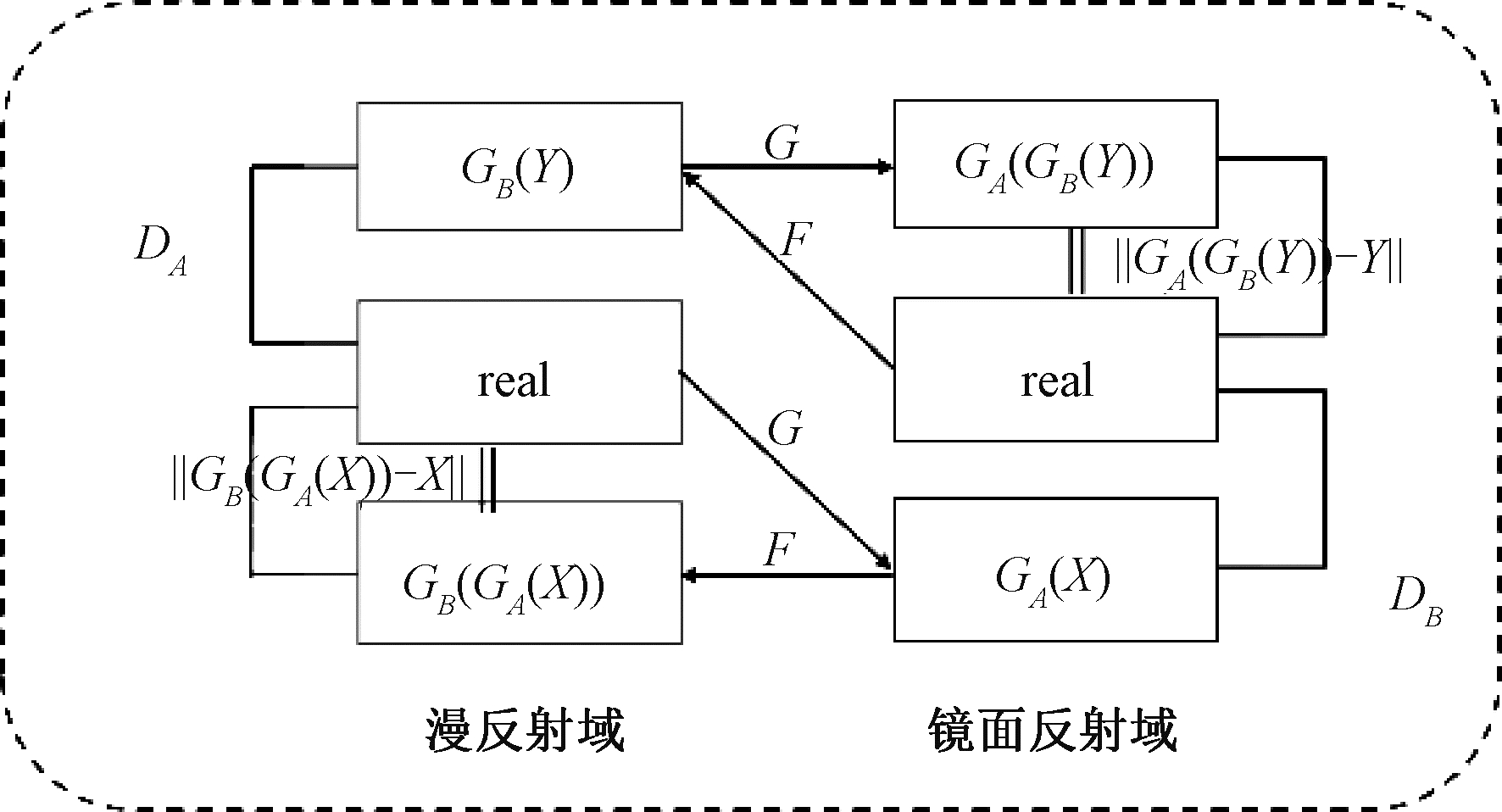

2.3 基于CycleGAN的无监督S2D-NET该算法核心为对偶学习生成对抗网络框架,拟采用该网络实现镜面反射域到漫反射域的转换。图 2为实现图像转换的框架图,有两个生成器和两个判别器。生成器GA和GB将镜面材质图像转换为漫反射材质图像。GA生成图像GA(X, Z)后,传递给GB,得到GB(GA(X, Z), Z′),即为原有镜面反射图片的一次重构,Z和Z′是噪声。接下来是对偶过程。将漫反射材质图像Y用生成器GB转换为镜面反射图GB(Y, Z);用生成器GA对生成镜面材质图进行转换,得到GA(GB(Y, Z), Z′)。生成器GA对应的判别器DA对漫反射材质的图像进行判断;而生成器GB对应的判别器DB对镜面材质的图像进行判断。

|

图 2 跨域对偶学习框架 Fig. 2 Cross-domain dual learning framework |

图像建模为

| $ I=(1-M) \odot B+R, $ | (5) |

| $ M(x)=\left\{\begin{array}{l} 1, \text { 高光 }, \\ 0, \text { 非高光 }, \end{array}\right. $ | (6) |

其中:M为二进制掩码;I为输入图像;B为背景纹理;R为高光区域;⊙表示逐像素点乘法。

损失函数为

| $ \begin{aligned} & \mathcal{L}_{\text {cyc }}=\left\|G_A\left(G_B\left(Y, Z^{\prime}\right), Z-Y\right)\right\|+ \\ & \left\|G_B\left(G_A(X, Z), Z^{\prime}-X\right)\right\|, \end{aligned} $ | (7) |

与S2D-NET[9]类似的对抗损失函数为

| $ \lambda_{\mathrm{adv}}=\mathcal{L}_{\mathrm{GAN}}\left(G_A, D_A\right)+\mathcal{L}_{\mathrm{GAN}}\left(G_B, D_B\right), $ | (8) |

最终对偶学习框架损失函数为

| $ \mathcal{L}=\lambda_{\text {adv }} \mathcal{L}_{\text {adv }}+\lambda_{\text {cyc }} \mathcal{L}_{\text {cyc }}, $ | (9) |

其中:λadv和λcyc为超参数,取值为10。

3 实验结果与分析在本实验中使用多幅不同视角的背景图合成背景场景,比整体效果理想,没有出现颜色偏差等问题。但在部分情况下,合成背景图片边缘处出现锯齿状白点,这可能是由于可微渲染器本身造成的。若背景较复杂或背景场景反光则合成效果较差,这是由于拍摄物体的位置不同,镜面反射会产生不同的反射结果,这导致数据集的明暗程度不同,进而生成的背景中会产生黑色阴影,如图 3中(d)所示,在减小镜面反射影响的前提下,最终生成的图片如图 3(b)所示。

|

图 3 可微分渲染器合成的背景图片 Fig. 3 Background picture synthesized by differentiable renderer |

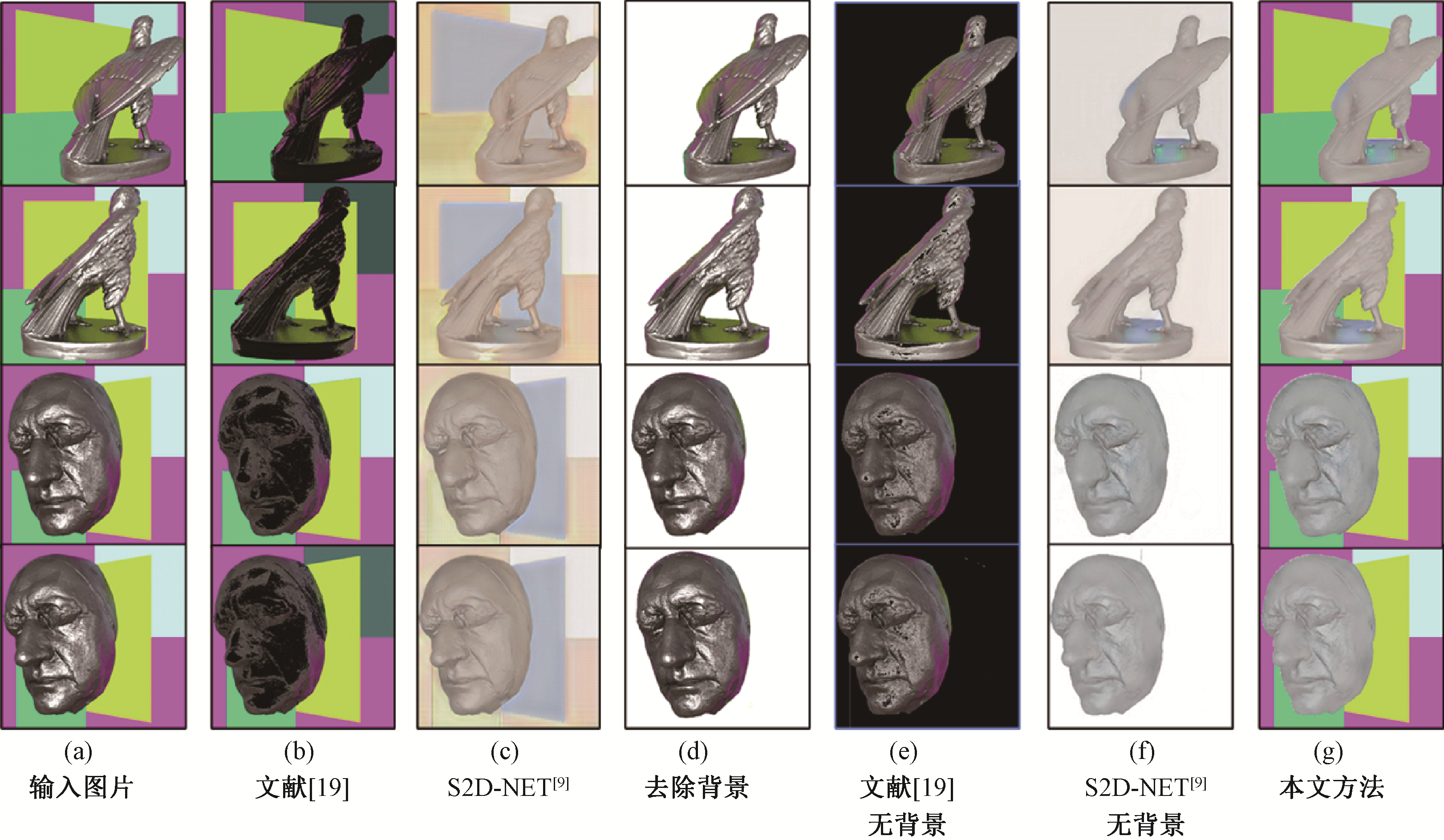

使用本文模型及对比算法分离图片前景、去除图片中的高光效果如图 4所示。图 4(a)为输入图片;图 4(b)是基于Souza等[19]提出的去高光算法生成图像;图 4(c)是基于CycleGAN网络生成的去除高光图像;图 4(d)为使用本文方法去除背景后的图片;图 4(e)、(f)除高光的方法与图 4(b)、(c)一致,但是将输入图片更换为去除背景的图片;图 4(g)为本文的方法。相比未去除背景的图片(c)而言,所生成的图像(f)、(g)在一定程度上更好地恢复了图像的细节和轮廓;相比传统方法(d)、(e)而言,图像(g)能够更好地恢复高光区域的纹理特征。

|

图 4 不同方法生成的图像 Fig. 4 The images generated by different methods |

峰值信噪比(peak signal to noise ratio, PSNR)是一种图像客观评价指标, 是基于误差敏感进行图像质量评价, 而不考虑人眼的视觉特性, 因而评价结果与人的主观感觉经常不一致。PSNR和MSE计算为

| $ \begin{gathered} P S N R=10 \lg \left(\frac{M A X^2}{M S E}\right), \\ M S E=\frac{1}{H \times W} \sum\limits_{i=1}^H \sum\limits_{j=1}^W(x(i, j)-y(i, j))^2, \end{gathered} $ |

其中:MSE为目标图像x与参考图像y间的均方误差;H、W为对应的像素总数;MAX代表像素的最大值。当MSE的值越小时,代表两个图像间的差别越小。

结构相似性度(structural similarity,SSIM)是图像质量评价指标,分别从亮度、对比度、结构三方面度量图像相似性, 计算为

| $ {SSIM}(x, y)=\frac{\left(2 \mu_x \mu_y+C_1\right)\left(2 \sigma_{x y}+C_2\right)}{\left(\mu_x^2+\mu_y^2+C_1\right)\left(\sigma_x^2+\sigma_y^2+C_2\right)}, $ |

其中:x和y代表两个给定图像的像素值;μx和μy分别代表x和y的平均值;σx2和σy2分别代表x和y的方差;σxy代表x和y的协方差;C1=(k1L)2是用来维持稳定的常数,L是像素值的动态范围;k1=0.01, k2=0.03。

本文采用PSNR和SSIM对实验结果进行评价,值越大,相似度越大。表 1展示了不同方法生成的去高光图像的SSIM和PSNR值。

|

|

表 1 不同方法生成的去高光图像的SSIM值和PSNR值 Tab. 1 The SSIM value and PSNR value of de-highlighted images generated by different methods |

从比较结果可以看出,所提方法的SSIM值和PSNR值都高于其他方法,即所提方法生成的图像优于其他方法。

4 结论为解决去除物体表面的高光时受图像背景影响较大的问题,基于可微渲染器,提出了一种分离图像前景与背景的方法。该方法使用可微分渲染器利用多幅图片生成背景场景,在同一视角下比对背景场景与真实图片进而生成蒙版,去除图片中的背景。实验证明在背景场景反射光强度不高的前提下,能较好地生成背景场景与前景图像。使用基于CycleGAN的神经网络去除前景图片中的高光,比其他方法能够更好地去除图像表面的高光。但是由于使用的是合成数据集,研究中没有考虑真实环境中光照环境复杂、物体位置标定可能存在误差等问题。另外,由于CycleGAN使用的合成数据集,在形状、反照率和材料等方面样本较少,若增大样本数量与种类,准确性将有大幅提高。

| [1] |

KIM S W, KOOK H K, SUN J Y, et al. Parallel feature pyramid network for object detection[C]//European Con ference on Computer Vision. Cham: Springer International Publishing, 2018: 239-256.

(  0) 0) |

| [2] |

BELL S, BALA K, SNAVELY N. Intrinsic images in the wild[J]. ACM transactions on graphics, 2014, 33(4): 159. (  0) 0) |

| [3] |

GAO J Y, ZHANG T Z, XU C S. Graph convolutional tracking[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2019: 4644-4654.

(  0) 0) |

| [4] |

ZHANG W M, ZHAO X, MORVAN J M, et al. Improving shadow suppression for illumination robust face recognition[J]. IEEE transactions on pattern analysis and machine intelligence, 2019, 41(3): 611-624. DOI:10.1109/TPAMI.2018.2803179 (  0) 0) |

| [5] |

KIM H, JIN H L, HADAP S, et al. Specular reflection separation using dark channel prior[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2013: 1460-1467.

(  0) 0) |

| [6] |

SUO J L, AN D S, JI X Y, et al. Fast and high quality highlight removal from a single image[J]. IEEE transactions on image processing, 2016, 25(11): 5441-5454. DOI:10.1109/TIP.2016.2605002 (  0) 0) |

| [7] |

YANG Q X, WANG S N, AHUJA N. Real-time specular highlight removal using bilateral filtering[C]//European Conference on Computer Vision. Berlin: Springer Press, 2010: 87-100.

(  0) 0) |

| [8] |

FU G, ZHANG Q, ZHU L, et al. A multi-task network for joint specular highlight detection and removal[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2021: 7748-7757.

(  0) 0) |

| [9] |

WU S H, HUANG H, PORTENIER T, et al. Specular-to-diffuse translation for multi-view reconstruction[C]//European Conference on Computer Vision. Cham: Springer International Publishing, 2018: 193-211.

(  0) 0) |

| [10] |

ZHU J Y, PARK T, ISOLA P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]//IEEE International Conference on Computer Vision. Piscataway: IEEE Press: 2242-2251.

(  0) 0) |

| [11] |

LI Y D, ZHAO W G, PAN J H. Deformable patterned fabric defect detection with fisher criterion-based deep learning[J]. IEEE transactions on automation science and engineering, 2017, 14(2): 1256-1264. DOI:10.1109/TASE.2016.2520955 (  0) 0) |

| [12] |

CABRAL R, DE LA TORRE F, COSTEIRA J P, et al. Matrix completion for weakly-supervised multi-label image classification[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(1): 121-135. DOI:10.1109/TPAMI.2014.2343234 (  0) 0) |

| [13] |

GEORGOULIS S, REMATAS K, RITSCHEL T, et al. Delight-net: decomposing reflectance maps into specular materials and natural illumination[EB/OL]. (2016-03-27)[2022-03-27]. https://arxiv.org/abs/1603.08240.

(  0) 0) |

| [14] |

MILDENHALL B, SRINIVASAN P P, TANCIK M, et al. Nerf: Representing scenes as neural radiance fields for view synthesis[J]. Communications of the ACM, 2021, 65(1): 99-106. (  0) 0) |

| [15] |

NGUYEN-PHUOC T, LI C, THEIS L, et al. HoloGAN: unsupervised learning of 3D representations from natural images[C]//IEEE International Conference on Computer Vision. Piscataway: IEEE Press, 2019: 7587-7596.

(  0) 0) |

| [16] |

KATO H, USHIKU Y, HARADA T. Neural 3D mesh renderer[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2018: 3907-3916.

(  0) 0) |

| [17] |

LIAO Y Y, SCHWARZ K, MESCHEDER L, et al. Towards unsupervised learning of generative models for 3D controllable image synthesis[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 5870-5879.

(  0) 0) |

| [18] |

MIYATO T, KATAOKA T, KOYAMA M, et al. Spectral normalization for generative adversarial networks[EB/OL]. (2018-02-16)[2022-03-20]. https://arxiv.org/abs/1802.05957.

(  0) 0) |

| [19] |

SOUZA A C S, MACEDO M C F, NASCIMENTO V P, et al. Real-time high-quality specular highlight removal using efficient pixel clustering[C]//The 31st SIBGRAPI Conference on Graphics, Patterns and Images. Piscataway: IEEE Press, 2018: 56-63.

(  0) 0) |

2023, Vol. 55

2023, Vol. 55