2. 烟台大学 计算机与控制工程学院 山东 烟台 264005;

3. 河南理工大学 计算机科学与技术学院 河南 焦作 464000

2. Department of Computer and Control Engineering, Yantai University, Yantai 264005, China;

3. Department of Computer Science and Technology, Henan Polytechnic University, Jiaozuo 464000, China

近年来,随着服务计算、云计算、移动边缘计算等新型计算模式的快速发展与成熟,网络上出现了大量来自不同领域的可用服务。与此同时,随着移动网络与智能终端的广泛普及,使得大规模用户可以随时随地访问服务,极大方便了用户的生活和工作。然而,如何从海量的候选服务中发现用户需要的服务具有一定挑战性,为了解决这一问题,大量的研究工作针对服务推荐[1-3]展开,并取得了丰富的研究成果,在一定程度上解决了服务发现的难题。然而,已有的服务推荐方法大都通过挖掘相似用户或相似服务之间的信息,为用户推荐其感兴趣的、可能会使用的服务,并没有考虑用户的实际服务需求。

服务需求预测是提高服务推荐准确率的重要基础。已有服务需求预测方法主要包括基于协同过滤(collaborative filtering, CF)[4-7]、基于机器学习(machine learning, ML)[8-11]以及基于深度学习(deep learning, DL)[12-14]技术的预测方法。尽管已有的服务需求预测研究在一定程度上提高了服务推荐的准确度, 然而已有的研究工作大都是基于单一模态数据开展的,没有考虑多模态数据下的服务需求预测[15]。

随着移动网络与智能终端的快速发展,在服务使用过程中产生了大量的文本数据、图片数据等多模态数据。多模态数据中蕴藏着更加丰富的服务使用信息,通过对多模态数据的挖掘学习,有助于提高服务需求预测的精度。为此,本文考虑了与服务使用相关的文本数据与图片数据,提出了一种基于软注意力机制与多模态机器学习(soft attention and multimodal machine learning,SAMML)的服务需求预测方法。该方法分别采用Doc2Vec[16]模型对文本数据进行处理并提取特征向量、使用ResNet[17]模型提取图像数据特征向量,通过特征共享模块,将所提取的特征向量进行融合;通过引入软注意力机制,对不同服务的共享特征向量进行权重分配,增强服务数据之间的关联性,基于GRU网络对经过权重分配的共享向量进行学习,获取用户对服务使用的兴趣;根据用户特征信息、服务文本特征向量及服务图像特征向量训练SAMML模型,并使用训练好的模型进行服务需求预测。本文使用大量真实的数据集进行了实验验证,并且与目前具有代表性的机器学习方法进行了比较,证明了本文所提方法的可行性与有效性。

1 相关工作近年来,为了准确预测用户的服务需求,进而在合适的场景为用户推荐高质量的服务,国内外学者展开了用户服务需求预测研究。Guo等[18]提出了一种用于短期出行需求预测的残差时空网络,能够捕捉出行需求的空间、时间及出行需求之间的依赖关系,在出行需求预测方面具有更好的预测效果。Liu等[19]提出了一种基于注意力机制的深度集成网络模型,分别对特征地图的通道间关系、空间关系和位置关系进行建模并预测用户的服务需求。Zheng等[20]针对时空需求预测和竞争性供应问题,提出了一种同时考虑时空预测和供需状态的需求感知路径规划算法,并构建了一种时空图卷积顺序预测模型,该模型能够通过位置和时间预测用户服务请求,帮助服务提供商预先分配服务起点,以减少客户的等待时间。Chu等[21]提出了一种多尺度卷积长短期记忆网络模型,该模型可以同时考虑时间和空间的相关性来预测用户未来的需求。

Lu等[22]针对现有的服务需求预测缺少考虑用户在移动中的隐私问题,提出了一种结合隐私关注强度的用户协同过滤方法,并考虑了关于用户隐私的相关因素进行服务需求预测。Gardino等[23]利用多视角的方法来学习视图之间的联系,以此解决行业间零售商与批发商之间的需求预测问题。Law等[24]利用深度学习方法缓解人工网络模型带来的复杂度,将旅游搜索强度作为唯一输入指标,为旅游业务人员提供了游客与目的地之间的需求预测。Xu等[25]将历史需水量作为数据信息,对城市供水系统提供有效的需水量预测。

上述工作大都基于单模态数据进行需求预测研究,没有考虑利用多模态数据进行需求预测。本文考虑了用户服务应用过程中产生的多模态数据,基于软注意力机制与多模态机器学习模型提出了一种服务需求预测方法。

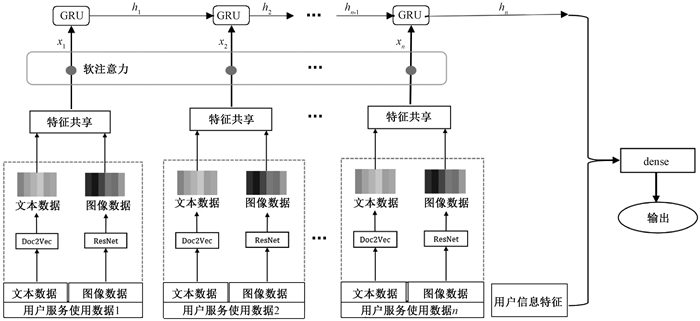

2 基于SAMML的服务需求预测方法 2.1 SAMML模型SAMML模型由多模态数据特征共享模块、服务兴趣提取模块和服务需求预测模块组成,SAMML模块结构如图 1所示。

|

图 1 基于软注意力机制与多模态机器学习模型 Fig. 1 Machine learning model based on soft attention and multi-model |

在SAMML模型中,首先基于Doc2Vec模型和ResNet模型分别从用户服务信息的文本数据和图像数据提取特征向量, 并通过特征共享模块对所提取的特征向量进行融合;然后针对用户不同的服务使用数据,利用软注意力机制进行权重学习;再基于GRU网络处理所得到的特征数据,学习用户服务应用表达向量;最后基于用户特征和服务特征向量训练SAMML模型,并实现用户的服务需求预测。

2.2 多模态数据特征模块对于服务需求预测问题,设训练数据集为T=[(X1, Y1), (X2, Y2), …, (Xm, Ym), …, (Xn, Yn)],其中:n为训练数据集的数据规模; Xm=[Xum, Xsm] 表示第m项的训练数据;Ym表示用户在Xm时对应的服务需求;Xum=[Xu(1), …, Xu(i)]为用户特征,包括用户的性别、年龄等;Xsm=[Xs(1), …, Xs(k), …, Xs(j)]表示服务特征信息。每一个服务特征信息包括与服务应用相关的文本数据与图像数据,Xs(k)=[Xst(k), Xsg(k)],k∈[1, j]表示k服务项的特征数据; Xst(k)表示k服务项的文本数据特征; Xsg(k)表示k服务项的图像数据特征。

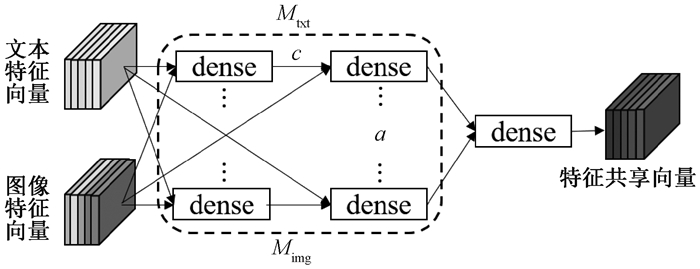

为了实现不同模态数据特征的有效融合,采用前期研究工作中所提出的特征共享机制[25],实现多模态数据特征之间的关联,进而提升服务需求预测的准确度。在SAMML模型中,特征融合是由文本特征网络Mtxt和图像特征网络Mimg组成,并且Mtxt和Mimg由全连接网络构成。以用户的服务项k为例,将服务项k的文本特征序列Xst(k)和图像特征序列Xsg(k)分别输入Mtxt和Mimg网络;将文本特征Xst(k)与图像特征网络Mimg中每层dense的输出Pimg进行逻辑相加,将图像特征Xsg(k)与文本特征网络Mtxt中每层dense的输出Ptxt进行逻辑相加。共享模块的网络结构如图 2所示。

|

图 2 多模态特征融合结构图 Fig. 2 Multi-model feature fusion structure diagram |

设定特征共享模块的输入层的节点数为a,层数为c,特征向量在经过第l层时,输出文本特征网络Ptxtl=[Ptxt1l, …, Ptxtal],图像特征网络Pimgl=[Pimg1l, …, Pimgal],l∈[1, c]。在经过第l层的操作后,以Mtxt网络传输为例,特征融合公式为

| $ \boldsymbol{E}_{\mathrm{txt}}^{l-1}=\left[\left(P_{\mathrm{txt1}}^{l-1}+X_{\mathrm{sg}}^{(1)}\right), \cdots,\left(P_{\mathrm{txt}m}^{l-1}+X_{\mathrm{sg}}^{(a)}\right)\right], $ | (1) |

| $ \boldsymbol{P}_{\mathrm{txt}}^l=\sigma\left(\boldsymbol{W}_{\mathrm{txt}}^l \cdot E_{\mathrm{txt}}^l+b_{\mathrm{txt}}^l\right), $ | (2) |

其中:Etxtl-1为Mtxt中经过l-1层特征共享后的文本特征向量;σ表示Mtxt中第l层的激活函数ReLu;Wtxtl表示Mtxt中第l层的权重矩阵向量;btxtl表示Mtxt中第l层的偏置值;Mtxt为网络结构的解释说明。

将特征共享向量Ptxtl和Pimgl经过一层全连接网络,输出用户服务的特征共享表达向量组Fs, Fsk的计算为

| $ \boldsymbol{F} \boldsymbol{s}^k=\sigma\left(\boldsymbol{W}_1\left[\boldsymbol{P}_{\mathrm{txt}}^l \oplus \boldsymbol{P}_{\mathrm{txt}}^l\right]+b\right), $ | (3) |

其中:W1表示权重矩阵;$\oplus $表示向量拼接操作;b表示偏置值;Fsk表示向量组内的第k组向量。

2.3 基于软注意力机制的特征权重获取模块注意力机制分为硬注意力和软注意力两种。硬注意力机制(hard attention, HA)针对信息选择时,选取的是概率最高的一项信息,其余信息均被忽略,在模型中预测效果偏向单面性。软注意力(soft attention, SA)机制[27-28]通过选择性地忽略部分信息来对其余信息进行重新加权聚合计算,所有信息在被聚合之前会以自适应的方式进行重新加权,这样可以分离重要信息,并避免这些信息受到不重要信息的干扰,从而提高准确性。本文选择SA机制获取特征信息的权重,保证在训练模型过程中学习特征向量,从而增强表达向量的关联性;在得到多样化的服务兴趣表达向量之后,让模型在学习的过程中,通过用户使用服务序列,调整用户多样化的服务兴趣对用户服务需求的影响权重值;然后,将权重和用户多样化的服务兴趣表达向量相乘,并输入GRU网络中,动态建模用户多样化服务兴趣的变化过程。SAMML模型以特征共享向量Fs作为软注意力机制的输入,根据下列操作最终计算不同服务特征向量的加权平均,直观分析不同服务向量之间的占比率。基于SA的权重获取步骤如下。

1) 初始化。注意力变量z表示需要查询的索引值,z∈[1, N];N表示用户服务特征总量;当z=k时,表明选择第k项特征共享向量Fsk。

2) 在确定了查询向量q和特征共享向量Fsk之后,对q与Fsk相似度进行计算比较,依据公式(4)计算第k项的特征共享向量的概率αk,并进行归一化调整,

| $ \alpha_k=\operatorname{softmax}\left(S^k\right)=\frac{\exp \left(S^k\right)}{\sum\limits_{k=1}^N \exp \left(S^k\right)} 。$ | (4) |

3) 进行加权平均。在注意力分布αk查询Fs中的第k项的特征共享信息与q的关联程度,得到软注意力的值,如公式(5)所示,

| $ {att}(\boldsymbol{F} \boldsymbol{s}, q)=\sum\limits_{k=1}^N \alpha_k \boldsymbol{F} \boldsymbol{s}^k, $ | (5) |

其中:αk的概率向量表示注意力分布。

4) 在计算出不同特征共享信息关联度之后,分别针对不同的特征共享信息进行处理,并将输出作为结果,依次输入GRU网络,进行下一步操作。

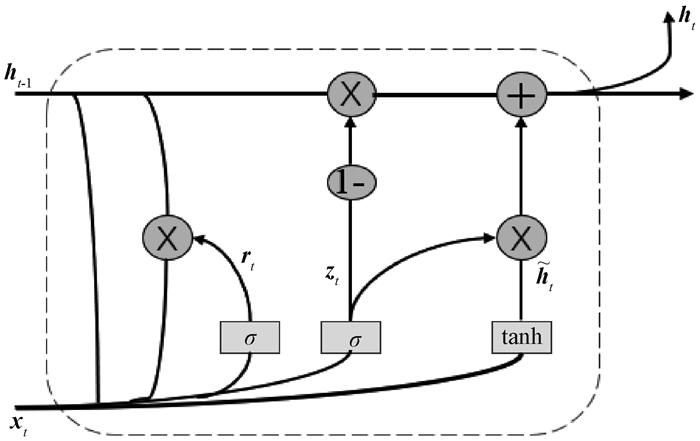

2.4 基于GRU的服务兴趣提取模块近年来,GRU(gate recurrent unit)神经网络[29-30]在NLP以及时序数据处理方面得到了广泛的应用[31-34]。GRU网络具有结构简单、计算速度快等优点。为此,本文使用GRU网络对服务特征共享向量进行学习,提取用户服务的兴趣。GRU网络的结构如图 3所示。其中,zt和rt分别表示更新门和重置门。更新门用来控制上一刻的服务状态信息被保留在当前状态中的程度,zt的值越大说明上一刻服务信息留在当前状态的越多;重置门的作用是控制上一刻的服务信息有多少被写入当前候选集h ~ t内,rt的值越小,被写入的信息量越少。经过SA机制处理后的数据作为GRU网络的输入。

|

图 3 GRU神经元结构 Fig. 3 GRU neuron structure |

服务特征共享信息在GRU网络中处理过程如下。

1) 根据当前状态xt与上一刻的隐藏状态ht-1经过zt输出[0, 1]之间的单位值,具体为

| $ \boldsymbol{z}_t=\operatorname{sigmoid}\left(\boldsymbol{W}^u \cdot \mathrm{e}_s^t+\boldsymbol{U}^u \cdot \boldsymbol{h}_{t-1}+b^u\right) 。$ | (6) |

2) 根据xt与上一刻的隐藏状态ht-1,经过rt输出[0, 1]之间的单位值,同时,函数tanh创建此刻候选值向量

| $ \boldsymbol{r}_t=\operatorname{sigmoid}\left(\boldsymbol{W}^r \cdot \mathrm{e}_s^t+\boldsymbol{U}^r \cdot \boldsymbol{h}_{t-1}+b^r\right), $ | (7) |

| $ \tilde{\boldsymbol{h}}_t=\tanh \left(\boldsymbol{W}^h \cdot \mathrm{e}_s^t+\boldsymbol{r}_t \cdot \boldsymbol{U}^h \cdot \boldsymbol{h}_{t-1}+b^h\right) 。$ | (8) |

3) 由zt作为权重,候选向量与前一时刻输出向量通过加权平均得到GRU网络的输出ht,

| $ \boldsymbol{h}_t=\left(1-\boldsymbol{z}_t\right) \cdot \boldsymbol{h}_{t-1}+\boldsymbol{z}_t \cdot \tilde{\boldsymbol{h}}_t, $ | (9) |

其中:xt为时刻t状态的输入(时刻t为第k项服务序列经过SA处理后的输入);ht-1为上一时刻隐含层的状态函数;rt为重置门的输出,经过sigmoid函数将结果映射到0~1之间,越接近1信息越容易被保留;zt为更新门的输出,经过sigmoid函数将结果映射到0~1之间;$\tilde{\boldsymbol{h}}_t$表示t时刻的候选激活状态,由新输入xt前状态ht-1和权重Wh计算更新其值; ht为t时刻的激活状态,表示GRU网络中第t个隐藏状态向量,根据新的zt前一时刻的状态ht-1和

GRU网络能够对用户每一时刻所使用的服务,以及过去时刻使用的服务对当前时刻使用服务的影响都进行学习,将学习结果储存在每一时刻的隐藏状态向量中,并在每一时刻输出一个隐藏状态向量来表示学习的服务兴趣信息,使得GRU网络中每一时刻的隐藏状态向量ht能够表示用户该时刻的服务使用兴趣。为了提高GRU对服务使用兴趣的提取效果,本文对GRU网络引入一个辅助损失函数Llf,用来计算GRU每个时刻的隐藏状态和下个时刻服务特征融合向量之间的差距,

| $ L_{\mathrm{lf}}=\frac{1}{n} \sum\limits_{i=1}^n\left|\mathrm{e}_s^{t+1}-\boldsymbol{h}_t\right|。$ | (10) |

在获取服务兴趣特征表达向量ht之后,基于用户的服务兴趣特征表达向量ht和用户特征向量,预测用户下一刻的服务需求。在对服务需求预测模块进行训练时,定义输入数据为Ii=[Xui, hti, yi],其中:Xui表示用户特征向量;hti表示用户i最终的服务兴趣表达向量;yi表示模型的值,表示用户下一时刻的服务需求。服务需求预测模块的预测函数为

| $ \hat{y}_i=\sigma\left(\boldsymbol{W} \cdot \boldsymbol{I}_i+b\right), $ | (11) |

其中:W表示权重矩阵;Ii表示输入数据。

在SAMML模型中,根据用户使用的服务序列,基于多模态机器学习预测用户下一时刻的服务需求问题,属于机器学习中的回归问题。对于机器学习中的回归问题,常用的损失函数为平方绝对误差(MAE),MAE指服务需求预测模型的预测值

| $ M A E=L_{\mathrm{tag}}=\frac{1}{n} \sum\limits_{i=1}^n\left|y_i-\hat{y}_i\right|。$ | (12) |

SAMML模型总的损失函数L主要由服务需求预测的损失函数Ltag和辅助损失函数Llf两部分组成。Ltag和Llf均采用MAE损失函数,只是MAE的输入部分不同。总的损失函数L的计算为

| $ L=L_{\mathrm{tag}}+\Delta \alpha * L_{\mathrm{lf}}, $ | (13) |

其中:Δα表示超参数,用于平衡用户服务兴趣的表达和模型的预测。本文采用Adma优化算法,基于SAMML模型的服务需求预测方法的算法主要步骤如下。

输入:数据。输出:用户的服务需求。

1) 模型初始化参数。

2) FOR i TO N DO。

3) 输入训练数据项(Xi, Yi)。

4) 根据公式(1),实现文本特征学习网络Mtxt第l-1(1≤l≤c)层的输出Ptxtl-1与图片特征向量Xsg(k)的特征共享操作。

5) 根据公式(2)获取文本特征学习网络Mtxt第l-1(1≤l≤c)层的输出Ptxtl。

6) 重复4)~5),将图片特征与文本特征融合,并获取图片的第l-1(1≤l≤c)层的输出Pimgl。

7) 根据公式(3),获取用户的使用服务表达向量Fsk。

8) 根据公式(4),计算软注意力机制针对Fsk的打分函数,并获取服务向量的注意力分布。

9) 根据公式(5),对Fsk进行加权平均,获取不同服务之间的关联程度。

10) 根据公式(6)~(7),输出GRU网络的更新门和输出门。

11) 根据公式(8)~(9),计算用户使用服务的表达向量ht。

12) 根据公式(10)~(12)、(13)计算辅助函数值、损失函数值、预测函数值以及总损失。

13) 更新SAMML模型参数。

14) END FOR。

15) UNTIL。

16) 根据数据Ii输入并运行SAMML模型。

3 实验 3.1 实验环境与实验数据为了验证所提方法的有效性,本文采用阿里云-天池提供的Debiasing数据集(https://tianchi.aliyun.com/competition/entrance/231785/information) 对本文所提方法进行实验验证,数据文件以CSV格式存储,编码格式为UTF-8。数据内容是根据真实的用户服务数据处理并包含一百多万条的记录信息,主要包括用户特征、商品特征以及标签,这里将商品映射为服务。

实验环境为:操作系统Windows10专业版64位,CPU Intel i7 5500U,RAM 4+4 GB;使用Python与TensorFlow 2.0实现SAMML模型。本文采用平方绝对误差(MAE)、均方误差(MSE)、均方根误差(RMSE)和R2指标来评估SAMML的性能,计算公式为

| $ M S E=\frac{1}{n} \sum\limits_{i=1}^n\left(y_i-\hat{y}_i\right)^2, $ |

| $ R M S E=\sqrt{\frac{1}{n} \sum\limits_{i=1}^n\left(y_i-\hat{y}_i\right)^2}, $ |

| $ R^2=1-\frac{\sum\limits_{i=1}^n\left(y_i-\hat{y}_i\right)^2}{\sum\limits_{i=1}^n\left(y_i-\bar{y}_i\right)^2} 。$ |

MAE、MSE和RMSE的值越小,表示模型的预测精度越高,R2的值越大表明服务需求预测模型的预测精度越高。

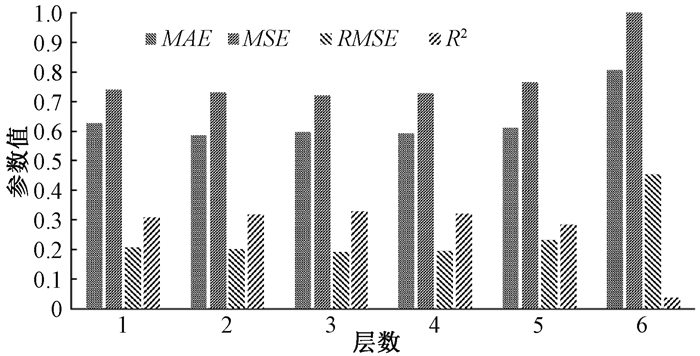

3.2 模型参数设置SAMML模型中,特征共享的目的是为了将两种模态的数据特征向量融合,提高对用户与服务的关联性以及表达能力。该模块的网络层数M对模型精度具有一定影响,为了能使SAMML模型具有较好的预测能力,本实验先通过设置不同的网络层数进行实验, 来观察MAE、MSE、RMSE、R2的变化,并将评估指标差别放大化,确定特征共享模块中网络层数的最佳值。实验结果如图 4所示。从图 4可以看出差异化后的评估指标,增加层数有助于提高SAMML模型的预测精度,随着网络层数的增加,模型的精度呈现正态分布趋势。

|

图 4 不同网络层数对模型预测结果影响 Fig. 4 The effect of different network layers on model prediction result |

然而,再增加特征共享模块网络层数时,需要学习更多参数,占用更长的训练时间,增加过拟合的风险。根据实验结果,在网络层数为3时,各项指标相对最优且稳定,因此,本文确定特征共享模块的网络层数为3。在SAMML模型中,特征共享模块内每层网络的神经元节点数目对模型预测也具有一定的影响,为了使服务需求预测模型具有较高的预测精度,在SAMML模型中,分别设置特征共享模块内每层网络的神经元节点数为16、32、64、128、256。通过实验来确定神经元节点最佳取值,实验结果如表 1所示。

|

|

表 1 特征共享模块中神经元节点数对SAMML模型的影响 Tab. 1 The influence of neuron nodes on SAMML model in feature sharing module |

从表 1可以看出,当神经元节点数为16和64时,评估指标MAE、MSE、RMSE、R2的值相对最优。每层网络的神经元节点数量过低容易导致数据的拟合不足,过多则会增加模型过拟合的风险。根据实验结果综合比较,本文将SAMML模型的特征共享模块每层网络节点数量设置为64。

在SAMML模型中,采用Adam算法对模型的参数进行调优。为了使得模型具有较强的预测能力,设置学习率为1e-2、1e-3、1e-4、1e-5训练模型。

当学习率为1e-4时,使用100个epoch时已经显示出拟合。随着在训练集上epoch的增加,测试集的损失值没有降低。当学习率为1e-5、1e-2、1e-3时,曲线拟合效果较差。综合分析,本文将学习率定为1e-4,即epoch为100。

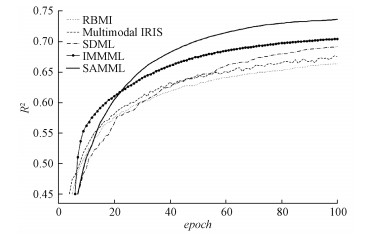

3.3 模型性能比较为了验证本文所提出的预测模型的性能,鉴于多模态特性选取实验对比模型,需要同时具有图像和文本数据的处理功能,单模态模型无法满足。依据数据特征,通过对文本、图像数据的多模态处理原则,本文选取了四种基于多模态机器学习的预测模型与本文所提出的方法进行比较。四种典型的预测模型分别为:RBMI[35]、Multimodal IRIS[36]、SDML[37]和IMMML[26]。该实验使用数据集的80%作为模型的训练数据,使用数据集的20%作为模型的测试数据。依据评估指标来评测每一个模型的性能,实验结果如表 2所示。

|

|

表 2 不同模型在数据集上的性能评估 Tab. 2 Evaluation of different models on the data set |

从表 2可以看出,SAMML模型在评估指标MAE、MSE、RMSE和R2上均优于其他对比模型。在评估指标R2上,SAMML模型比次优结果高0.031 0;在指标MAE、MSE和RMSE上,分别领先于次优结果0.021 8、0.026 3和0.027 3。对比结果显示,SAMML模型通过引入软注意力机制,降低了多模态之间的特征向量表达差异,提升了用户服务需求的预测精度。

为了能够直观地验证不同模型的收敛性能,分别针对不同模型进行训练测试对比,将确定的最佳参数值统一调整不变。得出实验性能对比结果如图 5所示。

|

图 5 不同模型实验性能对比结果 Fig. 5 Performance comparison results of different models |

随着迭代次数增加,不同模型的收敛性不断增加并且逐渐稳定,其中RBMI模型的表现相对较差,SAMML模型表现最好。根据实验结果得出,SAMML模型的学习能力较强,在有限的迭代次数内能够获得相对较高的预测精度,且随着迭代次数减少计算量。

3.4 不同功能模块对SAMML模型性能比较为了验证SAMML模型内部不同的功能模块对模型本身预测精度的影响,在实验中使用不同功能模块与SAMML模型实验结果进行对比,通过实验结果验证不同模块功能的必要性。其中,NoAttention模型表示SAMML模型去除软注意力机制模块,直接将融合的特征向量输入GRU网络中;NoshareFeat模型表示SAMML模型去除特征共享融合模块,直接将不同模态的两种特征向量分别进行软注意力机制模块处理。实验结果如图 6所示。

|

图 6 模型缺少不同模块的实验结果对比 Fig. 6 Comparison of experimental results of models lacking different modules |

从图 6中可以看出,SAMML在缺少特征共享模块NoShareFeat和缺少软注意力机制模块NoShareFeat时的MAE值均大于SAMML模型。结合上述实验结果,使用特征共享模块和软注意力机制模块既有助于提高SAMML模型的预测精度,也说明了本文提出模型的有效性。

4 结束语为了更好地预测用户的服务需求,本文提出了一种多模态数据驱动的服务需求预测方法。该方法首先通过特征共享模块将用户服务的多维服务特征进行融合,增强用户服务的关联性;然后引入SA机制,从而使模型能够动态改变权重,以此来改变对用户服务需求的影响;最后,依据用户信息和服务的多模态特征表达向量,通过全连接网络预测用户的服务需求。使用真实数据集进行实验测试,通过与其他典型的多模态模型相比,验证了本文所提出方法的优越性。在后续的研究中,将继续分析不同模态、不同注意力机制对服务需求预测的影响,挖掘不同模态对于用户服务需求的影响规律,进而进一步提高模型的预测精度。

| [1] |

PHANKOKKRUAD M, WACHARAWICHANANT S. A comparison of extreme gradient boosting and convolutional neural network-long short-term memory for service demand forecasting[C]//The International Conference on Natural Computation, Fuzzy Systems and Knowledge Discovery. Berlin: Springer Press, 2019: 547-556.

(  0) 0) |

| [2] |

郝旭政, 柴争义. 一种改进的深度残差网络行人检测方法[J]. 计算机应用研究, 2019, 36(5): 1569-1572. HAO X Z, CHAI Z Y. Improved pedestrian detection method based on depth residual network[J]. Application research of computers, 2019, 36(5): 1569-1572. (  0) 0) |

| [3] |

张冬雯, 赵琪, 许云峰, 等. 基于长短期记忆神经网络模型的空气质量预测[J]. 河北科技大学学报, 2020, 41(1): 67-75. ZHANG D W, ZHAO Q, XU Y F, et al. Air quality prediction based on neural network model of long short-term memory[J]. Journal of Hebei university of science and technology, 2020, 41(1): 67-75. (  0) 0) |

| [4] |

SU X Y, KHOSHGOFTAAR T M. A survey of collaborative filtering techniques[J]. Advances in artificial intelligence, 2009, 2009: 421425. (  0) 0) |

| [5] |

KUANG L, YAN X J, TAN X H, et al. Predicting taxi demand based on 3D convolutional neural network and multi-task learning[J]. Remote sensing, 2019, 11(11): 1265. DOI:10.3390/rs11111265 (  0) 0) |

| [6] |

HU J, LAI Y L, PENG A, et al. Proactive content delivery with service-tier awareness and user demand prediction[J]. Electronics, 2019, 8(1): 50. DOI:10.3390/electronics8010050 (  0) 0) |

| [7] |

张星, 刘帅. 感知用户的Item-based协同过滤算法[J]. 信阳师范学院学报(自然科学版), 2017, 30(1): 125-128. ZHANG X, LIU S. User-aware item-based collaborative filtering algorithm[J]. Journal of Xinyang normal university (natural sicence edition), 2017, 30(1): 125-128. (  0) 0) |

| [8] |

XUE P N, JIANG Y, ZHOU Z G, et al. Multi-step ahead forecasting of heat load in district heating systems using machine learning algorithms[J]. Energy, 2019, 188: 116085. DOI:10.1016/j.energy.2019.116085 (  0) 0) |

| [9] |

LI Z H, FAN Y Y, JIANG B, et al. A survey on sentiment analysis and opinion mining for social multimedia[J]. Multimedia tools and applications, 2019, 78(6): 6939-6967. DOI:10.1007/s11042-018-6445-z (  0) 0) |

| [10] |

LI Y C, ISHI C T, WARD N, et al. Emotion recognition by combining prosody and sentiment analysis for expressing reactive emotion by humanoid robot[C]//Asia-Pacific Signal and Information Processing Association Annual Summit and Conference. Piscataway: IEEE Press, 2017: 1356-1359.

(  0) 0) |

| [11] |

SEMWAL N, KUMAR A, NARAYANAN S. Automatic speech emotion detection system using multi-domain acoustic feature selection and classification models[C]//IEEE International Conference on Identity, Security and Behavior Analysis. Piscataway: IEEE Press, 2017: 1-6.

(  0) 0) |

| [12] |

WANG Y Z, ZHANG N Q, CHEN X. A short-term residential load forecasting model based on LSTM recurrent neural network considering weather features[J]. Energies, 2021, 14(10): 2737. DOI:10.3390/en14102737 (  0) 0) |

| [13] |

MOU L C, BRUZZONE L, ZHU X X. Learning spectral-spatial-temporal features via a recurrent convolutional neural network for change detection in multispectral imagery[J]. IEEE transactions on geoscience and remote sensing, 2019, 57(2): 924-935. DOI:10.1109/TGRS.2018.2863224 (  0) 0) |

| [14] |

PAN Y, ZHENG R C, ZHANG J X, et al. Predicting bike sharing demand using recurrent neural networks[J]. Procedia computer science, 2019, 147: 562-566. DOI:10.1016/j.procs.2019.01.217 (  0) 0) |

| [15] |

FANG C H, LU Q Y. Personalized recommendation model of high-quality education resources for college students based on datamining[J]. Complexity, 2021, 2021: 9935973. (  0) 0) |

| [16] |

LAU J H, BALDWIN T. An empirical evaluation of doc2vec with practical insights into document embedding generation[C]//Proceedings of the 1st Workshop on Representation Learning for NLP. Stroudsburg: Association for Computational Linguistics, 2016: 78-86.

(  0) 0) |

| [17] |

HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2016: 770-778.

(  0) 0) |

| [18] |

GUO G, ZHANG T Q. A residual spatio-temporal architecture for travel demand forecasting[J]. Transportation research part C: emerging technologies, 2020, 115: 102639. DOI:10.1016/j.trc.2020.102639 (  0) 0) |

| [19] |

LIU Y, LIU Z Y, LYU C, et al. Attention-based deep ensemble net for large-scale online taxi-hailing demand prediction[J]. IEEE transactions on intelligent transportation systems, 2020, 21(11): 4798-4807. DOI:10.1109/TITS.2019.2947145 (  0) 0) |

| [20] |

ZHENG B, HU Q, MING L, et al. Spatial-temporal demand forecasting and competitive supply via graph convolutional networks[EB/OL]. [2021-01-18]. https://arxiv.org/abs/2009.12157.

(  0) 0) |

| [21] |

CHU K F, LAM A Y S, LI V O K. Deep multi-scale convolutional LSTM network for travel demand and origin-destination predictions[J]. IEEE transactions on intelligent transportation systems, 2020, 21(8): 3219-3232. DOI:10.1109/TITS.2019.2924971 (  0) 0) |

| [22] |

ZHANG R Y, LU Q B, GUO F P. User-based collaborative filtering recommendation method combining with privacy concerns intensity in mobile commerce[J]. International journal of wireless and mobile computing, 2019, 17(1): 63. DOI:10.1504/IJWMC.2019.10022319 (  0) 0) |

| [23] |

GARDINO G B, MEO R, CRAPAROTTA G. Multi-view latent learning applied to fashion industry[J]. Information systems frontiers, 2021, 23(1): 53-69. (  0) 0) |

| [24] |

LAW R, LI G, FONG D K C, et al. Tourism demand forecasting: a deep learning approach[J]. Annals of tourism research, 2019, 75: 410-423. (  0) 0) |

| [25] |

XU Y B, ZHANG J, LONG Z Q, et al. Hourly urban water demand forecasting using the continuous deep belief echo state network[J]. Water, 2019, 11(2): 351. (  0) 0) |

| [26] |

丰凯. 大数据环境下服务需求动态感知方法研究[D]. 焦作: 河南理工大学, 2021. FENG K. Research on dynamic service demand awareness method in big data environment[D]. Jiaozuo: Henan Polytechnic University, 2021. (  0) 0) |

| [27] |

SHEN T, ZHOU T Y, LONG G D, et al. Reinforced self-attention network: a hybrid of hard and soft attention for sequence modeling[EB/OL]. [2021-11-31]. https://arxiv.org/abs/1801.10296.

(  0) 0) |

| [28] |

SON L H, KUMAR A, SANGWAN S R, et al. Sarcasm detection using soft attention-based bidirectional long short-term memory model with convolution network[J]. IEEE access, 2019, 7: 23319-23328. (  0) 0) |

| [29] |

CHO K, VAN MERRIENBOER B, GULCEHRE C, et al. Learning phrase representations using RNN encoder-decoder for statistical machinetranslation[C]//Conference on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2014: 1724-1734.

(  0) 0) |

| [30] |

SHIHAB M S H, ADITYA S, SETU J H, et al. A hybrid GRU-CNN feature extraction technique for speaker identification[C]//The 23rd International Conference on Computer and Information Technology. Piscataway, IEEE Press, 2020: 1-6.

(  0) 0) |

| [31] |

朱乔木, 李弘毅, 王子琪, 等. 基于长短期记忆网络的风电场发电功率超短期预测[J]. 电网技术, 2017, 41(12): 3797-3802. ZHU Q M, LI H Y, WANG Z Q, et al. Short-term wind power forecasting based on LSTM[J]. Power system technology, 2017, 41(12): 3797-3802. (  0) 0) |

| [32] |

殷兆凯, 廖卫红, 王若佳, 等. 基于长短时记忆神经网络(LSTM)的降雨径流模拟及预报[J]. 南水北调与水利科技, 2019, 17(6): 1-9. YIN Z K, LIAO W H, WANG R J, et al. Rainfall-runoff modelling and forecasting based on long short-term memory (LSTM)[J]. South-to-northwater transfers and water science & technology, 2019, 17(6): 1-9. (  0) 0) |

| [33] |

王增平, 赵兵, 纪维佳, 等. 基于GRU-NN模型的短期负荷预测方法[J]. 电力系统自动化, 2019, 43(5): 53-58. WANG Z P, ZHAO B, JI W J, et al. Short-term load forecasting method based on GRU-NN model[J]. Automation of electric power systems, 2019, 43(5): 53-58. (  0) 0) |

| [34] |

JUNG S, MOON J, PARK S, et al. An attention-based multilayer GRU model for multistep-ahead short-term load forecasting[J]. Sensors, 2021, 21(5): 1639. (  0) 0) |

| [35] |

CAI G Y, CHEN N N. Recommendation based on multimodal information of user-item interactions[C]//The 9th International Conference on Information Science and Technology. Piscataway: IEEE Press, 2019: 288-293.

(  0) 0) |

| [36] |

LV J M, SONG B, GUO J, et al. Interest-related item similarity model based on multimodal data for top-N recommendation[J]. IEEE access, 2019, 7: 12809-12821. (  0) 0) |

| [37] |

HU P, ZHEN L L, PENG D Z, et al. Scalable deep multimodal learning for cross-modal retrieval[C]//Proceedings of the 42nd International ACM Conference on Research and Development in Information Retrieval. New York: ACM Press, 2019: 635-644.

(  0) 0) |

2023, Vol. 55

2023, Vol. 55