近年来,深度学习方法已经成功应用于机器视觉[1]、图像处理等领域,这些成功的背后都离不开大量的带标签数据支撑。但是在实际生活中,收集足够多的带标签数据是极其困难的。特别是在特殊领域,由于无法获取足够的带标签数据,导致该领域发展受限。迁移学习[2]的提出可以借助相关源域丰富的带标签数据来解决目标域无标签数据的问题。领域自适应[3]是一种非常有效的迁移学习方法,能够利用来自不同但相关源域丰富的带标签数据,将从源域学习的知识迁移到目标域。

领域自适应的关键就是要减小源域样本与目标域样本之间的域转移问题,从大量带标签数据的源域中学习域不变特征,迁移到目标域上,从而解决目标域标签样本不足的问题。

现有的领域自适应方法大多数是基于全局的域自适应,将源域和目标域全局分布对齐,没有考虑到源域与目标域类别的情况。在面对目标域类别比源域类别数量少的部分领域自适应,此时将两个域经过全局域适应后,两个域特征分布大致相同,但是由于目标域的类别数量少,源域类别数量多,在对齐的过程中势必会将目标域本身的特征信息分配给只出现在源域的类别,从而导致负迁移。现有针对部分域自适应的方法常见的是基于对抗性的。但基于对抗性的方法的本质也是将两个域的特征分布进行全局对齐,可能会丢失数据本身的细粒度信息。

基于以上问题,本文提出一种深度加权子域自适应网络,通过加权跨域对齐相关的子域分布,增强深度领域自适应网络的特征学习能力,与以往的方法相比,更加关注子类信息,通过子域自适应来学习每个类别的特征信息,同时考虑样本特征的权重来减缓只存在源域的异常源类的负迁移。

本文的主要贡献包括3个方面:

1) 提出一种新的深度加权子域自适应网络(deep-weighted subdomain adaptive network, DWSAN),通过权重设置, 弱化只出现在源域的异常源类特征对目标域学习源域相关类别特征信息的影响,最大限度将目标域的类别与相关源类进行子域对齐,从而为解决部分领域自适应问题提供思路。

2) 提出一种局部加权最大均值差异方法,通过权重设置来减缓异常源类的特征在迁移过程中对目标域的影响,并且对目标域和源域都存在的每个子类的特征分布差异进行优化。

3) 本文采用的网络结构是非对抗性的,优化参数少,比以前的基于对抗的模型结构简单。

1 相关工作 1.1 深度域自适应深度域自适应是利用深度网络来增强域自适应性能的一种方法。深度网络学习的特征更具有代表性和可迁移性。与传统的方法相比,深度域自适应方法通过将域自适应和深度神经网络相结合,利用深度网络学习更多可迁移的特征。

深度域自适应主要有基于差异和基于对抗两种方法。基于差异的深度域自适应方法主要是利用目标域标记的或者未标记的数据对深度网络模型进行调整,以此来减少两个域的分布差异。最大均值差异[4](maximum mean discrepancy, MMD)是最常用的比较和减少域间分布差异的非参数方法,除此之外还有相关对齐(CORAL)[5]、Kullback-Leibler(KL)散度[6]等方法。文献[7]提出了一种极其简单的域自适应神经网络(domain adaptive neural network, DaNN),该方法是一种新的深度结构域自适应方法,在特征层之后加入MMD自适应层来测量两个域之间的特征分布差异。基于对抗的深度域自适应方法是通过域鉴别器来混淆用于分类的数据是来自源域还是目标域,以此来最小化源域与目标域映射在特征空间的分布差异。文献[8]提出了一种新的领域对抗神经网络(domain adversarial neural network, DANN),首次将对抗学习的思想引入迁移学习,该模型最小化标签分类器的损失函数以提取具有区分能力的特征,最大化分类器的损失函数以提取具有域不变性的特征,从而减少域迁移。文献[9]提出了一种对抗判别域自适应(adversarial discriminative domain adaptation, ADDA)模型,将生成式对抗网络(generative adversarial network, GAN)[10]损失、权重共享和判别建模相结合,对域差异进行优化。文献[11]提出的部分对抗性域自适应(partial adversarial domain adaptation, PADA)通过对抗的思想对齐两个域的全局分布,同时减小在异常源类的类别权重而增大源域中目标域相关类别的权重,把问题转化为传统迁移学习问题。文献[12]提出了选择对抗网络(selective adversarial network, SAN)来解决部分领域自适应问题,文献[12]和文献[11]的整体思路和架构几乎一样,最大的不同是文献[12]使用了多个域鉴别器,源域有多少类就有多少个域鉴别器,而文献[11]只有一个域鉴别器。文献[13]提出了重要性加权对抗网络(importance weighted adversarial network, IWAN),该网络针对部分迁移问题的解决方案是,选择出源域中与目标域都存在的类别里的样本,给它们赋予高权重,异常源类里的样本赋予低权重,将问题转化为传统的迁移学习问题。

1.2 最大均值差异(MMD)MMD等多种测量两个域特征分布的度量方法都被应用于域适应,除此之外还有一些基于MMD的扩展也被应用于域自适应。文献[14]提出了一种深度残差传输网络(residual transfer network, RTN)域自适应方法,除了使用MMD适应特征外,还增加了一个门控残余层用于分类器自适应。文献[15]提出了一种新的深度自适应网络结构(deep adaptation network, DAN),在条件分布保持不变的前提下,通过嵌入多个任务特定层和多核来优化匹配边缘分布学习可转移特征,而不是使用单层线性MMD。文献[16]提出联合自适应网络(joint adaptation network, JAN),该网络通过联合最大平均误差(joint maximum mean discrepancy, JMMD)准则来调整多个领域特定层的联合分布来学习迁移网络,采用对抗性训练策略使JMMD最大化,使源域和目标域的分布更容易区分。

MMD值最常用的定义为再生核希尔伯特空间(reproducing kernel Hilbert space, RKHS)中边缘分布Ps和Pt的内核嵌入之间的平方距离。MMD值越小,表示源域与目标域的特征分布越相似。

源域与目标域的特征分布距离可以表述为

| $ {MMD}_{k}\left(P_{S}, P_{T}\right)^{2}=\left\|E_{P_{S}}\left[\phi\left(\boldsymbol{x}_{S}\right)\right]-E_{P_{T}}\left[\phi\left(\boldsymbol{x}_{T}\right)\right]\right\|_{H_{k}}^{2}, $ |

| $ \begin{aligned} &{MMD}_{k}\left(P_{S}, P_{T}\right)^{2}=\| \frac{1}{n_{s}} \sum\limits_{i=1}^{n_{s}} \phi\left(\boldsymbol{x}_{i}^{s}\right)- \\ &\frac{1}{n_{t}} \sum\limits_{i=1}^{n_{t}} \phi\left(\boldsymbol{x}_{i}^{t}\right) \|_{H_{k}}^{2}=\frac{1}{n_{s}^{2}} \sum\limits_{i=1}^{n_{s}} \sum\limits_{j=1}^{n_{s}} k\left(\boldsymbol{x}_{i}^{s}, \boldsymbol{x}_{j}^{s}\right)+ \\ &\frac{1}{n_{t}^{2}} \sum\limits_{i=1}^{n_{t}} \sum\limits_{j=1}^{n_{t}} k\left(\boldsymbol{x}_{i}^{t}, \boldsymbol{x}_{j}^{t}\right)-\frac{2}{n_{s} n_{t}} \sum\limits_{i=1}^{n_{s}} \sum\limits_{j=1}^{n_{t}} k\left(\boldsymbol{x}_{i}^{s}, \boldsymbol{x}_{j}^{t}\right), \end{aligned} $ |

其中: ϕ是特征映射; k是ϕ的核函数; Hk代表具特色核k的RKHS。

1.3 子域自适应近年来越来越多研究人员对子域自适应进行了深入的研究,文献[17]提出了一种利用子空间对齐的迁移框架,源域和目标域均用特征向量矩阵描述的子空间表示。文献[18]提出了基于RCNN的目标检测器的子空间对齐的域自适应算法。在基于子空间的对象域适应中,需要访问源子空间和目标子空间来获得特征。文献[19]提出将特征映射到低维子空间,在子空间中进行联合适配。

本文提出的深度加权子域自适应网络,该网络设计了一种新的局部加权最大平均差异来优化目标域和源域相关子类的特征分布差异,通过设置权重尽量减少异常源类在域自适应过程中的负迁移。

2 深度加权子域自适应网络 2.1 基本定义本文主要针对源域的标签空间Cs包含目标域的标签空间Ct的部分域自适应问题,即Cs⊃Ct。定义源域Ds={(xis, yis)}i=1ns为ns个带标签的样本共计Cs类,目标域Dt={xjt}j=1nt为nt个无标签的样本共计Ct类。两个域中的数据分别从不同的数据分布p和q采样获得,即p≠q。在部分域自适应中有pct≠q,pct表示源域中属于标签空间Ct的数据。将只存在于源域的类别称为异常源类。

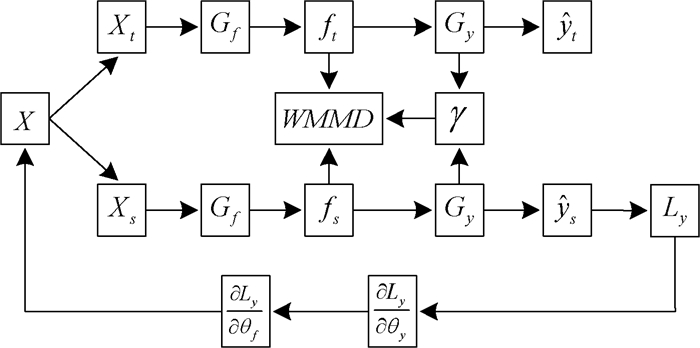

2.2 深度加权子域自适应网络本文针对部分领域自适应问题提出了深度加权子域自适应网络。与以往的方法不同,本次实验没有采用对抗性的方法,网络结构更加简单,提出了局部加权最大平均差异方法。通过给源域类别设置权重参数,来缓解异常源类数据在子域自适应过程中对目标域数据产生的影响。网络结构如图 1所示。

|

图 1 深度加权子域自适应网络结构图 Fig. 1 Diagram of deep-weight subdomain adaptive network structure |

通过对深度神经网络的研究发现,深度网络可以学习更深层次的可迁移特征,并且这些特征更具有代表性,在深度域自适应中提取的特征好坏会直接影响模型的泛化性能。因此,本文的特征提取器Gf是在ImageNet模型中预先训练的ResNet-50模型的基础上微调得到的,该模型可以充分利用预训练过的模型和原始网络参数的优点。通过特征提取器Gf提取输入数据的深度域不变特征,并在两个域之间共享特征提取器Gf的权值。其中,fs表示从源域提取的特征,ft表示从目标域提取的特征。

源分类器Gy将特征提取器Gf获得的域不变特征f作为输入,可以得到预测输出。将源分类器的权值共享给目标域分类器。

为获取域不变特征f,通过优化特征提取器Gf的参数θf,同时优化源分类器Gy的参数θy来保证源分类器Gy的准确性。除此之外还要优化局部加权最大均值差异(weighted maximum mean discrepancy, WMMD)的参数θm,进一步减小相关源类和目标域类别的子域特征分布差异,从而提高传递精度。

2.3 局部加权最大均值差异以往的基于MMD的方法重点关注全局分布的对齐,从而忽略了两个域中同一类别之间的关系。尤其是在部分域自适应问题中,由于异常源类的存在,直接进行全局对齐就会产生负迁移。本文提出将源域和目标域中同一类别的相关子域的分布进行对齐。在对齐相关子域的同时,把异常源类的影响降到最低,因此提出WMMD,给异常源类一个低权重,从而减少异常源类在对齐子域分布的影响。WMMD的分布距离可以表述为

| $ \begin{array}{l} W M M D_{k}\left(P_{S}, P_{T}\right)^{2} \stackrel{\Delta}{=} E_{C} \| E_{P_{S}}\left[\phi\left(\boldsymbol{x}_{S}\right)\right]- \\ E_{P_{T}}\left[\phi\left(\boldsymbol{x}_{T}\right)\right] \|_{H_{k}}^{2}, \end{array} $ |

| $ \begin{array}{l} W M M D_{k}\left(P_{S}, P_{T}\right)^{2}=\frac{1}{C} \sum\limits_{c=1}^{C} \| \sum\limits_{x_{i}^{s} \in D_{s}}^{n_{s}} \boldsymbol{\gamma}_{i}^{s c} \phi\left(\boldsymbol{x}_{i}^{s}\right)- \\ \sum\limits_{x_{j}^{t} \in D_{t}}^{n_{t}} \phi\left(\boldsymbol{x}_{j}^{t}\right) \|_{H_{k}}^{2}。\end{array} $ |

为了对齐相关子域的分布,设置源域每个类的权重参数为γ。

| $ \begin{aligned} &W M M D_{k}\left(P_{s}, P_{t}\right)^{2}=\frac{1}{C} \sum\limits_{c=1}^{C}\left[\sum\limits_{i=1}^{n_{s}} \sum\limits_{j=1}^{n_{s}} \boldsymbol{\gamma}_{i}^{s c} \boldsymbol{\gamma}_{j}^{s c} k\left(\boldsymbol{z}_{i}^{s l}, \boldsymbol{z}_{j}^{s l}\right)-\right. \\ &\left.2 \sum\limits_{i=1}^{n_{s}} \sum\limits_{j=1}^{n_{t}} \boldsymbol{\gamma}_{i}^{s c} k\left(\boldsymbol{z}_{i}^{s l}, \boldsymbol{z}_{j}^{t l}\right)+\sum\limits_{i=1}^{n_{t}} \sum\limits_{j=1}^{n_{t}} k\left(\boldsymbol{z}_{i}^{t l}, \boldsymbol{z}_{j}^{t l}\right)\right], \end{aligned} $ |

其中:γisc代表源域属于类别C的权重。

由于源分类器

| $ \boldsymbol{\gamma}=\frac{1}{n_{t}} \sum\limits_{i=1}^{n_{t}} \hat{\boldsymbol{y}}_{i}, $ |

γ是一个量化源域类别贡献的|Cs|维向量。由于目标域数据不属于异常源类,因此针对异常源类的数据应该有一个比较小的权重,这样才能减少子域对齐的影响。通过将每个权重都除以这个权重向量中最大权值进行归一化处理,即:γ=γ/max(γ),从而达到将异常源类的权重贡献明显变小。这样处理不管源域的类别数量比目标域数量多还是相等,都可以得到源域类别的贡献权重,从而引导目标域数据减少分类错误。

2.4 损失函数本文提出的深度加权子域自适应网络的损失包括两部分,一部分是在训练源分类器的源监督损失,另一部分是利用WMMD对齐子域分布的损失。

深度加权子域自适应网络的总体损失函数为

| $ \begin{aligned} &C_{0}\left(\theta_{f}, \theta_{y}, \theta_{m}\right)=\frac{1}{n_{s }}\sum\limits_{x_{i} \in D_{s}} \boldsymbol{\gamma}_{y_{i}} L_{y}\left(G_{y}\left(G_{f}\left(\boldsymbol{x}_{i}\right)\right), \boldsymbol{y}_{i}\right)- \\ &\sum\limits_{x_{i} \in D_{s}, D_{t}} L_{M}\left(\boldsymbol{\gamma}_{y_{i}} G_{f}\left(\boldsymbol{x}_{s}\right), G_{f}\left(\boldsymbol{x}_{t}\right)\right) 。\end{aligned} $ |

整体优化问题就是寻找

| $ \left(\hat{\theta}_{f}, \hat{\theta}_{y}\right)=\underset{\theta_{f}, \theta_{y}}{\arg \min } C_{0}\left(\theta_{f}, \theta_{y}, \theta_{m}\right), $ |

| $ \left(\hat{\theta}_{m}\right)=\underset{\theta_{m}}{\arg \min } C_{0}\left(\theta_{f}, \theta_{y}, \theta_{m}\right) 。$ |

我们在Office-31[20]、Office-Home[21]和水下人造物体数据集上进行了仿真实验,以此来评估我们的方法与几种先进的深度域自适应方法的性能。

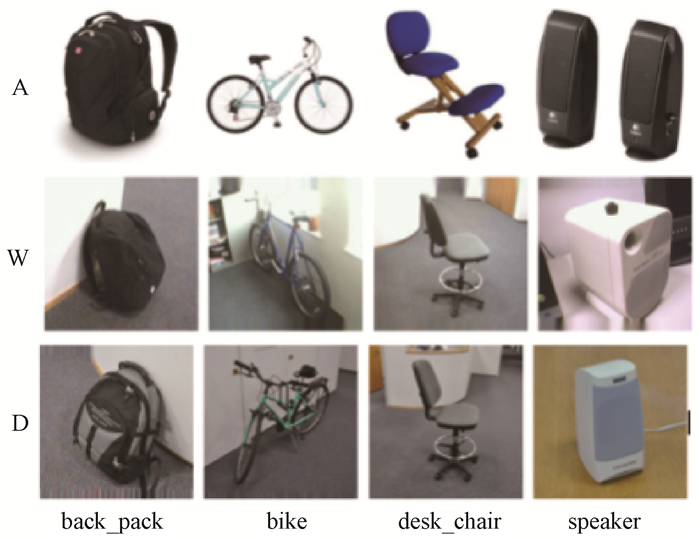

3.1 数据集Office-31是领域自适应中使用最广泛的数据集,从三个不同的领域收集了包含31个类别共计4 652张图像,如图 2所示。这些图像数据集分别为从亚马逊网下载的Amazon(A)、通过网络摄像头和单反相机拍摄的Webcam(W)和DSLR(D)。使用Office-31和Caltech-256数据集共享的10类作为目标域。设置6组域自适应学习任务,分别为A31→W10(A→W)、D31→W10(D→W)、W31→D10(W→D)、A31→D10(A→D)、D31→A10(D→A)、W31→A10(W→A)。每组学习任务源域为31类,目标域为10类。

|

图 2 Office-31数据集示例图像 Fig. 2 Sample image of the Office-31 dataset |

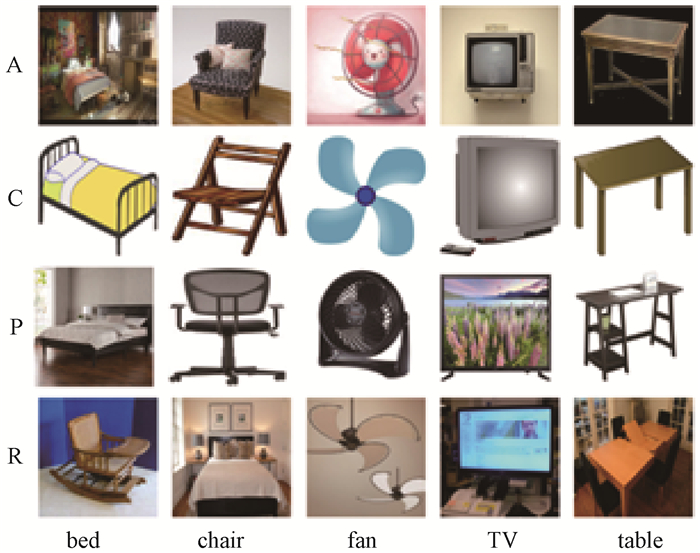

Office-Home是一个复杂度更高的领域自适应数据集,从4个不同的领域收集了65个类别共计15 588张图像,如图 3所示。这些图像分别来自艺术照片(A)、剪纸画(C)、产品图像(P)和现实世界图像(R)。将这四个域的数据分别作为源域,目标域数据为按照字母排序的前25类图像。基于此我们可以构造12个学习任务。分别为A65→C25(A→C)、A65→P25(A→P)、A65→R25(A→R)、C65→A25(C→A)、C65→P25(C→P)、C65→R25(C→R)、P65→A25(P→A)、P65→C25(P→C)、P65→R25(P→R)、R65→A25(R→A)、R65→C25(R→C)、R65→P25(R→P)。每组学习任务源域为65类,目标域为25类。

|

图 3 Office-Home数据集示例图像 Fig. 3 Sample image of the Office-Home dataset |

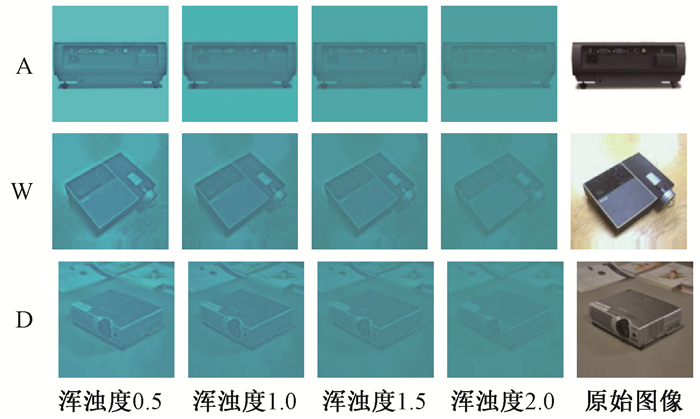

水下数据集:借助文献[22]提出的不需要额外的图像深度信息就能获得满意的水下图像的方法,基于Office-31和Caltech-256数据集共享的10类数据集为基础,得到的浑浊度分别为0.5、1.0、1.5、2.0的水下数据集。水下数据集示例如图 4所示。将得到的水下数据集作为目标域,Office-31数据集作为源域,针对每种浑浊度的水下数据集分别构造了以下9个学习任务。A31→U_A10(A→U_A)、A31→U_W10(A→U_W)、A31→U_D10(A→U_D)、W31→U_A10(W→U_A)、W31→U_W10(W→U_W)、W31→U_D10(W→U_D)、D31→U_A10(D→U_A)、D31→U_W10(D→U_W)和D31→U_D10(D→U_D)。每组学习任务源域为31类,目标域为10类。

|

图 4 水下数据集示例图像 Fig. 4 Sample image of the underwater dataset |

针对Office-31和Office-Home数据集将本文提出的深度加权子域自适应与其他主流的深度学习方法进行了性能对比。针对Office-31数据集比较的方法有深度残差网络ResNet[1]、深度自适应网络DAN[15]、RTN[14]、DANN[8]、ADDA[9]、JAN[16]、PADA[11]、IWAN[13]。针对Office-Home数据集比较的方法有ResNet[1]、DAN[15]、RTN[14]、ADDA[9]、PADA[11]、IWAN[13]、SAN[12]。除此之外,还利用水下数据集测试了我们的方法。

我们在PyTorch上实现了所有的方法,并且微调了在ImageNet预训练的ResNet-50。由于分类器是重新开始训练的,将其学习速率设置为其他经过微调层的10倍。对于所有的学习任务,使用动量为0.85的小批量随机梯度下降(SGD)和Revgrad中的学习率退火策略。SGD是使用ηp=

基于ResNet-50对Office-31数据集的6个任务的分类结果如表 1所示,黑体表示该迁移任务的最高准确率。从表 1可以看出:

|

|

表 1 Office-31数据集用于域适应的准确率(ResNet-50) Tab. 1 Accuracy of Office-31 datasets used for domain adaptation(ResNet-50) |

1) DAN、DANN、ADDA、JAN的分类正确率都低于ResNet,由此可见,这些方法在面对部分领域自适应问题负迁移的现象很严重。

2) RTN方法虽然比ResNet有改进,但在一些任务上精度仍然不高,仍然存在负迁移问题。

3) 部分域自适应方法PADA、IWAN在结果上远比其他方法准确率高,也正因为它们利用加权机制才能缓解异常源类的负迁移,促进相关源类的正迁移。

4) 本文所提出的DWSAN在分类任务上取得的效果要比部分域自适应方法PADA、IWAN要好,这也说明了本文提出的方法可以有效减缓异常源类的负迁移,促进相关子域的正迁移。

Office-Home数据集复杂度更高,更具有挑战性,基于ResNet-50对Office-Home数据集的12个任务的分类结果如表 2所示。黑体表示该迁移任务的最高准确率。从表 2可以看出:

|

|

表 2 Office-Home数据集用于域适应的准确率(ResNet-50) Tab. 2 Accuracy of Office-Home datasets used for domain adaptation (ResNet-50) |

1) DAN、RTN、ADDA的分类准确率在一些任务上分类精确度高于ResNet,但整体效果并不理想,这些方法在处理部分领域自适应问题存在负迁移问题。

2) 部分域自适应方法PADA、IWAN、SAN在有些任务上比其他域自适应方法表现优秀,但由于数据集更具挑战性,整体精度并没有很突出。

3) 本文所提出的DWSAN在分类任务上取得的效果比部分域自适应方法PADA、SAN、IWAN好,这也说明了本文提出的方法可以有效减缓异常源类的负迁移,促进相关子域的正迁移。

对比实验结果进一步说明:

1) 在部分领域自适应问题中,深度加权子域自适应方法性能优于之前的域适应方法。将以往的全局域适应方法改进为加权子域自适应方法是实现域适应的关键;以前的方法不考虑子域之间的关系对齐全局分布,忽略了局部信息,而DWSAN精确地对齐了相关的子域分布,它不仅弱化了异常源类的信息,还可以为每个目标域相关类别捕获更细粒度的信息。

2) 特别是与其他部分域自适应方法相比,DWSAN取得了更高的精确度。

除此之外,本文采用的网络结构没有基于对抗性方法。基于对抗性的方法大多包含多个损失函数,收敛速度相对较慢。从表 2中可以看到以往基于对抗性的部分领域自适应方法与本文提出的方法对比,本文的方法在准确率上提高了10%。

基于不同浑浊度的水下数据集用深度子域自适应网络执行9组任务,仿真结果如表 3所示。可以看到每种任务下各种浑浊度的数据集都能够得到较高的正确率。即使浑浊度较高,得到的水下数据集不清晰,也能够得到较准确的结果。

|

|

表 3 水下数据集用于域适应的准确率(ResNet-50) Tab. 3 Accuracy of underwater datasets used for domain adaptation(ResNet-50) |

针对部分领域自适应问题大多数只考虑对齐两个域的全局分布,而不考虑不同域中相同类别之间的子域关系,从而导致异常源类在迁移过程中造成的负迁移。本文提出了一种新的深度加权子域自适应网络(DWSAN)。该网络通过对深度网络提取的特征基于自适应权重调节机制进行重要性加权,将两个域中都存在的类别特征赋予高权重,只存在于源域的类别特征赋予低权重;并提出局部加权最大均值差异方法,研究两个相关子域的特征分布对齐方法,从而减少异常源类的特征在迁移过程中导致的负迁移,提高模型的分类精度。本文提出的方法与PADA、SAN、IWAN等方法在Office-31和Office-Home公开数据集上进行了对比实验,还将此方法应用于水下数据集。实验结果表明,该方法在Office-31和Office-Home数据集上能获得比现有主流方法更高的分类准确率。从表 3可以计算出,水下数据集用于域适应的平均准确率达到90.55%。

| [1] |

HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2016: 770-778.

(  0) 0) |

| [2] |

PAN S J, YANG Q. A survey on transfer learning[J]. IEEE transactions on knowledge and data engineering, 2010, 22(10): 1345-1359. DOI:10.1109/TKDE.2009.191 (  0) 0) |

| [3] |

WANG M, DENG W H. Deep visual domain adaptation: a survey[J]. Neurocomputing, 2018, 312: 135-153. (  0) 0) |

| [4] |

ZHU Y C, ZHUANG F Z, WANG D Q. Aligning domain-specific distribution and classifier for cross-domain classification from multiple sources[C]//Proceedings of the AAAI Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2019, 5989-5996.

(  0) 0) |

| [5] |

SUN B C, SAENKO K. Deep CORAL: correlation alignment for deep domain adaptation[C]//European Conference on Computer Vision. Berlin: Springer Press, 2016: 443-450.

(  0) 0) |

| [6] |

PENG X C, SAENKO K. Synthetic to real adaptation with generative correlation alignment networks[C]//IEEE Winter Conference on Applications of Computer Vision. Piscataway: IEEE Press, 2018: 1982-1991.

(  0) 0) |

| [7] |

GANIN Y, LEMPITSKY V. Unsupervised domain adaptation by backpropagation[C]//Proceedings of the 32nd International Conference on Machine Learning. Lille: International Machine Learning Society, 2015: 1180-1189.

(  0) 0) |

| [8] |

GANIN Y, USTINOVA E, AJAKAN H, et al. Domain-adversarial training of neural networks[M]//CSURKA G. Domain adaptation in computer vision applications. Cham: Springer International Publishing, 2017: 189-209.

(  0) 0) |

| [9] |

TZENG E, HOFFMAN J, SAENKO K, et al. Adversarial discriminative domain adaptation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2017: 2962-2971.

(  0) 0) |

| [10] |

GOODFELLOW I, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial networks[J]. Communications of the ACM, 2020, 63(11): 139-144. (  0) 0) |

| [11] |

CAO Z J, MA L J, LONG M S, et al. Partial adversarial domain adaptation[C]//European Conference on Computer Vision. Cham: Springer International Publishing, 2018: 139-155.

(  0) 0) |

| [12] |

CAO Z J, LONG M S, WANG J M, et al. Partial transfer learning with selective adversarial networks[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2018: 2724-2732.

(  0) 0) |

| [13] |

ZHANG J, DING Z W, LI W Q, et al. Importance weighted adversarial nets for partial domain adaptation[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2018: 8156-8164.

(  0) 0) |

| [14] |

LONG M S, ZHU H, WANG J M, et al. Unsupervised domain adaptation with residual transfer networks[C]//30th Annual Conference on Neural Information Processing Systems. San Diego: NeurIPS Press, 2016: 136-144.

(  0) 0) |

| [15] |

LONG M S, CAO Y, WANG J, et al. Learning transferable features with deep adaptation networks[C]//Proceedings of the 32nd International Conference on International Conference on Machine Learning. New York: ACM Press, 2015: 97-105.

(  0) 0) |

| [16] |

LONG M S, WANG J M, JORDAN M I. Deep transfer learning with joint adaptation networks[EB/OL]. [2021-04-16]. https://arxiv.org/abs/1605.06636.

(  0) 0) |

| [17] |

ELHADJI-ILLE-GADO N, GRALL-MAES E, KHAROUF M. Transfer learning for large scale data using subspace alignment[C]//The 16th IEEE International Conference on Machine Learning and Applications. Piscataway: IEEE Press, 2017: 1006-1010.

(  0) 0) |

| [18] |

RAJ A, NAMBOODIRI V P, TUYTELAARS T. Subspace alignment based domain adaptation for RCNN detector[C]//Procedings of the British Machine Vision Conference. Nottingham: British Machine Vision Association Press, 2015: 1-11.

(  0) 0) |

| [19] |

黄露, 曾庆山. 基于平衡概率分布和实例的迁移学习算法[J]. 郑州大学学报(理学版), 2020, 52(3): 55-61. HUANG L, ZENG Q S. Balanced distribution adaptation and instance based transfer learning algorithm[J]. Journal of Zhengzhou university (natural science edition), 2020, 52(3): 55-61. (  0) 0) |

| [20] |

SAENKO K, KULIS B, FRITZ M, et al. Adapting visual category models to new domains[C]//European Conference on Computer Vision. Berlin: Springer Press, 2010: 213-226.

(  0) 0) |

| [21] |

VENKATESWARA H, EUSEBIO J, CHAKRABORTY S, et al. Deep hashing network for unsupervised domain adaptation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2017: 5385-5394.

(  0) 0) |

| [22] |

YU X, XING X R, ZHENG H, et al. Man-made object recognition from underwater optical images using deep learning and transferlearning[C]//IEEE International Conference on Acoustics, Speech and Signal Processing. Piscataway: IEEE Press, 2018: 1852-1856.

(  0) 0) |

2022, Vol. 54

2022, Vol. 54