2. 中国矿业大学 矿山数字化教育部工程研究中心 江苏 徐州 221116

2. Engineering Research Center of Mine Digitalization of Ministry of Education, China University of Mining and Technology, Xuzhou 221116, China

基于视觉的人体姿态估计是指对给定帧中的人体关键点进行分类和定位,并连接相应的关键点构建近似骨架。关键点是主观的,并因应用而异。但是,表征人体形状的关节可以定义为关键点。例如,铰链关节、枢轴关节、椭球关节以及连接肩关节和髋关节以允许向后、向前、侧向和旋转运动的球窝关节被认为是大多数姿势估计算法中包含的必要关键点。

人体姿态估计是计算机视觉中的经典问题之一,几十年来一直是一个活跃的研究领域。早期,研究人员通过采用手工提取特征建立模型, 基于图结构(pictorial structures)模型[1]和基于形变部件模型[2]是常用的模型,但是在严重遮挡和其他复杂环境下,它们无论是在准确性方面还是时效性方面效果都不太令人满意。近年来,随着深度学习的出现,一些网络模型如卷积神经网络(CNN)[3]、生成对抗网络(GANs)[4]、金字塔网络以及高分辨率网络(HRNet)[5]等被提出。由于这些网络具有强大的特征提取能力和拟合能力,在视觉方面取得了不少的研究成果,比如图像识别、图像分割、图像生成、人体姿态估计等各个领域。通过深度学习的方法,一定程度上降低了人体姿态估计的研究门槛。人体姿态可以利用CNN提取更加准确的特征,人体关节点之间的联系也更容易获取,整体上提高人体姿态估计的准确率。由此,人体姿态估计也得到快速发展。

人体姿态是许多与娱乐相关的多媒体应用程序的重要组成部分,如游戏和动画电影。它在运动员的表现分析和运动训练中起着关键作用。在其他领域如医学成像、人群分析、动物饲养、动作识别、人机交互、检测和跟踪等发挥着重要作用。

本文从单人人体姿态估计到多人人体姿态估计进行论述,汇总分析近年来的研究进展与应用,阐述了当前该研究领域所面临的问题和未来发展的趋势。

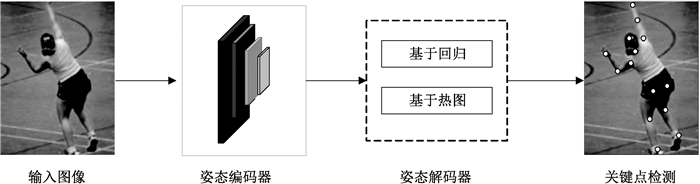

1 单人二维人体姿态估计方法当输入的图像只包含一个人时,可以直接使用二维人体姿态估计对关键点进行检测。当输入图像包含多人时,需要对图像预处理,把其中的每个人进行分割,得到单人图像。基于深度学习,单人人体姿态估计主流的方法分为基于回归的方法和基于热图的方法。基于回归的方法直接将输入图像映射到身体关节的坐标,通常使用完全连接预测层,消除了热图的需要。基于热图的方法是通过参数间的映射达到预测关键点位置的目的。单人人体姿态估计方法的识别流程图如图 1所示。

|

图 1 单人姿态估计识别流程图 Fig. 1 Single-human pose estimation and recognition process |

Toshev等[6]以AlexNet为骨干,提出了一种级联深度神经网络回归器(DeepPose),用于从图像中学习关键点,将姿势估计表述为基于深度神经网络(DNN)的关节点回归问题。该方法具有以整体方式推理姿态的优点,能够产生高精度的姿态估计。识别效果较优,人体姿态估计的研究从传统方法转向深度学习方法。

基于GoogLeNet,Carreira等[7]提出了一个坐标回归框架,通过引入自顶向下的反馈机制,将分层特征提取器的表达能力扩展到包括输入和输出空间。该机制允许模型预测误差,并在当前估计时间对其进行校正,而不是直接预测目标输出。这个过程称为迭代误差反馈。这是一种自校正模型,通过将预测误差注入输入空间来逐步改变初始解。

Sun等[8]提出了一种基于ResNet-50的结构感知回归方法,称为“组合姿势回归”。该方法不再将关节用于人体姿态的表示,而是将包含人体的信息重新参数化表示。Luvizon等[9]提出了一种用于人体姿态估计的端到端回归方法,使用softargmax函数将特征图转换为完全可微框架中的关节坐标。该方法能够间接地学习热图表示,将特征图转换为关键点坐标,可以直接将上、下文信息包含在姿势预测中,使识别精度进一步提高。Li等[10]提出了姿势回归变换器,这是一种基于变换器结构的单人姿势识别方法的新设计。与现有的基于热图的方法相比,它将姿势识别任务视为一项回归任务,通过回归推理从关节中获得关键点预测的空间关系,消除了复杂的预处理或后处理程序,并且需要较少的启发式设计。

编码丰富姿态信息的良好特征对于基于回归的方法至关重要。学习更好的特征表示的一种流行策略是多任务学习[11],称为类似姿态估计。将基于姿态的动作识别为相关任务,这种任务之间相互表示,模型可以更好地概括原始任务(姿态估计)。遵循这一方向,Li等[12]提出了一个异质多任务框架,该框架由两个任务组成:通过回归器从全图像中预测关节坐标,以及使用滑动窗口从图像块中检测身体部位。Fan等[13]提出了一种双源,即图像补丁和完整图像的CNN,用于确定补丁是否包含身体关节的关节检测,以及确定补丁中关节的准确位置的关节定位。每个任务都对应一个损失函数,两个任务的组合可以改善结果。Luvizon等[14]提出了一个多任务框架,用于从静止图像中联合进行2D和3D姿势估计,并从视频序列中进行人体动作识别。该网络框架表明了一个单一的体系结构可以有效解决动作识别和人体姿势估计这两个问题,并且仍然可以获得最先进的结果。

基于Transformers,Mao等[15]提出了一种基于回归方式的人体姿态估计框架,与以前的基于回归的方法不同,通过变换器有效解决了将姿势估计任务公式化为序列预测问题,该框架能够自适应地关注与目标关键点最相关的特征,这在很大程度上克服了以前基于回归方法的特征失准问题。该团队第二年又提出了名为Poseur[16]的一种基于回归的直接方法来从单个图像中估计2D人体姿态。将该问题表述为序列预测任务,并使用Transformer网络解决。该网络直接学习从图像到关键点坐标的回归映射,而无须求助热图等中间表示。这种方法避免了与基于热图的方法相关的许多复杂性。同时,他们还提出了一种关注机制,该机制自适应地关注与目标关键点最相关的特征,显著提高了准确性,克服先前基于回归方法的特征失准问题。

1.2 基于热图的模型基于热图的人体姿态估计方法旨在训练身体部位检测器来预测身体关节的位置。人体姿态估计的检测方法通过热图预测方法来处理估计任务。具体来说,目标是估计k个热图{H1, H2, …, Hk},共k个关键点。在每个关键点热图中像素值Hi(x, y)表明关键点位于该位置(x, y)的概率。目标热图由以地面真实联合位置为中心的2D高斯函数生成。因此,通过最小化预测热图和目标热图之间的差异来训练姿态估计网络。

与联合坐标相比,热图包含丰富的空间信息。利用其大量的监督信息,卷积网络的训练也更加方便有效。因此,最近人们利用热图来表示联合位置,并为人体姿态估计开发有效的CNN架构。Tompson等[17]将基于CNN的身体部位检测器与基于部位的空间模型结合为2D人体姿态估计的统一学习框架。Lifshitz等[18]提出了一种基于CNN的预测关节位置的方法。它结合关键点投票和联合概率来确定人体姿态表示。这种基于CNN的预测关节位置的方法,结合关键点投票和关节概率来确定人体姿态,在没有增加模型参数量的基础上能有效地扩大卷积感受野,提高关键点热图检测的准确率。Sun等[5]提出了一种新的高分辨率网络(HRNet),是多人姿态估计的基础,通过并行连接多分辨率子网络重复多尺度融合,学习可靠的高分辨率表示。

一个高效的网络结构有参数数量少、收敛速度快、关键点位置易于预测等特点,这种网络结构对深度学习网络的实际应用具有重要意义。Wei等[19]引入了一种基于卷积网络的序列框架,称为卷积姿态机,以通过多级处理来预测关键关节的位置,每个阶段中的卷积网络利用从前一阶段生成的2D置信图,产生对身体部位位置精细预测。利用使用卷积神经网络提取图像纹理信息的同时,使用图模型或者其他模型来表达各个身体部位在空间上的关系,使得学习的效果更好。在此基础上,Yang等[20]设计了一个多分支金字塔残差模块来代替堆叠沙漏中的残差单元,从而增强了深CNN尺度的不变性。Newell等[21]提出了一种名为“堆叠沙漏”的编码器-解码器网络,以在中间监督下重复自下而上和自上而下处理。

堆叠沙漏(SHN)网络设计用于在图像上捕捉不同比例的特征。它通过汇集和上采样捕获每个尺度的信息,该网络包含若干个残差模块,以便在不同分辨率上处理空间信息,进行关键点预测。将多个沙漏堆叠,每个沙漏结构都包含从高分辨率到低分辨率和从低分辨率到高分辨率的过程,同时与中间监督相结合,以估计不同尺度的人体姿态关键点特征,提高网络性能。

此后,有大量研究改进基于沙漏堆叠网络,Chu等[22]设计了新的沙漏残留单元,该单元将残留单元与具有更大接受野的滤光片的侧分支延伸,以捕捉不同尺度的特征,进一步提升了关键点热图预测的准确率。除了高准确率,模型的轻量化对于应用落地也是至关重要的。因而Zhang等[23]根据堆叠沙漏网络的对称性结构, 将其进行压缩,同时对该模型进行知识蒸馏, 引导压缩后的堆叠沙漏网络模型的训练,不仅保证模型的准确率,还最大程度降低了模型的尺寸,减少了运算参数数量。

生成对抗网络(GAN)出现后,学者们将GAN应用到人体姿态估计中。Chen等[24]构建了一个结构感知的有条件对抗网络,即对抗姿态网络。它包含一个姿态生成器和两个辨别器,用于辨别人体姿态的合理性。Chou等[25]构建了一个基于对抗学习的网络,其中两个堆叠的沙漏网络分别与鉴别器和生成器共享相同的结构。生成器是对关节点坐标的估计,估计每个关节的位置,鉴别器是用来对热图的真实性进行鉴别。Peng等[26]开发了一种对抗性数据增强网络,该网络在不需要寻找更多数据的情况下优化数据增强和网络训练。通过将人体姿态估计网络作为鉴别器并使用增强网络作为生成器来增强对抗性,从而优化数据增强和网络训练。

对于视频中的人体姿态估计而言,时间信息必不可少。Jain等[27]设计了一个框架,该框架包含两个分支的CNN,采用多尺度RGB帧和光流图作为输入。这种新的、有效的方法用于使用卷积网络架构的视频中的关节人体姿态估计,该架构结合了颜色和运动特征。Pfister等[28]研究了一种ConvNet架构,使用光流图作为指导,在输入层使用光流的架构,直接回归关节坐标的架构,以及在没有空间融合的情况下,根据视频的时间上、下文信息对齐来自相邻帧的预测热图。

为了给人体姿态估计网络建设提供更多更好的监督信息,研究者们除研究网络设计方面之外,也关注了身体结构信息。Yang等[29]提出将深度卷积神经网络和可变形混合零件模型合并到一个端到端的框架中。该框架能够通过结合人体部位之间的空间和外观一致性来挖掘负面因素,可以更有效地训练深度卷积神经网络。Chu等[30]提出了一种结构化的特征级学习框架,用于在人体姿态估计中推理人体关节之间的相关性,这捕获了人体关节更丰富的信息,并改进了学习结果。Ke等[31]设计了一种多尺度结构感知神经网络,该网络结合了多尺度监督、多尺度特征组合、结构感知损失信息方案和关键点掩蔽训练方法,以改进复杂场景中的人体姿态估计模型。Tang等[32]构建了一个基于沙漏的监督网络,称为深度学习成分模型,以描述身体各部分之间复杂而现实的关系,并学习人体中的成分模式信息(每个身体部分的方向、比例和形状信息)。Tang等[33]揭示了并非所有部件都彼此相关,因此引入了基于部件的分支网络来学习特定于每个部件组的表示,而不是所有部件的共享表示。

1.3 小结单人姿态估计分为基于坐标回归和基于热图检测方法。表 1列出了这两种方法的对比。

|

|

表 1 单人姿态估计方法对比 Tab. 1 Comparison of single-human pose estimation methods |

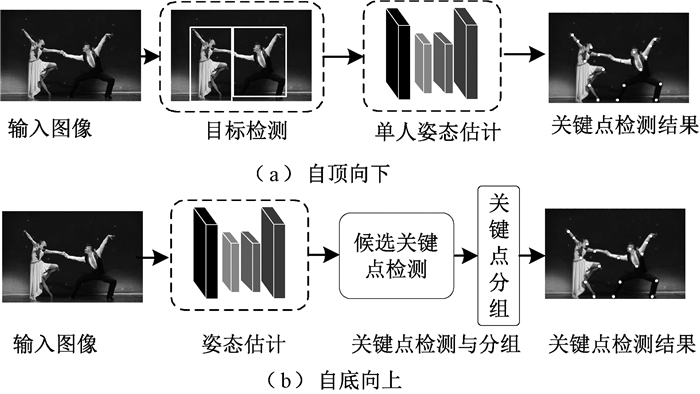

相对于单人的人体姿态估计而言,多人人体姿态估计更加困难。多人人体姿态估计有两种范式:自顶而下和自底而上。自顶而下的范式首先检测人,然后对每个检测的人执行单人姿势估计。自底而上的范式要么直接回归属于同一个人的关键点位置,要么检测并分组关键点。自顶而下的范式更准确,但由于需要额外的人员检测过程,成本更高。

自底向上方法的计算速度通常比自顶向下方法快,因为它们不需要分别检测每个人的姿势。多人姿态估计识别流程如图 2所示。

|

图 2 多人姿态估计识别流程 Fig. 2 Multi-human pose estimation and recognition process |

在如图 2(a)所示的自顶而下的过程中,包含一个检测器和单人姿势估计器,分别用于获得人体边界框和对边界框内关键点位置进行预测。一系列工作集中于设计和改进HPE网络中的模块。Xiao等[35]在主干网络ResNet中添加了一些反卷积层以构建一个简单而有效的结构,以生成高分辨率表示的热图。为了更好地定位关键点位置,Wang等[36]引入了一种两阶段基于图的模型不可知框架,称为Graph-PCNN。它包括一个定位子网以获得粗略的关键点位置,以及一个图形姿态细化模块以获得精确的关键点定位表示。

Cai等[37]引入了一个多级网络,该网络具有残差步长网络(RSN)模块,用于通过有效的内部特征融合策略学习精细的局部表示。当一张图上存在多人时,人们之间的肢体难免会相互遮挡或重叠。在自顶向下的检测方法中,人体检测识别就成为难点。为此,Iqbal等[38]构建了基于Faster R-CNN检测器来估计关节候选。将一组在图像中检测的候选关键点构造成一个完全连接的图,然后,他们使用整数线性规划来解决关节与人之间的关联问题,甚至在存在严重遮挡的情况下也能获得人体姿态。

Papandreou等[39]提出了一种两阶段架构,该架构具有一个更快的R-CNN人体检测器,用于为候选人体创建边界框,以及一个关键点估计器,通过使用一种形式的热图偏移聚合来预测关键点的位置。该方法在遮挡和杂乱的场景中效果良好。为了缓解HPE中的遮挡问题,Chen等[40]提出了一种级联金字塔网络(CPN),它包括两部分:GlobalNet(预测不可见关键点的特征金字塔网络)和RefineNet(将GlobalNet的所有级别的特征与关键点挖掘损失相结合的网络)。通过实验数据可知,CPN在预测闭塞关键点方面具有出色的表现。Su等[41]设计了两个模块,即通道混合模块(channel shuffle module,CSM)和空间注意力残差模块(spatial channel-wise attention residual bottleneck,SCARB),以增强信道方向和空间信息,从而在遮挡场景下更好实现多人人体姿态估计。Qiu等[42]提出了一个新的OPEC网络框架,该框架提出一个图像引导的渐进式GCN模块,模块提供了对图像上、下文和姿态结构的全面理解,从推理的角度估计不可见关节。Rafi等[43]提出了一个关键点对应框架,利用遮挡场景中前一帧的时间信息来恢复丢失的姿态。使用自监督训练网络,以改善稀疏注释视频数据集上的姿态估计结果。

最近,基于变换器的方法吸引了更多的关注,因为变换器中的关注模块可以获得预测关键点的长期依赖性和全局证据,这比CNN更强大。早期提出了一种基于变压器的2D人体姿态估计模型TransPose,该模型利用注意力层预测关键点的热图,并学习遮挡场景中人体姿态估计的细粒度证据。在TransPose之后,大多数现有的基于CNN的方法在视觉表示方面表现良好,但缺乏明确学习关键点之间的约束关系的能力。通过这种方式,提出的TokenPose能够通过自我注意交互显式地捕捉外观线索和约束线索。

2.2 自底向上与自顶向下的人体姿态估计方法相反,自底向上的HPE先通过人体关键点检测,提取局部特征和预测身体关节候选。接着对关节候选进行分组,以使用零件关联策略构建姿态表示。

Pishchulin等[44]提出了一种名为DeepCut的基于快速R-CNN的身体部位检测器。它使用整数线性规划(ILP)将标记的部位组合。然而,DeepCut在计算上很昂贵。为此,Insafutdinov等[45]引入了DeeperCut,提出了强大的身体部位检测器,在身体部位之间引入了新的图像条件成对项,加入一种新的增量优化策略,提升速度和鲁棒性。后来,Cao等[46]构建了一个名为OpenPose的检测器,该检测器基于CPM网络的方法来预测具有部分亲和力场(part affinity fields,PAF)的所有候选关键点信息,从而将关键点与每个人关联起来。PAF是一组包含编码肢体位置和方向的2D矢量场。此方法最大的贡献是提出了部分亲和力关系PAF,从而在保持高精度的同时实现实时的效果。

在自底向下的方法中,OpenPose在一定程度上提高了检测速度。Osokin[47]在OpenPose的基础上进行优化,提出了Lightweight OpenPose。使用MobileNet v1进行特征提取,通过权重共享来减少计算量,为解决感受野较小而造成的效果不佳问题,采用空洞卷积优化算法。基于OpenPose框架,Zhu等[48]通过开发了一种冗余PAF机制来补偿原始PAF的缺陷,改进了OpenPose结构,以增加PAF中关节之间的连接,并获得比基线方法更好的性能。为了改善OpenPose算法在分辨率低或目标获取不完整的条件时性能低下的问题,Kreiss等[49]提出了一种称为PifPaf的多人姿态估计方法,该方法使用部分强度场(PIF)关系来预测身体部位的位置,同时使用PAF关联身体部位,确定单个完整的人体姿态并进行分组,复合的PAF可以对细粒度的信息进行编码。在低分辨率和遮挡场景下,该方法优于以前基于OpenPose的方法。在OpenPose的影响下,Newell等[50]引入了关联嵌入,这是一种监督卷积神经网络进行检测和分组任务的新方法。网络同时进行输出检测和组分配,这种网络可以嵌入其他网络架构中。继关联嵌入之后,Jin等[51]提出了一种新的可微分分层图分组(HGG)方法,用于学习自底向上多人姿态估计任务中的图分组。

此外,HGG很容易嵌入主流自底向上方法。它将人类关键点候选作为图节点,并在多层图神经网络模型中对关键点进行聚类。HGG的模块可以通过关键点检测网络进行端到端的训练,并且能够以分层方式监控分组过程。基于关联嵌入和HRNet,Cheng等[52]提出了HRNet的扩展,称为高分辨率网络,用于使用高分辨率特征金字塔学习尺度感知表示,并对其进行多分辨率监督训练。在推断过程中,具有多分辨率热图聚合的HigherHRNet能够有效地生成多分辨率和更高分辨率热图,以实现更精确的人体姿态估计。Yu等[53]提出了一种用于人体姿态估计的高效高分辨率网络LiteHRNet。引入了一个轻量级单元,即条件信道加权,以取代无序块中代价高昂的逐点(1×1)卷积。信道加权的复杂度相对于信道数量是线性的,并且低于逐点卷积的二次时间复杂度。

自底向上的HPE方法也采用了多任务结构。Papandreou等[54]引入了PersonLab,将姿势估计模块和人物分割模块结合起来,用于关键点检测和关联。PersonLab由短程偏移(用于细化热图)、中程偏移(预测关键点)和长程偏移(将关键点分组为实例)组成。多任务结构也用于自底向上的HPE方法。Kocabas等[55]提出了一种多任务学习模型,该模型具有一个名为MultiPoseNet的姿态残差网络,可以执行关键点预测、人类检测和语义分割任务。

准确回归关键点位置需要学习关注关键点区域。Geng等[56]提出一种简单而有效的方法,称为解纠缠关键点回归。通过逐像素空间变换器采用自适应卷积来激活关键点区域中的像素,并相应地进行学习。热图回归是当今人体姿态估计中较普遍的方法。地面实况热图通常通过二维高斯核覆盖所有骨架关键点来构建。这些核的标准偏差是固定的。然而,对于需要处理大量人类尺度差异和标签歧义的自底向上的方法,Luo等[57]提出了尺度自适应热图回归方法,该方法可以自适应地调整每个关键点的标准差。由于计算成本高,很难在资源受限的边缘设备上部署最先进的姿态估计模型。HRNet的高分辨率分支对于低计算区域的模型来说是多余的,移除它们可以提高效率和性能。受这一发现的启发,Wang等[58]设计了LitePose用于姿态估计的高效单分支架构,并引入了两种简单的方法来增强LitePose的能力,包括融合解卷积头和大核卷积。大核卷积显著提高了模型的容量和接受域,同时保持了较低的计算成本。

2.3 小结自顶向下方法中,计算量会随着检测目标的增多而加大。而自底向上方法与图像中人数无关,因此检测速度比较快,但是如果人体之间有较大重叠,对检测关键点进行分组时就变得比较困难。所以,想要获得更高的识别精度,就需要基于自顶向下的姿态估计方法进行研究;想要获得更快的识别速度,自底向上的姿态估计方法将是最佳选择,表 2列出了这两种方法及其模型的优、缺点。

|

|

表 2 多人姿态估计方法对比 Tab. 2 Comparison of multi-human pose estimation methods |

近年来,2D人体姿态估计算法已取得显著的成果,在视频监控、分割、自动驾驶、行为分析、面部情绪识别和步态分析等领域都取得了广泛的应用。相关研究在受到广泛关注的同时,仍存在很多制约因素,二维人体姿态估计仍然存在许多问题与挑战。

1) 算法效率受复杂环境因素影响较大。

光照及遮挡等问题,在多人姿态估计中易导致人体检测框的误检和冗余,重叠的关节点导致关节点分组的错误;不同视角导致无法正确判断人体比例,影响姿态估计鲁棒性。

2) 算法复杂无法满足实时预测的要求。

基于深度学习的神经网络运算量较大,且相较于分类任务和检测任务,人体姿态检测需要更高分辨率的输出特征图,大大增加了算法计算量。

3) 人体姿态的变化复杂与多样。

对于人体不同的运动姿态,估计结果精度不同,幅度较大的姿态往往预测准确度较低。人的身体构造复杂,肢体表达自由度高,这都会导致出现自我闭塞或者复杂的人体姿势。

基于对以上限制因素的分析, 考虑现实应用需求,未来的工作可从如下几方面开展。

1) 提高对复杂场景的适应性。

未来可以利用多视角信息融合方法,通过多路匹配算法[59]对多视角中二维姿态进行聚类,然后利用不同视角下的互补信息来解决复杂场景下人体相互遮挡、相互截断等问题。研究肢体遮挡修复算法的及姿态连续性信息,有助于还原姿态失真。

2) 简化运算参数。

随着人体姿态在现实生活中的应用,降低计算成本也成为了科研工作者的研究方向之一。卷积网络框架是人体姿态估计工作的核心部分,轻量级卷积网络结构能够有效降低算法复杂度,减少运算量。通过近年来的研究,可以考虑利用一些包括蒸馏法、分组卷积以及逐点卷积等轻量化网络算法,应用到人体姿态估计中。

3) 多模式学习。

使用单个模型进行人体姿态估计往往会导致姿态的特征表示过于复杂而难以学习,因而如何设计网络根据不同的姿态模式学习不同的组件,降低学习特征表示的复杂度, 简化学习过程,将是未来基于多模式学习的人体姿态估计算法研究的重点。

4) 模型向半监督,甚至无监督模式发展。

现有主流的人体姿态估计模型需要大量的标注好的训练数据。手工标注数据集不仅耗时耗力,而且标注质量参差不齐,存在一定局限性,泛化能力差。使用无监督学习模型在未标注数据上可自我学习,甚至可以采取无监督训练方法,采用无标签训练数据,可进一步提升模型对场景的适应性。

4 结束语2D人体姿态估计是计算机视觉的研究热点,本文对近年来基于深度学习的二维人体姿态估计算法进行了回顾、分析与对比,探讨了2D人体姿态估计目前所面临的挑战以及未来发展趋势。

| [1] |

FISCHLER M A, ELSCHLAGER R A. The representation and matching of pictorial structures[J]. IEEE transactions on computers, 1973, C22(1): 67-92. (  0) 0) |

| [2] |

YANG Y, RAMANAN D. Articulated pose estimation with flexible mixtures-of-parts[C]//Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2011: 1385-1392.

(  0) 0) |

| [3] |

LECUN Y, BOSER B, DENKER J S, et al. Backpropagation applied to handwritten zip code recognition[J]. Neural computation, 1989, 1(4): 541-551. DOI:10.1162/neco.1989.1.4.541 (  0) 0) |

| [4] |

GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[EB/OL]. (2014-06-10)[2022-08-19]. https://doi.org/10.48550/arXiv.1406.2661.

(  0) 0) |

| [5] |

SUN K, XIAO B, LIU D, et al. Deep high-resolution representation learning for human pose estimation[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 5686-5696.

(  0) 0) |

| [6] |

TOSHEV A, SZEGEDY C. DeepPose: human pose estimation via deep neural networks[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press 2014: 1653-1660.

(  0) 0) |

| [7] |

CARREIRA J, AGRAWAL P, FRAGKIADAKI K, et al. Human pose estimation with iterative error feedback[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2016: 4733-4742.

(  0) 0) |

| [8] |

SUN X, SHANG J X, LIANG S, et al. Compositional human pose regression[C]//IEEE International Conference on Computer Vision. Piscataway: IEEE Press, 2017: 2621-2630.

(  0) 0) |

| [9] |

LUVIZON D C, TABIA H, PICARD D. Human pose regression by combining indirect part detection and contextual information[J]. Computers & graphics, 2019, 85: 15-22. (  0) 0) |

| [10] |

LI K, WANG S J, ZHANG X, et al. Pose recognition with cascade transformers[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2021: 1944-1953.

(  0) 0) |

| [11] |

RUDER S. An overview of multi-task learning in deep neural networks[EB/OL]. (2017-06-15)[2022-08-19]. https://doi.org/10.48550/arXiv.1706.05098.

(  0) 0) |

| [12] |

LI S J, LIU Z Q, CHAN A B. Heterogeneous multi-task learning for human pose estimation with deep convolutional neural network[C]//IEEE Conference on Computer Vision and Pattern Recognition Workshops. Piscataway: IEEE Press, 2014: 488-495.

(  0) 0) |

| [13] |

FAN X C, ZHENG K, LIN Y W, et al. Combining local appearance and holistic view: dual-source deep neural networks for human pose estimation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2015: 1347-1355.

(  0) 0) |

| [14] |

LUVIZON D C, PICARD D, TABIA H. 2D/3D pose estimation and action recognition using multitask deep learning[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2018: 5137-5146.

(  0) 0) |

| [15] |

MAO W, GE Y T, SHEN C H, et al. TFPose: direct human pose estimation with transformers[EB/OL]. (2021-03-29)[2022-08-19]. https://doi.org/10.48550/arXiv.2013.15320.

(  0) 0) |

| [16] |

MAO W, GE Y T, SHEN C H, et al. Poseur: direct human pose regression with transformers[EB/OL]. (2022-01-19)[2022-08-19]. https://doi.org/10.48550/arXiv.2201.07412.

(  0) 0) |

| [17] |

TOMPSON J, JAIN A, LECUN Y, et al. Joint training of a convolutional network and a graphical model for human pose estimation[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems. New York: ACM Press, 2014: 1799-1807.

(  0) 0) |

| [18] |

LIFSHITZ I, FETAYA E, ULLMAN S. Human pose estimation using deep consensus voting[C]//Proceedings of the 14th European Conference on Computer Vision. Cham: Springer International Publishing, 2016: 246-260.

(  0) 0) |

| [19] |

WEI S H, RAMAKRISHNA V, KANADE T, et al. Convolutional pose machines[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2016: 4724-4732.

(  0) 0) |

| [20] |

YANG W, LI S, OUYANG W L, et al. Learning feature Pyramids for human pose estimation[C]//IEEE International Conference on Computer Vision. Piscataway: IEEE Press, 2017: 1290-1299.

(  0) 0) |

| [21] |

NEWELL A, YANG K, DENG J. Stacked Hourglass Networks for Human Pose Estimation[C]//Proceedings of the 14th European Conference on Computer Vision. New York: ACM Press, 2016: 483-499.

(  0) 0) |

| [22] |

CHU X, YANG W, OUYANG W L, et al. Multi-context attention for human pose estimation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2017: 5669-5678.

(  0) 0) |

| [23] |

ZHANG F, ZHU X T, YE M. Fast human pose estimation[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 3512-3521.

(  0) 0) |

| [24] |

CHEN Y, SHEN C H, WEI X S, et al. Adversarial PoseNet: a structure-aware convolutional network for human pose estimation[C]//IEEE International Conference on Computer Vision. Piscataway: IEEE Press, 2017: 1221-1230.

(  0) 0) |

| [25] |

CHOU C J, CHIEN J T, CHEN H T. Self adversarial training for human pose estimation[C]//Asia-Pacific Signal and Information Processing Association Annual Summit and Conference. Piscataway: IEEE Press, 2019: 17-30.

(  0) 0) |

| [26] |

PENG X, TANG Z Q, YANG F, et al. Jointly optimize data augmentation and network training: adversarial data augmentation in human pose estimation[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2018: 2226-2234.

(  0) 0) |

| [27] |

JAIN A, TOMPSON J, LECUN Y, et al. MoDeep: a deep learning framework using motion features for human pose estimation[C]//Proceedings of the 12th Asian Conference on Computer Vision. Cham: Springer International Publishing, 2015: 302-315.

(  0) 0) |

| [28] |

PFISTER T, CHARLES J, ZISSERMAN A. Flowing ConvNets for human pose estimation in videos[C]//IEEE International Conference on Computer Vision. Piscataway: IEEE Press, 2016: 1913-1921.

(  0) 0) |

| [29] |

YANG W, OUYANG W L, LI H S, et al. End-to-end learning of deformable mixture of parts and deep convolutional neural networks for human pose estimation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2016: 3073-3082.

(  0) 0) |

| [30] |

CHU X, OUYANG W L, LI H S, et al. Structured feature learning for pose estimation[EB/OL]. (2016-03-30)[2022-08-19]. https://doi.org/10.48550/arXiv.1603.09065.

(  0) 0) |

| [31] |

KE L, CHANG M C, QI H, et al. Multi-scale structure-aware network for human pose estimation[EB/OL]. (2018-03-27)[2022-08-19]. https://doi.org/10.48550/arXiv.1803.09894.

(  0) 0) |

| [32] |

TANG W, YU P, WU Y. Deeply learned compositional models for human pose estimation[C]//European Conference on Computer Vision. Cham: Springer International Publishing, 2018: 197-214.

(  0) 0) |

| [33] |

TANG W, WU Y. Does learning specific features for related parts help human pose estimation?[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 1107-1116.

(  0) 0) |

| [34] |

XIAO B, WU H P, WEI Y C. Simple baselines for human pose estimation and tracking[C]//Proceedings of the 15th European Conference on Computer Vision. Cham: Springer International Publishing, 2018: 472-487.

(  0) 0) |

| [35] |

WANG J, LONG X, GAO Y, et al. Graph-PCNN: two stage human pose estimation with graph pose refinement[EB/OL]. (2020-07-21)[2022-08-19]. https://doi.org/10.48550/arXiv.2007.10599.

(  0) 0) |

| [36] |

CAI Y H, WANG Z C, LUO Z X, et al. Learning delicate local representations for multi-person pose estimation[EB/OL]. (2020-03-09)[2022-08-19]. https://doi.org/10.48550/arXiv.2003.04030.

(  0) 0) |

| [37] |

IQBAL U, GALL J. Multi-person pose estimation with local joint-to-person associations[M]//Lecture Notes in Computer Science. Cham: Springer International Publishing, 2016: 627-642.

(  0) 0) |

| [38] |

PAPANDREOU G, ZHU T, KANAZAWA N, et al. Towards accurate multi-person pose estimation in the wild[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE press, 2017: 3711-3719.

(  0) 0) |

| [39] |

CHEN Y L, WANG Z C, PENG Y X, et al. Cascaded pyramid network for multi-person pose estimation[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE press, 2018: 7103-7112.

(  0) 0) |

| [40] |

SU K, YU D D, XU Z Q, et al. Multi-person pose estimation with enhanced channel-wise and spatial information[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE press, 2020: 5667-5675.

(  0) 0) |

| [41] |

QIU L T, ZHANG X Y, LI Y R, et al. Peeking into occluded joints: a novel framework for crowd pose estimation[EB/OL]. (2020-03-23)[2022-08-19]. https://doi.org/10.48550/arXiv.2003.10506.

(  0) 0) |

| [42] |

RAFI U, DOERING A, LEIBE B, et al. Self-supervised keypoint correspondences for multi-person pose estimation and tracking in videos[EB/OL]. (2020-04-27)[2022-08-19]. https://doi.org/10.1007/978-3-030-58565-5_3.

(  0) 0) |

| [43] |

LI Y J, ZHANG S K, WANG Z C, et al. TokenPose: learning keypoint tokens for human pose estimation[EB/OL]. (2021-04-08)[2022-08-19]. https://doi.org/10.48550/arXiv.2104.03516.

(  0) 0) |

| [44] |

PISHCHULIN L, INSAFUTDINOV E, TANG S Y, et al. DeepCut: joint subset partition and labeling for multi person pose estimation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2016: 4929-4937.

(  0) 0) |

| [45] |

INSAFUTDINOV E, PISHCHULIN L, ANDRES B, et al. DeeperCut: a deeper, stronger, and faster multi-person pose estimation model[C]//Proceedings of the 14th European Conference on Computer Vision. Cham: Springer International Publishing, 2016: 34-50.

(  0) 0) |

| [46] |

CAO Z, HIDALGO G, SIMON T, et al. OpenPose: realtime multi-person 2D pose estimation using part affinity fields[J]. IEEE transactions on pattern analysis and machine intelligence, 2021, 43(1): 172-186. DOI:10.1109/TPAMI.2019.2929257 (  0) 0) |

| [47] |

OSOKIN D. Real-time 2D multi-person pose estimation on CPU: lightweight OpenPose[EB/OL]. (2018-11-29)[2022-08-19]. https://doi.org/10.48550/arXiv.1811.12004.

(  0) 0) |

| [48] |

ZHU X, JIANG Y. Multi-person pose estimation for PoseTrack with enhanced part affinity fields[C]//European Conference on Computer Vision. Berlin: Springer Press, 2018: 221-226.

(  0) 0) |

| [49] |

KREISS S, BERTONI L, ALAHI A. PifPaf: composite fields for human pose estimation[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 11969-11978.

(  0) 0) |

| [50] |

NEWELL A, HUANG Z, DENG J. Associative embedding: end-to-end learning for joint detection and grouping[C]//Proceedings of the 31st Annual Conference on Neural Information Processing Systems. Piscataway: IEEE Press, 2017: 2274-2284.

(  0) 0) |

| [51] |

JIN S, LIU W T, XIE E Z, et al. Differentiable hierarchical graph grouping for multi-person pose estimation[EB/OL]. (2020-07-23)[2022-08-19]. https://doi.org/10.48550/arXiv.2007.11864.

(  0) 0) |

| [52] |

CHENG B W, XIAO B, WANG J D, et al. HigherHRNet: scale-aware representation learning for bottom-up human pose estimation[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 5385-5394.

(  0) 0) |

| [53] |

YU C Q, XIAO B, GAO C X, et al. Lite-HRNet: a lightweight high-resolution network[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2021: 10435-10445.

(  0) 0) |

| [54] |

PAPANDREOU G, ZHU T, CHEN L C, et al. PersonLab: person pose estimation and instance segmentation with a bottom-up, part-based, geometric embedding model[C]//Proceedings of the 15th European Conference on Computer Vision. Cham: Springer International Publishing, 2018: 282-299.

(  0) 0) |

| [55] |

KOCABAS M, KARAGOZ S, AKBAS E. MultiPoseNet: fast multi-person pose estimation using pose residual network[EB/OL]. (2018-07-01)[2022-08-19]. https://doi.org/10.48550/arXiv.1807.04067.

(  0) 0) |

| [56] |

GENG Z G, SUN K, XIAO B, et al. Bottom-up human pose estimation via disentangled keypoint regression[EB/OL]. (2021-04-21)[2022-08-19]. https://doi.org/10.48550/arXiv.2104.02300.

(  0) 0) |

| [57] |

LUO Z, WANG Z, HUANG Y, et al. Rethinking the heatmap regression for bottom-up human pose estimation[EB/OL]. (2020-12-30)[2022-08-19]. https://doi.org/10.48550/arXiv.2012.15175.

(  0) 0) |

| [58] |

WANG Y H, LI M Y, CAI H, et al. Lite pose: efficient architecture design for 2D human pose estimation[EB/OL]. (2022-05-03)[2022-08-19]. https://doi.org/10.48550/arXiv.2205.01271.

(  0) 0) |

| [59] |

DONG J T, JIANG W, HUANG Q X, et al. Fast and robust multi-person 3D pose estimation from multiple views[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE Press, 2020: 7784-7793.

(  0) 0) |

2024, Vol. 56

2024, Vol. 56