2. 大秦铁路股份有限公司 山西 太原 030024;

3. 河北省科学技术情报研究院 河北省科技信息处理实验室 河北 石家庄 050021

2. Daqin Railway Co., Ltd, Taiyuan 030024, China;

3. Hebei Science and Technology Information Processing Laboratory, Hebei Institute of Science and Technology Information, Shijiazhuang 050021, China

近年来,知识图谱技术促进了自然语言处理与文本语义分析[1]的发展。其中,借助实体关系抽取技术来理解文本中的深层语义信息,为文档相似性研究提供了新的思路。实体关系抽取作为信息抽取、自然语言理解、信息检索等领域的核心任务和重要环节[2],能够从文本中提取出命名实体以及实体间的关系。

实体关系抽取主要有基于流水线的方法和联合抽取方法[3]。基于流水线的方法首先对给定句子进行命名实体识别,将实体标注出来,然后针对句子进行关系抽取,模型的灵活性高、独立性好,但是关系抽取的效果依赖于实体识别的效果,同时容易忽视两个任务之间的联系,造成交互缺失。Zeng等[4]提出分段卷积神经网络来捕获结构信息,利用多示例学习进行远程监督关系提取。Zhong等[5]提出分别用于学习实体识别和关系提取的编码器,利用实体的边界信息进行关系分类。联合抽取方法是利用实体识别和关系抽取两个任务之间的交互,基于神经网络的端到端模型,同时得到实体和关系。联合抽取方法通常采用端到端抽取模型,使用神经网络联合表示实体和关系。Zheng等[6]使用LSTM与卷积神经网络的联合抽取框架,其中LSTM进行命名实体识别,卷积神经网络进行关系分类。但是,现有的联合抽取工作主要使用循环网络和卷积网络以及其改进模型,较少利用句子的结构信息。

文本相似性一般是指文字描述在语义上的相似性度量,被广泛应用于自然语言信息处理任务的诸多方面[7]。现有的文本相似性度量主要有使用词频与逆文档频率(TF-IDF)的余弦相似性、潜在语义分析的相似性、主题建模相似性以及基于泊松分布的相似性等方法。文本相似性一般有字符匹配相似度、结构相似度和语义相似度。其中,字符匹配相似度采用基本的文本相似性计算方法,如编辑距离、Jaccard距离等;结构相似度计算的关键在于分析文本的结构;语义相似度通常是将文本表示成特征向量的形式,然后利用统计方法进行相似度计算。

Chandrasekaran等[8]回顾了近年来提出的语义相似性方法的演变过程,将其分类为基于知识的方法、基于语料库的方法、基于深层神经网络的方法和混合方法。Kusner等[9]利用两个文档之间所有词的距离作为文档间的相似程度,即一个文档的嵌入单词“移动”到另一个文档所消耗的最小代价。Pan等[10]将语义信息与网络模型相结合,提出一种基于语义网络的文档相似性度量方法,为评估文档提供了一个新的视角。在当前信息极速增长的背景下,短语和句子的相似性在一些情况下无法满足海量信息检索的需求。因此,探索基于文档相似性度量的方法具有重要意义。本文提出了图神经网络实体关系联合抽取模型以及文档相似性计算模型,将文档转换为图结构,引入结构信息和语义信息来对文本进行特征提取,实现了文档相似性计算,并通过实验验证了所提出的相似度计算方法的有效性。

1 基于句法依存图的多头图注意力实体关系抽取首先对文本采用双向长短期记忆网络(bi-directional long short-term memory,BiLSTM)进行上下文特征提取,然后获得句子的句法依存图,通过图卷积神经网络进行结构区域特征提取。在此基础上,利用多头图注意力神经网络进行实体关系抽取。基于句法依存图的多头图注意力实体关系抽取模型如图 1所示。

|

图 1 基于句法依存图的多头图注意力实体关系抽取模型 Fig. 1 Entity and relation extraction model based on syntactic dependency graph and multi-head graph attention |

根据句法依存分析,词之间存在从属依赖的关系。模型将句子的依存图作为输入,依存图可以看作一个具有n个节点的有向图G,其中节点表示句子中的单词,边表示依存图中单词与单词之间的句法依存关系。将句子的依存关系表示为一个n×n的邻接矩阵An×n,若节点ni在依存关系中与节点nj相连,则将邻接矩阵中对应的Aij的值设置为1,即

| $ A_{i j}= \begin{cases}1, & \text { if } i . children =j, \\ 0, & \text { otherwise 。}\end{cases} $ | (1) |

通过将句子表示为句法依存图,可以在句子序列关系的基础上引入纵向关系即层级关系,能够更好地表示句子的结构信息,同时也有利于采用图的方式来对句子进行语义特征提取。

1.1.2 BiLSTM特征提取层LSTM[11]是循环神经网络的一种,可以学习长期依赖信息。针对长期记忆和反向传播中梯度消失和梯度爆炸问题,LSTM中引入了三个门结构:输入门、遗忘门和输出门,从而能够对输入的序列信息进行选择性记忆和遗忘。先将句子中的文本信息进行分词,再把包含n个词的文本转换成向量序列{wi, i=1,2,…,n},并且在分词之后通过句法依存分析获得词性标签。将词性标签转换为特征向量,与文本向量进行拼接,形成LSTM层的输入,

| $ \boldsymbol{x}_i=\left[\boldsymbol{E}_w\left(\boldsymbol{w}_i\right) ; \boldsymbol{E}_{tag }\left(\boldsymbol{t}_i\right)\right] 。$ | (2) |

通过BiLSTM特征提取层,将输入的文本序列信息与句子中的上下文特征充分结合,得到新的特征向量G,

| $ \boldsymbol{G}=\left[g_1, g_2, \cdots, g_n\right]=BiLSTM \left(\left[x_1, x_2, \cdots, x_n\right]\right) 。$ | (3) |

图卷积神经网络(graph convolutional network,GCN)能够将卷积操作应用到图结构上,具有强大的特征学习能力。图卷积层的输入为通过BiLSTM层进行上下文特征提取之后的节点特征向量G=[g1, g2, …, gn],以及通过句法依存图构建的邻接矩阵A。一个GCN层通过考虑相邻节点的特征来计算新的节点特征,其公式为

| $ \begin{aligned} & \boldsymbol{H}^{(l+1)}=\sigma\left(\tilde{\boldsymbol{D}}-\frac{1}{2} \tilde{\boldsymbol{A}} \tilde{\boldsymbol{D}}-\frac{1}{2} \boldsymbol{H}^{(l)} W^{(l)}\right), \\ & \tilde{\boldsymbol{A}}=\boldsymbol{A}+\boldsymbol{I}, \tilde{\boldsymbol{D}}=\sum\limits_j \tilde{\boldsymbol{A}}_{i j}, \end{aligned} $ | (4) |

其中:H(l)表示第l层文本节点信息的隐藏特征表示,是一个N×d维的特征矩阵,N为句子分词后词的个数,d为节点的特征向量维度;W(l)是可学习的权重参数;σ是非线性激活函数,实验中采用ReLU函数。

1.2 基于多头图注意力的实体关系联合抽取 1.2.1 图注意力层图注意力网络(graph attention network,GAT)[12]将注意力机制引入基于空间域的图神经网络中。在GAT中,每个节点可以根据邻居节点的特征被赋予不同的权值。定义权重矩阵W∈RF′×F,用来完成节点的特征转换过程,变换公式为

| $ \boldsymbol{z}_j=\boldsymbol{W} \boldsymbol{h}_j 。$ | (5) |

设当前节点为vi,其中一个邻居节点vj到vi的权重系数为

| $ e_{i j}=a\left(\boldsymbol{W}\left(\boldsymbol{h}_i \| \boldsymbol{h}_j\right)\right), $ | (6) |

其中:a(·)是一个共享的注意力计算函数。模型可以对任意两个节点进行注意力系数计算,但是为了保证图的结构信息,将图的结构融入图注意力机制中。

对于每个实体,计算与其相邻的节点的注意力系数。为了更好地分配权重,将当前节点与其所有邻居节点的注意力系数进行归一化处理,

| $ \alpha_{i j}=\operatorname{softmax}\left(e_{i j}\right)=\frac{\exp \left(e_{i j}\right)}{\sum\limits_{k \in N_i} \exp \left(e_{i k}\right)} 。$ | (7) |

对于线性层的运算,一般情况下都要对其进行非线性函数的激活。采用LeakyReLU激活函数,最终的注意力计算公式为

| $ \begin{aligned} & \alpha_{i j}=\operatorname{softmax}\left(LeakyReLU\left(e_{i j}\right)\right)= \\ & \frac{\exp \left(e_{i j}\right)}{\sum\limits_{k \in N_i} \exp \left(Leaky\left(e_{i k}\right)\right)}。\end{aligned} $ | (8) |

计算完节点vi的每一个相邻节点的注意力系数之后,根据权重对节点vi的所有相邻节点进行特征求和更新,作为vi的最终输出,计算公式为

| $ \boldsymbol{h}_i^{\prime}=\sigma\left(\sum\limits_{j \in N_i} \alpha_{i j} \boldsymbol{z}_{i j}\right) 。$ | (9) |

通过引入图注意力机制,对单词的不同邻居节点自适应分配不同的注意力,让模型更多地关注更重要的词节点,从而提高神经网络模型的表达能力,有助于提高实体识别以及关系抽取的准确率。

1.2.2 多头注意力层GAT层中可以计算任意两个节点之间的注意力系数。在模型中为了保留图结构信息,只计算了中心节点的一阶邻居节点的注意力系数。为进一步提升注意力层的表达能力,引入多头注意力机制[13],即对注意力计算公式建立K组相互独立的注意力机制,每组注意力机制能够针对关系进行计算,然后将输出的结果进行连接,

| $ \boldsymbol{h}_i^{\prime}=\|_{k=1}^K \sigma\left(\sum\limits_{j \in N_i} \alpha_{i j}^k \boldsymbol{z}_{i j}^k\right) 。$ | (10) |

模型将每一种关系作为一组独立的注意力机制,不同的关系注意力能够突出不同的关系,使模型具有更强大的关系学习能力,并使模型对于关系的抽取更加准确。为了将不同的关系作为独立的注意力机制来进行计算,首先为每一种关系构建相应的邻接矩阵,通过图卷积之后得到节点特征H(l)。然后,通过softmax分类扩展为所有关系对应的类别特征,每个关系形成一个邻接矩阵,作为多头图注意力层的图结构特征。对每一组注意力机制得到的特征向量进行平均操作,这样不仅可以得到一个整体的特征表示,同时也避免了特征向量维度过高,对应的计算公式为

| $ \boldsymbol{h}_i^{\prime}=\sigma\left(\frac{1}{K} \sum\limits_{k=1}^K \sum\limits_{j \in N_i} \alpha_{i j}^k \boldsymbol{z}_{i j}^k\right) 。$ | (11) |

利用加权层次类型编码以及词移距离(word mover′s distance,WMD)[9]的思想对文档间的相似性进行评价分析,提出基于WMD的融合层次类型的相似度计算模型和基于图相似的计算模型。

2.1 基于层次类型的WMD文档相似性计算 2.1.1 加权层次类型编码层次类型[14]信息暗示了一个实体在不同场景中可能扮演的不同角色,这些类型通常由层次结构构成,其中不同粒度的语义概念被认为是不同层中的子类型,大多数实体都有多个层次类型。最精确的子类型是距离实体最近的层次,即第1层,将层次结构自下而上地编号,可以得到层次类型的表示为

| $ c=\{c(1), c(2), \cdots, c(k)\} 。$ | (12) |

假设有层次类型c,其在层次类型结构中对应了一条由子类型构成的链,其中粒度由细到粗的子类型依次为c(1), c(2), …, c(k-1),其对应的投影矩阵分别为Mc(i)。由于结构中子类型的不同粒度可能在重要性上有所不同,所以通过考虑层次中不同粒度的权重,对层次类型信息进行加权,将不同权重的投影矩阵相加来表示层次类型矩阵,

| $ \begin{aligned} & \boldsymbol{M}_c=\sum\limits_{i=1}^m \beta_i \boldsymbol{M}_{c^{(i)}}= \\ & \beta_1 \boldsymbol{M}_{c^{(1)}}+\beta_2 \boldsymbol{M}_{c^{(2)}}+\cdots+\beta_m \boldsymbol{M}_{c^{(m)}}, \end{aligned} $ | (13) |

其中:m为层次结构中的层数;Mc(i)是c(i)的投影矩阵;βi是c(i)对应的权重。

2.1.2 WMD相似度计算方法WMD的思想是基于推土距离(Earth mover′s distance,EMD)[15],与欧氏距离一样,都是一种距离度量的定义,可以用来测量某两个分布之间的距离。文档距离实际上可以看成文档1转化为文档2所需要付出的总代价,词与词之间的移动代价由语义距离决定。在两个文档中,通过实体关系抽取模型已经形成实体关系图,利用加权层次类型编码将文档中实体关系映射到相同的词向量空间中,得到具有层次类型信息的实体节点表示,计算移动产生的距离总和。文档中词与词之间的距离定义为词转移代价,将实体对之间的语义相似性纳入文档距离度量。实体对之间的相似性由所在向量空间中的欧氏距离表示,

| $ c(i, j)=\left\|\boldsymbol{x}_i-\boldsymbol{x}_j\right\|_2 \text {, } $ | (14) |

其中:c(i, j)表示词i与词j的距离;xi和xj为实体对的向量表示。定义T∈Rn×n, Tij≥0表示一个文档d中的词i转移到另一个文档d′中的词j所占的权重,则文档距离可表示为

| $ \min\limits_{T \geqslant 0} \sum\limits_{i, j=1}^n T_{i j} c(i, j) 。$ | (15) |

约束条件为

| $ \sum\limits_{j=1}^n T_{i j}=d_i, \forall i \in\{1, 2, \cdots, n\},$ | (16) |

| $ \sum\limits_{i=1}^n T_{i j}=d_j^{\prime}, \forall j \in\{1, 2, \cdots, n\}, $ | (17) |

其中:di表示词i本身在文档d中所拥有的权重;dj′表示词j本身在文档d′中所拥有的权重。

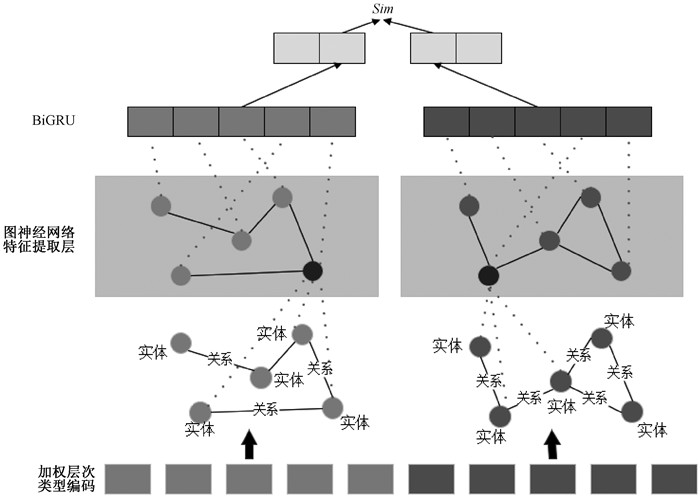

2.2 基于图相似的文档相似性计算 2.2.1 图相似性分析基于图神经网络的文档相似性计算模型的主要流程为:首先,将实体关系建模为图结构,形成由实体关系组成的文档图;然后,采用图神经网络对文档图进行特征提取,提取文档图的局部结构特征,得到能够表征整个图的特征;最后,根据图级特征对文档图进行相似度计算、分类等任务。

2.2.2 图相似性计算模型文档中所有的实体与关系三元组形成文档图G,将图G表示为邻接矩阵A∈Rn×n,文档中的实体节点通过融合层次类型信息表示为节点特征矩阵X∈Rn×d。其中:n表示图中节点的个数,即文档中实体的数量;d表示节点特征向量的维度。对于每个文档,分别获取文档图的A和X作为模型的输入。

1) 图卷积层。当文档的邻接矩阵和实体节点特征矩阵输入后,通过图卷积层的叠加和迭代,能够不断地对图的局部特征进行提取,尽可能多地获得文档图的结构特征,得到实体节点的图嵌入表示,

| $ \boldsymbol{Y}^l=f^l\left(\boldsymbol{H}^{(l)}, \boldsymbol{A}\right), $ | (18) |

其中:Yl∈Rn×dl,dl表示第l层输出的节点特征向量的维度;fl为第l层非线性激活函数。最终输出的Yl即为每一个实体节点在新的特征空间中的特征表示。

2) 图注意力层。文档图中不同节点之间产生的关系以及其对整个图的影响都不同。引入图注意力机制来计算文档图中节点之间的注意力系数,对实体的不同邻居节点分配不同的注意力,从而提高神经网络模型的表达能力,更好地提取整个文档图的特征,计算公式见式(9)。

3) Att-BiGRU特征融合层。图神经网络层得到的特征表示Y=[y1, y2, …, yn],作为BiGRU的输入特征,通过双向GRU增强实体的上下文语义信息表示,

| $ \boldsymbol{Y}^{\prime}=BiGRU(\boldsymbol{Y}) \text {, } $ | (19) |

其中:Y′∈Rd×h,h为通过BiGRU特征提取之后的向量维度。对于实体不同的TF-IDF权重赋予不同的注意力,文档中实体的注意力矩阵为Att,则表征文档的图级特征向量为

| $ \boldsymbol{f}=\boldsymbol{A} t \boldsymbol{t} \cdot \boldsymbol{Y}^{\prime}, $ | (20) |

其中:f∈R1×h;Att∈R1×n。通过模型嵌入将文档图Gi表示为图级特征fi,文档图Gj表示为图级特征fj,则两个文档之间的相似性为

| $ Sim\left(G_i, G_j\right)=\cos \left(\boldsymbol{f}_i, \boldsymbol{f}_j\right)=\frac{\boldsymbol{f}_i, \boldsymbol{f}_i}{\left\|\boldsymbol{f}_i\right\| \cdot\left\|\boldsymbol{f}_j\right\|}。$ | (21) |

基于图神经网络的文档相似性计算模型如图 2所示。

|

图 2 基于图神经网络的文档相似性计算模型 Fig. 2 Document similarity calculation model based on graph neural network |

使用的实验数据集为纽约时报语料NYT。NYT是由远程监督方法生成的新闻语料库,广泛用于重叠实体关系抽取任务,共包含24个已定义好的关系类型约束和6万多条标记样例。将NYT数据集划分为56 195条训练集、5 000条验证集和5 000条测试集。

3.1.2 结果分析选择的对比模型为CopyRE、GraphRel1p、GraphRel2p和DG-GAT。分别对不同的网络模型进行了实验,选取Precision、Recall和F1三个评价指标进行了对比,实验结果如表 1所示。可以看出,本文模型通过引入图注意力网络,相较于仅使用图卷积网络的模型,实验效果更佳。DG-GAT模型采用了注意力机制,可以计算任意两点之间的权重,分别针对不同的关系提取特征,使得注意力层能够更好地突出关系特征,排除其他关系的干扰,模型效果有了明显提高。在构建本文的多头注意力机制后,实验效果较单层图注意力层有所提升。由于多头注意力分别为每种关系建立一组独立的注意力机制,针对不同的关系对节点进行特征提取,使模型强化特征关系的识别,从而提高了关系抽取的准确性。

|

|

表 1 不同模型的实验结果 Tab. 1 Experimental results of different models |

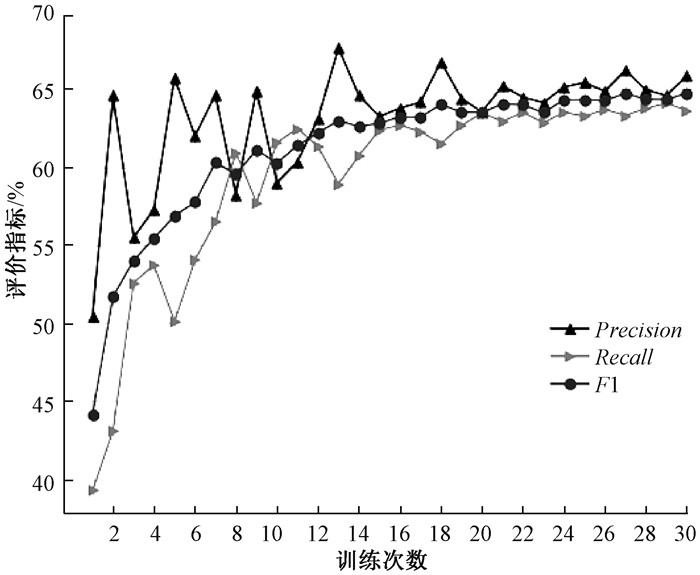

训练过程中评价指标的变化如图 3所示。可以看出,从训练开始,三个指标均呈上升趋势,其中F1值快速上升,最终趋于稳定,模型收敛较快,并且达到较好效果。

|

图 3 训练过程中评价指标的变化 Fig. 3 Changes of evaluation indexes during training |

通过基于多头图注意力的实体关系联合抽取模型,将实验数据经过实体识别、关系抽取之后形成三元组,对提取出的三元组进行处理分析,将实体和关系的实体类型信息以及位置信息融合到实体和关系的嵌入表示中,从而得到实体和关系的更细粒度的表示,最后对文档间的实体关系进行分析计算,得到文档间的相似性评价。

LCSTS是由哈尔滨工业大学深圳研究院通过新浪微博构建的大规模中文摘要数据集,主要用于自动文本摘要生成等任务。实验选取1 000条文本数据,通过降重、替换语序、改变语言表述、AI改写等方法进行处理,得到1 000组内容改写但表述基本相同的数据进行实验。

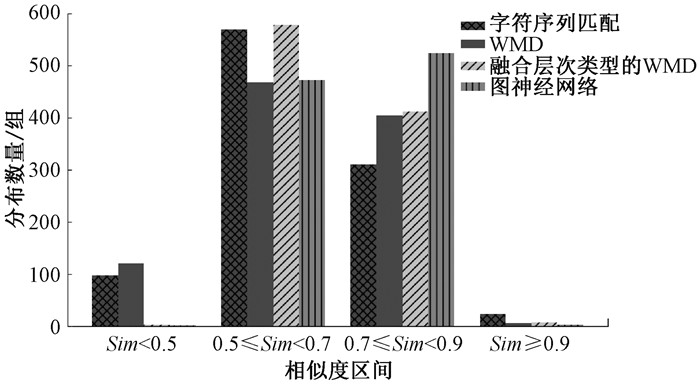

3.2.2 结果分析对1 000组相似文本进行相似性计算评分后,得到了字符序列匹配模型、WMD模型、融合层次类型的WMD模型和图神经网络模型在不同相似度区间的数量分布柱状图,如图 4所示。可以看出,融合层次类型的WMD模型的相似度区间主要集中在0.5~0.9,特别是0.5~0.7,相比于WMD模型,整体相似性有所提高;而本文的图神经网络模型在0.7~0.9区间较为突出,整体分布较其他方法有所提高。

|

图 4 数量分布柱状图 Fig. 4 Histogram of quantity distribution |

此外,使用MUTAG、PTC、IMDB-MULTI和COIL-RAG四个图分类公共数据集,通过模型在图分类任务中的表现来验证模型提取图级特征的能力能否表征整个文档。其中,MUTAG和PTC是关于化学中分子和化合物的数据集;IMDB-MULTI是社会网络数据集;COIL-RAG是图像数据集。对比模型选择了基于图嵌入的模型SPI-GCN、基于深度学习的模型DGCNN以及一种基于图核的模型Weisfeiler-Lehman(WL),不同模型的准确率结果如表 2所示。可以看出,本文模型在化学数据集上表现较好,在图像数据集上的表现不如图嵌入的方法。

|

|

表 2 不同模型的准确率结果 Tab. 2 Accuracy results of different models |

针对文档相似性计算,本文从深层语义的角度进行了分析与研究,实现了实体与关系的联合抽取,并且针对相似性匹配进行了基于WMD的融合层次类型的探索,以及通过图相似来对文档相似性计算模型进行实验,取得了一定的效果。本文采用句法依存图的方式进行构图,使用图神经网络进行抽取,在构图的方式中还有很多方法值得深入探讨。同时,图相似领域存在一些优秀的思想以及方法,如图核方式等,未来将通过设计合适的核函数来实现图相似性的计算。

| [1] |

董星彤, 陈士宏, 陈淑鑫. 自然语言处理文本查重优化算法设计[J]. 科学技术与工程, 2022, 22(3): 1091-1097. DONG X T, CHEN S H, CHEN S X. Algorithm design of text duplicated-checking based on natural language processing[J]. Science technology and engineering, 2022, 22(3): 1091-1097. DOI:10.3969/j.issn.1671-1815.2022.03.030 (  0) 0) |

| [2] |

鄂海红, 张文静, 肖思琪, 等. 深度学习实体关系抽取研究综述[J]. 软件学报, 2019, 30(6): 1793-1818. E H H, ZHANG W J, XIAO S Q, et al. Survey of entity relationship extraction based on deep learning[J]. Journal of software, 2019, 30(6): 1793-1818. (  0) 0) |

| [3] |

李冬梅, 张扬, 李东远, 等. 实体关系抽取方法研究综述[J]. 计算机研究与发展, 2020, 57(7): 1424-1448. LI D M, ZHANG Y, LI D Y, et al. Review of entity relation extraction methods[J]. Journal of computer research and development, 2020, 57(7): 1424-1448. (  0) 0) |

| [4] |

ZENG D J, LIU K, CHEN Y B, et al. Distant supervision for relation extraction via piecewise convolutional neural networks[C]//Proceedings of the Conference on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2015: 1753-1762.

(  0) 0) |

| [5] |

ZHONG Z X, CHEN D Q. A frustratingly easy approach for entity and relation extraction[C]//Proceedings of the Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg: Association for Computational Linguistics, 2021: 50-61.

(  0) 0) |

| [6] |

ZHENG S C, HAO Y X, LU D Y, et al. Joint entity and relation extraction based on a hybrid neural network[J]. Neurocomputing, 2017, 257: 59-66. DOI:10.1016/j.neucom.2016.12.075 (  0) 0) |

| [7] |

陈观林, 侍晓龙, 周梁, 等. 基于深度强化学习的文本相似语义计算模型[J]. 郑州大学学报(理学版), 2020, 52(3): 1-8. CHEN G L, SHI X L, ZHOU L, et al. A text similarity semantic computing model based on deep reinforcement learning[J]. Journal of Zhengzhou university (natural science edition), 2020, 52(3): 1-8. (  0) 0) |

| [8] |

CHANDRASEKARAN D, MAGO V. Evolution of semantic similarity: a survey[J]. ACM computing surveys, 2022, 54(2): 1-37. (  0) 0) |

| [9] |

KUSNER M J, SUN Y, KOLKIN N I, et al. From word embeddings to document distances[C]//Proceedings of the 32nd International Conference on Machine Learning. New York: ACM Press, 2015, 37: 957-966.

(  0) 0) |

| [10] |

PAN X W, HUANG P, LI S, et al. MCRWR: a new method to measure the similarity of documents based on semantic network[J]. BMC bioinformatics, 2022, 23(1): 56. DOI:10.1186/s12859-022-04578-1 (  0) 0) |

| [11] |

AHMADZADEH E, KIM H, JEONG O, et al. A deep bidirectional LSTM-GRU network model for automated ciphertext classification[J]. IEEE access, 2022, 10: 3228-3237. (  0) 0) |

| [12] |

VELIČKOVIĆ P, CUCURULL G, CASANOVA A, et al. Graph attention networks[EB/OL]. (2017-10-30)[2022-03-30]. https://doi.org/10.48550/arXiv.1710.10903.

(  0) 0) |

| [13] |

FU C Z, LIU C R, ISHI C T, et al. Multi-modality emotion recognition model with GAT-based multi-head inter-modality attention[J]. Sensors, 2020, 20(17): 4894. (  0) 0) |

| [14] |

XIE R, LIU Z, SUN M. Representation learning of knowledge graphs with hierarchical types[C]//25th International Joint Conference on Artificial Intelligence. Amsterdam: Elsevier Press, 2016: 2965-2971.

(  0) 0) |

| [15] |

BOUDAA T, MAROUANI M E, ENNEYA N. Using earth mover's distance and machine learning for recognizing textual entailment in Arabic[J]. Computación y sistemas, 2020, 24(4): 1499-1508. (  0) 0) |

2023, Vol. 55

2023, Vol. 55