随着新一轮科技革命和产业变革的深入推进,我国实施了创新驱动发展战略,强调科技创新和科技自立自强是提高社会生产力和综合国力的战略支撑。知识产权发明专利作为科技创新的有效保护手段,越来越受到个人和企业的重视。根据国家知识产权局年报数据,2019年收到专利申请5 089 000件,2020年授权专利2 980 200件[1]。大规模专利申请数量代表着我国科技创新能力的提升以及国民知识产权意识的提高,也给专利审查人员的工作带来了巨大挑战。

目前国际上常用的专利分类标准主要有国际专利分类(IPC)、欧洲专利分类号(ECLA)、美国专利分类号(UPC/USPC)等。面对大量的专利申请,有效的专利文本分类尤为重要。通过对专利的有效分类,不仅有利于为专利审查员推送合适的待审专利进行审查,还可以使申请者避免重复性研究[2]。目前的专利文本分类主要依赖于人工判别,但随着专利数量的增加和交叉领域技术的迅速发展,人工模式的专利审查工作需要占据大量的人力和时间。因此,借助智能技术协助人工完成半专利文本分类对提升分类效率和准确率具有重要的意义。

1 专利自动分类研究现状近年来,自然语言处理的研究在抽象生成、语义分析、情感识别等方面取得了一系列研究成果[3]。文本分类是自然语言处理的重要组成部分,其关键之处在于对文本特征的准确提取和对分类器的构造。

词嵌入是常用的文本表示方法之一,它将文本中的词语嵌入到空间中并以向量的形式表达出来。One-Hot[4]、词袋法(bag of words, BOW)[5]和词频-反向词频(term frequency-inverse document frequency,TF-IDF)[6]等都是常用的文本表示方法,但这些方法在追求准确性的同时会导致维数过高、稀疏性过大等问题,且对于两个意思相近的词不能很好地表达关联性[7]。随着深度学习算法在图像、语音等时序数据的大量应用,神经网络被用来实现对中文文本的向量化表示,其中最具代表性的是谷歌公司于2018年提出的BERT (bidirectional encoder representations from transformers)预训练模型。在考虑语境信息的基础上,一词多义问题得到了很好的解决,可得到序列当前最全面的局部和全局特征表示。刘秀磊等[8]提出一种基于BERT与XGBoost融合模型的航天科技开源情报分类算法,通过BERT模型的深度结构提取情报中的关键特征,利用XGBoost模型取代BERT最后的输出层,并依据BERT提取到的关键特征对相关情报进行分类。

为了更好地区分文本特征、增强语境联系,注意力机制被引入到神经网络中。赵云山等[9]在卷积神经网络(convolutional neural networks, CNN)的基础上引入注意力机制生成非局部相关度,建立了CNN-A分类模型,有效地提升了卷积神经网络模型的文本分类准确率。张冲[10]提出Attention-Based LSTM模型用于提取特征,其中长短期记忆网络(long short-term memory, LSTM)模型解决了传统递归神经网络(recurisve neural networks, RNN)的梯度消失的问题,同时通过注意力机制减少特征向量提取过程中的信息丢失和信息冗余。李洋等[11]通过对CNN特征和双向长短期记忆网络(bidirectional LSTM, BiLSTM)特征的融合完成对文本的情感分析任务。

与普通文本分类任务不同,中文专利文本中包含大量的专业术语和新兴词汇,且上下文之间的逻辑联系更加紧密,对文本特征提取方法和分类方法提出了更高的要求。薛金成等[12]提出一种LSTM-A文本分类模型,有效提升高相似度专利文本的分类准确率。Yu等[13]提出一种基于强化学习的TRIZ中文专利分类结构化框架。杜恒欣等[14]结合卷积神经网络提取局部特征和BiLSTM提取全局特征的优势,在BiLSTM隐藏层引入注意力机制,构建了针对中文专利文本分类的BiLSTM-Att-CNN组合模型。Xu等[15]提出了一个通过专利分析和深度学习绘制新兴产业价值链技术景观的框架,使用生成式对抗网络作为数据增强方法,克服新兴行业专利样本少的问题。

为了实现对中文专利文本的准确分类,本文结合预训练的BERT模型以及双向门控网络(bidirectional gated recurrent unit, BiGRU),提出一种基于BERT-BiGRU模型的中文专利自动分类方法。首先使用词嵌入、全词掩码等增强语义表征模型对中文发明专利文本中上下文语境信息进行提取、表征;其次引入多头注意力机制强化语义表征序列之间的侧重关系;最后通过双向GRU门控网络从顺序和逆序两方面对文本向量化特征进行学习并训练模型,实现对中文发明专利文本的准确分类。

2 基于BERT-BiGRU的文本分类方法相较于日常文本数据,中文专利文本具有专业性强、逻辑性更紧密的特点。考虑到专利文本中专业词汇繁多等因素,且可以充分利用文本上下文联系,本文主要采用BERT模型实现对中文专利文本从文字到语义向量表征的转化。在文本读取完成后,对中文文本进行字嵌入、句子嵌入及位置嵌入,运用全词掩码、多头注意力机制等技术增强模型的语义表征能力,构成当前中文专利文本的增强语义表征向量,完成从中文字符到向量的转化。利用不同种类专利文本的增强语义表征向量及分类标签,最后通过双向GRU实现对中文专利的分类任务。

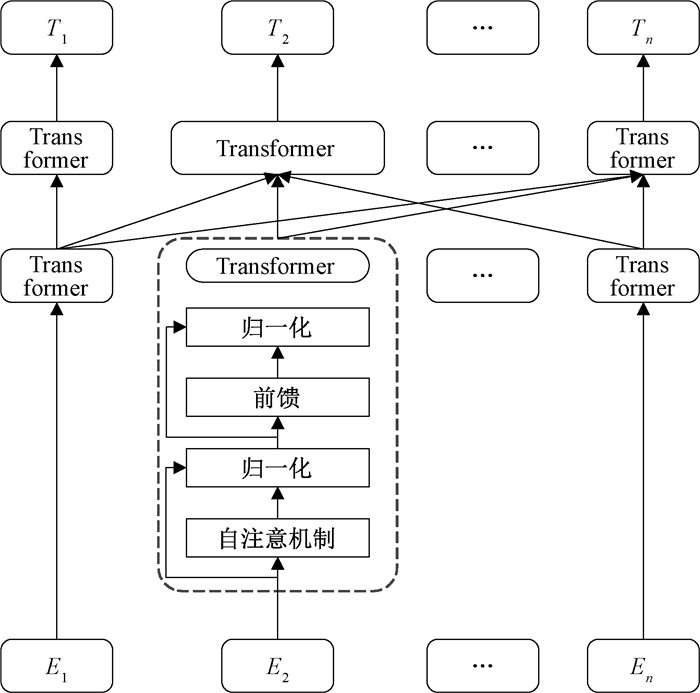

2.1 BERT模型BERT是一个预训练的语义表征模型,它从大规模语料数据中学习到通用的语义表示,通过微调后适用于下游任务[16]。预训练过程提供了更优的模型初始化方法,有助于提高模型的泛化能力以及加速模型收敛。BERT沿用了Transformer架构中的编码器(Encoder)模块,构成一种基于Transformer中编码器模块的多层双向编码模型,保留其双向编码能力和强大的特征提取能力。BERT模型的结构如图 1所示。

|

图 1 BERT模型结构 Fig. 1 Structure of BERT model |

BERT模型在得到输入文本后,首先利用词嵌入(word embeddings)对文本进行编码[17],包括字嵌入(token embeddings)、句子嵌入(segment embeddings)、和位置嵌入(position embeddings),分别得到字向量、句子向量和位置向量,如图 2所示。

|

图 2 BERT词嵌入方式 Fig. 2 Word embedding method of BERT |

在词嵌入过程中输入文本会被添加[CLS]和[SEP]两个特殊标记,[CLS]位于文本开头,[SEP]置于每一句的结尾,如图 2所示。字向量是由BERT模型查询字向量表将文本中的每个字转化而来,句子向量用于表征文本的全局语义信息,并与字的语义信息相融合,位置向量用于表征出现在文本不同位置的字所携带的语义信息差异。由字向量、句子向量和位置向量的累加和构成融合全文语义信息的向量表示,作为BERT模型的输入。

BERT模型还构建了掩码语言模型(masked language model, MLM)和下一句预测(next sentence prediction, NSP)两个预训练任务。MLM任务通过预测被掩码代替的原始单字来学习上下文特征,注重字在句子中的关系特征。NSP任务通过预测两个句子是否连在一起,让模型学习连续文本片段之间的关系,使模型具备理解长序列上下文联系的能力。但是随着BERT模型在中文文本处理中的广泛应用,仅对单字进行掩码显然不符合中文语义,如“本发明”被单字掩码后变为“本[MASK]明”,造成当前词语语义缺失。有研究使用全词掩码(whole word masking, WWM)对单字所在的词进行掩码,如“本发明”被全词掩码后变为“本[MASK][MASK]”,提升BERT模型在中文文本处理中对上下文语义的学习能力。

2.2 多头注意力机制自注意力机制是文本编码中的重要一环,它可以通过调节权重的方式使模型更注重于学习我们所认为的关键信息[18]。对输入文本中的每个字分别增强语义向量表示,加权融合文本中所有字的语义信息,得到各个字的增强语义向量。构造Q、K和V三个矩阵来查询当前单词与上下文中其他单词之间的关系,并更新特征向量。更新后的词向量包含了整个句子的信息,从而得到当前词的上下文关系。利用自注意力机制可以使文本语境整合到当前词汇的编码中,有区分地利用上下文信息增强目标字的语义表示。编码器模块中的自注意机制的计算可以表示为

| $ {Attention}(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V})={softmax}\left(\frac{\boldsymbol{Q} \boldsymbol{K}^{\mathrm{T}}}{\sqrt{d_k}}\right) \boldsymbol{V}, $ | (1) |

其中:Q、K、V是当前输入与上下文中其他字之间关系的权重系数;dk是当前输入的维数。为了扩展模型关注不同位置的能力,并增加注意力单元的“呈现子空间”,Transformer采用了“多头”模式,可表示为

| $ 当 { head }_i= { Attention }\left(\boldsymbol{Q} \boldsymbol{W}_i^Q, \boldsymbol{K} \boldsymbol{W}_i^K, \boldsymbol{V} \boldsymbol{W}_i^V\right)\\ {MultiHead}(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V})={Concat}\left( { head }_1, \cdots, { head }_m\right) \boldsymbol{W}^o $ | (2) |

其中:WiQ∈Rdmodel×dk;WiK∈Rdmodel×dk;WiV∈Rdmodel×dv;WO∈Rhdv×dmodel;dk=dv=dmodel/m,m为多头注意力机制“头”数量。用不同的自注意力模块获得文本中每个字在不同语义空间下的增强语义向量,并将每个字的多个增强语义向量进行线性组合,从而获得一个最终与原始字向量长度相同的增强语义向量。

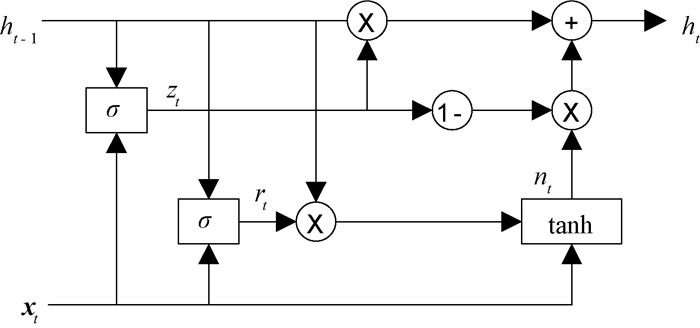

2.3 双向GRULSTM和GRU都是RNN的改进模型,很好地解决了RNN网络中的梯度消失等问题[19]。GRU神经网络优化了LSTM模型的结构,并将三个选通单元合并为两个选通单元,即更新门和重置门,GRU神经网络基本单元如图 3所示。更新门控制前一时刻的状态信息进入当前状态。重置门决定如何将新的输入信息与存储器相结合。GRU模型具有较少的参数和较低的训练开销,能自适应地捕捉序列数据之间的信息传递关系。

|

图 3 GRU神经网络基本单元 Fig. 3 Basic unit of GRU neural network |

如图 3所示,专利文本被BERT模型进行语义表征后转化为增强语义向量xt,通过上一时刻状态信息ht-1和当前输入xt获得更新门状态zt和重置门状态rt:

| $ r_t=\sigma\left(\boldsymbol{W}_{x r} \boldsymbol{x}_t+\boldsymbol{W}_{h r} h_{t-1}+b_r\right), $ | (3) |

| $ z_t=\boldsymbol{\sigma}\left(\boldsymbol{W}_{x z} \boldsymbol{x}_t+\boldsymbol{W}_{h z} h_{t-1}+b_z\right), $ | (4) |

其中:rt是复位门输出;zt是更新门输出;ht是候选隐藏状态;Wxr和Wxz分别表示输入xt与重置门、更新门之间的权重矩阵;Whr和Whz分别表示ht-1与重置门、更新门之间的权重矩阵;br与bz为对应偏置量;σ是Sigmoid函数,它可以将计算结果转换为[0, 1]的范围。更新门的值越接近1,则从上一时刻引入的状态信息越多。重置门的值越接近1,前一时刻写入的状态信息就越多。在此基础上可以计算当前状态信息ht,

| $ n_t=\tanh \left(\boldsymbol{W}_{x n} \boldsymbol{x}_t+b_{x n}+r_t \circ\left(\boldsymbol{W}_{h n} h_{t-1}+b_{h n}\right)\right), $ | (5) |

| $ h_t=\left(1-z_t\right) \circ n_t+z_t \circ h_{t-1}, $ | (6) |

其中:○表示哈达玛积(Hadamard product);Wxn、Whn和bxn分别为权重矩阵和偏置量;激活函数tanh用于将数据缩放到[-1, 1]。GRU可以通过门控机制保留增强语义向量中的重要信息,以确保上下文信息的有效传递。

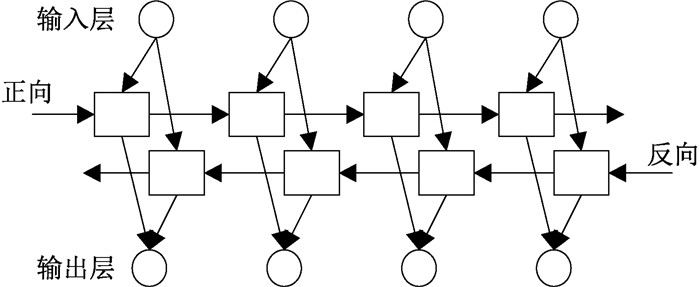

双向GRU是指分别在时间维度上以顺序和逆序,依次处理输入的文本向量化语义表征特征,并将每一个词的GRU输出拼接成为最终输出[20]。这样每个词的输出节点都包含了当前词完整的顺序上文和逆序下文的语义信息,双向GRU网络模型结构如图 4所示。

|

图 4 双向GRU网络模型结构 Fig. 4 Bidirectional GRU network model |

本文选取IPC国际专利主分类号中的“部”作为分类依据,共有8个类别,各类别的具体含义如表 1所示。

|

|

表 1 IPC主分类号含义 Tab. 1 Meaning of IPC main classification number |

从Incopat专利数据库下载中文发明专利数据作为数据集,导出为Excel表格形式,其中包含专利的标题、摘要、申请人、IPC主分类号等信息,以中文专利文本的标题和摘要作为当前样本的文本表述,以IPC主分类号中的“部”作为分类标签。每个类别包含25 000条数据样本,其中15 000条作为训练集,5 000条作为验证集,5 000条作为测试集。自制中文专利文本数据集共包括200 000条样本数据,其中训练集120 000条,验证集40 000条,测试集40 000条。

3.2 模型评价指标阳性-阴性混淆矩阵可以表示常用分类模型针对不同任务的分类情况,如表 2所示,其中TP、FP、FN、TN分别表示真阳性、假阳性、假阴性、真阴性。

|

|

表 2 混淆矩阵 Tab. 2 Confusion matrix |

本文选择准确率A(Accuracy)、精确率P(Precision)、召回率R(Recall)和F1值(F1-Score)四个评价指标对实验模型进行评估。根据阳性-阴性混淆矩阵,各个评价指标的计算方式分别为

| $ A=(T P+T N) /(T P+T N+F N+F P), $ | (7) |

| $ P=T P /(T P+F P) , $ | (8) |

| $ R=T P /(T P+F N) , $ | (9) |

| $ F_1=(2 \times P \times R) /(P+R)。$ | (10) |

本文所用实验平台的处理器为i5-4460,内存为8 G(1 600 MHz),网络搭建框架为PyTouch,本地GPU为GTX 950,云GPU为RTX2080 Ti (11 G)。以哈工大讯飞联合实验室提供的RoBERTa-wwm-ext-large作为BERT预训练模型。选择TextCNN、TextRNN、BERT-CNN、BERT-LSTM作为对比模型。

1) TextCNN:先将文本分词进行词嵌入得到词向量,将词向量经过卷积抽取文本上下文特征,经过全连接层完成文本分类任务。

2) TextRNN:先将文本分词进行词嵌入得到词向量,经过RNN单元计算各个时间步长上的隐藏状态,表征为上下文特征,经过全连接层完成文本分类任务。

3) BERT-CNN:利用预训练的BERT模型完成对中文发明专利文本的向量化语义表征,经过卷积神经网络实现文本分类。

4) BERT-LSTM:利用预训练的BERT模型完成对中文发明专利文本的向量化语义表征,经过长短期记忆网络实现文本分类。

TextCNN、TextRNN模型中的词向量维度设置为300,句子向量长度为每句话处理成的长度,短填长切,训练过程中若超过3 000批次效果还没提升,则提前结束训练。考虑到计算资源问题,在使用BERT模型时,选择较小的批次样本数和句子向量长度。经过试验分析,各模型的具体参数如表 3所示。

|

|

表 3 模型参数设置 Tab. 3 Model parameters setting |

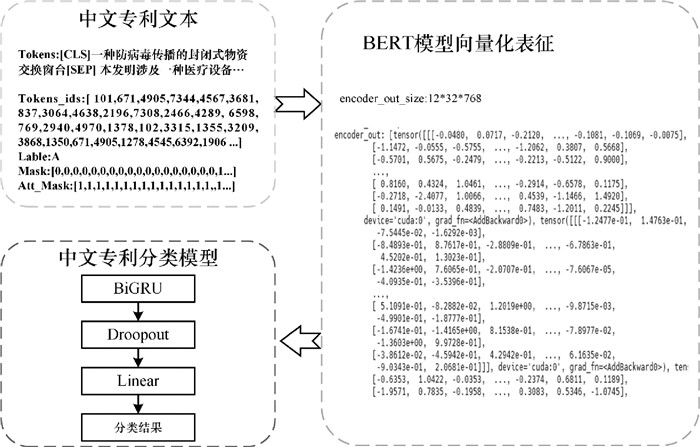

以一条A类专利样本为例,利用本文方法对其文本信息进行处理,相关处理过程如图 5所示。

|

图 5 样本处理过程 Fig. 5 Sample processing |

首先对中文专利文本进行词嵌入、掩码生成等处理,再经过BERT模型和注意力机制生成当前中文文本的向量化表征,图 5中示例为12*32*768的矩阵形式,最后利用基于BiGRU的中文专利分类模型实现准确分类。

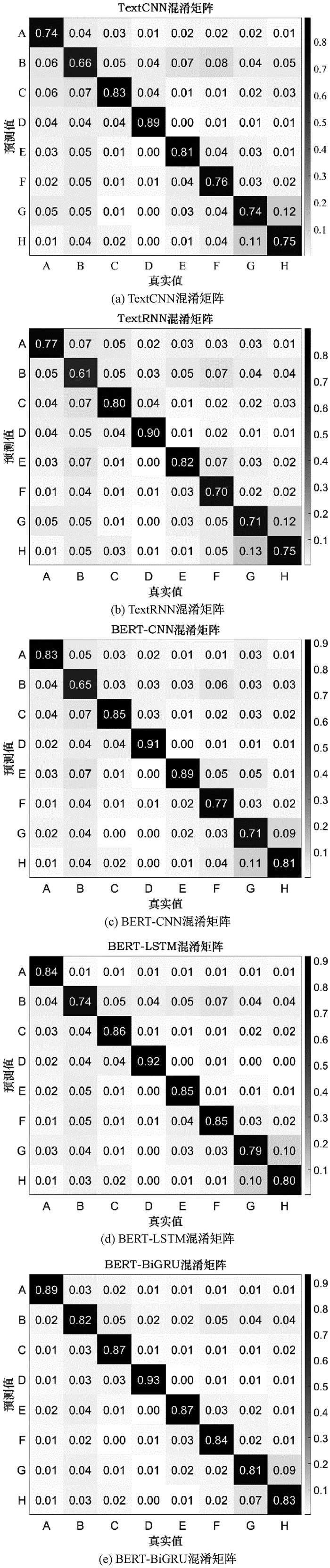

在实验平台上对TextCNN、TextRNN、BERT-CNN、BERT-LSTM以及本文提出的BERT-BiGRU模型进行训练并测试,以混淆矩阵的形式展示各个模型在测试集上的表现,测试结果如图 6所示。

|

图 6 不同模型的混淆矩阵 Fig. 6 Confusion matrices of different models |

从图 6中可以看出,各个模型的分类误差主要集中在“B”类、“G”类和“H”类。其中“B”类是作业、运输类,与其他7类之间的错误划分表明“B”类与其余类之间差异性较小。“G”类物理类和“H”类电学类本身存在紧密的学科交叉,在专业性研究中界限不清晰,文本描述等方面相似性强,容易造成错误分类。反而“D”类纺织和造纸类行业相对独立,专利文本分类效果最好,普遍达到90%以上。

从TextCNN、TextRNN的混淆矩阵可以看出,与日常文本分类任务相比,TextCNN和TextRNN对中文发明专利文本自动分类问题的表现并不突出,表明了中文发明专利文本与日常文本的差异性,中文发明专利文本中专有名词和新造名词较多,语句之间的逻辑性和关联性更紧密,对模型提取文本中词与词之间、句与句之间关联特征的能力要求更高。

在使用预训练的BERT模型对中文发明专利文本进行向量化语义表征后,分类准确率得到了明显提升。在BERT-CNN模型的分类结果中,几乎每一类的分类准确率都比TextCNN、TextRNN的高,表明预训练的BERT模型即便是对专业性强、逻辑性紧密的文本也能实现较好的语义表征效果。相较于BERT-CNN模型,BERT-LSTM使用针对时间序列数据建立的LSTM网络完成分类任务,更侧重于专利文本向量化语义表征后特征数据之间的联系。从图 6(d)可以看出,对于TextCNN、TextRNN、BERT-CNN模型表现都不好的种类“B”,在BERT-LSTM模型上识别准确率得到了大幅提升。

相较于BERT-LSTM模型,本文提出的BERT-BiGRU在识别准确率上进一步提升。在本文方法BERT-BiGRU中,由于引入了双向循环机制,从顺序和逆序两方面考虑了每个词与上下文之间的联系,对专利文本逻辑性的表征能力更强,更能描述不同文本类别之间的差异性。对种类“B”的分类准确率达到了82%,比BERT-LSTM的结果高8%。在一定程度上改善了“G”类和“H”类错误划分的问题,但物理类和电学类之间的错误分类仍然是中文专利文本自动分类的主要误差来源。

各个模型的总体分类准确率、精确率、召回率以及F1值如表 4所示。

|

|

表 4 各个模型的评价指标 Tab. 4 Evaluation indicators of each model |

从表 4中可以看出,不同方法的准确率提升幅度有限,也间接证明了中文专利文本专业性强、逻辑关系紧密,对分类模型的语义语境表征能力要求更高。依赖卷积神经网络抽取文本特征的TextCNN在本文的中文专利数据集上表现稍好于TextRNN,准确率高了1.89%。随着预训练BERT模型的引入,BERT-CNN对中文专利文本的分类准确率都高于TextCNN和TextRNN。在使用RNN代替CNN完成分类任务后,分类准确率得到了进一步的提升,BERT-LSTM的分类准确率达到了82.81%,比BERT-CNN提升了2.87%。这得益于LSTM针对时间序列数据的网络架构,“记忆”功能在根据专利文本上下文信息的分类任务中发挥了作用。本文所提BERT-BiGRU方法的识别准确率达到了85.44%,比传统TextCNN高8.23%,比BERT-LSTM高2.63%。

4 总结本文提出一种基于BERT-BiGRU模型的中文专利文本自动分类方法,使用词嵌入和多头注意力机制等方法提取专利文本中词语的上下文语境信息,利用预训练的中文BERT模型对专利文本进行向量化语义表征,通过双向GRU门控网络完成对中文发明专利的分类。实验结果表明,本文方法对8类专利文本的分类准确率达到了85.44%,比传统TextRNN高10.12%,比BERT-LSTM高2.63%。本文方法在一定程度上提高了分类模型对中文专利文本的差异性特征提取能力,提高了分类准确率,但是对于联系较为紧密的交叉学科专利文本的分类能力仍然有待提高。中文专利文本和日常文本在用词、逻辑表达等方面存在较大差异,可以考虑以大量中文专利文本数据为基础训练得到BERT模型,并将其应用于专利文本分类任务。

| [1] |

国家知识产权局. 国家知识产权局2020年政府信息公开工作年度报告[EB/OL]. (2021-01-31)[2022-04-10]. https://www.cnipa.gov.cn/art/2021/1/31/art_250_156580.html. State Intellectual Property Office. Annual Report of the State Intellectual Property Office on Government Information Disclosure in 2020[EB/OL]. (2021-01-31)[2022-04-10]. https://www.cnipa.gov.cn/art/2021/1/31/art_250_156580.html. (  0) 0) |

| [2] |

原之安, 彭甫镕, 谷波, 等. 面向标注数据稀缺专利文献的科技实体抽取[J]. 郑州大学学报(理学版), 2021, 53(4): 61-68. YUAN Z A, PENG F R, GU B, et al. Technology entity extraction of patent literature with limited annotated data[J]. Journal of Zhengzhou university (natural science edition), 2021, 53(4): 61-68. (  0) 0) |

| [3] |

奚雪峰, 周国栋. 面向自然语言处理的深度学习研究[J]. 自动化学报, 2016, 42(10): 1445-1465. XI X F, ZHOU G D. A survey on deep learning for natural language processing[J]. Acta automatica sinica, 2016, 42(10): 1445-1465. (  0) 0) |

| [4] |

傅依娴, 芦天亮, 马泽良. 基于One-Hot的CNN恶意代码检测技术[J]. 计算机应用与软件, 2020, 37(1): 304-308. FU Y X, LU T L, MA Z L. CNN malicious code detection technology based on One-Hot[J]. Computer applications and software, 2020, 37(1): 304-308. (  0) 0) |

| [5] |

NAGARAJU K C, REDDY C R K. Reusable component retrieval from a large repository using Word2Vec with continuous bag of words[J]. Ingénierie des systèmes d information, 2021, 26(5): 453-460. DOI:10.18280/isi.260504 (  0) 0) |

| [6] |

景丽, 何婷婷. 基于改进TF-IDF和ABLCNN的中文文本分类模型[J]. 计算机科学, 2021, 48(S2): 170-175. JING L, HE T T. Chinese text classification model based on improved TF-IDF and ABLCNN[J]. Computer science, 2021, 48(S2): 170-175. (  0) 0) |

| [7] |

武永亮, 赵书良, 李长镜, 等. 基于TF-IDF和余弦相似度的文本分类方法[J]. 中文信息学报, 2017, 31(5): 138-145. WU Y L, ZHAO S L, LI C J, et al. Text classification method based on TF-IDF and cosine similarity[J]. Journal of Chinese information processing, 2017, 31(5): 138-145. DOI:10.3969/j.issn.1003-0077.2017.05.020 (  0) 0) |

| [8] |

刘秀磊, 孔凡芃, 谌彤童, 等. 基于BERT与XGBoost的航天科技开源情报分类[J]. 郑州大学学报(理学版), 2021, 53(3): 15-22. LIU X L, KONG F P, CHEN T T, et al. Research on classification of aerospace science and technology open source information based on BERT and XGBoost[J]. Journal of Zhengzhou university (natural science edition), 2021, 53(3): 15-22. (  0) 0) |

| [9] |

赵云山, 段友祥. 基于Attention机制的卷积神经网络文本分类模型[J]. 应用科学学报, 2019, 37(4): 541-550. ZHAO Y S, DUAN Y X. Convolutional neural networks text classification model based on Attention mechanism[J]. Journal of applied sciences, 2019, 37(4): 541-550. (  0) 0) |

| [10] |

张冲. 基于Attention-Based LSTM模型的文本分类技术的研究[D]. 南京: 南京大学, 2016. ZHANG C. Text classification based on Attention-Based LSTM model[D]. Nanjing: Nanjing University, 2016. (  0) 0) |

| [11] |

李洋, 董红斌. 基于CNN和BiLSTM网络特征融合的文本情感分析[J]. 计算机应用, 2018, 38(11): 3075-3080. LI Y, DONG H B. Text sentiment analysis based on feature fusion of convolution neural network and bidirectional long short-term memory network[J]. Journal of computer applications, 2018, 38(11): 3075-3080. (  0) 0) |

| [12] |

薛金成, 姜迪, 吴建德. 基于LSTM-A深度学习的专利文本分类研究[J]. 通信技术, 2019, 52(12): 2888-2892. XUE J C, JIANG D, WU J D. Patent text classification based on long short-term memory network and attention mechanism[J]. Communications technology, 2019, 52(12): 2888-2892. (  0) 0) |

| [13] |

YU J S, HUANG L X, HU Y J, et al. A structured representation framework for TRIZ-based Chinese patent classification via reinforcement learning[C]//2020 3rd International Conference on Artificial Intelligence and Big Data (ICAIBD). Piscataway: IEEE Press, 2020: 6-10.

(  0) 0) |

| [14] |

杜恒欣, 朱习军. 基于BiLSTMATTCNN中文专利文本分类[J]. 计算机系统应用, 2020, 29(11): 260-265. DU H X, ZHU X J. Chinese patent text classification based on BiLSTMATTCNN model[J]. Computer systems and applications, 2020, 29(11): 260-265. (  0) 0) |

| [15] |

XU G N, DONG F, FENG J W. Mapping the technological landscape of emerging industry value chain through a patent lens: an integrated framework with deep learning[J]. IEEE transactions on engineering management, 2020, 99: 1-12. (  0) 0) |

| [16] |

CUI Y M, CHE W X, LIU T, et al. Pre-training with whole word masking for Chinese BERT[J]. IEEE/ACM transactions on audio, speech, and language processing, 2021, 29: 3504-3514. (  0) 0) |

| [17] |

于海燕, 陆慧娟, 郑文斌. 情感分类中基于词性嵌入的特征权重计算方法[J]. 计算机工程与应用, 2017, 53(22): 121-125. YU H Y, LU H J, ZHENG W B. Feature weighting method based on part of speech embedding for sentiment classification[J]. Computer engineering and applications, 2017, 53(22): 121-125. (  0) 0) |

| [18] |

朱张莉, 饶元, 吴渊, 等. 注意力机制在深度学习中的研究进展[J]. 中文信息学报, 2019, 33(6): 1-11. ZHU Z L, RAO Y, WU Y, et al. Research progress of attention mechanism in deep learning[J]. Journal of Chinese information processing, 2019, 33(6): 1-11. (  0) 0) |

| [19] |

黄磊, 杜昌顺. 基于递归神经网络的文本分类研究[J]. 北京化工大学学报(自然科学版), 2017, 44(1): 98-104. HUANG L, DU C S. Application of recurrent neural networks in text classification[J]. Journal of Beijing university of chemical technology (natural science edition), 2017, 44(1): 98-104. (  0) 0) |

| [20] |

程艳, 尧磊波, 张光河, 等. 基于注意力机制的多通道CNN和BiGRU的文本情感倾向性分析[J]. 计算机研究与发展, 2020, 57(12): 2583-2595. CHENG Y, YAO L B, ZHANG G H, et al. Text sentiment orientation analysis of multi-channels CNN and BiGRU based on attention mechanism[J]. Journal of computer research and development, 2020, 57(12): 2583-2595. (  0) 0) |

2023, Vol. 55

2023, Vol. 55