| 人员意外跌倒检测研究方法分析与综述 |

据国家统计局发布的人口统计数据显示, 现阶段我国已进入老龄化社会。据报道, 2021年5月, 60岁及以上人口超2.64亿, 与2010年相比, 60岁及以上人口的比重上升了5.44%。在65岁及其以上的人群中, 每年跌倒的人数大约占30%[1]。意外跌倒造成的一系列损伤是造成老年人意外死亡的第二大原因。随着老年人口的增长, 跌倒检测已成为智能家居环境的一个重要问题, 对独居老人进行意外跌倒检测, 可以将死亡和受伤的风险降至最低。

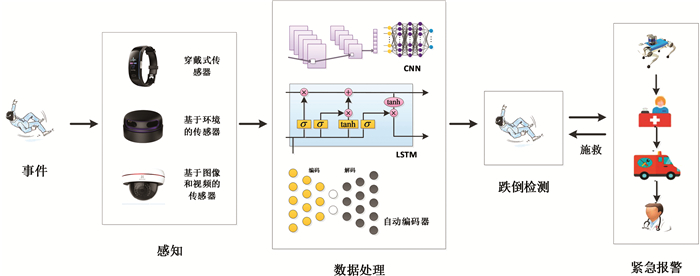

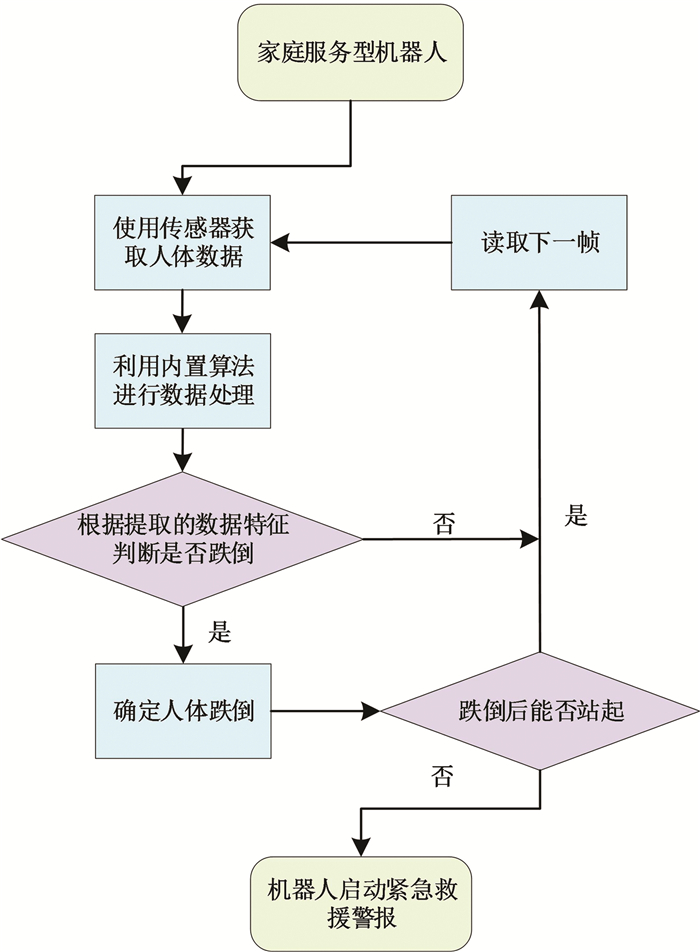

近年来, 机器学习和深度学习算法被广泛应用于跌倒检测领域。在深度学习中, 几乎所有的跌倒检测系统常用的步骤为:感知、数据处理、跌倒事件识别(跌倒检测)和紧急报警, 相应跌倒检测系统的概览如图 1所示。

|

| 图 1 跌倒检测系统概览 |

如何正确检测老年人跌倒, 降低误检率以及如何实现实时的跌倒检测, 都是当前跌倒检测亟需解决的问题。当前, 常用于跌倒检测的架构为:CNN架构、LSTM架构和自动编码器架构, 其中, 使用较多的为CNN架构和LSTM架构。CNN架构非常适合在给定的图像中寻找想要的目标, 因此, 采用基于CNN架构的跌倒检测系统都充分利用了CNN在分类或检测图像方面的能力。LSTM是基于RNN(recurrent neural network)改进的架构, 和CNN一样, LSTM也可以处理图像数据, 但LSTM的优势主要在于处理时间序列数据。同时, LSTM也可以和CNN组合用于跌倒检测, 从而克服一些与视觉相关的问题, 如:图像噪声、遮挡和透视等。CNN和LSTM架构主要用于监督学习, 而自动编码器主要用于无监督学习。

目前, 据作者所知, 还没有针对CNN架构展开为目标检测和光流识别两部分进行分析的综述性文章, 本文以此为基础, 在第二小节中, 介绍了基于单传感器和多传感器融合的跌倒检测数据获取方法, 在第三小节中介绍了跌倒检测中常用的CNN架构和LSTM架构, 其中, CNN架构分为目标检测和光流估计两部分进行介绍, 在第四小节中主要介绍了将传感器和算法应用于机器人平台的相关文献。

1 传感器首先介绍跌倒检测中各种数据获取的常用方法。

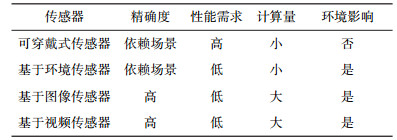

1.1 单传感器单传感器性能的总结和比较如表 1所示, 可分为两类:穿戴式传感器和非穿戴式传感器, 其中, 非穿戴式传感器又可细分为基于环境、图像和视频的传感器。

| 表 1 单传感器性能比较 |

|

1.1.1 穿戴式传感器

穿戴式设备的系统通常使用嵌入式传感器, 如:腕带。这些类型的传感器一般都从加速度计、陀螺仪和磁力计中获得运动学数据, 从而可以提供姿态和运动信息。基于阈值的方法和基于机器学习的方法都可以应用于穿戴式设备, 其中基于机器学习的方法通常优于基于阈值的方法[2], 参考文献[3]提出了结合基于阈值和基于机器学习的技术。穿戴式设备可以被穿戴在人体的各个部位, 但是穿戴后, 会让人感觉不适。此外, 穿戴式设备需要用户保证设备电量充足, 才能随身携带, 但是这些系统主要针对的是老年人, 因此在生活上有很多不便。

1.1.2 非穿戴式传感器1) 基于环境的传感器

非穿戴式传感器可进一步分为环境传感器和基于图像和视频的传感器。环境传感器主要监测它们特定感兴趣区域的变化, 获取温度图像或速度图像, 从而可以被应用于检测姿势、动作和人的存在。常用的环境传感器为:红外传感器、被动红外传感器和多普勒雷达。被动红外传感器通过发射和捕捉红外辐射来捕捉感兴趣区域环境中的变化, 或通过测量物体所释放的热量来捕捉感兴趣区域环境中的变化。多普勒雷达是以多普勒效应为基础, 发射微波信号, 从而可以精确地测量目标相对于雷达的径向速度。MFCC(Mel-Frequency Cepstral Coefficients)特征和机器学习算法通常用于跌倒检测[4]。尽管这些传感器都显示出较好的检测结果, 但它们的检测仅限于安装时的感兴趣区域, 而且它们的性能会受到其他用户和环境变化的影响。

2) 基于图像和视频的传感器

基于图像和视频的设备对那些安装在感兴趣区域的摄像头所捕捉到的视频或图像数据进行处理, 并提取身体姿态、状态信息和动作等信息。一些基于图像和视频的传感器利用历史图像和身体姿态的变化来检测跌倒, 而其它的基于图像和视频的传感器则应用机器学习算法从图像或视频数据中提取特征。然而环境中光的变化会导致基于图像和视频的设备采集的数据不准确。

单传感器跌倒检测系统经常面临影响其性能的限制。可穿戴式设备, 如加速度计, 其精度非常依赖于其放置位置[5], 并且在面临类似于跌倒的动作时, 也会给出跌倒的信号。环境传感器受限于特定的感兴趣区域, 并且容易受到环境变化的影响。根据跌倒检测的各种需要, 单传感器模式在使用上面临各种各样的限制, 因此, 较多的研究者依靠多传感器融合来获得一个更强大、更可靠的跌倒检测系统。

1.2 多传感器融合多传感器融合主要可分为三类:穿戴式传感器融合、非穿戴式传感器融合以及穿戴式和非穿戴式传感器融合。

1.2.1 穿戴传感器融合穿戴式跌倒检测系统大多基于加速度计, 通常与陀螺仪和磁力计等其它传感器融合在一起。为了区分生活中的日常活动(activities of daily life, ADL)和跌倒动作, Yodpijit[6]等人提出一种使用阈值人工神经网络算法, 该算法使用加速度传感器、陀螺仪和动作传感器检测身体方位和动作, 在网络中加入阈值提高区分ADL与跌倒的性能。另外, 为了引入时间特征, 参考文献[7]结合MPU 6050和北欧NRF 52832设计了穿戴式跌倒检测装置, 利用LSTM网络对老年人的运动进行分类。

Jefiza等[8]开发了一种可穿戴式跌倒检测系统, 首先在数据采集所在的预处理阶段对数据进行归一化, 该系统是基于一个单隐层的反向传播神经网络(back propagation neural network, BPNN), 因此, 将加速度和角速度的特征输入到BP神经网络中, 利用反向传播神经网络方法对跌倒运动类型进行分类。Shahiduzzaman等[9]开发了一种基于阈值的加速计和心电数据算法, 算法将加速度计中人的动作和HRV(heart rate variability)传感器中的心率作为输入, 然后分别对两种信号进行分析, 检查是否有异常, 当两个传感器的检测结果都显示为不正常时, 它才会发出检测到跌倒的警报。

1.2.2 非穿戴式传感器融合近年来, 基于穿戴式设备的跌倒检测技术得到了长足发展, 但仍存在一定的局限性。穿戴式设备的性能容易受到外界环境变化的影响, 且对被检测目标的日常行为活动有一定的限制。为了解决上述问题并提高系统使用舒适度与稳定性, 研究者们提出了基于图像或视觉的检测方法, 通过监控摄像头或其它非穿戴式传感器来检测跌倒事件。常用的机器学习方法有:K-近邻算法[10]、递归神经网络(RNN)[11]、卷积神经网络(CNN)[12]和支持向量机(support vector machines, SVM)[13]等。

非穿戴式传感器要么使用基于阈值的算法, 要么使用基于机器学习的算法, 从多个传感器中提取的特征用于训练分类器, 从而区分跌倒和ADL。Litvak等[14]基于多阈值方法, 利用振动能量来检测跌倒事件, 作者对振动和声音信号(110个特征)进行特征提取, 然后运用特征选择算法进行特征选择, 最终使用人体模型和重物进行跌倒模拟。ZHOU等[15]中, 提出了一种基于深度学习和多传感器融合的跌倒检测方法, 微波雷达和摄像机用于捕获人体动作信息, 微波雷达数据使用短时傅里叶变换(short-time fourier transform, STFT)处理, 最后采用多重卷积神经网络来实现判断是否发生了跌倒。

1.2.3 穿戴式和非穿戴式传感器融合近年来, 研究人员利用穿戴式传感器和非穿戴式传感器的优势, 开发出了更强大的跌倒检测系统。LEE等提出了一种通过惯性测量单元位置(inertial measurement unit-location, IMU-L)传感器和RGB摄像机进行老年人跌倒检测的双重检测方法[16], IMU-L传感器是IMU(inertial measurement unit)传感器(加速度计和陀螺仪)和超宽带信号定位传感器的组合, RGB传感器安装在机器人上, 老年人将IMU-L传感器佩戴在身上, 当类似跌倒的事件发生时, 个人的位置信息与运动数据将会同步。在检测过程中, 由于IMU数据的时序性, 利用递归神经网络(RNN)来对跌倒进行分类, 当IMU提示疑似摔倒时, 机器人就会移动到相应位置, 确认老年人是否摔倒, 在确认阶段, 采用基于卷积神经网络技术对RGB图像数据进行识别和确认。

2 基于CNN和LSTM的算法发展脉络本节介绍跌倒检测中常用的深度学习算法发展脉络和进化过程。

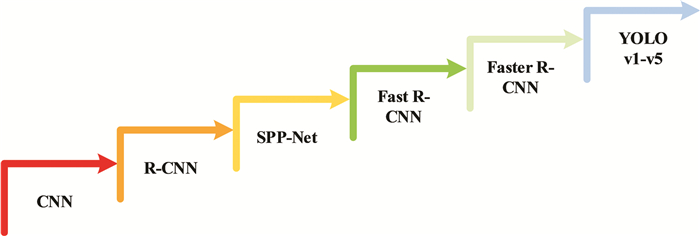

2.1 基于CNN的算法发展脉络在跌倒检测中, 通常需要用到目标检测和光流估计, 目标检测用于定位所需要的目标, 光流估计用于检测目标的运动。

2.1.1 目标检测近年来, CNN已经变成了人工智能领域的研究热点之一[17], CNN在很多方面都有突出的性能, 如:计算机视觉, 语言识别和自然语言处理等。现有研究成果证实, CNN可以进行实时目标检测。在CNN的基础上提出了YOLOv1[18](You only look once), YOLOv1将整张图片作为网络的输入, 直接在输出层对检测框的位置和类别进行回归, YOLOv1没有求取候选区域的过程, 从而解决了运行缓慢的问题, 背景误检率降低, 通用性变得更强, 但是YOLOv1在精准性和召回率上都有所下降, 对于检测框的定位不是很好, 从而降低了物体检测的定位准确性。对YOLOv1进行改进的YOLOv2[19]引入了批量归一化(batch normalization, BN)和高分辨率图像分类器, 受到Faster R-CNN的启发, 引入了锚箱, 同时使用了K均值聚类算法, 对锚箱数量进行了讨论, 在精度和速度之间做出折中。并且修改了网络结构, 去掉了全连接层, 改成了全卷积结构, 引入passthrough层来检测细粒度特征。在训练时引入了世界树(world tree)结构, 将检测和分类问题做成了一个统一的框架, 并且提出了一种层次性联合训练方法, 利用ImageNet分类数据集和COCO检测数据集同时对模型进行训练, 从而YOLOv2在速度和精度有了很大的优化, 可以适应不同的输入尺寸, 但是对于重叠部分的分类, YOLOv2依然无法给出很好的解决方案。YOLOv3[20]将YOLOv2中特征提取用的Darknet-19改为Darknet-53, 即在原本特征提取的网络结构中加入了残差网络, 同时, 采用类似特征金字塔网络(feature pyramid networks, FPN)的多尺度特征融合结构, 进行多尺度预测, 在保证准确度的基础上, 大大提高了算法速度, 但是YOLOv3在以图像50%区域为识别标准时, 准确度最高, 以图像更多的区域作为识别标准时, 准确度会逐步下降。通过对YOLOv3的改进, 得到了YOLOv4[21], YOLOv4借鉴CSPNet, 引入了CSP结构, 将Darknet-53改为CSPDarknet-53, 同时引入了金字塔注意网络(pyramid attention network, PAN)结构, 从不同的主干层对不同的检测层进行特征聚合, YOLOv4对训练时的输入端进行改进, 采用了Mosaic数据增强的方式, 从而增强了数据集, 减少GPU的计算负担, 但是YOLOv4的网络框架和结构较为复杂。YOLOv5引入了Focus结构, 从而再次提高了算法的速度, 同时, YOLOv5缩小了模型的大小, 但YOLOv5在YOLOv4的基础上改进不大。综上, 算法进化如图 2所示。

|

| 图 2 算法进化过程 |

参考文献[22]将YOLO和传统的光流估计算法Lucas-Kanade结合, 提出了YOLBO, 可以实现在视频的前后帧里对于同一个对象的跟踪检测。CHEN等[23]提出了一种基于姿态估计和基于YOLOV5的辅助检测方法, 该方法首先从不同的跌倒视频序列中提取视频帧, 形成一个数据集; 然后将训练样本集输入到改进后的网络中进行训练, 直到网络收敛; 最后根据优化的网络模型测试视频中的目标类别并对其进行定位。

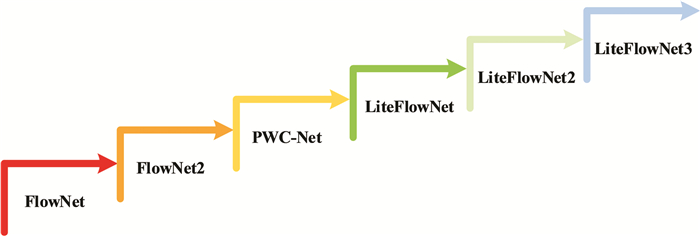

2.1.2 光流估计光流估计是计算机视觉中一个长期存在的问题, 因为著名的孔径问题, 所以光流无法直接测量。因此, 通常运用由粗到细的思想框架来进行能量最小化, 从而进行光流估计。HUI等人提出了LiteFlowNet[24], LiteFlowNet使用双流特征金字塔网络来提取特征, 然后对于级联的不同层次的局部特征进行代价容量计算, LiteFlowNet设置了不同的范围以减小计算量, 将计算后的特征输入亚像素修正层, 用来提升上一级光流结果的精度, 同时, 为每一级的光流结果构造了一个光流正则化层, 从而起到了平滑光流结果的作用。因此, LiteFlowNet在提高了运行速度的情况下, 减小了模型尺寸, 但是, LiteFlowNet运行速度较慢, 精度较低。通过改进LiteFlowNet, 得到了LiteFlowNet2[25], 在LiteFlowNet2中只保留了四个金字塔层级, 从而提高计算效率。在NetE中的每个级联流场推理中的128和64通道的卷积层之间增加了两个卷积层。在原来的第二级网络中, 引入了一种简单的流场推理网络, 称为伪网络, 它仅仅保留了原始网络结构中流场推理的最后一层和正则化层。因此, LiteFlowNet2具有更高的精度和更快的运行速度, 但是最终得到的流场精度还是较低。通过对LiteFlowNet2的改进, 得到了LiteFlowNet3[26], LiteFlowNet3在LiteFlowNet2的基础上自适应调节修改代价向量来改善代价容量中的异常值问题, 然后提出流场变形(flow field deformation)来为由粗到细的策略提供比较精确的初始值, 从而进一步提高了流场精度。综上, 算法进化如图 3所示。

|

| 图 3 算法改进过程 |

在现在的研究中, 文献[27]提出了一种基于YCL(YOLOV3与LiteFlowNet算法相结合)的多传感器融合的低成本智能家庭跌倒检测系统, 该系统一方面利用YCL算法对老年人的行为进行检测; 另一方面基于智能手机的嵌入式传感器, 即加速度传感器和气压传感器, 采用多传感器融合算法来检测跌倒行为。将YCL算法与嵌入式传感器的输出进行融合, 得到最终的检测结果, 相比于单一传感器, 该算法一定程度上提高了检测的精度和性能。一旦确认跌倒事件发生, 智能手机将立即向紧急联系人发送一条警报短信, 以寻求医疗援助。

2.2 基于LSTM的算法发展脉络RNN[28]是一类用于处理序列数据的神经网络, RNN循环处理相同的任务, 即预测句子中某个单词后的单词是什么。RNN在循环的任务中, 各个步骤之间不是独立, 它循环记录前面所有文本的信息(记忆), 作为预测当前词的一个输入。但是, RNN具有梯度消失、梯度爆炸和容易陷入到局部极值点的缺点, 从而无法处理较长序列数据, 从而无法获取长距离数据的信息。在此基础上, 对RNN进行改进, 提出了LSTM[29], LSTM细胞是由输入门、遗忘门和输出门组成的, 其中, 输入门决定当前时刻网络的输入数据有多少需要保存到单元状态, 遗忘门决定上一时刻的单元状态有多少需要保留到当前时刻, 输出门控制当前单元状态有多少需要输出。

由于LSTM良好的性能, LSTM也常被用于进行跌倒检测。Amara等提出了一种基于加速度计和ConvLSTM网络的智能手机跌倒检测应用[30], 提出了ConvLSTM结构, 用于分类跌倒和非跌倒活动, 在ConvLSTM中利用卷积进行特征提取, 用LSTM进行特征的顺序处理。LU等提出了一种基于三维卷积神经网络(3-D CNN)的跌倒检测方法[31], 二维CNN只能对空间信息进行编码, 而采用三维卷积可以从时间序列中提取运动特征, 这对跌倒检测具有重要意义。为了进一步定位每个帧的感兴趣区域, 作者引入了基于LSTM的空间视觉注意力方案。利用数据集Sports-1 M训练三维CNN, 然后将三维CNN与LSTM结合训练得到可以分类跌倒数据集的分类器。Chahyati等人提出了一种基于卷积神经网络和LSTM的多模态数据集跌倒检测方法[32], 利用UP-Fall数据集, 利用卷积神经网络和LSTM来检测跌倒。其中, 卷积神经网络用于从图像数据中检测空间信息, LSTM用于从信号数据中提取时间信息, 然后, 将两个模型的结果与多数投票算法相结合, 从而大大提高了准确率。

3 基于机器人平台的跌倒检测算法研究穿戴式传感器需要用户保证设备电量充足的情况下, 才能随身携带, 在日常生活中使用非常不便, 且人体佩戴后, 舒适度欠佳。非穿戴式传感器通常被固定在特定的位置, 检测特定的区域, 因此非穿戴式传感器局限于感兴趣区域, 存在很多盲区。因此, 智能家居环境中, 研究人员将传感器和算法应用于机器人平台, 机器人可以实现对人的跟踪和追随, 就可以对人进行实时的跌倒检测。机器人跌倒检测的工作流程如图 4所示, 首先机器人使用传感器获取人体数据, 然后利用其内置算法进行数据处理, 根据提取的数据特征判断人体是否跌倒, 若判断为未跌倒, 则读取下一帧, 重新循环跌倒检测过程, 若判断为跌倒, 再确定人体跌倒后能否站起, 若跌倒后能站起, 则读取下一帧, 重新循环跌倒检测过程, 若跌倒后不能站起, 机器人启动紧急救援警报。

|

| 图 4 机器人平台检测跌倒过程 |

CHEN等[33]提出了一种基于视觉的检测方法在低成本小型移动机器人上完成跌倒检测, 文章提出了跌倒检测与跟随算法相结合的检测方法。该方法首先通过移动机器人摄像机获取图像, 并将图像输入神经网络进行跌倒检测, 然后检测到老年人跌倒时, 网络输出老年人的检测框的坐标, 最后通过坐标完成机器人对人的跟踪和检测。SCHNEEMANN[34]提出了一种基于特征的方法, 通过配备Kinect传感器的移动机器人来检测人员跌倒。检测跌倒的方法由五部分组成:预处理、分割、分层、特征提取和分类, 其中, 通过在点云中分割并将其分层以处理物体遮挡的问题, 最后, 使用经过训练的分类器对物体的层进行分类, 通过一定数量的正分类层可以实现跌倒检测。

跌倒检测在生活中的应用越来越广泛, 从智能居家环境到公共环境, 从单人到多人, 从监测到预防检测相融合, 算法在一步步变得更加完善充实, 应用性也越来越强。跌倒检测算法目前在居家环境中应用较多, 随着社会智能化程度越来越高, 在移动平台以及智能家居中的应用将越来越广泛。

4 总结本文从跌倒检测的数据采集方式入手, 对比了三种利用传感器和传感器融合方法进行数据获取的思路, 得到了:穿戴式传感器虽携带不便, 但方便进行随时随地的跌倒检测, 非穿戴式传感器虽不需携带, 但受感兴趣区域的限制, 因此, 需进行各种传感器的融合, 达到更好的数据采集的效果, 如:将跌倒检测算法应用于机器人平台。然后对基于CNN算法和基于LSTM算法的发展脉络进行总结可以得到:当前跌倒检测所用算法的精度已较高, 继续提高精度所带来的成本并不乐观, 因此, 应提高算法的实时性, 使得在应用时, 精度和速度达到适当的平衡。尽管跌倒检测技术已经有了广泛的应用且发展迅速, 但依然有许多问题待进一步研究:

1) 有效结合上下文信息, 解决跌倒检测任务中进行有遮挡部分的检测;

2) 选择或改进传感器融合, 或选择更好的传感器的使用平台, 使得在保证方便的基础上, 不受环境的限制;

3) 选择或改进已有且合适的跌倒检测算法, 使得在保证准确率的基础上, 达到实时检测的效果。

| [1] |

MOUSTAFA H, KENN H, SAYRAFIAN K, et al. Mobile wearable communications[J]. IEEE Wireless Communications, 2015, 22(1): 10-11. DOI:10.1109/MWC.2015.7054713 |

| [2] |

QUADROS T, LAZZARETTI A E, SCHNEIDER F K, et al. A movement decomposition and machine learning-based fall detection system using wrist wearable device[J]. IEEE Sensors Journal, 2018, 18(12): 5082-5089. DOI:10.1109/JSEN.2018.2829815 |

| [3] |

KHOJASTEH S B, VILLAR J R, CHIRA C, et al. Improving fall detection using an on-wrist wearable accelerometer[J]. Sensors, 2018, 18(5): 1350-1377. DOI:10.3390/s18051350 |

| [4] |

LIU L, POPESCU M, SKUBIC M, et al. Automatic fall detection based on doppler radar motion signature[C]//2011 5th International Conference on Pervasive Computing Technologies for Healthcare (Pervasive Health) and Workshops. Dublin: IEEE. 2011: 222-225.

|

| [5] |

CLELAND I, KIKHIA B, NUGENT C, et al. Optimal placement of accelerometers for the detection of everyday activities[J]. Sensors, 2013, 13(7): 9183-9200. DOI:10.3390/s130709183 |

| [6] |

YODPIJIT N, SITTIWANCHAI T, JONGPRASITHPORN M. The development of artificial neural networks (ANN) for falls detection[C]//2017 3rd International Conference on Control, Automation and Robotics (ICCAR). Nagoya: IEEE. 2017: 547-550.

|

| [7] |

HSIEH S T, LIN C L. Fall detection algorithm based on mpu6050 and long-term short-term memory network[C]//2020 International Automatic Control Conference (CACS). Hsinchu: IEEE. 2020: 1-5.

|

| [8] |

JEFIZA A, PRAMUNANTO E, BOEDINOEGROHO H, et al. Fall detection based on accelerometer and gyroscope using back propagation[C]//2017 4th International Conference on Electrical Engineering, Computer Science and Informatics (EECSI). Yogyakarta: IEEE. 2017: 1-6.

|

| [9] |

CHAO P K, CHAN H L, TANG F T, et al. A comparison of automatic fall detection by the cross-product and magnitude of tri-axial acceleration[J]. Physiological Measurement, 2009, 30(10): 1027-1037. DOI:10.1088/0967-3334/30/10/004 |

| [10] |

LIU C L, LEE C H, LIN P M. A fall detection system using k-nearest neighbor classifier[J]. Expert Systems with Applications, 2010, 37(10): 7174-7181. DOI:10.1016/j.eswa.2010.04.014 |

| [11] |

THEODORIDIS T, SOLACHIDIS V, VRETOS N, et al. Human fall detection from acceleration measurements using a recurrent neural network[C]//International Conference on Biomedical and Health Informatics. Orlando: Springer. 2017: 145-149.

|

| [12] |

NÑEZ-MARCOS A, AZKUNE G, ARGANDA-CARRERAS I. Vision-based fall detection with convolutional neural networks[J]. Wireless Communications and Mobile Computing, 2017, 2017(1): 1-16. |

| [13] |

AZIZ O, KLENK J, SCHWICKERT L, et al. Validation of accuracy of SVM-based fall detection system using real-world fall and non-fall datasets[J]. PLoS ONE, 2017, 12(7): 1-11. |

| [14] |

CHAUDHURI S, THOMPSON H, DEMIRIS G. Fall detection devices and their use with older adults: a systematic review[J]. Journal of Geriatric Physical Therapy (2001), 2014, 37(4): 178-196. DOI:10.1519/JPT.0b013e3182abe779 |

| [15] |

ZHOU X, QIAN L C, YOU P J, et al. Fall detection using convolutional neural network with multi-sensor fusion[C]//2018 IEEE International Conference on Multimedia & Expo Workshops (ICMEW). San Diego: IEEE. 2018: 1-5.

|

| [16] |

LEE D W, JUN K, NAHEEM K, et al. Deep neural network-based double-check method for fall detection using imu-l sensor and rgb camera data[J]. IEEE Access, 2021, 9: 48064-48079. DOI:10.1109/ACCESS.2021.3065105 |

| [17] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[C] //In: Proc. of International Conference on Neural Information Processing Systems. Lake Tahoe: Communications of the ACM. 2012: 1097-1105.

|

| [18] |

REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. Las Vegas: IEEE. 2016: 779-788.

|

| [19] |

REDMON J, FARHADI A. Yolo9000: better, faster, stronger[C]//IEEE Conference on Computer Vision & Pattern Recognition. Honolulu: IEEE. 2017: 6517-6525.

|

| [20] |

REDMON J, FARHADI A. Yolov3: An incremental improvement [J]. arXiv Preprint arXiv: 1804.02767, 2018.

|

| [21] |

BOCHKOVSKIY A, WANG C Y, Liao H Y M. Yolov4: optimal speed and accuracy of object detection [J]. arXiv Preprint arXiv: 2004.10934, 2020.

|

| [22] |

KAPUTA D S, LANDY B P. Yolbo: you only look back once-a low latency object tracker based on yolo and optical flow[J]. IEEE Access, 2021(99): 82497-82507. |

| [23] |

CHEN Y, DU R, LUO K, et al. Fall detection system based on real-time pose estimation and SVM[C]//2021 IEEE 2nd International Conference on Big Data, Artificial Intelligence and Internet of Things Engineering (ICBAIE). Nanchang: IEEE. 2021: 990-993.

|

| [24] |

HUI T W, TANG X, LOY C C. Liteflownet: a lightweight convolutional neural network for optical flow estimation[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE. 2018: 8981-8989.

|

| [25] |

HUI T W, TANG X, LOY C C. A lightweight optical flow CNN: revisiting data fidelity and regularization[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 43(8): 2555-2569. |

| [26] |

HUI T W, LOY C C. Liteflownet3: Resolving correspondence ambiguity for more accurate optical flow estimation[C]//European Conference on Computer Vision. Edinburgh: Springer. 2020: 169-184.

|

| [27] |

LV X, GAO Z, YUAN C, et al. Hybrid real-time fall detection system based on deep learning and multi-sensor fusion[C]//2020 6th International Conference on Big Data and Information Analytics (BigDIA). Shenzhen: IEEE. 2020: 386-391.

|

| [28] |

ZAREMBA W, SUTSKEVER I, VINYALS O. Recurrent neural network regularization[J]. arXiv Preprint arXiv: 1409.2329, 2014.

|

| [29] |

SHI X J, CHEN Z, WANG H, et al. Convolutional LSTM network: a machine learning approach for precipitation nowcasting[C]//Advances in Neural Information Processing Systems. Montreal: MIT Press. 2015: 802-810.

|

| [30] |

RAKHMAN A Z, NUGROHO L E, WIDYAWAN, et al. Fall detection system using accelerometer and gyroscope based on smartphone[C]//2014 The 1st International Conference on Information Technology, Computer, and Electrical Engineering. Semarang: IEEE. 2014: 99-104.

|

| [31] |

LU N, WU Y, FENG L, et al. Deep learning for fall detection: three-dimensional CNN combined with LSTM on video kinematic data[J]. IEEE Journal of Biomedical and Health Informatics, 2018, 23(1): 314-323. |

| [32] |

CHAHYATI D, HAWARI R. Fall detection on multimodal dataset using convolutional neural network and long short term memory[C]//2020 International Conference on Advanced Computer Science and Information Systems (ICACSIS). New York: IEEE. 2020: 371-376.

|

| [33] |

CHEN G, DUAN X H. Vision-based elderly fall detection algorithm for mobile robot[C]//2021 IEEE 4th International Conference on Electronics Technology (ICET). Chengdu: China IEEE. 2021: 1197-1202.

|

| [34] |

SCHNEEMANN F, VOLKHARDT M, GROSS H M. Fallen person detection for mobile robots using 3d depth data[C]//2013 IEEE International Conference on Systems, Man, and Cybernetics. Manchester: IEEE. 2013: 3573-3578.

|

2021, Vol. 35

2021, Vol. 35