2. 浙江理工大学国际教育学院;

3. 之江实验室智能社会治理实验室

以算法为核心的人工智能技术逐渐成熟,能够完成的任务越来越复杂和智能,已经在多个领域比人类更快、更准确,如疾病诊断[1]、智能推荐[2]、员工绩效预测[3]、工作路径规划[4]等。人工智能的激动人心的进展给我们带来了有趣的挑战,如果可以选择,我们如何决定是要寻求人类还是算法的帮助?如何做出理性的选择?有趣的是,人们对人类与算法的选择并不一定是理性的。最近,研究人员发现,即使算法被证明更优越,人们也不会对算法做出理性反应,而是更喜欢人类而不是算法,这种现象被称为算法厌恶(algorithm aversion)[5-6]。例如,病人更愿意采纳医生而不是医疗人工智能的诊断结果[7],消费者更喜欢依靠朋友而不是计算机系统的推荐[2]。近年来,算法厌恶的现象得到了管理学、心理学等研究领域的高度关注。

随着越来越多的研究深入探讨这一现象,少数研究观察到了相反的结果:算法欣赏(algorithm appreciation),即在人类与算法间,用户更倾向于选择算法[8-9]。Logg等人发现,当做看图估计数量的任务,以及预测歌曲的流行度等任务时,人们更相信算法的答案[9]。哪些特征导致算法厌恶,哪些特征会导致算法欣赏,对此我们知之甚少。在此背景下,本文对算法厌恶的相关实证文章进行了系统的文献综述,以回答以下问题:哪些因素会影响人们对算法的厌恶?以及人们为什么会发展出对算法的厌恶?其背后的形成机理和理论解释是什么?

本研究以“algorithm”“aversion”“preference”“artificial intelligence”为检索词,在Web of Science、Google Scholar、中国知网等平台上搜索。筛选出比较人们对算法与人类偏好的相关论文。同时,对算法厌恶的关键文献(如Longoni等[7]),以及Jussupow等[10]、李游、梁哲浩和常亚平[11]等综述里的参考文献进行反向搜索,最终筛选出98篇论文进入文献综述。通过对以往的研究进行回顾,总结算法厌恶的概念和测量方法,影响因素以及发生机制,在此基础上,分析未来的研究方向。

二、算法厌恶的概念与测量 1. 算法厌恶的概念算法厌恶的研究起源于对算法或电脑、计算机程序、人工智能等对象的抵触(resistance)[7]、接受度(acceptance)[12]、信任(trust)[13]等的相关研究。最初的算法被视为基于统计模型、决策规则等的计算方法和程序,随着人工智能技术的兴起,算法代表了一种旨在模拟人类智能的功能强大且复杂的技术[10]。这种技术的核心在于可以代替人类独立自主开展工作,将控制权和决策权从人类转向技术,从而改变了我们之前对人与技术关系的理解[14]。在本研究中,将算法宽泛地定义为基于证据的计算预测或机器学习等方法输出结果的计算机执行者[5,15]。

算法厌恶捕捉了这样一种现象:即使算法与人类表现一致甚至更好,人们仍倾向于选择人类提供服务,而不是算法[5]。这里的人类,可以是人类专家,也可以是朋友和陌生人。这种对算法的厌恶与人们是否使用过算法,是否体验过失败的算法无关。即使人们没有经历过算法犯错,仍然会抵触使用算法[7]。算法厌恶的定义在多数研究中已基本达成共识,可以被定义为:与人类相比,对算法的负面态度和行为[10]。与此相对,算法欣赏可以被定义为:与人类相比,对算法的积极态度和行为[10]。从这个角度来讲,算法欣赏是算法厌恶的对立面。通过对相关文献的详细梳理,发现算法厌恶的实证研究有41篇,算法欣赏的实证研究有5篇,既发现了算法厌恶也发现了算法欣赏的实证研究有12篇。总体来看,关于算法欣赏的研究在数量上显著少于算法厌恶的研究。当前,学者对于算法欣赏的成因仍处于初步探索阶段,相比之下,算法厌恶的研究则占据了主导地位[16]。

算法厌恶的概念与相似的研究概念,例如对技术的接受度、对技术的抵触等的区别之处归纳如表1所示:从研究对象来看,对技术的接受度和抵触的研究聚焦于技术本身,而算法厌恶的研究聚焦算法这项技术相对于人类服务提供者的偏好;从对技术的定位来看,对技术的接受度和抵触的研究将技术作为一项工具来进行探讨,而算法厌恶的概念将算法这项技术不仅仅视为一项工具,而是可以独立给消费者提供服务,甚至取代人类专家的社会行为主体[10];从研究的侧重点来看,对技术的接受度的相关研究聚焦影响人们对技术的接受和使用的因素,对技术的抵触相关研究聚焦技术的不同威胁、人们对保持现状的偏好等因素,如何影响人们对技术的抵触。算法厌恶的研究关注人们评估算法和人类服务提供者的系统性差异。这种差异可能是非理性的、主观的系统误差造成的,而不仅仅是基于技术本身的优劣的评价,也不仅仅是对现状的偏好。

| 表 1 “算法厌恶”与“技术接受度”、“技术抵触”的概念区分 |

已有文献中,对算法厌恶的测量综合采用多种方式[7-8]。对算法厌恶的测量方法有以下三类。

(1)在算法或人类间进行选择。在这种设计中,由算法和人类助手提供建议或执行任务,关于两者的信息均提供给被试,请被试选择其中一个。选择的方式可以是二元的,即是否选择该助手的服务;也可以是偏好评分表,例如7级量表,1代表绝对选算法,4代表中立,7代表绝对选人类;也可以是选择实验,在电脑上给被试提供关于算法和人类多条件的组合,请被试进行选择[7]。如果参与者选择人类而不是算法,表明存在算法厌恶。

(2)参考算法/人类意见的程度。在此种实验设计中,被试被要求一开始独立做出一个自己的判断和估计,然后给其人类或算法的意见,请被试提供最终的估计。通过计算建议采纳程度(Weight of Advice,WOA=(被试最终估计-被试初始估计)/(建议值-被试初始估计))表明被试在自己的决定中对算法/人类的重视程度[9,18]。另一种反映参考意见的程度的方法是请被试直接填写愿意遵循算法/人类的建议的程度(例如7级量表,1代表绝对不遵循,7代表绝对遵循)[7]。如果愿意接受算法建议的程度显著小于愿意接受人类的建议,即存在算法厌恶。

(3)对算法/人类的直接评价。例如,请被试评价对算法/人类的信任[19],或者请被试评估由算法/人类做出决定的合适程度[8],或者请被试反映愿意给算法/人类付费的意愿(例如,11级量表,从0元到100元)[7]。如果对算法的评价低于对人类的评价,则存在算法厌恶。算法厌恶的测量方法归纳如表2所示。

| 表 2 算法厌恶的测量方法 |

现有研究大多从算法特征、个体特征和任务特征三个方面,来探索算法厌恶的前因[10-11,21-22]。这些特征可能会引起不同程度的算法厌恶,或转而引起算法欣赏。因此,本研究在对算法厌恶的前因进行回顾时,一并归纳算法欣赏的前因。

1. 算法特征(1)算法的介入程度(algorithm agency)

按照算法的介入程度,可以将算法分为建议型算法(advisory algorithm)和执行型算法(performative algorithm)[10],执行型算法的介入度和自主性相较于建议型算法更为显著。建议型算法为用户提供支持,最终决定权在用户[10],例如参考算法的建议进行流行音乐的预测[9],给医生提供诊断支持的AI影像诊断建议等[23];执行型算法能够通过收集信息、决策和执行来完成独立的操作,用户可以监控最后的结果[10],例如管理决策[24]、提供绩效反馈[25]等。

算法的介入度和自主性越强,用户的算法厌恶越明显。当算法只起到建议作用,最终仍由人类做决策时,算法厌恶降低[8]。而介入度低的算法是否会使算法厌恶消失,甚至变成算法欣赏,现有研究没有得出一致性的结论。Longoni, Bonezzi和Morewedge发现,当算法只起到建议作用时,由人类专家在算法的辅助下做出决定与人类专家独立做出决定,用户采纳服务的可能性没有显著差异[7]。表明算法的存在没有影响用户的选择,此时算法厌恶消失,也不存在算法欣赏。而Palmeira和Spassova发现,当人们有机会比较纯专家判断和专家判断与算法辅助相结合时,他们更喜欢后者[26]。这种情况下表明算法厌恶消失,转变成算法欣赏。

这两个研究存在的不一致之处打开了有趣的研究问题。首先,在完成客观的任务时,与单独的算法相比,人机混合的模式(即建议型算法辅助人类)是否真的表现更佳尚不清楚[2]。人机混合的模式,与单独的人类或单独的算法相比,是否能获得消费者更多的偏好,也没有明确的答案[7,26]。Pezzo和Pezzo发现医生使用算法来支持他们的决策,与没有算法支持的医生相比,若犯错,对这种混合模式的失败的评价更少负面。然而,与医生独立做出的成功决定相比,混合模式的积极结果被评估为没那么积极[27]。人机混合模式的相关研究有待进一步研究探讨。

(2)算法的表现

算法的成功信息。当算法和人类专家的准确率相同或相近时,在算法和人类之间,用户会选择人类[7]。当用户已知算法的准确率高于人类时,对算法的厌恶降低[28],甚至用户转而选择算法[7-8]。因此,是否提供算法的性能信息以及如何提供会影响算法厌恶的强弱程度。

算法的失败信息。在观察到算法或人类专家犯错或提出错误建议后,与人类失败相比,用户对算法的失败更为愤怒[24]。对算法的依赖比对人类的依赖减少更多[5,29],这是因为在看到算法和人类犯了同样的错误后,人们对算法比对人类专家更容易失去信心[5]。另一方面,由于AI被认为比人类更同质,人们会将一组AI失败的信息过度迁移到另一组AI上,认为另一组AI也会失败,这种迁移的程度要大于将一个人的失败信息转移到另一个人的程度[30]。

算法的响应时间。算法的响应时间长,人们认为其生成的预测准确性低,对其的依赖程度也会降低。相反地,人类缓慢生成的预测被认为更准确[15]。这种不对称的效应可以用人们预期人类与算法执行任务的不同难度来解释。对人类来说,预测的任务可能比较困难,较慢的反应符合预期,因此较长的反应时间意味着更多的努力,使人们认为预测质量较高。对于算法,较慢的响应与预期不一致,预测的任务对算法来说应该是简单的,因此较慢的速度与更多的努力和预测质量无关[15]。

(3)算法的表现形式

算法的表现形式在不同情境下可能会产生相反的效果。当算法被描述为个性化的,能够考虑到每个个体独特的情况,可以降低算法厌恶[7]。然而,在某些领域,算法真的做出个性化的反应时,反而会加重算法厌恶。例如,人类医生记住患者的名字和独特的病史,这种个性化体验会提升患者的依从性,而由个性化算法驱动的AI医生做出同样的行为会使患者感受到被侵犯,从而降低依从性[31]。算法拟人化同样是一把双刃剑,当拟人化的算法做出对消费者有利的决定时,人们对算法的态度会更加积极[32]。相反,在服务失败情境下时,高度拟人化的算法化身会加剧顾客对智能客服的厌恶[33]。当允许用户稍微修改算法的输出会使人们的算法厌恶降低,对算法出错的容忍度提高[6]。

2. 个体特征现有研究发现人们的年龄、对统计学的态度、个人心理特质,如风险偏好、同理心等,对算法厌恶没有显著影响[34-35]。能够显著影响算法厌恶的个体特征包括个体的算法知识:当个体的算法知识较少时,更倾向于接受专家的建议,当个体的算法知识较多时,个体更容易接受算法的建议[18];个体的专业性:个体的专业性越强,表现出更强的算法厌恶[36];个体的身份认同:当身份动机是消费的重要驱动力时,这些个体会抵触自动化的产品,例如强烈自我身份认同的面包师会抵触大大降低烘焙所需技能的自动化产品(面包机)[37];心理掌控力(locus of control):认为自己能够掌控自己生活中的事件的人表现出更强的算法厌恶[35]。

3. 任务特征算法厌恶还是算法欣赏,很大程度上取决于使用算法的任务类型以及人们如何看待任务[28]。例如,Yeomans等发现被试更多地依赖人类而不是算法来预测笑话的趣味性[2],而Logg等发现被试更多的依赖算法而不是人类来完成具有客观正确答案的数字任务[9]。Thurman等发现,在新闻推荐上,相比于工作人员或专家的推荐,人们整体上更乐于接受算法的推荐[38]。这两个研究结果的差异可能是因为,相比于客观的任务,人们对算法做主观任务的信任和依赖较低[28]。将任务描述为依赖于定量分析(相对于直觉式的)会增加感知任务的客观性,进而增加消费者对算法的信任和依赖[28]。随着任务的难度提高,人们对算法建议的依赖度也随之提高[39]。此外,在可能存在歧视的情况下,算法决策比人类决策更不容易被认为有偏见,这是因为人们认为算法会忽略个人特征,以统一规则进行评判[20]。进而,种族和经济不平等的威胁增加了对算法决策的偏好[40]。

任务的重要性和不确定性也会影响算法厌恶。越重要的任务,算法厌恶越深[28]。对不确定性高的领域,人们越不愿意使用算法[41]。对高创造性的任务,在人类的推荐下消费者的采纳意愿更高,对低创造性的任务,算法的推荐下消费者的采纳意愿更高[42]。对于享乐型的产品(相对于实用型的产品),人们更愿意听取人类的推荐;对于实用型的产品,人们更愿意采纳算法的推荐[43-44]。此外,面对高象征性的消费任务,人们更喜欢人类(相对于机器人)的服务,例如去做纹身时,与去消除纹身相比,彰显自我的象征性更高,在这种高象征性的消费环境下,人们对纹身师而不是机器人的偏好更加明显[45]。算法厌恶的前因归纳如表3所示。

| 表 3 算法厌恶的前因 |

总体来看,相对于人类,算法因其强大的信息处理、数理计算能力,在做客观的、数字相关的、可能有歧视的任务时,个体更可能表现出算法欣赏[9,20,28,46]。然而,算法因其缺乏灵活性、低可预测性、不透明性、不可解释性,在做主观的、高创造性、重要的、不确定性高的任务时,个体更可能表现出算法厌恶[28,41-42]。算法厌恶还是算法欣赏,可能依赖于算法特征、个体特征及任务特征的组合,这背后的发生机制值得深入探讨。

四、算法厌恶的发生机制及理论解释 1. 算法厌恶的发生机制关于算法厌恶的产生机制,现有研究进行了初步的探讨。通过对这些研究结论的归纳梳理可以发现,算法厌恶的产生原因可以大致分为对算法的认知机制和情感机制。

(1)对算法的认知机制

一些研究从人们对算法的认知的角度探讨算法厌恶产生的原因,例如,患者抵触AI诊疗是因为患者认为AI不能考虑到自己特殊的情况[7],以及人们主观上难以理解人工智能的决策过程[29,47]。同样,人们不易接受算法的推荐,因为难以理解算法推荐的过程[2]。

算法被认为是有效率和客观的,但也缺乏直觉和主观判断能力[48]。人们认为与人类决策相比,算法决策的道德性相对较低[49]。以及人们会认为算法在特定任务上的胜任感不足,例如高创造性的任务[42]。此外,当消费者的请求被算法接受时,与被人类接受相比,消费者的反应不那么积极,因为将算法做出的接受决定进行内化更困难[32]。相反,当请求被拒绝时,消费者很容易将这个结果进行外化,例如责怪算法没有考虑到个体的独特性,责怪人类缺乏客观性,Yalcin等发现此时消费者对算法和人类的反应相似[32]。

(2)对算法的情感机制

还有一些研究从人们对算法产生的情感出发,探讨了算法厌恶产生的原因。人们认为聊天机器人知识较少且缺乏同理心,和聊天机器人的对话会变得生硬并减少购买[50]。人们认为AI教练缺乏软的人际交往技能,不愿听从AI教练[51]。人们厌恶机器进行道德有关的医疗决策,这种厌恶由机器既不能充分思考,也不能完全感受所中介[8]。此外,遵循医生的建议比遵循算法的建议让患者感觉自己的责任更小[13]。AI的拟人化行为在医疗情境下会使患者感受到被冒犯[31]。选择人类而不是算法后,对人类造成的结果的情感反应更为强烈[24]。算法厌恶产生的认知机制和情感机制归纳如表4所示。

| 表 4 算法厌恶的发生机制 |

现有的实证研究较少采用深层的理论机制来解释算法厌恶产生的机理,运用比较多的理论是社会认同理论(social identity theory)和归因理论(attribution theory)。现有研究主要采用社会认同理论来解释算法本身及算法的不同表现形式对算法厌恶的影响,运用归因理论解释算法的成功或失败对算法厌恶的影响。

(1) 社会认同理论

社会认同理论的基础是自我分类(self-categorization),它描述了人们如何将自己和他人归入不同的社会群体中,从而区分内群体和外群体的成员[52]。人们倾向于将算法视作外群体成员[30],从而容易产生排斥心理[28,53]。个体对自我的身份认同越强,越排斥使用替代自己技能的自动化产品[37]。为将算法尽可能地向内群体靠近,学者们研究算法的不同表现形式,例如拟人化[54]和个性化[7]对算法厌恶的影响。

运用社会认同理论对算法厌恶进行解释的研究,将人们对算法和人类服务提供者的不同偏好归因于内外群体的差异。然而无法解释算法自身的特征对算法厌恶的影响,也无法解释不同的任务类型下,算法厌恶的强弱。

(2) 归因理论

归因理论认为,人们对给定的结果会从内部或外部寻找原因[55]。人们倾向于将自己的成功归功于自身,将失败归责于外在因素[32]。当人们无法控制事情发生的进程时,他们就不能将成功的结果归功于自己的行动,即不能进行内部归因[24]。人们不理解算法工作的过程,对由算法执行的结果难以进行内部归因。例如,当人们提出的请求被算法决定接受时,人们难以对此进行内化,反应不如被人类接受积极[32]。面包师认为自动化机器取代了面包师身份所必须的技能,消除了内部归因的机会,从而抵触这些自动化的产品[37]。而当面临自己的失败时,人们倾向于进行外化,此时算法和人类决策者都容易被进行归责[32]。

运用归因理论解释算法厌恶的现象需要注意理论适用的情境,归因理论适用于解释个体卷入程度较深或算法/人类扮演决策者的情境。当个体卷入程度较低时,可能不适宜用归因理论进行解释。例如,当算法或人类作为服务提供者犯了同样的错误时,人们对算法的失败更为愤怒[24],与上述算法或人类作为决策者时的反应不同[32]。由此,归因理论难以解释算法厌恶的不同情境,未来研究需要进一步明确归因理论的解释范围。

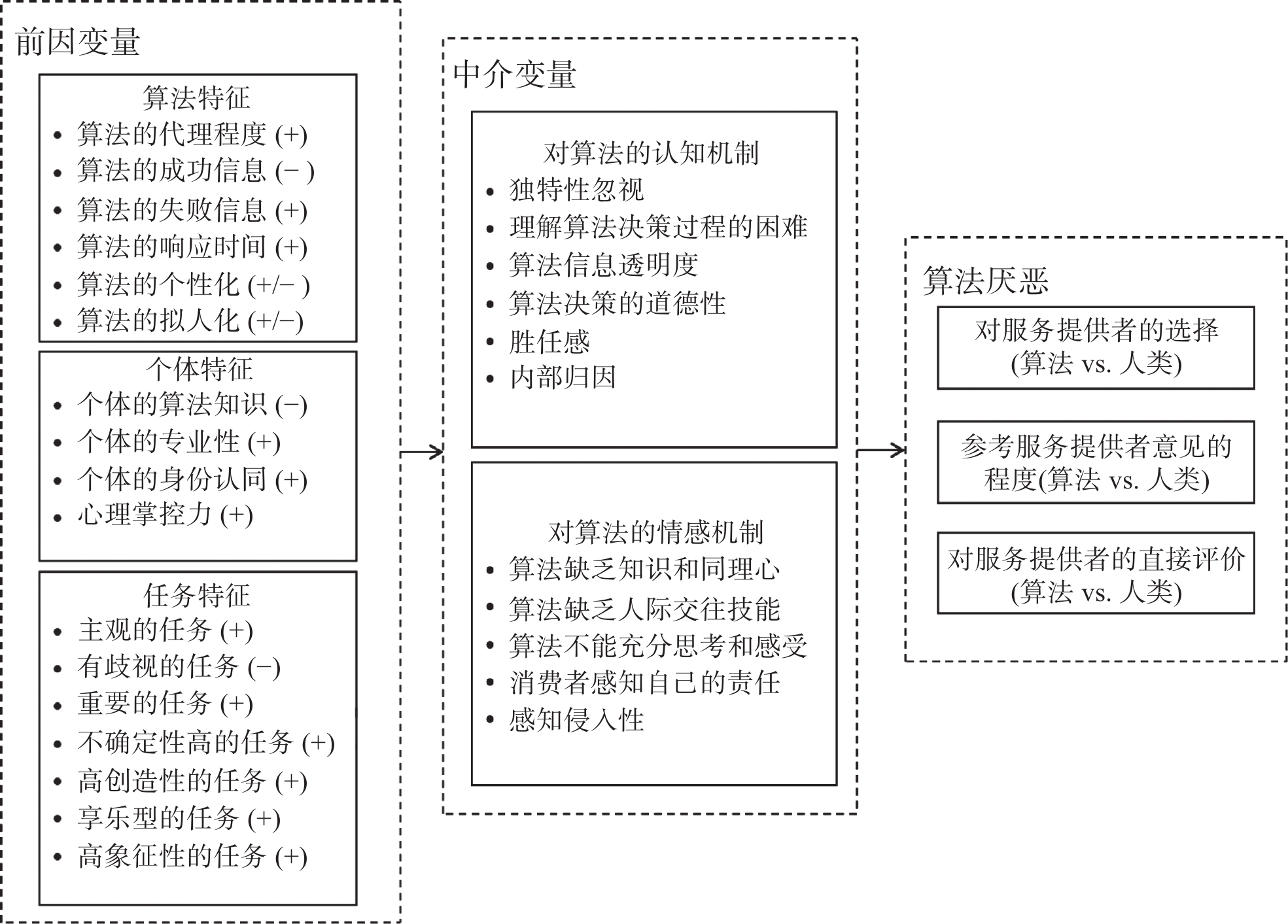

五、未来研究展望本研究对算法厌恶的概念、测量方式、影响因素及产生机制的实证研究进行了系统性的回顾。归纳与总结了影响算法厌恶的算法特征、个体特征和任务特征,算法厌恶产生的认知机制和情感机制,以及深层的理论解释,极大地丰富了以往的综述研究[10]。并据此绘制了现有研究脉络总结,如图1所示。

|

图 1 现有研究脉络 资料来源:根据相关文献整理归纳 |

未来研究可以从算法厌恶的边界条件、内在机制、干预策略、引发后果等四个方面拓展。在现有研究脉络的基础上,进一步探索引起算法厌恶的成因,其背后深层次的理论机制,降低算法厌恶的策略,以及探索算法厌恶对个体、组织和社会造成的影响。

1. 算法厌恶的边界条件扩充(1)理清算法厌恶还是算法欣赏关键的边界条件。关于算法厌恶和算法欣赏的临界条件没有形成统一的、稳健的结论。对于何时会发生算法厌恶、何时会发生算法欣赏没有形成规律性的论断。Castelo等认为算法厌恶还是算法欣赏,很大程度上取决于使用算法的任务类型以及人们如何看待任务[28]。他们发现,相比于客观的任务,人们对算法做主观的任务更为厌恶,在他们的研究中并未找到对于客观的任务,消费者转为算法欣赏的研究证据,而是仍表现出算法厌恶。然而Logg等发现,对于特定的客观任务,人们表现为算法欣赏[9]。因此,现有研究中关于算法厌恶和算法欣赏仍未找出清晰的边界,任务特征可能是关键,尤其是任务特征的组合。未来的研究可以采取元分析来比较算法厌恶和算法欣赏的效应量。

(2)探索介入度低的算法何时使算法厌恶消失,甚至变成算法欣赏。对于介入度低的算法,例如建议型算法辅助人类,这种人机混合模式与单独的人类或单独的算法相比,是否能获得消费者更多的偏好,现有研究没有一致的、明确的答案[7,26]。而人机混合模式的客观表现是否更佳也没有充分的研究证据支持[2]。这为以后的研究提供了有趣的研究方向。

(3)从算法、个体、任务等维度以及其他视角进一步探究可能影响算法厌恶的因素。本研究归纳了影响算法厌恶的算法特征、个体特征与任务特征,在这几个维度中有可能还存在其他影响算法厌恶的因素。例如,有研究发现,算法的可解释性存在双刃剑效应,当用户认为平台的算法较为简单时,增加算法透明度会降低用户采纳;当用户认为平台的算法较为复杂时,增加算法的透明度会增加用户采纳[56]。在任务特征维度,宋晓兵和何夏楠[57]发现,当面对差别定价,消费者认为人工智能定价更公正和公平。因此,影响算法厌恶的算法特征、个体特征、任务特征需要进一步挖掘和检验。此外,还可能存在影响算法厌恶的其他维度的因素。尤其,有必要引入影响算法厌恶的不同的情境的作用。例如,消费者在医疗领域,似乎有更强的算法厌恶[7,58]。这可能与情境的重要性、复杂度、容错率等因素有关。

2. 算法厌恶的内在机制挖掘(1)从创新性的视角挖掘算法厌恶的产生机制。本研究从对算法的认知机制、情感机制两个方面归纳了算法厌恶产生的机理。未来的研究可以超越现有的视角,提出创新性的算法厌恶的分析框架。罗映宇等将算法厌恶的成因归纳为算法视角和人类视角,分别代表人类如何认识算法及人类如何认识人类自身[16]。李游、梁哲浩和常亚平提出了人类偏爱机制,即人们对人类某些特性的偏好推动了算法厌恶的产生[11]。例如,Cadario等发现,人们有一种认为自己能理解人类医生决策过程的错觉[47]。对人类的偏爱是相对于对算法的偏好而言的,因此该机制需要和对算法的认知机制和情感机制区分开,挖掘出人们对人类某些特性的独特偏好。未来的研究可以进一步从创新性的视角挖掘算法厌恶的产生机理。

(2)从底层的理论机制挖掘算法厌恶的形成机理。现有的实证研究对于算法厌恶产生的机制探讨大多聚焦表面的现象,没有将现象抽象成理论。例如,研究表明人们对算法做主观的任务、高创造性和享乐型的任务表现出更强的算法厌恶[28,44-45],然而未挖掘背后更深层次的理论机制,从而难以将现有的结论推广到其他的任务类型或情境类型上。现有关于算法厌恶产生的理论有社会认同理论、归因理论等[30,32]。这些理论部分阐释了算法厌恶的产生机理,然而解释范围存在局限。现有研究也没有明确用这几个理论进行解释的逻辑关系,难以全面揭示算法厌恶产生的根源。总的来说,当前研究缺乏一个系统性的理论框架来解释算法厌恶产生的底层机制,无法基于现有理论对算法厌恶的产生条件进行推广和预测。这也为未来的研究提供了进一步的研究方向。

3. 算法厌恶的干预策略研究(1)探讨大幅降低算法厌恶,甚至转变为算法欣赏的干预策略。现有的研究基于算法厌恶的影响因素,设计干预措施以减少算法厌恶。例如,将算法的表现形式变得拟人化[32]、个性化[7],增加对算法决策过程的介绍[47]、提供有关算法优越性的信息等[28]。然而,这些干预措施的作用有限,只能小幅降低算法厌恶,不能使算法厌恶消失。未来的研究需要探索有效的方法来转变人们对算法的主观厌恶。

(2)形成整合性的降低算法厌恶的干预策略。现有研究中降低算法厌恶的策略较为碎片化,这是因为当前的研究对于算法厌恶的底层根源尚未形成共识,对于制定有效的应对策略存在较大的实践难度。未来的研究可以从影响算法厌恶的算法特征、个体特征、任务特征等角度出发,探索不同特征的结合以提高算法在社会生产和生活中的接受度。进而提出一个整合性的、在实践中更具有广泛意义的干预策略框架。

4. 算法厌恶引发的后果探索未来的研究应更加重视对于算法厌恶引发的正面或负面影响的探讨。目前,学术界多数研究集中于分析算法厌恶在不同情境下的产生机理及其干预条件的研究[7,43,59]。然而,对于算法厌恶对个体、组织及社会层面造成的广泛影响,当前鲜有研究关注[16]。例如,被算法监控的情况下劳动者可能会要求更高的工资[60]。算法厌恶是否一定会引发负面后果,有无可能有正向作用?医生对辅助决策类算法产生的算法厌恶对医疗服务流程、医疗质量会产生哪些影响?员工对企业中的绩效评价、监控类的算法产生的算法厌恶是否会影响企业的算法使用、员工满意度、员工招募及企业绩效?未来研究可以围绕算法厌恶导致的结果展开实证研究,如聚焦利用算法开展生产或管理实践的组织,开展案例研究和定量分析[4,16]。

| [1] |

Cheng J-Z, Ni D, Chou Y-H, et al. Computer-aided diagnosis with deep learning architecture: applications to breast lesions in US images and pulmonary nodules in CT scans.

Scientific reports, 2016, 6(1): 1-13.

DOI: 10.1038/s41598-016-0001-8. |

| [2] |

Yeomans M, Shah A, Mullainathan S, et al. Making sense of recommendations.

Journal of Behavioral Decision Making, 2019, 32(4): 403-414.

DOI: 10.1002/bdm.2118. |

| [3] |

Highhouse S. Stubborn reliance on intuition and subjectivity in employee selection.

Industrial and Organizational Psychology, 2008, 1(3): 333-342.

DOI: 10.1111/j.1754-9434.2008.00058.x. |

| [4] |

Möhlmann M, Zalmanson L, Henfridsson O, et al. Algorithmic Management of Work on Online Labor Platforms: When Matching Meets Control.

MIS quarterly, 2021, 45(4): 1999-2022.

DOI: 10.25300/MISQ/2021/15333. |

| [5] |

Dietvorst B J, Simmons J P, Massey C. Algorithm aversion: people erroneously avoid algorithms after seeing them err.

Journal of Experimental Psychology: General, 2015, 144(1): 114-126.

DOI: 10.1037/xge0000033. |

| [6] |

Dietvorst B J, Simmons J P, Massey C. Overcoming algorithm aversion: People will use imperfect algorithms if they can (even slightly) modify them.

Management science, 2016, 64(3): 1155-1170.

|

| [7] |

Longoni C, Bonezzi A, Morewedge C K. Resistance to Medical Artificial Intelligence.

Journal of Consumer Research, 2019, 46(4): 629-650.

DOI: 10.1093/jcr/ucz013. |

| [8] |

Bigman Y E, Gray K. People are averse to machines making moral decisions.

Cognition, 2018, 181: 21-34.

DOI: 10.1016/j.cognition.2018.08.003. |

| [9] |

Logg J M, Minson J A, Moore D A. Algorithm appreciation: People prefer algorithmic to human judgment.

Organizational Behavior and Human Decision Processes, 2019, 151: 90-103.

DOI: 10.1016/j.obhdp.2018.12.005. |

| [10] |

Jussupow E, Benbasat I, Heinzl A. Why are we averse towards algorithms? A comprehensive literature review on algorithm aversion. 2020. Proceedings of the 28th European Conference on Information Systems (ECIS), An Online AIS Conference: AIS Electronic Library, 2020: 1−16.

|

| [11] |

李游, 梁哲浩, 常亚平. 用户对人工智能产品的算法厌恶研究述评及展望.

管理学报, 2022, 19(11): 1725-1732.

|

| [12] |

Venkatesh V, Thong J Y, Xu X. Consumer acceptance and use of information technology: extending the unified theory of acceptance and use of technology.

MIS quarterly, 2012, 36(1): 157-178.

DOI: 10.2307/41410412. |

| [13] |

Promberger M, Baron J. Do patients trust computers?.

Journal of Behavioral Decision Making, 2006, 19(5): 455-468.

DOI: 10.1002/bdm.542. |

| [14] |

Glikson E, Woolley A W. Human Trust in Artificial Intelligence: Review of Empirical Research.

Academy of Management Annals, 2020, 14(2): 627-660.

DOI: 10.5465/annals.2018.0057. |

| [15] |

Efendić E, Van de Calseyde P P F M, Evans A M. Slow response times undermine trust in algorithmic (but not human) predictions.

Organizational Behavior and Human Decision Processes, 2020, 157: 103-114.

DOI: 10.1016/j.obhdp.2020.01.008. |

| [16] |

罗映宇, 朱国玮, 钱无忌, 等. 人工智能时代的算法厌恶: 研究框架与未来展望.

管理世界, 2023, 39(10): 205-233.

|

| [17] |

Kim H-W, Kankanhalli A. Investigating user resistance to information systems implementation: A status quo bias perspective.

MIS quarterly, 2009, 33(3): 567-582.

DOI: 10.2307/20650309. |

| [18] |

杜秀芳, 王静, 李方, 等. 算法厌恶还是算法欣赏?——不同建议来源对个体建议采纳的影响.

中国临床心理学杂志, 2023, 31(1): 75-79+95.

|

| [19] |

Önkal D, Goodwin P, Thomson M, et al. The relative influence of advice from human experts and statistical methods on forecast adjustments.

Journal of Behavioral Decision Making, 2009, 22(4): 390-409.

DOI: 10.1002/bdm.637. |

| [20] |

Bonezzi A, Ostinelli M. Can algorithms legitimize discrimination?.

Journal of Experimental Psychology: Applied, 2021, 27(2): 447.

DOI: 10.1037/xap0000294. |

| [21] |

Mahmud H, Islam A N, Ahmed S I, et al. What influences algorithmic decision-making? A systematic literature review on algorithm aversion.

Technological Forecasting and Social Change, 2022, 175: 121390.

DOI: 10.1016/j.techfore.2021.121390. |

| [22] |

景怡. 算法态度文献综述、研究框架和未来展望.

华东经济管理, 2023, 37(5): 107-118.

|

| [23] |

Jussupow E, Spohrer K, Heinzl A, et al. Augmenting medical diagnosis decisions? An investigation into physicians’ decision-making process with artificial intelligence.

Information Systems Research, 2021, 32(3): 713-735.

DOI: 10.1287/isre.2020.0980. |

| [24] |

Leyer M, Schneider S. Me, you or AI? How do we feel about delegation. 2019. Proceedings of the 27th European Conference on Information Systems (ECIS), Stockholm & Uppsala, Sweden: AIS Electronic Library, 2019: 1−17.

|

| [25] |

Tong S, Jia N, Luo X, et al. The Janus face of artificial intelligence feedback: Deployment versus disclosure effects on employee performance.

Strategic Management Journal, 2021, 42(9): 1600-1631.

DOI: 10.1002/smj.3322. |

| [26] |

Palmeira M, Spassova G. Consumer reactions to professionals who use decision aids.

European Journal of Marketing, 2015, 49(3/4): 302-326.

DOI: 10.1108/EJM-07-2013-0390. |

| [27] |

Pezzo M V, Pezzo S P. Physician evaluation after medical errors: does having a computer decision aid help or hurt in hindsight?.

Medical Decision Making, 2006, 26(1): 48-56.

DOI: 10.1177/0272989X05282644. |

| [28] |

Castelo N, Bos M W, Lehmann D R. Task-dependent algorithm aversion.

Journal of Marketing Research, 2019, 56(5): 809-825.

DOI: 10.1177/0022243719851788. |

| [29] |

Prahl A, Van Swol L. Understanding algorithm aversion: When is advice from automation discounted?.

Journal of Forecasting, 2017, 36(6): 691-702.

DOI: 10.1002/for.2464. |

| [30] |

Longoni C, Cian L, Kyung E J. Algorithmic Transference: People Overgeneralize Failures of AI in the Government.

Journal of Marketing Research, 2023, 60(1): 170-188.

DOI: 10.1177/00222437221110139. |

| [31] |

Chen J, Chen C, B. Walther J, et al. Do You Feel Special When an AI Doctor Remembers You? Individuation Effects of AI vs. Human Doctors on User Experience. Extended Abstracts of the 2021 CHI Conference on Human Factors in Computing Systems. Yokohama, Japan: ACM, 2021: 1–7.

|

| [32] |

Yalcin G, Lim S, Puntoni S, et al. Thumbs Up or Down: Consumer Reactions to Decisions by Algorithms Versus Humans.

Journal of Marketing Research, 2022, 59(4): 696-717.

DOI: 10.1177/00222437211070016. |

| [33] |

王海忠, 谢涛, 詹纯玉. 服务失败情境下智能客服化身拟人化的负面影响: 厌恶感的中介机制.

南开管理评论, 2021, 24(04): 194-206.

|

| [34] |

Kramer M F, Schaich Borg J, Conitzer V, et al. When do people want AI to make decisions?. Proceedings of the 2018 AAAI/ACM Conference on AI, Ethics, and Society. New Orleans, LA, USA: ACM, 2018: 204–209.

|

| [35] |

Shaffer V A, Probst C A, Merkle E C, et al. Why Do Patients Derogate Physicians Who Use a Computer-Based Diagnostic Support System?.

Medical Decision Making, 2013, 33(1): 108-118.

DOI: 10.1177/0272989X12453501. |

| [36] |

Gaube S, Suresh H, Raue M, et al. Do as AI say: susceptibility in deployment of clinical decision-aids.

NPJ digital medicine, 2021, 4(1): 31.

DOI: 10.1038/s41746-021-00385-9. |

| [37] |

Leung E, Paolacci G, Puntoni S. Man versus machine: Resisting automation in identity-based consumer behavior.

Journal of Marketing Research, 2018, 55(6): 818-831.

DOI: 10.1177/0022243718818423. |

| [38] |

Thurman N, Moeller J, Helberger N, et al. My Friends, Editors, Algorithms, and I: Examining audience attitudes to news selection.

Digital Journalism, 2019, 7(4): 447-469.

DOI: 10.1080/21670811.2018.1493936. |

| [39] |

Bogert E, Schecter A, Watson R T. Humans rely more on algorithms than social influence as a task becomes more difficult.

Scientific reports, 2021, 11(1): 8028.

DOI: 10.1038/s41598-021-87480-9. |

| [40] |

Bigman Y E, Yam K C, Marciano D, et al. Threat of racial and economic inequality increases preference for algorithm decision-making.

Computers in Human Behavior, 2021, 122: 106859.

DOI: 10.1016/j.chb.2021.106859. |

| [41] |

Dietvorst B J, Bharti S. People Reject Algorithms in Uncertain Decision Domains Because They Have Diminishing Sensitivity to Forecasting Error.

Psychological Science, 2020, 31(10): 1302-1314.

DOI: 10.1177/0956797620948841. |

| [42] |

吴继飞, 于洪彦, 朱翊敏, 等. 人工智能推荐对消费者采纳意愿的影响.

管理科学, 2020, 33(5): 29-43.

|

| [43] |

Longoni C, Cian L. Artificial Intelligence in Utilitarian vs.

Hedonic Contexts: The “Word-of-Machine” Effect. Journal of Marketing, 2022, 86(1): 91-108.

|

| [44] |

Wien A H, Peluso A M. Influence of human versus AI recommenders: The roles of product type and cognitive processes.

Journal of Business Research, 2021, 137: 13-27.

DOI: 10.1016/j.jbusres.2021.08.016. |

| [45] |

Granulo A, Fuchs C, Puntoni S. Preference for human (vs.

robotic) labor is stronger in symbolic consumption contexts. Journal of Consumer Psychology, 2021, 31(1): 72-80.

|

| [46] |

杜严勇. 厌恶算法还是欣赏算法?——算法认知差异与算法信任建构.

哲学分析, 2022, 13(3): 151-199.

|

| [47] |

Cadario R, Longoni C, Morewedge C K. Understanding, explaining, and utilizing medical artificial intelligence.

Nature human behaviour, 2021, 5(12): 1636-1642.

DOI: 10.1038/s41562-021-01146-0. |

| [48] |

Lee M K. Understanding perception of algorithmic decisions: Fairness, trust, and emotion in response to algorithmic management.

Big Data & Society, 2018, 5(1): 1-16.

|

| [49] |

Jago A S. Algorithms and authenticity.

Academy of Management Discoveries, 2019, 5(1): 38-56.

DOI: 10.5465/amd.2017.0002. |

| [50] |

Luo X, Tong S, Fang Z, et al. Frontiers: Machines vs.

humans: The impact of artificial intelligence chatbot disclosure on customer purchases. Marketing Science, 2019, 38(6): 937-947.

|

| [51] |

Luo X, Qin M S, Fang Z, et al. Artificial intelligence coaches for sales agents: Caveats and solutions.

Journal of Marketing, 2021, 85(2): 14-32.

DOI: 10.1177/0022242920956676. |

| [52] |

Tajfel H. Social psychology of intergroup relations.

Annual review of psychology, 1982, 33(1): 1-39.

DOI: 10.1146/annurev.ps.33.020182.000245. |

| [53] |

Mende M, Scott M L, van Doorn J, et al. Service robots rising: How humanoid robots influence service experiences and elicit compensatory consumer responses.

Journal of Marketing Research, 2019, 56(4): 535-556.

DOI: 10.1177/0022243718822827. |

| [54] |

Li X, Sung Y. Anthropomorphism brings us closer: The mediating role of psychological distance in User–AI assistant interactions.

Computers in Human Behavior, 2021, 118: 106680.

DOI: 10.1016/j.chb.2021.106680. |

| [55] |

Cheng P W, Novick L R. A probabilistic contrast model of causal induction.

Journal of personality and social psychology, 1990, 58(4): 545.

DOI: 10.1037/0022-3514.58.4.545. |

| [56] |

Lehmann C A, Haubitz C B, Fügener A, et al. The risk of algorithm transparency: How algorithm complexity drives the effects on the use of advice.

Production and Operations Management, 2022, 31(9): 3419-3434.

DOI: 10.1111/poms.13770. |

| [57] |

宋晓兵, 何夏楠. 人工智能定价对消费者价格公平感知的影响.

管理科学, 2020, 33(5): 3-16.

|

| [58] |

Kyung N, Kwon H E. Rationally trust, but emotionally? The roles of cognitive and affective trust in laypeople’s acceptance of AI for preventive care operations. Production and Operations Management, 2022: 1-20.

|

| [59] |

Garvey A M, Kim T, Duhachek A. Bad News? Send an AI.

Good News? Send a Human. Journal of Marketing, 2023, 87(1): 10-25.

|

| [60] |

Liang C, Peng J, Hong Y, et al. The Hidden Costs and Benefits of Monitoring in the Gig Economy.

Information Systems Research, 2022, 34(1): 297-318.

|

2. School of International Education,Zhejiang Sci-Tech University;

3. Laboratory for Intelligent Society and Governance, Zhejiang Lab

2024, Vol. 14

2024, Vol. 14