2. 网络系统与网络文化北京市重点实验室

在人工智能(Artificial Intelligence,简称AI)界,继2013年“Playing Atari with Deep Reinforcement Learning”一文的突破性创新之后,Google DeepMind的AlphaGo在围棋人工智能上的突破又一次震惊了世界!其实,从1950年香农教授提出为计算机象棋博弈编写程序开始,游戏人工智能就是人工智能技术研究的前沿,被誉为人工智能界的“果蝇”,推动着人工智能技术的发展,并对社会产生深远影响。

一、 人工智能的概念如果我们知道了什么是人工智能,那么游戏人工智能的含义也就不言而喻了。比起人工智能,更基础的概念是智能。那么什么是智能呢?权威辞书《韦氏大词典》的解释是“理解和各种适应性行为的能力”;《牛津词典》的说法是“观察、学习、理解和认识的能力”;《新华字典》的解释是“智慧和能力”;James Albus在答复Henry Hexmoor时说“智能包括:知识如何获取、表达和存储;智能行为如何产生和学习;动机、情感和优先权如何发展和运用;传感器信号如何转换成各种符号;怎样利用各种符号执行逻辑运算、对过去进行推及对未来进行规划;智能机制如何产生幻觉、信念、希望、畏惧、梦幻甚至善良和爱情等现象”[1]。

作为一门前沿科学和交叉学科,人工智能至今尚无统一的定义。不同科学背景的学者对人工智能做了不同的解释:符号主义学派认为人工智能源于数理逻辑,通过计算机的符号操作来模拟人类的认知过程,从而建立起基于知识的人工智能系统;联结主义学派认为人工智能源于仿生学,特别是人脑模型的研究,通过神经网络及网络间的链接机制和学习算法,建立起基于人脑的人工智能系统;行为主义学派认为智能取决于感知和行动,通过智能体与外界环境的交互和适应,建立基于“感知-行为”的人工智能系统。其实这三个学派从思维、脑、身体三个方面对人工智能做了阐述,目标都是创造出一个可以像人类一样具有智慧,能够自适应环境的智能体。理解了人工智能的内涵以后,我们应该怎么衡量和评价一个智能体是否达到人类智能水平呢?目前有两个公认的界定:图灵测试和中文屋子。一旦某个智能体能够达到这两个标准,那么就认为它具备了人类智能。

游戏人工智能是人工智能在游戏中的应用和实践。它通过分析游戏场景变化、玩家输入获得环境态势的理解,进而控制游戏中各种活动对象的行为逻辑,并做出合理决策,使它们表现得像人类一样智能,旨在提高游戏娱乐性、挑战智能极限。游戏人工智能是结果导向的,最关注决策环节可以看做“状态(输入)”到“行为(输出)”的映射,只要游戏能够根据输入给出一个看似智能的输出,那么我们就认为此游戏是智能的,而不在乎其智能是怎么实现的(Whatever Works)。那么如何衡量游戏人工智能的水平呢?目前还没有公认的评价方法,而且游戏人工智能并不是特别关心智能体是否表现得像人类一样,而是更加关心游戏人工智能的智能极限——能否战胜人类的领域专家,如Waston在智能问答方面战胜了 Jeopardy,超级明星 Ken Jennings 和 Brad Rutter,AlphaGo在围棋上战胜了欧洲冠军樊麾。

二、 游戏机理 1. 人类的游戏机理游戏对我们来说并不陌生,无论是小时候的“小霸王学习机”,还是五子棋、象棋等各种棋类游戏,都是童年的美好回忆。自香农发表计算机象棋博弈编写程序的方案以来,游戏人工智能已经走过了半个多世纪,无数的科学家贡献了自己的才华和岁月,取得了许多里程碑意义的成果,如表 1所示。

| 表 1 游戏人工智能里程碑 |

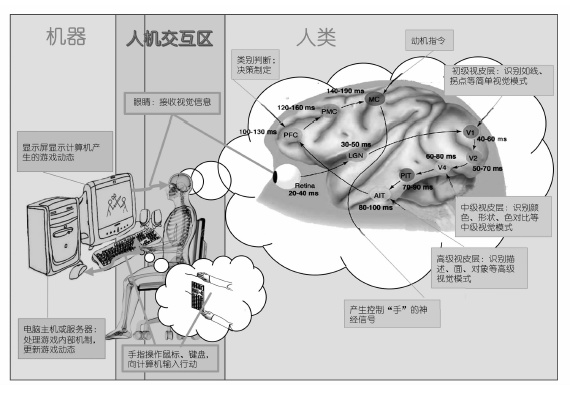

但人类玩游戏的整个过程是什么样的呢?具体过程如图 1所示:首先玩家眼球捕捉显示屏上的游戏画面并在视网膜上形成影像;然后经过视觉神经传至V1区,并提取线条、拐点等初级视觉信息;初级视觉信息经过V2区传至V4区,并进一步提取颜色、形状、色对比等中级视觉信息;中级视觉信息经过PIT传至AIT,进而提取描述、面、对象等高级视觉信息并传至PFC;在PFC进行类别判断,并根据已有的知识制定决策,然后在MC的动机的促发下产生行为指令并传至响应器官(手);响应器官执行操作;至此,玩家的游戏机制已经完成。计算机在接收到玩家的输入(键盘、鼠标等)以后,根据游戏的内部逻辑更新游戏状态,并发送至输出设备(显示屏)展示给用户,自此计算机游戏环境更新完成。然后玩家展开下一次游戏机理,并循环直至游戏结束或玩家放弃游戏。

|

图 1 人类游戏机理 |

游戏人工智能是创造一种代替人类操作游戏的智能体。想要让机器玩好游戏,我们就需要了解“它”玩游戏的机理,这样才能更好地改进它。

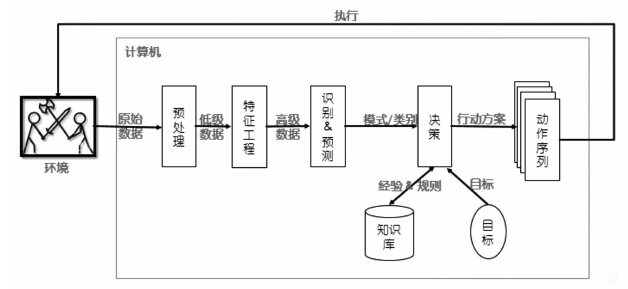

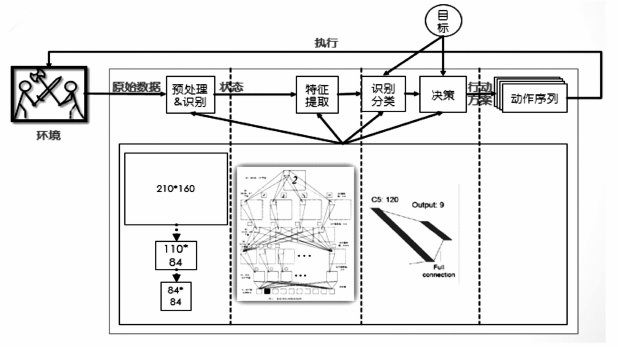

计算机的游戏机理如图 2所示:首先通过某种方式(读取视频流、游戏记录等)获得环境的原始数据,然后经过去重、去噪、修正等技术对数据进行预处理,并提取低级语义信息;然后经过降维、特征表示(人工或计算机自动提取)形成高级语义信息;然后通过传统机器学习方法进行模式识别,进一步理解数据的意义;最后结合先前的经验(数据挖掘,或人工提取,或自学习产生的领域知识库)决策生成行动方案,进而执行改变环境,并进行新一轮的迭代。在每次迭代的过程中,智能体还可以学习新的经验和教训,进而进化成更加智能的个体。

|

图 2 计算机游戏机理 |

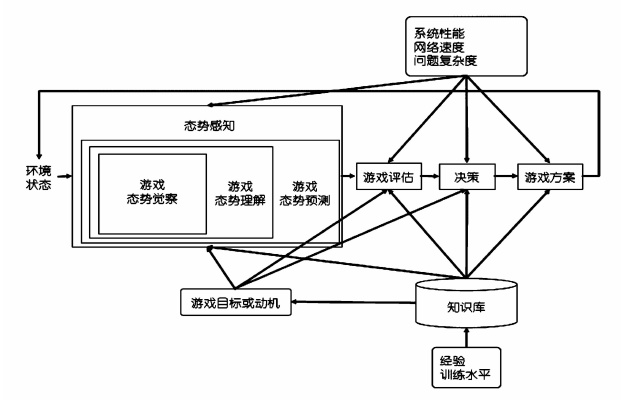

从人类和计算机的游戏机理,我们可以总结出游戏玩家的一般性机理,如图 3所示:游戏玩家可以看做是一个态势感知过程,接收原始数据作为输入,输出动作序列,在内部进行了态势觉察产生低级信息、态势理解形成高级认知、态势预测估计将来的态势,并根据已有的经验和规则,在目标和动机的驱动下产生行动方案,从而指导游戏向更有利于玩家的方向进行,然后进入下一个循环序列。

|

图 3 游戏一般过程机理(SA图 源于Endsley) |

游戏的一般性机理还可以看做是一个“状态”到“动作”的映射。游戏的环境状态、玩家的目标是自变量,玩家的操作是因变量,而映射关系是游戏一般机理的核心部分。它可以通过如神经网络这种技术来对自变量进行特征提取和表征,也可以直接使用自变量,利用公式计算获得输出值,进而映射到相应的动作。

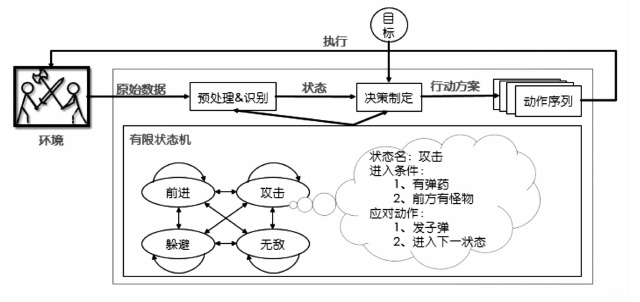

三、 游戏人工智能实现技术 1. 有限状态机当你设法创造一个具有人类智能的生命体时,可能会感觉无从下手;一旦深入下去,你会发现:只需要对你所看到的做出响应就可以了。有限状态机就是这样把游戏对象复杂的行为分解成“块”或状态进行处理的,其处理机制如图 4所示:首先接收游戏环境的态势和玩家输入;然后提取低阶语义信息,根据每个状态的先决条件映射到响应的状态;接着根据响应状态的产生式规则生成动作方案;最后执行响应动作序列并输入游戏,进入下一步循环。比较图 4和图 2可知:有限状态机方法是计算机游戏机理的一种简单实现:根据规则人为将原始数据映射到“状态”完成“特征工程和识别”,根据产生式系统将“状态”映射到响应的动作完成“决策制定”,而实现游戏态势理解、评估和游戏动机透明。

|

图 4 有限状态机游戏机理 |

那么理论层次上的“有限状态机”又是怎么描述的呢?有限状态机是表示有限个状态以及在这些状态之间转移和动作等行为的特殊有向图,可以通俗地解释为“一个有限状态机是一个设备,或是一个设备模型,具有有限数量的状态,它可以在任何给定的时间根据输入进行操作,使得从一个状态变换到另一个状态,或者是促使一个输出或者一种行为的发生。一个有限状态机在任何瞬间只能处在一种状态”[2]。通过相应不同游戏状态,并完成状态之间的相互转换可以实现一个看似智能的游戏智能引擎,增加游戏的娱乐性和挑战性。

有限状态机这种实现方式固然简单易懂、容易实现,但是游戏状态的划分、响应动作的制定都直接依赖于人类的先验知识,并决定了游戏的智能水平;因为游戏处理的时间和空间复杂度随着游戏状态的增多而指数型增加,所以有限状态机只适用于状态较少的游戏;有限状态机还有一个致命缺陷就是难以处理状态碰撞的情况。

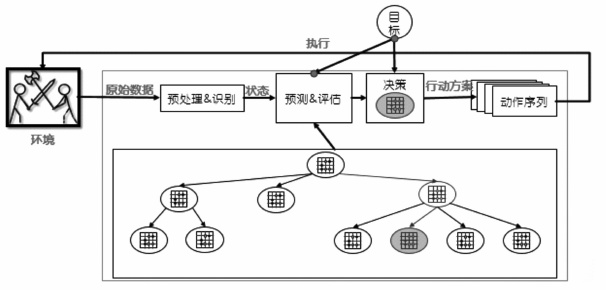

2. 搜索“人无远虑,必有近忧”,如果能够知晓未来的所有情况并进行评估,那么只需要筛选出最好的选择路径就可以完成决策。搜索在棋类游戏的智能实现中备受青睐,其中表现最优秀的是α-β搜索树和蒙特卡洛搜索树。与游戏的一般性机理相比,搜索的游戏人工智能更关注的是预测和评估,而决策的制定只需挑选出预测的最好方式即可,如图 5所示。

|

图 5 博弈树游戏机理 |

搜索的实现方式直观易懂,如果穷尽搜索一定可以找到游戏的全局最优值,而且它适用于一切游戏智能实现。但是搜索成功的前提是准确的态势评估和搜索深度,而态势评估一般是专家制定的,即使是使用机器学习学得的评估函数依然很难客观衡量当前态势,搜索的时空复杂度更是随着搜索的深度呈指数型增长。

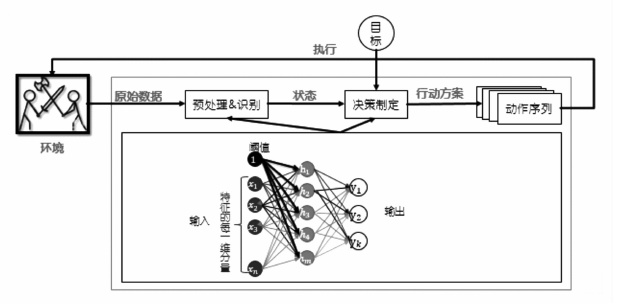

3. 有监督学习分类、拟合是有监督学习方法,也是实现游戏人工智能的重要方法,旨在有标签的数据中挖掘出不同类别的特性。无论什么游戏,人类都是在不断的学习中才成为游戏高手的,棋类游戏更是需要学习前人经验并经过专门的训练才能有所成就。经过几千年的探索,人类积累了包括开局库、残局库、战术等不同的战法指导玩家游戏。与游戏的一般性机理相比,有监督学习更关注的是预处理、态势理解和态势预测,首先需要对数据进行去重、去噪、填充缺失值等预处理,然后分析数据并提取数据特征,再使用机器学习算法从数据中挖掘潜在信息并形成知识,实现对当前态势的直观描述或者态势到决策的映射,具体如图 6所示。Google DeepMind的围棋程序AlphaGo就使用了有监督学习训练策略网络,用以指导游戏决策;它的SL策略网络是从KGS GO服务器上的30,000,000万棋局记录中使用随机梯度上升法训练的一个13层的神经网络,在测试集上达到57.0%的准确率,为围棋的下子策略提供了帮助[3]。

|

图 6 有监督学习机理 |

在无人工参与的情况下,有监督学习能够从数据中自主学习成为游戏高手,而且通过不同的有标签数据训练,同一模型无需改动或者做极小改动就可以适用于不同的游戏。但是,“rubbish in,rubbish out”,数据的质量和数量直接决定了有监督学习模型的性能,而且有监督模型一般存在欠拟合和过拟合的现象,有的算法还极易陷入局部最优解,除此之外模型参数的选取也直接决定了智能体的智能水平。

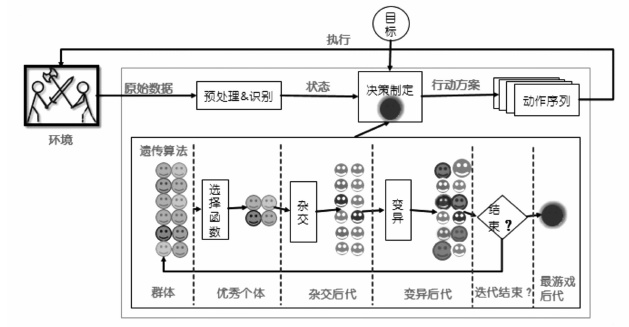

4. 遗传算法遗传算法是进化算法的一种。它模拟达尔文进化论的物竞天择原理,不断从种群中筛选最优个体,淘汰不良个体,使得系统不断自我改进。遗传算法可以使得游戏算法通过不断的迭代进化,可以从一个游戏白痴进化成为游戏高手,是一个自学习的算法,无需任何人类知识的参与。

在系统中,每个个体是一个游戏智能体(一种游戏智能的实现方式,能根据游戏输入产生决策输出),并通过某种映射转化为一串遗传信息,这串信息代表了我们所要优化游戏智能体的全部特征。如图 7所示,与游戏的一般性机理对比,遗传算法更关注决策指定,旨在通过一定数量的游戏智能体(可能是随机生成的,也可能是人为指定的,也可能是机器学习学得的)自我进化出一个具有高超游戏水平的游戏智能体,从而实现游戏态势到应对方案的正确映射。遗传算法维持一个由一定数量个体组成的种群,每一轮都需要计算每个个体的适应度,然后根据适应度选出一定数量存活的个体,同时淘汰掉剩余落后的个体。随后,幸存的个体将进行“繁殖”,填补因为淘汰机制造成的空缺,从而维持种群的大小。所谓的繁殖,就是不同个体组合自己本体的一部分形成新的副本。然而为了实现进化,必须要有模仿基因突变的机制。因此在复制副本的时候也应当使得遗传信息产生微小的改变。“选择-繁殖-突变”这样的过程反复进行,就能实现种群的进化。

|

图 7 遗传算法游戏机理 |

遗传算法是一种与问题领域无关的自学习算法,可以在无人为参与的情况下实现游戏智能,而且遗传算法可扩展性强,可以组合其他游戏智能实现技术获得更加智能的游戏个体。但是遗传算法一般只能获得满意解,而不能获得最智能的游戏智能体;而且参数、适应性函数的确定需要不断尝试,否则会严重影响游戏个体的智能性;另外,遗传算法求解速度很慢,要得到游戏较智能的个体需要较多的训练时间。

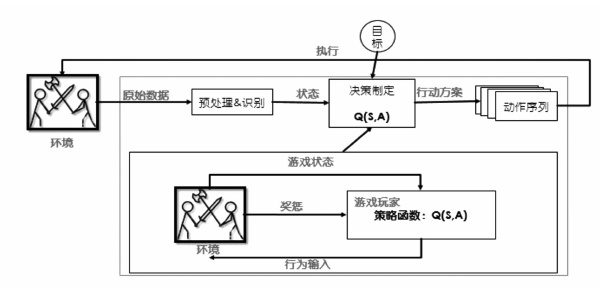

5. 强化学习一无所知的游戏智能体通过不断地与环境交互来改进自己,进而趋利避害,这就是强化学习。如图 8所示,与游戏的一般性机理相比,强化学习更关注决策制定,它内部维护一个策略函数,通过对游戏态势做出决策从而获得反馈,并不断改进策略函数使得针对环境态势、自身决策获得最大报酬值,让游戏结果向着有利于游戏智能体的方向发展,不断迭代这个过程就可以获得态势到决策的最优映射。

|

图 8 强化学习游戏机理 |

强化学习有着坚实的数学基础,也有着成熟的算法,在机器人寻址、游戏智能、分析预测等领域有着很多应用;而且强化学习是一种与问题领域无关的自学习算法,可以在无任何人为参与的情况下实现游戏智能。但是强化学习对于连续、高维的马氏决策问题将面临维数灾难,而且学习效率不高、在理论上的收敛性也难以保证[4]。

6. DRNDRN是Google DeepMind在“Playing Atari with Deep Reinforcement Learning”一文中结合深度学习和强化学习形成的神经网络算法,旨在无需任何人类知识,采用同一算法就可以让玩家在多款游戏上从游戏白痴变成游戏高手。其原理如图 9所示:首先使用数据预处理方法把128色的210×160的图像处理成灰度的110×84的图像,然后从中选出游戏画面重要的84×84的图像作为神经网络的输入;接着使用CNN自动进行特征提取和体征表示,作为BP神经网络的输入进行有监督学习,自动进行游戏策略的学习[5]。

|

图 9 DRN游戏机理 |

DRN在Atari游戏上的应用证明了它的成功:击败了人类顶级玩家。但是DRN底层使用了CNN做特征提取,使得它更适用于以二维数据为输入的游戏。

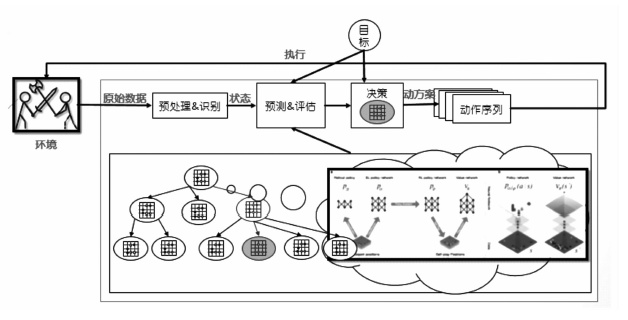

7. 深度学习+强化学习+博弈树Google DeepMind的AlphaGo使用值网络来评价棋局形式,使用策略网络来选择棋盘着法,使用蒙特卡洛树来预测和前瞻棋局,试图冲破人类智能最后的堡垒。AlphaGo的原理如图 10所示:策略网络使用由监督学习训练+强化学习共同训练获得,而值网络仅使用强化学习训练获得,通过这两个网络结构总结人类经验,自主学习获得对棋局的认知;然后使用蒙特卡洛树将已经学得的知识应用于棋局进行预测和评估,从而制定着法的选择。

|

图 10 AlphaGo的游戏机理 |

继图形和交互技术之后,人工智能成为游戏科技发展的瓶颈,人们不再单纯追求更真实、更美丽的画面,而是更人性、更智能的游戏伙伴(对手)。计算机思考问题的过程其实就是数值计算的过程。游戏人工智能的实现需要坚实的数学理论。最好的浅层机器学习算法SVM,其求解目标在于确定一个二分类的超平面,以最大化样本在特征空间上的间隔,其中涉及线性空间到高维空间的映射、KKT最优化算法等;风头正劲的深度神经网络,无非就是在海量数据的基础上拟合出一个非常复杂的函数来实现特征学习、分类拟合,其中涉及卷积计算、蒙特卡洛方法、最优化求解等;在自主决策独树一帜的强化学习其实就是一个马尔科夫决策过程,通过不断的迭代来不断更新内部的策略函数,最终实现自主决策,其中涉及随机过程、最优化求解等;简单而广泛使用的决策树,其分支依据有信息增益率、Gini准则等,其中涉及信息论等。在高级的人工智能中数学无处不在,也从根本上制约着人工智能的发展,它的每一次突破都能引发人工智能的新一波热潮。

计算机思考问题的过程其实就是移位、与或非等计算的过程,所以任何人工智能算法的成功都依赖于大量的计算。震惊世界的AlphaGo最后一个版本共使用了40个搜索线程,48个CPU和8个GPU;多台机器实现的分布式AlphaGo版本共使用了40个搜索线程,1202个CPU和176个GPU[3]。谷歌大脑运用深度学习的研究成果,使用 1000 台电脑创造出包含10亿个连接的“神经网络”,使机器系统自动学会识别猫[6]。海量数据的处理也使得并行计算框架Hadoop、Spark等在人工智能中变得炙手可热。

众所周知,人工智能是当前制约游戏、机器人等科技发展的瓶颈,人工智能研究的难点是对认知的解释与建构,而认知研究的关键问题则是自主和情感等意识现象的破解。生命认知中没有任何问题比弄清楚意识的本质更具挑战性,或者说更引人入胜。这个领域是科学、哲学、人文艺术、神学等领域的交集。尽管意识问题如此重要,令人啼笑皆非的是:无论过去还是现在,一旦涉及到意识问题,大家不是缄口不提,就是敬而远之,避之唯恐不及。究其原因,不外乎意识的变化莫测与主观随意等特点严重偏离了科学技术的逻辑实证与感觉经验验证判断。既然与科学技术体系相距较远,自然就不会得到相应的认同与支持了。如此看起来似乎顺理成章,理应如此,但是最近科技界一系列的前沿研究正悄悄地改变着这个局面:研究飘忽不定的意识固然不符合科技的尺度,那么在意识前面加上情境(或情景)二字呢?人在大时空环境下的意识是不确定的,但“格物致知”一下,在小尺度时空情境下的意识应该有迹可循吧!自古以来,人们就知道“天时地利人和”的小尺度时空情境对态势感知及意识的影响,只是明确用现代科学的手段实现情境(或情景)意识的研究则源自1988年Mica Endsley 提出的情景意识Situation Awareness(SA)概念框架①: “…the perception of the elements in the environment within a volume of time and space,the comprehension of their meaning,and the projection of their status in the near future.” [7](在一定的时间和空间内对环境中的各组成成分的感知、理解,进而预知这些成分的随后变化状况)。但这只是个定性分析概念模型,其机理分析与定量计算还远远没有完善。

①详细内容可在公众微信号"人机与认知实验室"中参见相关文章。

在真实的游戏人工智能系统交互领域中,人的情景意识、机器的物理情景意识、环境的地理情景意识等往往同构于统一时空中(人的五种感知也应是并行的),人注意的切换使之对于人而言发生着不同的主题与背景感受/体验,类似基督教中的三位一体。在人的行为环境与机的物理环境、地理环境相互作用的过程中,人的情景意识被视为一个开放的系统,是一个整体,其行为特征并非由人的元素单独所决定的,而是取决于人机环境系统整体的内在特征,人的情景意识及其行为只不过是这个整体过程中的一部分罢了。另外,人机环境中许多个闭环系统常常是并行或嵌套的,并且特定情境下这些闭环系统的不同反馈环节信息又往往交叉融合在一起,起着或兴奋或抑制的作用,不但有类似宗教情感类的柔性反馈(不妨称之为软调节反馈,人常常会延迟控制不同情感的释放),也存在着类似法律强制类的刚性反馈(不妨称之为硬调节反馈,常规意义上的自动控制反馈大都属于这类反馈)。如何快速化繁为简、化虚为实是衡量一个人机系统稳定性、有效性、可靠性大小的主要标志,是用数学方法的快速搜索比对还是运筹学的优化修剪计算,这是一个值得游戏人工智能领域深究的问题。

游戏人工智能交互系统往往是由有意志、有目的和有学习能力的人的活动构成,涉及变量众多、关系复杂,贯穿着人的主观因素和自觉目的,所以其中的主客体界线常常模糊,具有个别性、人为性、异质性、不确定性、价值与事实的统一性、主客相关性等特点,充满了复杂的随机因素的作用,不具备重复性。另外,游戏人工智能交互系统有关机(装备)、环境(社会、自然)研究活动中的主客体则界线分明,具有较强的实证性、自在性、同质性、确定性、价值中立性、客观性等特点。诸多主客观元素的影响,进而导致了人机环境交互系统的异常复杂和非常的不确定。所以对游戏人工智能交互系统的研究不应仅仅包含科学的范式,如实验、理论、模拟、大数据,还应涉及到人文艺术的多种方法,如直观、揣测、思辨、风格、图像、情境等,在许多状况下还应与哲学、宗教的多种进路相关联,如现象、具身、分析、理解与信仰等等。而无论是在古代、中世纪还是在现代,哲学、宗教早已不单纯是意识形态,而且逐渐成为各个阶级中的强大的政治力量,其影响不断渗透到社会生活的各个领域,更有甚者,把哲学、政治、法律等上层建筑都置于宗教控制之下。在这种情形下,人工智能的研究则愈显复杂。

在充满变数的游戏人工智能交互系统中,存在的逻辑不是主客观的必然性和确定性,而是与各种可能性保持互动的同步性,是一种得“意”忘“形”的见招拆招和随机应变能力。这种思维和能力可能更适合复杂的人类各种艺术过程。对此种种,恰恰是游戏及人工智能所欠缺的地方。

五、 小结游戏人工智能关注挑战智力极限,表征是游戏战胜人类最强者。与教导人类成为领域专家不同,游戏人工智能更关注培育自学习能力的智能体,表征是无经验自主学习。所以,当前最先进的两个游戏引擎均使用了深度学习和强化学习两方面的知识,旨在培育具有自学习能力的高智能个体。

随着计算机硬件水平和软件技术的提升,中国的游戏产业迅猛发展,人工智能在游戏中的应用也更加广泛与完善,游戏的可玩性大幅增强,对人工智能、游戏领域及相关产业产生很大影响。近10年来,电子竞技在我国从一个被所有人误解的边缘化产业,逐步变成了一个成熟、庞大的新兴产业链条,电子竞技正在逐渐成长为一个不可忽视的庞大产业。其实自香农提出为计算机象棋博弈编写程序以来,追求更强、更智能游戏智能体的脚步就从未停止,战胜世界冠军李世石的AlphaGo更是被认为突破了人类最后的堡垒。设计这种游戏智能时,更关注的是提高游戏智能体的游戏水平,而不关注是否类人化,所以更像是不通世事的“书呆子”。而普通人在与计算机游戏对战时,并不希望自己面对的是一个冷冰冰的机器,而是有喜有忧、患得患失的有血有肉的玩家,计算机的游戏水平也应该与玩家水平相近,既不能让玩家因无法胜利而沮丧,也不能让玩家容易取胜而感到无聊。因此游戏人工智能能够让游戏智能人性化,并调节自己的水平以适应玩家。

AlphaGo与李世石的围棋之战受到大家的极大关注。现在的人机比分是否表示机器已经突破人类最后的堡垒呢?是否表示达到智能极限?游戏人工智能下一步的研究关注点又应该是什么呢?作者认为,即使战胜李世石机器也没有达到人类智能的极限,与记忆和速算一样,搜索与前瞻的能力也不能代表人类智能,人类还有情感、有思想、能快速学习等等能力。所以,AlphaGo即使战胜李世石也只是在某个领域里面比人类更强而已;游戏人工智能不能使用图灵测试、中文屋子来衡量人工智能的程度,因为人类在游戏(特别是棋类游戏)上的智能并不突出,因为人脑的复杂度有限,并不能计算游戏的最优值,只是在能力范围内做出较优的决策,所以“游戏人工智能的关注点应该是:同一游戏引擎作为双方对战,总是同一方(先手或后手)取胜,而且能够战胜人类最强者”。即使AlphaGo战胜李世石,棋类智能仍有探索的空间:游戏的最优值!

同时,人们也十分关心如何将游戏智能迁移运用到现实世界中。棋类等大多数游戏通常是有限状态、有规则的完全信息条件下的博弈,而像军事等现实世界具有高维、动态、不确定性的特点,是无规则的不完全信息下的决策。DeepMind团队在战胜李世石后转战星际争霸,试图探索在状态更多、规则性更弱、信息不完全条件下的博弈,更有甚者试图将AlphaGo技术应用到兵棋推演、军事空战决策中。此外,与深蓝、Watson不同,DeepMind团队的研究成果除了高超的游戏技能以外,还在于其自主学习的能力和可迁移的能力,这也是它能够大放异彩的原因。人们一直希望建立一种游戏智能框架:它无需任何人为参与就能在不同的游戏中通过自主学习成为游戏高手,其中DeepMind的DRN技术在无需人为参与、无需调整算法框架的情况下,只通过自主学习就能精通7种Atari 2600游戏,甚至在某些游戏中超过人类玩家。

2. Beijing Key Laboratory of Network System and Network Culture

| [1] |

Nils J.Nilsson. 人工智能. 郑扣根, 庄越挺译. 北京: 机械工业出版社, 2007.

( 0) 0)

|

| [2] |

Mat Buckland. 游戏人工智能编程案例精粹. 罗岱等译. 北京: 人民邮电出版社, 2008.

( 0) 0)

|

| [3] |

D. Silver, A. Huang, C. J. Maddison, A. Guez, L. Sifre. Mastering the Game of Go with Deep Neural Networks and Tree Search.

Nature,2016, 529 (7587) : 484-489.

DOI: 10.1038/nature16961. ( 0) 0)

|

| [4] |

陈学松, 杨宜民. 强化学习研究综述.

计算机应用研究,2010, 27 (8) : 2834-2838.

( 0) 0)

|

| [5] |

V. Mnih, K. Kavukcuoglu, D. Silver, A. Graves. Playing Atari with Deep Reinforcement Learning.

Computer Science,2013 .

( 0) 0)

|

| [6] |

涂兰敬. 谷歌的人工智能.

中国计算机报,2015.01.05 (007) .

( 0) 0)

|

| [7] |

Endsley M. R. Situation Awareness in Aviation Systems. In Garland D. J, Wise J. A, Hopkin V. D. Handbook of Aviation Human Factors.

Mahwah, NJ: Erlbaum,1999 : 257-276.

( 0) 0)

|

2016, Vol. 6

2016, Vol. 6