近年来,人工智能应用于临床诊断发展迅速。2014年,IBM公司开发的电脑医生“沃森”(Waston)登上医疗舞台,以其海量的医学知识和超常的阅读能力迅速成为癌症专家[1]。该系统给出的诊断建议在96%的受试者中与医院肿瘤委员会给出的诊断结果相匹配,但筛查时间却缩短了78%,另外,智能医生还可以辅助人类医生制定个性化的治疗方案[2]。2017年5月,丁香园、中南大学湘雅二医院和大拿科技发布了国内首个“皮肤病人工智能辅助诊断系统”,该模型对红斑狼疮及各种亚型疾病的识别准确率超过85%[3]。

然而,人工智能辅助临床诊断的可信度仍然令人担忧,主要源自算法中可能出现的数据“黑箱”(black box),即数据输入和输出过程的无法解释[4]。无疑,人类无法完全信任以算法为主的弱人工智能,对这种新型智慧的认识还太粗浅[5]。有学者认为,弱人工智能无独立思考的意识和运作能力,并无任何主体性可言,主体仍是作为人工智能设计者和制造者的人类[6]。也有学者认为,弱人工智能体也具有一定的自主性,但这种自主性不是自由意志方面的,而是行为意义上的,指能够在不受外力的影响下独立决定和选择[7]。2017年2月我国原国家卫生和计生委员会印发的《人工智能辅助诊断技术管理规范》,2018年4月国家卫生健康委员会印发的《全国医院信息化建设标准与规范(试行)》,国家药品监督管理局发布的《深度学习辅助决策医疗器械软件审评要点》《人工智能医用软件产品分类界定指导原则》等文件,都提到了人工智能在临床应用中的辅助定位[8]。美国医学会使用“增强智能”(augmented intelligence)来描述医疗人工智能技术,强调它存在的目的是增强人类医生的智能,而非取代它[9]。尽管如此,以人工智能辅助诊断、决策和推理为基础的“医疗决策支持系统”(Medical Decision Support System,MDSS)软件为提高医疗决策的精准度提供了强有力支持。最近一项研究使用4万余幅肺癌患者CT扫描图像训练的深度学习模型预测肺部肿瘤,其准确率已经高达94%[10]。

无疑,人工智能辅助诊断对医患双方主体性的发挥都产生一定影响。从医生的角度来看,虽然人工智能的辅助定位决定了医生只能选择性地采纳意见,但仍可能影响到医生的自主诊断。从患者的角度来看,人工智能可能造成对其自主性的严重干预,导致患者盲目地信任大数据算法。并且,在人类医生和智能医生的诊断结果存在巨大差异的情况下,患者无论是武断地否定人类医生的诊断结果,还是无法在两者之间进行自主选择,都不同程度地弱化了人类医生的权威,进而导致医患信任更加难以维系。孙保学认为,患者对人工智能诊疗的信任是否会发展成高度信赖仍值得怀疑,存在多重因素会削弱人们对MDSS的信赖,患者仍保有自主决策权[11]。当然,临床决策中患者的自主性主要通过知情同意原则的实施来实现,人工智能辅助诊断以信息处理和数据分析为主,它对于提升患者的疾病信息处理水平并形成对疾病的科学认知有着重要帮助。但是,它是否能够因此减少知情同意中的障碍仍值得怀疑,因为过分的信息解读更有可能误导患者做出不同意的医疗决定。因而人工智能辅助诊断实际上可能造成患者在知情同意过程中的各种迷惑,导致医疗决策困难。那么,人工智能辅助诊断在何种层面上能够影响医患双方的主体性并进而影响医患共同决策?

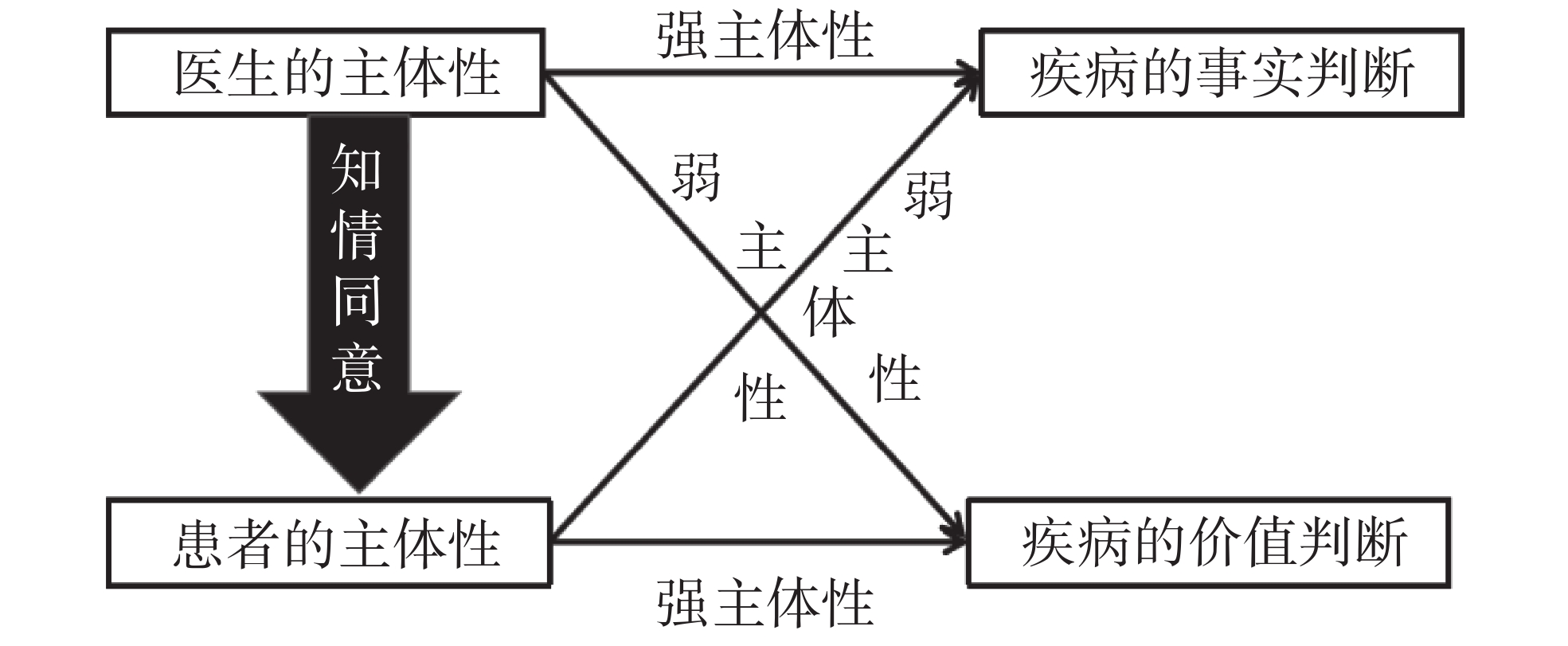

一、知情同意中的医患主体性当前的临床实践通过知情同意来平衡医患主体性,在“知情”和“同意”中分别体现出不同的主体性特征。首先,“知情”是医生通过信息告知获得患者信任的过程,医生体现出强主体性特征,它不只是认知性的,还是价值性的。医生的强主体性尤其隐含在对患者最佳利益的偏好中,不仅会在客观上评估治疗方案的可行性与风险,而且会在主观上引导患者选择最佳利益,这种引导包含了道德价值的评判。其次,医生的引导要发生作用需依赖患者的“信息理解”,此时,患者对疾病信息的处理体现出强主体性特征,其中包含患者的价值判断。因而在“知情”环节已经产生了医患双方的认知与价值主体性,医生的“信息告知”是关键,在告知的过程中产生医患主体间性,医患双方都需要依靠理智来判断对方的真实意图并进行价值取舍。

医生的主体性体现在通过有效的“信息告知”引导患者做出选择。如果医生只考虑诊疗方案的真实性和可行性,那么,以尽可能客观的方式告知患者疾病的真实信息即可。但现实中这样的信息告知并不被推崇,尤其是绝症患者的信息告知,更需考虑患者对疾病的价值判断,而非事实认知。因而医生的信息告知必须是选择性的,医生的主体性并不以患者对疾病的事实认知为目标导向,而以患者可能产生的价值选择为目标导向,尤其是准确告知会影响患者的情绪且不利于治疗时,医生更倾向于在“信息告知”中隐瞒真实病情。

患者的主体性更多地取决于价值判断,医生在信息告知中不仅须有效权衡患者对疾病信息的理解能力,还须有效预估患者的价值选择。根据汤姆·比切姆(Tom L. Beauchamp)和詹姆士·邱卓思(James F. Childress)的分析,患者对疾病的信息处理主要受选择性的知觉模式、错误的信念、对医生的信任程度、患者的个体人格等因素的影响,患者的信息理解常具有随机性和自我欺骗性,病情严重时甚至会产生不同程度的人格分裂,都会影响患者的主体性发挥[12]。在知情同意中,患者对疾病的事实认知依赖医生传达的信息,在此过程中医生体现出强主体性,但在对疾病做出价值判断的过程中,因为疾病的“属我性”,患者体现出强主体性,具体如图1所示。

|

图 1 知情同意中医患主体性特征图 |

医患主体性都离不开“病”,但医患主体与“病”的关系有差别。对医生来说,“病”是外在于“我”的客体;对患者来说,病是内在于“我”的一部分,甚至在某一时间段内,病构成患者意义世界的全部。医生与“病”既可以体现为主体与客体(病)的关系,也可以体现为主体与主体(病人)的关系。但患者与“病”既非主体与客体的关系,也非主体与主体的关系,而是我与“我的病”或“病的我”的关系。医生可以提升患者的认知主体性,却很难主导患者与“我的病”或“病的我”的关系。尽管信息告知中需要医患双方的认知主体性,但行为导向是由价值主体性决定的。在患者看来,疾病是“我的病”,首先要考虑的是我的感受,“病”和我是统一的。相反,医生更倾向于将患者看作是病的承载者,“病”并非因患者这个人有何不同,“病”和人是分离的。如果医生过分夸大认知主体性,忽略病人的价值主体性,就会导致医患关系的抽象化,病人被抽象成各种“病”的实体。相反,如果患者过分夸大价值主体性,就会在信息理解的过程中产生事实偏差,其自主意愿可能违背生命利益。

二、人工智能医生的主体性定位当前,医疗机器人的强大智能几乎接近人类,但是否能赋予其主体地位备受争议。2016年,欧盟委员会要求赋予最先进的自动化机器人“特定的权利和义务”,并建议为其身份进行登记,以便为其进行纳税、缴费等[13]。2017年10月26日,沙特阿拉伯授予 “女性”机器人“索菲亚”公民身份。2017年年底,科大讯飞发布公告称“智医助理”机器人顺利通过临床执业医师考试,如果此机器人能获得“法人”式的法律人格,那么就可能成为依法执业的“机器人医生”[14]。无疑,人工智能凭借认知优越性获得“类人性”的认可,在某些技能方面甚至远远地超过人类医生,但主体概念是应用在人和人、人和物的关系上的。郭湛提出,“是否为主体不完全取决于自己的意愿,而取决于同客体的现实关系。”[15]如果没有相对应的客体存在,不构成一定的关系性,就无所谓主体。人工智能虽然在计算和图像处理方面体现出强能力特征,但它并不具备主导客体的社会关系能力。因为“非社会人”这一特点,人工智能不具备与人类进行社会交往的能力,尤其是复杂的情感交往能力,因而并不产生真正的社会关系。一句话,当前的人工智能主要体现为一种技术主体性,并非人际交互主体性。塞缪尔·西甘(Samuel T.Segun)认为,“自主性、交互性和适应性是衡量智能体是否属于伦理主体的标准或特征。”[16]即使人工智能医生通过考试获得执业医生资格证,这只能说明它获得了成为执业医师的知识能力,而非实践能力。

人工智能作为一种特殊的认知主体存在,其成熟度既依赖它在技术上的强主体性,也依赖它在医患关系中的价值主体性。认知主体性可以体现出弱主体性和强主体性特征,但价值主体性却是以主体-客体、主体-主体关系的和谐为特征的,它不以任何一方的主体性强弱来定义彼此的良好关系,而以关系本身来定义彼此的主体性强弱。过分地夸大其技术主体性,实质上是人与人工智能关系的异化,此时人的主体性被技术所主导。人作为社会主体的地位会因其所处社会关系的改变而改变。主体性也经历从低到高、从幼稚到成熟的发展过程,因而主体性总是相对的,是相对于客体来说的主导性。主体性即主体主导与客体关系的能力和属性,但这种主导不是绝对的。比如在人与自然的关系上,过分地夸大人的主体性会导致人类中心主义,造成人与自然关系的紧张。因而在任何关系中,主体性不是将对方当作是纯粹客体产生的,而是在尊重对方拥有同等主体性的基础上达成的。成素梅等人提出,人工智能革命促使人类需要学习如何重新尊重自然,“改变在工业文明时代形成的索取自然和掠夺自然的生产与消费方式,以及以追求物质和经济为核心的范畴体系,从而使人与自然的对象性关系重新转变为人与自然和谐共处的共生关系”[17]。

在现实的医疗实践中,医生不仅需要具有完备的知识结构,而且需要丰富的临床实践经验以及应对复杂医患关系的社会交往能力。人工智能在增强人类认知主体性方面具有优势,在人类的意义世界里却不拥有相应的道德主体性,因为它并不经历类人性的社会实践生活,也就无所谓关系需求及其意义。这意味着,人工智能是无法承担临床辅助诊断中的道德责任的。陶锋认为,“主体性意味着主体自身是自律的、自为的,这种主体性应该是从自身中生长出来、自我意识到的,显然这种自生的主体性在机器没有诞生意识的情况之下是不可能的。”[18]目前,对于人工智能的伦理责任归属存在无责任、有责任和有部分责任等三种不同观点[19]。崔中良认为,人工智能在多大程度上要对自己的行为负责是无法进行定量分析的,它由不同的设计者和生产者制造出来,其出厂设置以及后期的伦理习得方式也是提前设定的[20]。李建华认为,“主体性意味着主观能动性和行为责任性,而机器人只是被某种程序控制”,它是没有办法成为能够主动参与社会伦理实践并承担相应责任的伦理主体的[21]。因而人工智能辅助诊断中的人机关系最终由人类医生来主导和解释,人工智能只是提供必要的诊断参考。

三、人工智能辅助诊断中医患双方的主体性当前,人工智能辅助诊断中的人-机伦理关系备受关注,医生的主体地位会受到影响是主要担忧。即使人类医生暂时不会被人工智能取代,也无法阻止他们本能地依赖人工智能,甚至产生严重影响自身判断能力的“警觉衰退”(atrophy of vigilance)现象[22]。与此同时,人工智能的辅助定位意味着医生需要对每一次判断进行再判断,最终做出决定,如果判断一致,可以增强医生的诊疗信心;如果不一致,便会产生人-机间“同行分歧”难题[23]。另外,医生的自主决策空间或将受到挤压,建立在辅助诊断基础上的医疗决策是不完全自主的,各职业阶段的医生均会受到影响,尤其是新手或基层医生更倾向于听从智能诊断的结果[24]。除此之外,人工智能辅助诊断造成的归责难题持续引起热议。医生和医疗机构、设计者和制造商等主体都对诊断结果产生影响,数据的采集和标注、算法设计等在不同环节产生作用,使得责任主体的确定异常复杂[25]。

无疑,人工智能辅助诊断对医生主体性的影响和归责难题是十分复杂的,进而影响到患者的自主性与医患信任问题。即使人工智能对医生的主体地位不会造成影响,但人工智能对医生的认知主体性产生的影响是不能忽视的,在诊断中医生是否能够坚持自主判断比较关键。无疑,在医疗大数据产生之前,临床诊断中医生的经验性积累至关重要,它依赖医生在长期的临床实践中进行归纳总结。那么,这种经验性逻辑与人工智能的数理逻辑相比较,哪一种更应该成为疾病诊断中的科学依据?无疑,疾病既有一般化特征,也存在明显的个体差异,人工智能在解释疾病的一般化特征方面占据优势,在解释疾病的个体性方面是否也存在优势?当前,人工智能的优势在于影像识别、医疗风险预知、辅助分类和特殊临床工作等,局限在于无法成为床边医生并与患者进行高级对话和共情,导致医患信任困难并可能激化医疗冲突[26]。尽管可以通过各种扫描技术来勘探疾病,但最后诊断仍需要综合患者病史、体检结果和辅助性讨论等做出汇融性解释。那么,患者应该如何自主地面对人工智能诊断结果?

无疑,由于医疗信息的极度不对称,医患之间的信任已经是难题,它严重地考验患者在知情同意过程中的选择,对医生的不信任是患者拒绝治疗的重要原因。人工智能辅助诊断是化解还是加深了这一难题?只有将人工智能的强技术主体性放置于医患关系中思考,才能有效地评估它对双方主体性的影响。客观地讲,医患双方的认知主体性都会因人工智能得到提升,即使不选择完全相信这一结果,它都具有重要的参考价值。当医生和人工智能的诊断结果一致时,医生在知情同意过程中的信息告知将更有说服力;当结果不一致时,如果医生能够为自己的诊断结果提供更合理的证据,那么更可能获得患者的信任和满意。如果医生无法为自己的诊断提供更合理的证据,那么至少他的诊断拥有了一个参照对象,患者可以自主地选择相信医生或人工智能,这样的临床诊断服务将更能使患者信服。无疑,人工智能诊断同时挑战着医患双方的自主性发挥,如果医生坚持认为自己的诊断结果比人工智能更加科学合理,但又拿不出理由和证据时,至少这种自主精神可以影响到患者,在做出医疗决定的时候不必盲听盲从,而是根据自己对生命的切身感受来做出决定。如《柳叶刀》杂志的编辑埃玛·希尔(Emma Hill)所说的:“每个患者在自己选择的领域里都是专家,这个领域就是自己的生命”[27]。无论如何,人类正步入个体化的精准医疗时代,患者必须自己评估病情并做出满足自身需求的医疗决定。尽管人工智能给出的诊断结果无法得到充分检验,但仍具有重要的参考价值,它使得患者减少对医生的依赖并获得更多的自主决策能力。

当前,人工智能在辅助诊断中增强医生的认知主体性,弥补医生在数据处理或知识储备能力方面的不足,为有效评估患者的生命价值提供有力支持,并进而在维护患者的最佳利益上获得支持。随着人工智能诊断技术应用的深入,人工智能代理决策越来越成为发展趋势,智能化医疗决策支持系统滋生新形式的伦理问题。从最佳利益原则出发,它可能提高医疗决策的精准度,但也可能被它诱导。智能诊疗系统擅长分析已经有成熟应对方案的病症,但在未知病症的评估方面,专业医生更有优势,据报道,目前最先进的MDSS也经常给出不靠谱的医疗建议,因而最终还是需要医生为患者做出精准的病情评估并提供诊断方案[28]。

另外,人工智能可以根据其优越的信息处理能力,更准确地判断患者与病情有关的生理信息和指标,但却无法准确地掌握患者的心理情绪变化、价值选择和交往习惯等。人工智能辅助诊断能够大大减弱医患信息不对称,医疗决定的做出不再是从医生到患者的单向模式,但过度依赖信息的医疗决策是不科学和非人性化的,医学不是只靠大数据算法就能推动的,还依赖于医护人员的直觉和隐性知识(tacit knowledge)[11]。换句话说,人工智能可以依靠某些技术上的优越性能更好地认知“我的病”,却缺乏认知“病的我”的能力。无论如何,在患者选择以认知主体性为导向并与医生达成一致的时候,人工智能以其强技术主体性可以提升医生的可信度,有效地化解患者对医生业务能力的不信任。除此之外,人工智能虽不具备价值主体性,但可以为构建医患价值共同体提供有利的技术支持,前提是人工智能的强技术主体性获得医患双方的认同。

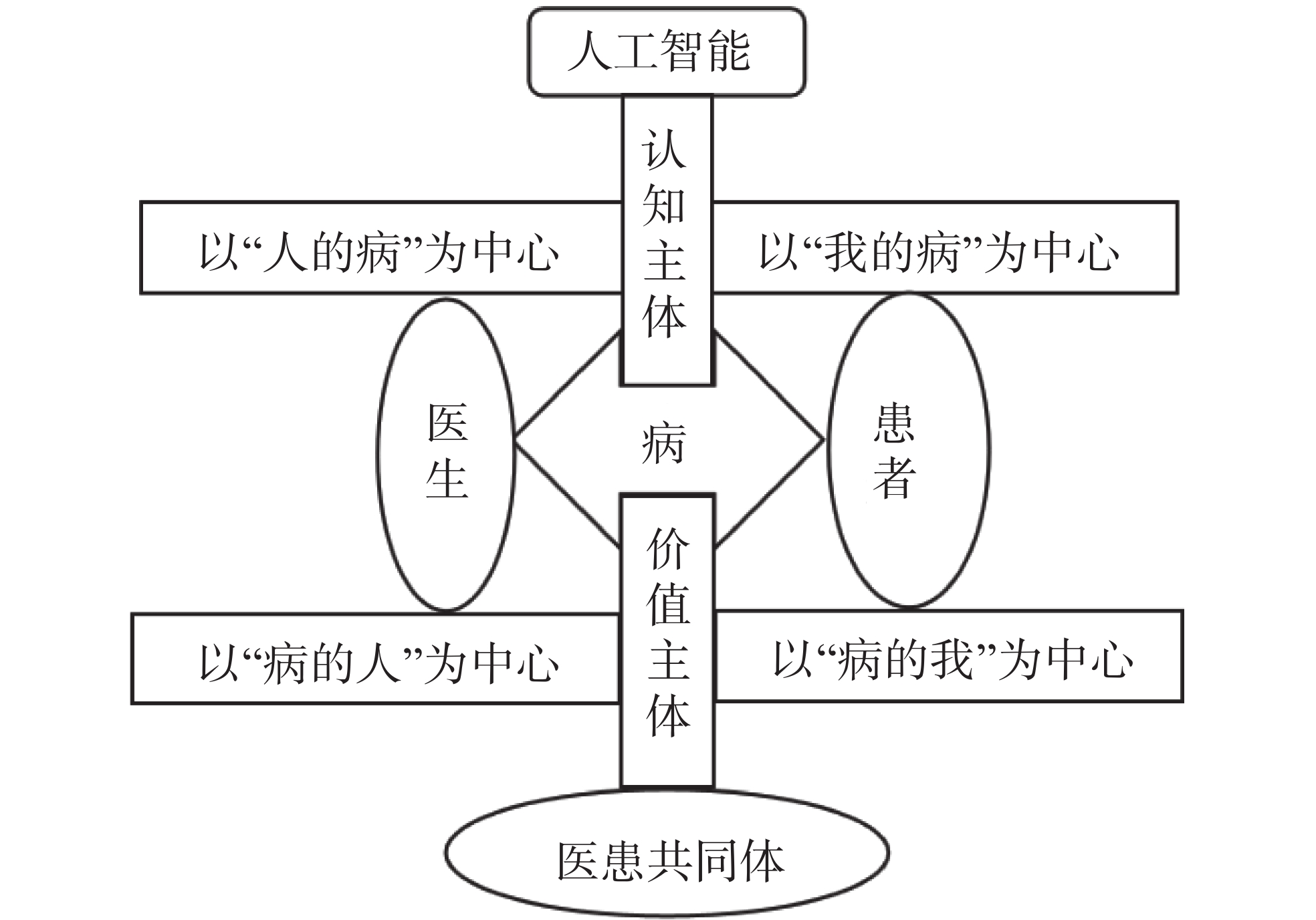

医生无论是作为认知主体还是作为价值主体,所面对的患者要么体现为“人的病”,要么体现为“病的人”,无论是哪种情况,“病”始终是医患交往的中介。相反,患者无论是作为认知主体,还是作为价值主体,与其相对应的客体并非医生,而是“我的病”或“病的我”。临床决策中患者对于“我的病”的认知是通过医生的主体作用来实现的,因而医生是患者认知主体性发挥的中介。医生对于“病的人”是通过患者的主体作用来实现的,因而患者是医生价值主体性发挥的中介,医生通过患者认知到“病的人”。人工智能辅助诊断对医患双方的主体性都产生影响,如图2所示。

|

图 2 人工智能辅助诊断中的医患主体性模式图 |

当医患双方都选择更多地服从认知主体性时,将共同以“人的病”或“我的病”为中心,此时患者对医生业务水平的信赖极为重要。在人工智能的辅助诊断中,缺乏可解释性极大地阻碍了人们对人工智能的信任,并最终阻碍它在医疗领域的使用。互联网帮助患者获得海量医疗信息,反而加剧了医患之间的不信任。人工智能所提供的信息同样存在着难以解释的多样性和复杂性,有时候,专业医生甚至比患者更难信任智能系统,这导致他们无法有效沟通,进而影响到彼此的信任。但是,传统医学实践中的医患之间也是无法完全解释的,只能通过全面沟通才能实现信任[29]。这意味着,即使人工智能可以为临床诊疗提供可靠信息,同样需要加强沟通才能促进医患交互主体性的产生。当医患双方都选择更多地服从价值主体性时,将更多地以“病的人”或“病的我”为中心,此时医生对患者所持价值观的尊重极为重要。反之,当医生选择更多地服从认知主体性,将“人的病”放在中心,而患者选择更多地服从价值主体性,将“病的我”放在中心,或相反,都会产生严重的医患冲突。

四、结 语人工智能技术的应用一方面提升了人类认知疾病的主体性;另一方面也加剧了医患之间的不信任。造成医患关系紧张的是信息的不对称与沟通不畅,过于专业化的医疗信息及其不可解释性是主要原因。无论如何,尊重患者自主不是一纸知情同意书可以实现的,它更多地依靠患者以真正的主体身份参与到医疗决策中去。良好的医患关系须以双方在认知和价值方面的交互主体性为前提,这不仅依靠患者能够获得更多智能诊疗系统的支持,化解医患之间因信息不对称而产生的认知隔阂,而且需要双方对疾病、治疗、智能诊疗系统等达成价值共识。

| [1] |

聂金福. 人工智能在生物医疗领域的应用和机遇.

软件和集成电路, 2017,(4): 38-41.

DOI: 10.3969/j.issn.2096-062X.2017.04.007. |

| [2] |

Gosfield A G. Artificial intelligence and the practice of medicine.

Health Law Handbook, 2019, 7: 1-15.

|

| [3] |

周路菡. 医学人工智能开始加速产业化.

新经济导刊, 2017,(7): 18-22.

DOI: 10.3969/j.issn.1009-959X.2017.07.004. |

| [4] |

Price W. Regulating black-box medicine.

Michigan Law Review, 2017, 116(3): 421-474.

|

| [5] |

莫宏伟. 强人工智能与弱人工智能的伦理问题思考.

科学与社会, 2018, 8(1): 14-24.

|

| [6] |

闫涛. 论人工智能伦理建构何以可能.

哲学分析, 2023, 14(1): 148-158.

DOI: 10.3969/j.issn.2095-0047.2023.01.012. |

| [7] |

龚群. 论弱人工智能体的道德性考察.

哲学研究, 2023,(3): 37-45,126.

|

| [8] |

郑志峰. 诊疗人工智能的医疗损害责任.

中国法学, 2023,(1): 203-221.

|

| [9] |

American Medical Association. Augmented intelligence in health care. https:// www.ama-assn.org/ |

| [10] |

Ardila D, Kiraly A P, Bharadwaj S, etal. End-to-end lung cancer screening with three-dimensional deep learning on low-dose chest computed tomography.

Nature Medicine, 2019, 25(6): 954-961.

DOI: 10.1038/s41591-019-0447-x. |

| [11] |

孙保学. 人工智能辅助医疗决策并未挑战尊重自主原则.

伦理学研究, 2019,(6): 81-86.

|

| [12] |

汤姆·比彻姆, 詹姆士·邱卓思. 生命医学伦理原则. 李伦译. 北京: 北京大学出版社, 2014: 90.

|

| [13] |

吴汉东. 人工智能时代的制度安排与法律规制.

法律科学(西北政法大学学报), 2017, 35(5): 128-136.

|

| [14] |

曹艳林, 王将军, 陈璞, 等. 人工智能对医疗服务的机遇与挑战.

中国医院, 2018, 22(6): 25-28.

|

| [15] |

郭湛. 主体性哲学——人的存在及其意义. 北京: 中国人民大学出版社, 2011: 228.

|

| [16] |

Samuel T. Segun, From machine ethics to computational ethics.

AI & Society, 2021, 36(1): 263-276.

|

| [17] |

成素梅, 张帆. 人工智能的哲学问题. 上海: 上海人民出版社, 2020:22-23.

|

| [18] |

陶锋. 当代人工智能哲学的问题、启发与共识——“全国人工智能哲学与跨学科思维论坛”评论.

四川师范大学学报(社会科学版), 2018, 45(4): 29-33.

|

| [19] |

Gunkel D J. Mind the gap: responsible robotics and the problem of responsibility.

Ethics and Information Technology, 2020, 22(4): 307-320.

DOI: 10.1007/s10676-017-9428-2. |

| [20] |

崔中良. 伦理的人工主体: 人工智能的伦理挑战及其应对方案.

马克思主义与现实, 2023(2): 140-147.

DOI: 10.3969/j.issn.1004-5961.2023.02.018. |

| [21] |

李建华. 智能时代人机关系的伦理学慎思.

理论月刊, 2023,(9): 5-15.

|

| [22] |

Smith H, Fotheringham K. Artificial intelligence in clinical decision-making: Rethinking liability.

Medical Law International, 2020, 20(2): 131-154.

DOI: 10.1177/0968533220945766. |

| [23] |

Froomkin A M, Kerr I R, Pineau J. When AIs outperform doctors: Confronting the challenges of a tort-induced over-reliance on machine learning.

Arizona Law Review, 2019, 66: 33-99.

|

| [24] |

Gaube S, Suresh H, Raue M, et al. Do as AI say: Susceptibility in deployment of clinical decision-aids.

npj Digital Medicine, 2021, 4(1): 31.

DOI: 10.1038/s41746-021-00385-9. |

| [25] |

何丽. 人工智能辅助医疗决策的归责难题新解.

自然辩证法研究, 2023, 39(6): 65-71.

|

| [26] |

Krittanawong C. The rise of artificial intelligence and the uncertain future for physicians.

European Journal of Internal Medicine, 2018, 48: e13-e14.

DOI: 10.1016/j.ejim.2017.06.017. |

| [27] |

埃里克·托普. 未来医疗: 智能时代的个体医疗革命. 郑杰, 译. 杭州: 浙江人民出版社, 2016: 3.

|

| [28] |

Ross C, Swetlitz I. IBM’s Watson supercomputer recommended“unsafe and incorrect”cancer treatments, internal documents show. https://www.statnews.com/2018/07/25/ibm-watson-recommended-unsafe-incorrect-treatments/. [2018-07-25].

|

| [29] |

陈宇超, 艾永明. 增强人工智能在医疗领域信任的有效途径——传统医疗领域的立法框架和经验借鉴.

青海社会科学, 2020,(5): 143-148.

|

2024, Vol. 14

2024, Vol. 14