从技术框架中讨论设计与伦理的关系大致有三种不同的观点。第一种观点是将设计与伦理对立起来,认为技术设计的行为阻碍了人类道德的进步。这种观点多存在于古代,主要是受到了当时技术发展水平的限制以及社会观念的影响。到了近代社会这种观点已经少有出现了。鉴于技术产品对人类社会生活质量的切实提升,将技术设计视为不道德的行为缺乏有力的证据,而更普遍的是将技术设计视为无关道德、价值中立的行为,这也是设计与伦理的第二种关系,即设计无关伦理。设计的目的是为了满足用户和使用者的功能需求,设计本身并不蕴含着道德的因素。使用者和用户决定了设计产品的价值,而无关设计者。这其实是技术中性论的一种体现。诚如雅斯贝尔斯所说:“技术在本质上既非善也非恶,而是既可以为善也可以为恶,技术本身不包含观念……只有人赋予技术以意义。”[1]直到20世纪中叶,这种观点一直占据主导地位。

然而,到了20世纪六七十年代,受到STS(科学技术与社会)的影响,人们开始关注于技术设计的社会属性。技术设计不再是价值无涉的行为,相反,社会价值和伦理价值可以通过设计的方式嵌入到技术产品之中,使技术产品最大程度地体现出道德意义和社会意义。这是设计与伦理的第三种关系,即设计蕴含伦理。伦理通过价值的方式体现在设计之中,使得设计呈现出一种伦理价值的导向。设计蕴含伦理这一观点可以从两个方面展开分析,一是现有设计中如何体现出了伦理价值?二是如何以伦理为导向进行设计?前者是“设计中的伦理”(Values in Design),后者是“为了伦理的设计”(Design for Values),前者为后者提供了可能性。

“设计中的伦理”强调设计的伦理属性。设计并不是技术中性论者所认为的无关价值,相反,设计的主体(设计者)除了考虑用户和使用者的需求,还要将自身的意图、信念、欲望等主观因素嵌入到设计的产品之中,这些主观因素往往受到伦理价值的影响。技术哲学史上的一个经典反例—摩西低桥[2],就充分地说明了设计之中蕴含着价值。与之类似的案例,比如拉图尔认为在提醒司机减速的问题上,“减速带”和交通警察、减速指示牌起到了相同的作用,也就是减速带在设计之初被赋予了“减速”的价值[3];再如,维贝克指出“超声波机”在设计之初就被赋予了显示性别的功能,这导致了因为性别而堕胎的可能性的增加[4]。“设计中的伦理”大多是隐性的,需要通过不同的视角加以解读,并且为“伦理的设计”提供了可能性。

“为了伦理的设计”强调设计的伦理导向。如果说设计一开始就蕴含着价值,那么能否将价值的被动挖掘转化为主动嵌入?也就是说,以一种积极的方式将价值前置,使技术设计从根源上体现价值的诉求,使设计成为一种价值导向的设计。这正是价值敏感性设计的核心要旨。

价值敏感性设计的方法由华盛顿大学的弗里德曼等人于20世纪90年代发明,最早被用于人机交互界面(human-computer interaction,HCI),将交互接口与利益相关者相联系,使得利益相关者的诉求在一定程度上可以被采纳。弗里德曼等人进一步指出,价值敏感性设计中的价值可以有三种建构方式,概念调查、经验调查和技术调查。概念调查是价值的主要来源,即从概念上建构与一项技术有关的价值诉求。这包含了两种情况,一种情况是识别与该技术相关的利益相关者,这里包括直接利益相关者和间接利益相关者两类。直接利益相关者指的是直接参与某项技术的相关人员,而间接利益相关者指的是不直接参与某项技术但却受该技术影响的人。另外一种概念调查指的是识别使用技术过程中的相关价值。比如,弗里德曼等人认为与ICT技术相关的价值包括:“人类福祉、财产权、隐私、无偏见、普遍可用性、信任、自主性、知情同意、可解释性、同一性、平衡和环境可持续性。”[5]这里存在的问题是价值冲突或价值张力,即价值与价值之间的矛盾关系,如安全和隐私之间的冲突关系。经验调查指的是从“理解、语境和经验”中得来的价值,可以通过调查问卷、调研、深度访谈、实验、参与者观察等方法来探寻相关行动中的价值。技术调查主要与技术的特征相关,这种方法包括设计一种新的技术以支持特定的价值或分析现存技术的特定特征如何影响该技术在使用语境中的特定价值。以上三种价值建构方式同时起作用,其目的是为了挖掘更多的相关价值。基于价值敏感性设计的基础条件,以价值为导向的设计(values-oriented design)成为一种有效的设计方法。

二、人工智能设计中的伦理价值人工智能技术飞速发展,已被应用到各个领域之中。对人工智能技术的研究不仅限于技术语境,也蕴含着社会语境和文化语境。人工智能技术在医疗、军事、经济、建筑、农业等领域的多元化应用,使得经济、文化、社会等问题不断地涌现出来。其中,伦理价值作为重要的价值之一,体现在人工智能的设计环节中。按照价值敏感性设计的方法论,从概念上建构人工智能设计涉及的伦理价值,可以按照人与人、人与技术、人与环境这三个维度析出。需要说明的是,这里的价值体现为两个层级。第一层级的价值是普遍的价值、终极的价值,第二层级的价值是为了实现第一层级价值而实施的具体的、可操作的价值标准。第一层级的价值可以被还原为第二层级的价值标准。

1. 人的伦理价值:福祉人既是技术的主体,也是技术的客体,技术应当以人为目的。人工智能技术的设计应当时刻将人的伦理价值置于首位。人的第一层级价值是福祉。福祉指的是人们感到高兴或幸福的状态,设计中的福祉意味着设计应当为了使人们感到高兴或者为了追求人类的幸福。如果按照功利主义的原则,设计应当追求最大多数人的最大幸福。人工智能的设计应当最大程度地增加人们的幸福感受或者最大程度地防止不幸的发生。福祉作为第一层级的价值可以被还原为自由与自主、平等与公正等第二层面的价值。人工智能设计中的自由与自主指的是设计应当最大程度地提升人的自由度与自主性,这意味着设计活动要在保障人类自主性的前提下为人类提供更多选择的空间,而非一味地控制技术。人工智能设计中的平等与公正同样重要。一项新的技术很容易导致一种不公正和不平等,无论是马克思深刻的异化理论还是约纳斯对遥远未来的担忧,都在强调由技术引发的不平等和不公正。正因如此,人工智能技术在设计的环节中,更应当将平等与公正作为重要因素慎重考量。

此外,为了实现自由与自主、平等与公正这些第二层级的价值进而实现福祉这个第一层级的价值,还有一些具体的伦理价值需要被满足。与人工智能设计相关的伦理价值主要包括:隐私、信任、知情同意、无偏见等。具体说来,人工智能技术往往基于大数据和云计算,其根本是数据,数据的误用和数据的滥用会导致严重的后果[6]。这就要求在设计之初尽可能地为保护数据提供手段,保护数据也就是保护用户的个人隐私,保护隐私应当成为人工智能设计的一个基本要求。比如,当前流行的人脸识别技术如果处理不当,将成为泄露个人隐私的罪魁祸首。此外,人工智能设计还要尽可能实现信任,表面上看是使用者对人工智能产品的信任,实质上是人与人之间的信任问题,人工智能技术应当最大程度地增进人与人之间的信任感,而不是成为阻碍人们信任的技术障碍。与保护隐私和增进信任直接相关的一个伦理价值就是知情同意。人工智能技术的知情同意主要强调对数据采集和识别的知情同意。《人工智能标准化白皮书2018》建议,数据采集“不能仅仅征得数据所有者的同意”,“还应当建立实用、可执行的、适应于不同使用场景的标准流程以供设计者和开发者保护数据来源的隐私”。比如,Facebook的数据泄露事件就是利用了知情同意的漏洞,数据所有者同意采集其通讯录中的数据,这就导致了通讯录中的其他人在不知情的情况下被泄露了隐私。最后,人工智能设计要体现无偏见的伦理导向,数据偏见是人工智能和深度学习不可避免的一个后果,其设计要体现纠偏的伦理意图,不仅要尽可能避免“偏见出”(bias out),还要避免“偏见入”(bias in)。这些关于人工智能设计的具体的价值诉求,本质上是为了增进人类福祉,实现人的价值。

2. 技术的伦理价值:负责任创新技术的本质价值是创新,技术创新是技术活动的根本目的。人工智能设计在追求人类价值的大前提下,还需要满足人工智能技术的创新价值。创新价值并不直接等同于伦理价值,而负责任的创新才符合伦理的诉求。负责任创新作为第一层级的价值可以被具体还原为有效和安全这两个第二层级的价值。有效性是技术创新的目的和评价标准,一项技术之所以创新,就在于它能够在一定范围内提升技术生产和技术应用的效率。但是,创新并不单指提升效率,还应当注重如何在保障安全的前提下提升效率。因此,保障安全和提升效率有时会产生冲突,如何在技术行为中做出选择就是一个值得思考的伦理问题。有效性是技术创新的技术要求,安全性则是技术创新的伦理要求。

这里重点分析人工智能设计中的安全价值。安全通常和风险联系在一起,提高安全性意味着降低风险。人工智能设计追求安全价值意味着其设计过程要尽可能降低风险,可以通过增强可解释性、可识别性和可控性这三个主要方式实现。首先,可解释性指的是由人工智能技术生成的数据和算法应当具备可解释的先决条件。人工智能算法和数据通常被认为是技术黑箱,人们不了解数据产生的算法和机理,也由此增加了对人工智能数据和算法的风险感知。为了降低这类风险,可以在人工智能设计环节注重可解释性。例如人工智能的一个新兴分支—可解释AI(Explainable AI,XAI),用于解释人工智能所做出的每一个决策背后的逻辑[7]。可解释AI的设计将可解释性价值作为设计出发点,有助于降低人工智能由不确定导致的风险,从而增强人工智能的设计安全。可解释性通常和透明性有关,人工智能设计的可解释性在某种程度上要求人工智能设计的透明性,特别是数据和算法的透明性,公开部分的源数据和源代码有助于发现人工智能算法训练过程产生歧视等不道德现象的原因。其次,提升可识别性是增强人工智能设计安全的另一种方式,可识别性指的是人工智能设计应当尽可能体现出与人类的区别,因为对人工智能的一种很现实担忧就是人工智能可能会取代人、超越人[8],所以在设计之初就应当注意人工智能与人的区别,不仅体现在外表上应当与人有差异,还应当在功能上体现出与人不同的一面。设计过程中可以做出明确的标识,比如该产品含有人工智能这类提示语,以增强人工智能产品的可识别性。最后,人工智能设计应当注重可控性,即人类对人工智能技术及产品的可控性。增强人类控制的两个必要条件是“追踪”条件(a “tracking” condition)和“追溯”条件(a “tracing” condition),前者强调系统应当能够回应人类设计和发展该系统所涉及的相关道德理由以及该系统运行环境中的相关事实,后者强调系统应当总是能够允许在设计或使用的链条中有至少一个人对其操作的结果进行追溯[9]。可解释性、可识别性和可控性是具体的设计要求,本质是为了实现技术的安全创新价值,换言之,技术创新应当是负责任创新。

3. 环境的伦理价值:可持续性人-技关系的载体是环境,环境为人与技术的互动提供了平台,因而环境的价值也应当被满足。人工智能设计中涉及到的第一层级价值是可持续性,这里的可持续性指的是一种计算的可持续性。“计算可持续性”(computational sustainability)由Carla Gomes提出,Gomes认为计算可持续性是一个新的跨学科研究领域,其目的是发展可计算模型、方法、工具以平衡环境、经济和社会的可持续发展需求[10]。人工智能设计应当将环境可持续性、经济可持续性和社会可持续性之间的平衡作为设计出发点,利用数据优势和算法优势,为可持续性发展提供有效的数学模型和计算模型。

可持续性是人工智能设计的第一层级价值,它可以被还原为稳定性和环境友好这两个第二层级的价值。人工智能设计对稳定性的要求强调人工智能技术应当追求环境、经济、社会与技术之间的稳定关系,技术作为一种聚合,是环境、经济和社会因素的共同驱动力,人工智能技术的设计应当最大程度寻求这些因素的平衡和稳定发展。为了实现人工智能设计的稳定性目的,还需要考虑回弹力的因素。人工智能设计的回弹力要求指的是设计一种人工智能技术使其具有调整策略以适应外界变化的能力,这是一种积极的设计策略,目的也是为了实现人工智能技术在创新发展过程中的稳定性。另外一个价值是环境友好,人工智能设计应当追求环境友好的发展目标。这里的环境友好既包括社会环境友好也包括自然环境友好。自然环境友好的诉求应该体现为人工智能的绿色设计,在设计过程中考虑可拆卸、可回收、可重复利用等环境属性,尽量避免对自然的不可逆伤害。社会环境友好应当体现为人工智能的和谐设计,在设计过程中考虑用户体验、社会习俗、特殊群体等因素,以实现人-技术-社会的和谐关系。

三、伦理导向的人工智能设计如果说人工智能技术能够负载福祉、负责任创新和可持续性的伦理价值,那么是否可以更进一步,即利用设计的方式更加积极主动地将伦理价值嵌入到人工智能技术之中?换言之,如何实现以福祉、负责任创新、可持续性的伦理价值为导向的人工智能设计?这需要从设计驱动主体、设计理念、设计方法和设计策略这几个方面深入考察。

1. 伦理导向的设计驱动主体伦理导向的人工智能设计首先需要明确的是设计驱动的主体。理论上,人工智能设计的驱动主体有使用者和设计者两类。使用者驱动(user-driven)的伦理设计指的是使用者的伦理价值是设计的首要诉求,设计要尽可能满足使用者的需求。使用者驱动的人工智能设计强调对使用者的关怀,即设计一种用户友好的人工智能产品,如改造设计方法(Transformation Design)。使用者驱动的伦理导向设计就是要求将设计者的伦理诉求作为设计的核心,比如说在设计过程中将用户隐私作为首要因素,在设计数据采集和人像采集等信息采集程序中要注意处理数据,模糊数据或隐蔽数据以此达到从设计的环节保护隐私的目的。设计者驱动(designer-driven)的伦理设计指的是设计者来决定应该将哪些价值嵌入到设计过程之中,设计者在决定嵌入价值的过程中要充分考虑未来语境和社会语境,其目的也是为了尽可能满足使用者和用户的需求,只是驱动主体由设计者承担,同时设计者也要为自己的价值选择承担责任,如社会影响设计方法(Social Implication Design)和产品愿景设计法(Vision in Product Design)。

2. 伦理导向的设计理念伦理导向的人工智能设计理念本质上是一种参与设计(Participatory Design)。参与设计是一种价值为导向的设计方法,“一个调查、理解、反思、建构、发展和支持多方参与者在行动中相互学习的过程,参与者始终站在设计者和使用者这两种角色的立场上,设计者应当努力了解使用者境况的现实,而使用者应当清楚地表达自己的欲求并努力掌握恰当的技术手段以实现这些欲求。”[11]参与设计的核心是参与和民主,这与传统意义上的技术设计不同,传统意义上认为设计只是设计者的事情,而参与设计则认为与该技术或技术产品相关的使用者也应当参与设计的过程。参与设计是一种价值为中心的设计方法,这里的价值导向经历了从政治价值到伦理价值的转变[12]。以伦理为导向的人工智能设计本质上就是参与设计,人工智能技术的设计者和使用者应当根据自身的立场展开恰当的讨论,参与者应当参与决策,因为人工智能技术会切实影响到每一个参与者的生活。比如说,可以设计一种可参与的人机交互界面,用户不仅可以从系统中接收信息,还可以通过互动的形式,鼓励使用者参与交互设计的过程,设计一种流动性系统,以实时调整人机交互的方式。

3. 伦理导向的设计方法以伦理为导向的设计方法重点关注伦理价值如何被嵌入到设计的过程之中,这首先取决于与技术相关的设计活动,比如需求提取、价值细化、模型创建、实施、测试、维护等活动。将伦理价值渗透到这些设计活动之中,不仅需要技术上的支持,更需要从伦理的角度析取价值并实现价值的嵌入。常见的方法主要包括:利益相关者分析法、价值析取和抓取法、启发卡片法、价值敏感行动反思模型等[13]。

利益相关者分析法(stakeholder analysis)是设计活动中一种比较早期的方法,主要强调关注与这项技术有关的利益相关者的价值,这里的利益相关者包括直接的利益相关者与间接的利益相关者,前者指的是与技术直接相关的个人或者组织,后者指的是因使用这项技术而受影响的其他个人或组织。举一个例子,依托人工智能技术而实现数据采集和管理的智能系统(如医疗数据系统),该系统的直接相关者可能是医生、医院、护士和医保中心等个人或机构,而间接相关者可能是病人、病人家属以及其他受影响的个人或机构。尽管这些人并不直接使用该系统,但是他们的个人信息、病历、社会关系等隐私都与这个系统密切相关。因此,利益相关者分析法就需要在设计之初将直接相关者与间接相关者的价值诉求考虑到设计的过程中,这些价值就包括了伦理价值,伦理诉求也应当是设计考量的重点。伦理诉求往往与角色相关,设计者要充分考虑不同角色背景下的伦理诉求和伦理冲突,将这些伦理考量置入设计环节中。

价值析取法(value elicitation)和抓取法(value sketches)是利益相关者分析法的一个延续,因为要析取和抓取利益相关者的价值。价值析取和抓取可以通过经验调查的方式展开,析取一般采用调查问卷、深度访谈、焦点小组等方式,从利益相关者的现有价值中析取出共同价值和特殊价值。对人工智能技术进行价值析取可以充分利用智能平台,设计一类特定的数字工具以支持利益相关者直接反馈其特定语境中的价值诉求,或者设计一类平台根据使用者的任务完成情况,间接地反馈利益相关者的任务喜好和价值诉求。而价值抓取法可以通过设计一些活动来抓取参与者的价值需求。比如说摄像头的设计可以采用价值抓取的方法,首先可以选定不同的人群,让这些人通过实际的参与将城市中感到安全或威胁的地方标注出来,通过对这些标注的抓取,可以获得对隐私敏感性地点的地图,并据此来设计摄像头的位置。

启发卡片法(envisioning cards)主要是用于启发价值获取的多样性。从社会技术系统和长期发展的视角看技术设计活动,能够获取的共识是人类活动的多样性和复杂性导致了人与技术之间内在联系的多样性与复杂性,由此导致了与技术设计相关的价值的多样性与复杂性。启发卡片法就有助于处理这些复杂多样的价值及其张力。启发卡片法有四种维度,分别是:利益相关者、时间、价值和普遍应用性,由此对应着不同的卡片。另外有一些空白的卡片,用以扩展和创造新的价值。参与者可以根据现有卡片的内容进行讨论,也可以增加新的卡片而扩大讨论的范围。这种方法原是教学方法,也可以被用在技术设计的过程中,如形成观念、合作设计、启发式评价等环节。启发卡片法可以用于人工智能设计中,例如设计一种针对计算机程序安全的安全卡片,按照上述四个维度来讨论安全问题,从而扩展安全设计的价值域。

价值敏感行动反思模型(value sensitive action-reflection model)强调在行动中突出价值敏感性,主要包括设计者促动和利益相关者促动两种促动形式。上面提到的利益相关者分析法、价值析取与抓取法都属于利益相关者促动形式,而设计者促动的方法除了上面提到的启发卡片法以外,还包括合作设计。合作设计往往由设计者推动,吸纳非设计人员参与到设计的过程中,由此促进设计自身的价值扩张与价值融合。例如,设计者可以通过设计或使用一些游戏去探索、质疑或确认社会价值与伦理价值,这也称之为游戏中的价值(values at play)。

除此以外,价值坝与价值流(value dams and flows)、价值情景法(value scenarios)、价值层级法(value levers)等方法也可以用于伦理导向的设计,以上这些设计方法的重点在于伦理价值如何获取以及如何嵌入。这既需要技术上的支持,也需要社会层面和伦理层面的共同反思。

4. 案例:人类中心的助老机器人设计人类中心的助老机器人设计可以很好地说明伦理导向的人工智能设计如何实现。助老机器人主要用于看护和陪伴老年人。当前的助老机器人不仅具备满足使用者的生理需求、社会沟通需求、医疗康复需求和情感陪伴需求的功能,并通过实现这些功能体现出一定的社会价值。此外,还可以将伦理价值嵌入到助老机器人的设计中。Aleksandar Rodić等人设计了一种人类中心(human-centered)的助老机器人,该机器人由头部和身体两部分组成,身体部分是一个整体并且无固定外形,这主要是考虑到美观和人因工程。该机器人身体上装有6个自由度(DOF),使用者可以根据自身需要选择支撑移动(supported mobility)或人类辅助(human assistance),还装有超声波传感器以及话筒和指示灯。机器人头部设计有1个自由度,可任意旋转,有可以设置命令和传送信息的触屏,还有3个麦克风和1个可选择的视觉深度探测器[14]。通过以上设计,该机器人可以完成助老机器人的基本功能。此外,该机器人的设计中还融入了隐私保护、环境友好、嵌入式性格的伦理要素。

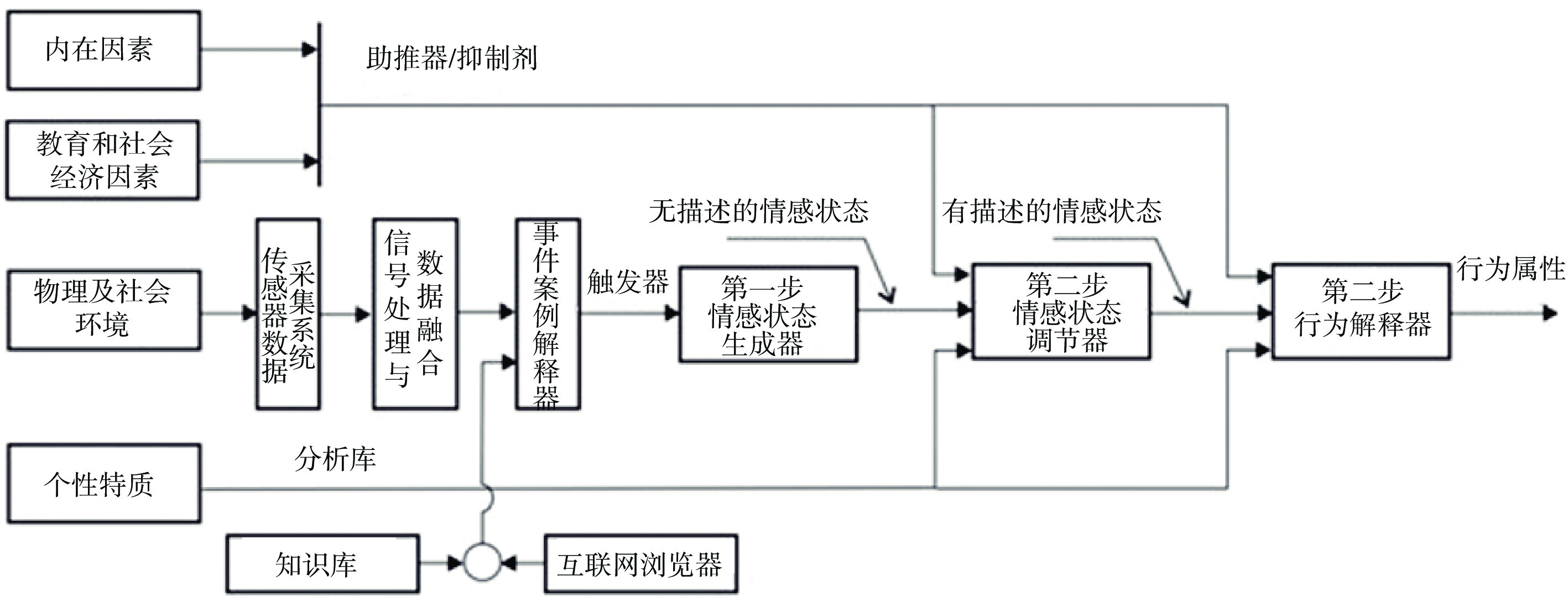

在隐私保护方面,该机器人的设计加入了“授权”的环节,只有被授权的人(家庭成员或者医疗人员)才能获取关于老人的信息,而其他非授权人员无法获取老人的信息。在环境友好方面,该机器人被设定了一种信息化的结构环境,这种环境系统是一种适应性系统,其中的语境是一种可定制的智能语境。技术手段是通过传感器探测老人的状态与需求,从而为老人提供友好的使用环境。比如压力传感器可以探测到老人是否在床上或者沙发上睡觉,以此调整应对来访者的策略。又或者环境传感器可以探测到老人是否处于一种危险状态,以此来判定是否需要救援。这种环境友好的设计能够为老人提供更加多样且舒适的居住环境。在嵌入式性格的操作上,Aleksandar Rodić等人提出了一种构想,他们从心理学的范式思考性格的可嵌入性,将性格还原为心理行为,即情感行为和社会行为。因此,嵌入式性格可以通过输入心理行为模式和性格参数而实现,具体的步骤可以分为:无描述的情感中介状态(第一步,由触发事件引起的客观情感状态);获得描述状态(第二步,特定状态的描述特征);获得情感驱动行为(第三步,基于性格对特定行为做出的回应)。考虑到性格本身是一个动态的过程,嵌入式性格需要在行动中做出判断和调整,如图1所示[14]。举一个例子,老人在吃药过程中将水杯打碎了,机器人需要通过“观察”老人的动作并结合之前输入的老人的性格参数,继而做出行为的判断。在这一过程中,嵌入式性格的伦理因素可以起到相应的作用,在这一情境中,机器人的宽容、友善和对他人的理解就可以成为该事件中老人情绪的互补因素。嵌入式性格的设计目前仍处于构想阶段,但是其设计模型具有可操作性,可以成为设计伦理的解释案例。

|

图 1 嵌入式性格设计步骤图示 |

人工智能技术的发展势必会引发一系列的伦理争议,从设计的立场出发反思人工智能技术能够为人工智能伦理的建构提供新的思路。一方面,人工智能设计中蕴含着福祉、创新和可持续性等伦理价值,需要对人工智能技术的伦理价值深入挖掘。另一方面,可以通过设计的方式,将伦理价值嵌入到人工智能技术之中,使人工智能技术表现出“向善”的伦理意图。但是,价值嵌入设计的方式还存在着有待进一步解决的难题,比如如何正确地识别利益相关者的相关价值,如何提供恰当的协商平台或协商工具以处理利益相关者的价值冲突,如何为价值的变化提供对应的设计手段,等等。对这些问题的回答将是未来研究的重点,用以完善人工智能技术的设计伦理研究。总体看来,人工智能的设计伦理研究具有广阔的研究前景,既能够为建构设计-伦理双向互动的科技伦理学提供基础保障,也能够为建构未来新型人机关系提供重要支撑,从根本上促进科技“向善”。

| [1] |

Jaspers, K. Origin and Goal of History. New Haven, Conn: Yale University Press, 1953: 115.

|

| [2] |

Langdon, W. Do Artifacts Have Politics?.

Daedalus, 1980, 109(1): 121-36.

|

| [3] |

Latour, B. Where Are the Missing Masses? The Sociology of A Few Mundane Artifacts. Bijker, W. E., Law, J. (Eds.). Shaping Technology/Building Society: Studies in Sociotechnical Change. Cambridge, MA: The MIT Press, 1992: 225–258.

|

| [4] |

Verbeek, P.P. Moralizing Technology: Understanding and Designing the Morality of Things. Chicago/London: The University of Chicago Press, 2011: 53–58.

|

| [5] |

Friedman, B., Kahn, P.H., Borning, A., Huldtgren. A.. Value sensitive design and information systems. Doorn, N., Schuurbiers, D., van de Poel, I., Gorman, M.E. (Eds) Early Engagement and New Technologies: Opening up the Laboratory, vol 16, Springer series: Philosophy of Engineering and Technology. Dordrecht: Springer, 2013: 55–59.

|

| [6] |

段伟文. 人工智能与解析社会的来临.

科学与社会, 2019, 9(1): 115-128.

|

| [7] |

Gunning, D. Explainable artificial intelligence (XAI).

Technical Report Defense Advanced Research Projects Agency(DARPA), Arlington, USA, 2016, : 16-23.

|

| [8] |

赵汀阳. 人工智能的自我意识何以可能?.

自然辩证法通讯, 2019(1): 1-8.

|

| [9] |

Santoni de Sio, F. van den Hoven, J. Meaningful Human Control over Autonomous System: A Philosophical Account.

Frontiers in Robotics and AI, 2018, 41(5): 1-14.

|

| [10] |

Gomes, C.P. Computational sustainability. Gama, J., Bradley, E., Hollmén, J. (Eds.) Advances in Intelligent Data Analysis X. Heidelberg: Springer, 2011(7014): 8.

|

| [11] |

Simonsen, J., Robertson, T. Routledge International Handbook of Participatory Design. Routledge, New York, 2012: 2.

|

| [12] |

Steen, M. Virtues in Participatory Design: Cooperation, Curiosity, Creativity, Empowerment and Reflexivity.

Science, Engineering and Ethics, 2013, (3): 945-962.

|

| [13] |

van den Hoven, J., Vermaas, P., van de Poe, I. Handbook of Ethics, Values, and Technological Design: Sources, Theory, Values and Application Domains. Dordrecht: Springer, 2015: 16–19.

|

| [14] |

Rodić, A., Vujović, M., Stevanović, I., Jovanović, M. Development of Human-Centered Social Robot with Embedded Personality for Elderly Care. Wenger, P., et al. (Eds.), New Trends in Medical and Service Robots, Mechanisms and Machine Science 39. Switzerland: Springer International Publishing, 2016: 233–247.

|

2020, Vol. 10

2020, Vol. 10